Reinert, Dietmar AJ

Adresse Berufsgenossenschaftliches Institut für Arbeitssicherheit, Alte Heerstraße 111, 53754 Sankt Augustin

Land: Deutschland

Telefon: 49 2241 231 645

Fax: 49 2241 231 234

E-Mail: 100565.2233@compuserve.com

Ausbildung: BA, 1984, Universität Bonn; Dr. rer nat, 1987, Universität Bonn

Interessengebiete: Programmierbare elektronische Systeme in sicherheitsrelevanten Anwendungen; sichere Software; sensorgesteuerte Schutzeinrichtungen

Sicherheitsrelevante Anwendungen

Mikroprozessoren spielen in den letzten Jahren eine immer größere Rolle im Bereich der Sicherheitstechnik. Da mittlerweile ganze Rechner (dh Zentraleinheit, Speicher und Peripheriekomponenten) als "Single-Chip-Rechner" in einem einzigen Bauteil verfügbar sind, findet die Mikroprozessortechnik nicht nur in komplexen Maschinensteuerungen, sondern auch in relativ einfach aufgebauten Absicherungen Anwendung (z. B. Lichtgitter, Zweihandsteuerungen und Schaltleisten). Die Software, die diese Systeme steuert, umfasst zwischen tausend und mehreren zehntausend Einzelbefehlen und besteht in der Regel aus mehreren hundert Programmzweigen. Die Programme arbeiten in Echtzeit und sind meist in der Assemblersprache der Programmierer geschrieben.

Die Einführung computergesteuerter Systeme im Bereich der Sicherheitstechnik ist bei allen technischen Großgeräten nicht nur mit aufwendigen Forschungs- und Entwicklungsprojekten, sondern auch mit erheblichen Einschränkungen zur Erhöhung der Sicherheit einhergegangen. (Als Beispiele für großtechnische Anwendungen seien hier die Luft- und Raumfahrttechnik, die Militärtechnik und die Atomkrafttechnik genannt.) Das Sammelgebiet der industriellen Massenproduktion ist bisher nur sehr begrenzt behandelt worden. Dies liegt unter anderem daran, dass die für den industriellen Maschinenbau charakteristischen schnellen Innovationszyklen eine nur sehr eingeschränkte Übertragbarkeit von Erkenntnissen aus Forschungsprojekten zur Enderprobung im Großmaßstab erschweren Sicherheitsgeräte. Dies macht die Entwicklung schneller und kostengünstiger Bewertungsverfahren zu einem Desiderat (Reinert und Reuss 1991).

Dieser Artikel untersucht zunächst Maschinen und Anlagen, in denen Computersysteme heute Sicherheitsaufgaben übernehmen, und zeigt anhand von Beispielen von Unfällen, die sich überwiegend im Bereich der Maschinenabsicherung ereignen, die besondere Rolle von Computern in der Sicherheitstechnik auf. Diese Unfälle geben Aufschluss darüber, welche Vorkehrungen zu treffen sind, damit die heute immer häufiger eingesetzten computergesteuerten Sicherheitseinrichtungen nicht zu einem Anstieg der Unfallzahlen führen. Der letzte Abschnitt des Artikels skizziert ein Verfahren, mit dem auch kleine Computersysteme mit vertretbarem Aufwand und in vertretbarer Zeit auf ein angemessenes Maß an technischer Sicherheit gebracht werden können. Die in diesem letzten Teil aufgezeigten Prinzipien werden derzeit in internationale Standardisierungsverfahren eingeführt und werden Auswirkungen auf alle Bereiche der Sicherheitstechnik haben, in denen Computer Anwendung finden.

Beispiele für den Einsatz von Software und Computern im Bereich der Maschinenabsicherung

Die folgenden vier Beispiele verdeutlichen, dass Software und Computer derzeit immer mehr Einzug in sicherheitsrelevante Anwendungen im gewerblichen Bereich halten.

Personen-Notsignalanlagen bestehen in der Regel aus einer zentralen Empfangsstelle und mehreren Personen-Notsignaleinrichtungen. Die Geräte werden von den vor Ort tätigen Personen selbst getragen. Befindet sich eine dieser allein arbeitenden Personen in einer Notsituation, kann sie über das Gerät per Funksignal in der zentralen Empfangsstelle einen Alarm auslösen. Eine solche willensabhängige Alarmauslösung kann auch durch einen willensunabhängigen Auslösemechanismus ergänzt werden, der durch in die Personennotrufgeräte eingebaute Sensoren aktiviert wird. Sowohl die einzelnen Geräte als auch die zentrale Empfangsstation werden häufig von Mikrocomputern gesteuert. Es ist denkbar, dass der Ausfall bestimmter Einzelfunktionen des eingebauten Computers in einer Notfallsituation dazu führen kann, dass der Alarm nicht ausgelöst wird. Es müssen daher Vorkehrungen getroffen werden, um einen solchen Funktionsverlust rechtzeitig zu erkennen und zu beheben.

Druckmaschinen, die heute zum Drucken von Zeitschriften verwendet werden, sind große Maschinen. Die Papierbahnen werden normalerweise von einer separaten Maschine so vorbereitet, dass ein nahtloser Übergang zu einer neuen Papierrolle möglich ist. Die bedruckten Seiten werden von einer Falzmaschine gefalzt und anschließend durch eine Kette weiterer Maschinen bearbeitet. Das Ergebnis sind Paletten, die mit vollständig vernähten Magazinen beladen sind. Obwohl solche Anlagen automatisiert sind, müssen an zwei Stellen manuelle Eingriffe vorgenommen werden: (1) beim Einfädeln der Papierwege und (2) beim Beseitigen von Hindernissen durch Papierrisse an Gefahrenstellen an den rotierenden Walzen. Aus diesem Grund muss während der Verstellung der Pressen eine reduzierte Arbeitsgeschwindigkeit oder ein weg- oder zeitbegrenzter Tippbetrieb steuerungstechnisch gewährleistet sein. Aufgrund der komplexen Steuerungsvorgänge muss jede einzelne Druckstation mit einer eigenen speicherprogrammierbaren Steuerung ausgestattet werden. Ein auftretender Fehler in der Steuerung einer Druckerei bei geöffneten Schutzgittern muss verhindert werden, dass es entweder zu einem unerwarteten Anlauf einer stillstehenden Maschine oder zu einem Betrieb über angemessen reduzierten Drehzahlen kommt.

In großen Fabriken und Lagern bewegen sich fahrerlose, fahrerlose Roboterfahrzeuge auf speziell gekennzeichneten Gleisen. Diese Gleise können jederzeit von Personen begangen oder Materialien und Geräte versehentlich auf den Gleisen zurückgelassen werden, da sie baulich nicht von anderen Verkehrswegen getrennt sind. Aus diesem Grund muss eine Art Kollisionsverhütungsausrüstung verwendet werden, um sicherzustellen, dass das Fahrzeug zum Stillstand gebracht wird, bevor es zu einer gefährlichen Kollision mit einer Person oder einem Objekt kommt. In neueren Anwendungen erfolgt die Kollisionsvermeidung mittels Ultraschall- oder Laserlichttaster in Kombination mit einem Sicherheitsbumper. Da diese Systeme computergesteuert arbeiten, ist es möglich, mehrere permanente Erfassungszonen zu konfigurieren, sodass ein Fahrzeug seine Reaktion abhängig von der spezifischen Erfassungszone, in der sich eine Person befindet, modifizieren kann. Fehler in der Schutzeinrichtung dürfen nicht zu einer gefährlichen Kollision mit einer Person führen.

Guillotinen mit Papierschneidesteuerung werden verwendet, um dicke Papierstapel zu pressen und dann zu schneiden. Sie werden durch eine Zweihandbedienung ausgelöst. Der Benutzer muss nach jedem Schnitt in den Gefahrenbereich der Maschine greifen. Eine immaterielle Schutzeinrichtung, meist ein Lichtgitter, dient in Verbindung mit der Zweihandbedienung und einer sicheren Maschinensteuerung dazu, Verletzungen beim Zuführen von Papier während des Schneidvorgangs zu vermeiden. Nahezu alle heute verwendeten größeren, moderneren Guillotinen werden von Mehrkanal-Mikrocomputersystemen gesteuert. Auch die Zweihandbedienung und das Lichtgitter müssen sicher funktionieren.

Unfälle mit computergesteuerten Systemen

In nahezu allen industriellen Anwendungsbereichen werden Unfälle mit Software und Computern gemeldet (Neumann 1994). Computerausfälle führen in den meisten Fällen nicht zu Personenschäden. Solche Versäumnisse werden ohnehin nur öffentlich gemacht, wenn sie von allgemeinem öffentlichem Interesse sind. Das bedeutet, dass die Fehlfunktionen oder Unfälle im Zusammenhang mit Computern und Software, bei denen Personenschäden im Spiel waren, einen relativ hohen Anteil an allen bekannt gewordenen Fällen ausmachen. Leider werden Unfälle, die kein großes öffentliches Aufsehen erregen, nicht mit der gleichen Intensität auf ihre Ursachen hin untersucht wie größere Unfälle, typischerweise in Großanlagen. Aus diesem Grund beziehen sich die folgenden Beispiele auf vier für computergesteuerte Systeme typische Beschreibungen von Fehlfunktionen oder Unfällen außerhalb des Bereichs der Maschinenabsicherung, die Hinweise darauf geben, was bei sicherheitstechnischen Beurteilungen zu berücksichtigen ist.

Unfälle, die durch zufällige Fehler in der Hardware verursacht werden

Das folgende Missgeschick wurde durch eine Konzentration zufälliger Fehler in der Hardware in Verbindung mit Programmierfehlern verursacht: Ein Reaktor überhitzt in einer Chemiefabrik, woraufhin Überdruckventile geöffnet wurden, wodurch der Inhalt des Reaktors in die Atmosphäre abgelassen werden konnte. Dieses Missgeschick ereignete sich kurz nach einer Warnung, dass der Ölstand in einem Getriebe zu niedrig sei. Eine sorgfältige Untersuchung des Missgeschicks ergab, dass kurz nachdem der Katalysator die Reaktion im Reaktor ausgelöst hatte – wodurch der Reaktor mehr Kühlung benötigt hätte – der Computer aufgrund der Meldung von niedrigem Ölstand im Getriebe alles eingefroren hatte Größen unter seiner Kontrolle auf einen festen Wert. Dadurch blieb der Kaltwasserdurchfluss zu niedrig und der Reaktor überhitzt. Weitere Untersuchungen ergaben, dass die Anzeige eines niedrigen Ölstands durch eine fehlerhafte Komponente signalisiert worden war.

Die Software hatte entsprechend der Spezifikation mit der Auslösung eines Alarms und der Fixierung aller Betriebsvariablen reagiert. Dies war eine Folge der HAZOP-Studie (Hazards and Operability Analysis) (Knowlton 1986), die vor dem Ereignis durchgeführt wurde und die verlangte, dass alle kontrollierten Variablen im Falle eines Ausfalls nicht modifiziert werden. Da der Programmierer die Vorgehensweise im Detail nicht kannte, wurde diese Forderung dahingehend interpretiert, dass die angesteuerten Aktoren (hier Regelventile) nicht verändert werden sollten; Die Möglichkeit eines Temperaturanstiegs wurde nicht beachtet. Der Programmierer hat nicht berücksichtigt, dass sich das System nach dem Empfang eines fehlerhaften Signals in einer dynamischen Situation befinden könnte, die das aktive Eingreifen des Computers erfordert, um ein Missgeschick zu verhindern. Die Situation, die zu dem Missgeschick führte, war zudem so unwahrscheinlich, dass sie in der HAZOP-Studie (Levenson 1986) nicht im Detail analysiert worden war. Dieses Beispiel bietet einen Übergang zu einer zweiten Kategorie von Ursachen für Software- und Computerunfälle. Dies sind die systematischen Fehler, die von Anfang an im System vorhanden sind, sich aber nur in ganz bestimmten Situationen manifestieren, die der Entwickler nicht berücksichtigt hat.

Unfälle durch Betriebsstörungen

Bei Feldversuchen bei der Endkontrolle von Robotern lieh sich ein Techniker die Kassette eines benachbarten Roboters aus und tauschte sie gegen eine andere aus, ohne seinen Kollegen darüber zu informieren. Bei der Rückkehr an seinen Arbeitsplatz legte der Kollege die falsche Kassette ein. Da er neben dem Roboter stand und von ihm einen bestimmten Bewegungsablauf erwartete, der aufgrund des ausgetauschten Programms anders herauskam, kam es zu einer Kollision zwischen Roboter und Mensch. Dieser Unfall beschreibt das klassische Beispiel eines Betriebsausfalls. Die Rolle solcher Ausfälle bei Störungen und Unfällen nimmt derzeit aufgrund der zunehmenden Komplexität bei der Anwendung von computergesteuerten Sicherheitsmechanismen zu.

Unfälle, die durch systematische Fehler in Hard- oder Software verursacht werden

Ein Torpedo mit Sprengkopf sollte zu Übungszwecken von einem Kriegsschiff auf hoher See abgefeuert werden. Aufgrund eines Defekts im Antriebsapparat blieb der Torpedo im Torpedorohr. Der Kapitän beschloss, zum Heimathafen zurückzukehren, um den Torpedo zu bergen. Kurz nachdem das Schiff seinen Heimweg angetreten hatte, explodierte der Torpedo. Eine Analyse des Unfalls ergab, dass die Entwickler des Torpedos gezwungen waren, in den Torpedo einen Mechanismus einzubauen, der verhindern sollte, dass er nach dem Abfeuern zur Startrampe zurückkehrt und damit das Schiff zerstört, das ihn gestartet hat. Der dafür gewählte Mechanismus war folgender: Nach dem Abfeuern des Torpedos wurde mit dem Trägheitsnavigationssystem überprüft, ob sich dessen Kurs um 180° geändert hatte. Sobald der Torpedo spürte, dass er sich um 180 ° gedreht hatte, detonierte der Torpedo sofort, angeblich in sicherer Entfernung von der Startrampe. Dieser Detektionsmechanismus wurde bei dem nicht ordnungsgemäß abgefeuerten Torpedo ausgelöst, so dass der Torpedo explodierte, nachdem das Schiff seinen Kurs um 180° geändert hatte. Dies ist ein typisches Beispiel für einen Unfall, der aufgrund eines Fehlers in den Spezifikationen auftritt. Die Anforderung im Lastenheft, dass der Torpedo bei einer Kursänderung das eigene Schiff nicht zerstören dürfe, sei nicht präzise genug formuliert; die Vorsichtsmaßnahme wurde also falsch programmiert. Der Fehler trat nur in einer bestimmten Situation auf, die der Programmierer nicht als Möglichkeit in Betracht gezogen hatte.

Am 14. September 1993 stürzte ein Airbus A 320 der Lufthansa bei der Landung in Warschau ab (Bild 1). Eine sorgfältige Untersuchung des Unfalls ergab, dass Änderungen in der Landelogik des Bordcomputers nach einem Unfall mit einer Boeing 767 der Lauda Air im Jahr 1991 mitverantwortlich für diese Bruchlandung waren. Was beim Unfall von 1991 passiert war, war, dass die Schubumlenkung, die einen Teil der Motorgase umleitet, um das Flugzeug bei der Landung abzubremsen, noch in der Luft eingesetzt hatte, wodurch die Maschine in einen unkontrollierbaren Sturzflug gezwungen wurde. Aus diesem Grund war in die Airbus-Maschinen eine elektronische Verriegelung der Schubumlenkung eingebaut worden. Dieser Mechanismus ließ die Schubumlenkung erst wirksam werden, nachdem Sensoren an beiden Fahrwerkssätzen das Zusammendrücken der Stoßdämpfer unter dem Druck der aufsetzenden Räder signalisiert hatten. Aufgrund falscher Angaben rechneten die Piloten des Flugzeugs in Warschau mit starkem Seitenwind.

Abbildung 1. Lufthansa Airbus nach dem Unfall in Warschau 1993

Aus diesem Grund brachten sie die Maschine leicht geneigt an und der Airbus setzte nur mit dem rechten Rad auf, wobei das linke Lager weniger als das volle Gewicht beließ. Aufgrund der elektronischen Verriegelung der Schubumlenkung verweigerte der Bordcomputer dem Piloten für die Dauer von neun Sekunden solche Manöver, die dem Flugzeug trotz widriger Umstände eine sichere Landung ermöglicht hätten. Dieser Unfall zeigt sehr deutlich, dass Änderungen an Computersystemen zu neuen und gefährlichen Situationen führen können, wenn die Bandbreite ihrer möglichen Folgen nicht im Voraus berücksichtigt wird.

Auch das folgende Beispiel einer Fehlfunktion zeigt, welche verheerenden Auswirkungen die Änderung eines einzigen Befehls in Computersystemen haben kann. Der Alkoholgehalt des Blutes wird in chemischen Tests mit klarem Blutserum bestimmt, aus dem zuvor die Blutkörperchen abzentrifugiert wurden. Der Alkoholgehalt des Serums ist daher um den Faktor 1.2 höher als der des dickeren Vollbluts. Aus diesem Grund müssen die Alkoholwerte im Serum durch den Faktor 1.2 dividiert werden, um die rechtlich und medizinisch kritischen Promillezahlen zu ermitteln. Bei dem 1984 durchgeführten Ringversuch sollten die in identischen Tests an verschiedenen Forschungseinrichtungen mit Serum ermittelten Blutalkoholwerte miteinander verglichen werden. Da es sich nur um einen Vergleich handelte, wurde außerdem der Befehl zum Teilen durch 1.2 für die Dauer des Experiments an einer der Institutionen aus dem Programm gestrichen. Nach Beendigung des Ringversuchs wurde an dieser Stelle fälschlicherweise ein Befehl zum Multiplizieren mit 1.2 in das Programm eingefügt. Als Folge wurden zwischen August 1,500 und März 1984 rund 1985 falsche Promillewerte berechnet. Dieser Fehler war für die Berufskarrieren von Lkw-Fahrern mit Blutalkoholwerten zwischen 1.0 und 1.3 Promille kritisch, da bei einem Wert von 1.3 Promille eine strafrechtliche Ahndung des Führerscheins über einen längeren Zeitraum die Folge ist.

Unfälle, die durch Einwirkungen von Betriebsbeanspruchungen oder Umweltbelastungen verursacht werden

Als Folge einer durch Abfallansammlung verursachten Störung im Wirkbereich einer CNC (Computer Numeric Control) Stanz- und Nibbelmaschine hat der Anwender den „programmierten Stopp“ veranlasst. Als er versuchte, den Abfall mit den Händen zu entfernen, geriet die Schubstange der Maschine trotz des programmierten Stopps in Bewegung und verletzte den Benutzer schwer. Eine Analyse des Unfalls ergab, dass es sich nicht um einen Programmfehler gehandelt hatte. Der unerwartete Anlauf konnte nicht reproduziert werden. Ähnliche Unregelmäßigkeiten waren in der Vergangenheit bei anderen Maschinen des gleichen Typs beobachtet worden. Daraus lässt sich plausibel ableiten, dass der Unfall durch elektromagnetische Störungen verursacht worden sein muss. Ähnliche Unfälle mit Industrierobotern werden aus Japan berichtet (Neumann 1987).

Eine Fehlfunktion der Raumsonde Voyager 2 am 18. Januar 1986 macht den Einfluss von Umweltbelastungen auf computergesteuerte Systeme noch deutlicher. Sechs Tage vor der größten Annäherung an Uranus bedeckten große Felder aus schwarz-weißen Linien die Bilder von Voyager 2. Eine genaue Analyse ergab, dass ein einziges Bit in einem Befehlswort des Flugdaten-Subsystems den Ausfall verursacht hatte, beobachtet als die Bilder wurden in der Sonde komprimiert. Dieses Bit war höchstwahrscheinlich durch den Einschlag eines kosmischen Teilchens im Programmspeicher verschoben worden. Die fehlerfreie Übertragung der komprimierten Aufnahmen der Sonde erfolgte bereits zwei Tage später mit einem Ersatzprogramm, das den ausgefallenen Speicherpunkt umgehen konnte (Laeser, McLaughlin und Wolff 1987).

Zusammenfassung der vorgestellten Unfälle

Die analysierten Unfälle zeigen, dass bestimmte Risiken, die unter Bedingungen einfacher, elektromechanischer Technik vernachlässigt werden könnten, durch den Einsatz von Computern an Bedeutung gewinnen. Computer erlauben die Verarbeitung komplexer und situationsspezifischer Sicherheitsfunktionen. Eine eindeutige, fehlerfreie, vollständige und prüfbare Spezifikation aller Sicherheitsfunktionen wird aus diesem Grund besonders wichtig. Fehler in Spezifikationen sind schwer zu entdecken und häufig die Ursache für Unfälle in komplexen Systemen. Frei programmierbare Steuerungen werden meist mit der Absicht eingeführt, flexibel und schnell auf sich verändernde Märkte reagieren zu können. Modifikationen haben jedoch – insbesondere in komplexen Systemen – schwer vorhersehbare Nebenwirkungen. Alle Änderungen müssen daher einem streng formalen Änderungsmanagement unterzogen werden, bei dem eine klare Trennung von Sicherheitsfunktionen von nicht sicherheitsrelevanten Teilsystemen dazu beiträgt, die Folgen von Änderungen für die Sicherheitstechnik überschaubar zu halten.

Computer arbeiten mit geringem Stromverbrauch. Sie sind daher anfällig für Störungen durch externe Strahlungsquellen. Da die Veränderung eines einzigen Signals unter Millionen zu einer Fehlfunktion führen kann, lohnt es sich, dem Thema Elektromagnetische Verträglichkeit im Zusammenhang mit Computern besondere Aufmerksamkeit zu schenken.

Die Wartung computergesteuerter Systeme wird derzeit immer komplexer und damit unübersichtlicher. Die Software-Ergonomie von Bedien- und Konfigurationssoftware wird daher aus sicherheitstechnischer Sicht immer interessanter.

Kein Computersystem ist zu 100 % testbar. Eine einfache Steuerung mit 32 binären Eingangsports und 1,000 verschiedenen Softwarepfaden benötigt 4.3 × 1012 Tests für eine vollständige Überprüfung. Bei einer Rate von 100 durchgeführten und ausgewerteten Tests pro Sekunde würde ein vollständiger Test 1,362 Jahre dauern.

Verfahren und Maßnahmen zur Verbesserung computergesteuerter Sicherheitseinrichtungen

In den letzten 10 Jahren wurden Verfahren entwickelt, die es ermöglichen, spezifische sicherheitstechnische Herausforderungen im Zusammenhang mit Computern zu meistern. Diese Verfahren beziehen sich auf die in diesem Abschnitt beschriebenen Computerfehler. Die beschriebenen Beispiele von Software und Computern in der Maschinenabsicherung und die analysierten Unfälle zeigen, dass das Schadensausmaß und damit auch das Risiko bei verschiedenen Anwendungen sehr unterschiedlich sind. Es ist daher klar, dass die erforderlichen Vorkehrungen zur Verbesserung von Computern und Software, die in der Sicherheitstechnik verwendet werden, in Bezug auf das Risiko getroffen werden sollten.

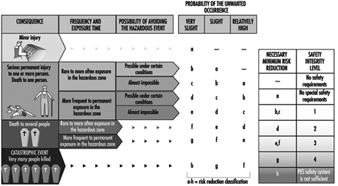

Abbildung 2 zeigt ein qualitatives Verfahren, mit dem die durch Sicherheitssysteme erzielbare notwendige Risikominderung unabhängig von Schadensausmaß und -häufigkeit ermittelt werden kann (Bell und Reinert 1992). Die im Abschnitt „Unfälle mit computergesteuerten Systemen“ (oben) analysierten Fehlerarten in Computersystemen können mit den sogenannten Safety Integrity Levels – also den technischen Einrichtungen zur Risikominderung – in Beziehung gesetzt werden.

Abbildung 2. Qualitatives Verfahren zur Risikobestimmung

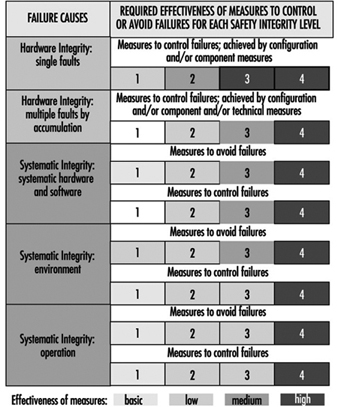

Abbildung 3 verdeutlicht, dass die Effektivität der jeweils getroffenen Maßnahmen zur Fehlerreduzierung in Software und Computern mit steigendem Risiko steigen muss (DIN 1994; IEC 1993).

Abbildung 3, Wirksamkeit der getroffenen Vorkehrungen gegen Fehler unabhängig vom Risiko

Die Analyse der oben skizzierten Unfälle zeigt, dass das Versagen computergesteuerter Schutzeinrichtungen nicht nur durch zufällige Bauteilfehler verursacht wird, sondern auch durch besondere Betriebsbedingungen, die der Programmierer nicht berücksichtigt hat. Eine weitere Fehlerquelle sind die nicht sofort ersichtlichen Folgen von Programmänderungen im Rahmen der Systemwartung. Daraus folgt, dass in mikroprozessorgesteuerten Sicherheitssystemen Fehler auftreten können, die zwar während der Entwicklung des Systems entstanden sind, aber erst im Betrieb zu einer gefährlichen Situation führen können. Bereits in der Entwicklungsphase sicherheitsrelevanter Systeme müssen daher Vorkehrungen gegen solche Ausfälle getroffen werden. Diese sogenannten Fehlervermeidungsmaßnahmen müssen nicht nur in der Konzeptphase, sondern auch im Prozess der Entwicklung, Installation und Modifikation getroffen werden. Bestimmte Fehler können vermieden werden, wenn sie dabei entdeckt und behoben werden (DIN 1990).

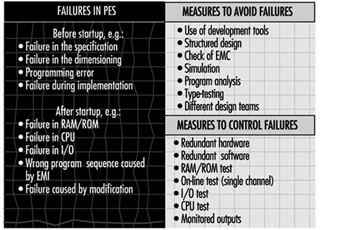

Wie das zuletzt beschriebene Missgeschick verdeutlicht, kann der Ausfall eines einzigen Transistors zum technischen Ausfall hochkomplexer automatisierter Anlagen führen. Da jede einzelne Schaltung aus vielen tausend Transistoren und anderen Komponenten zusammengesetzt ist, müssen zahlreiche Maßnahmen zur Fehlervermeidung ergriffen werden, um auftretende Fehler im Betrieb zu erkennen und eine entsprechende Reaktion im Computersystem einzuleiten. Abbildung 4 beschreibt Fehlerarten in programmierbaren elektronischen Systemen sowie Beispiele für Vorkehrungen, die getroffen werden können, um Fehler in Computersystemen zu vermeiden und zu beherrschen (DIN 1990; IEC 1992).

Abbildung 4. Beispiele für Vorkehrungen zur Kontrolle und Vermeidung von Fehlern in Computersystemen

Möglichkeiten und Perspektiven programmierbarer elektronischer Systeme in der Sicherheitstechnik

Moderne Maschinen und Anlagen werden immer komplexer und müssen immer umfangreichere Aufgaben in immer kürzerer Zeit bewältigen. Aus diesem Grund haben Computersysteme seit Mitte der 1970er Jahre nahezu alle Bereiche der Industrie erobert. Allein diese Zunahme der Komplexität hat maßgeblich zu den steigenden Kosten für die Verbesserung der Sicherheitstechnik in solchen Systemen beigetragen. Obwohl Software und Computer eine große Herausforderung an die Sicherheit am Arbeitsplatz darstellen, ermöglichen sie auch die Umsetzung neuer fehlerfreundlicher Systeme im Bereich der Sicherheitstechnik.

Ein skurriler, aber lehrreicher Vers von Ernst Jandl hilft zu erklären, was mit dem Begriff gemeint ist fehlerfreundlich. „Lichtung: Manche meinen Lechten und Rinks kann man nicht velwechsern, werch ein Illtum“. („Dilkation: Viele glauben, dass Licht und Reft nicht ausgetauscht werden können, was für ein Ello.“) Trotz des Austauschs der Briefe r und l, dieser Satz wird von einem normalen erwachsenen Menschen leicht verstanden. Sogar jemand mit geringen Englischkenntnissen kann es ins Englische übersetzen. Diese Aufgabe ist jedoch für einen Übersetzungscomputer allein nahezu unmöglich.

Dieses Beispiel zeigt, dass ein Mensch wesentlich fehlerfreundlicher reagieren kann als ein Sprachcomputer. Das bedeutet, dass der Mensch, wie alle anderen Lebewesen, Fehler tolerieren kann, indem er sie auf Erfahrung bezieht. Betrachtet man die heute im Einsatz befindlichen Maschinen, so sieht man, dass die Mehrzahl der Maschinen Ausfälle der Anwender nicht mit einem Unfall, sondern mit einem Produktionsrückgang bestrafen. Diese Eigenschaft führt zur Manipulation oder Umgehung von Schutzmaßnahmen. Moderne Computertechnik stellt dem Arbeitsschutz Systeme zur Verfügung, die intelligent – also modifiziert – reagieren können. Solche Systeme ermöglichen somit ein fehlerfreundliches Verhalten in neuartigen Maschinen. Sie warnen den Benutzer zunächst bei einer Fehlbedienung und schalten die Maschine erst dann ab, wenn nur so ein Unfall vermieden werden kann. Die Unfallanalyse zeigt, dass in diesem Bereich ein erhebliches Potenzial zur Reduzierung von Unfällen besteht (Reinert und Reuss 1991).

HAFTUNGSAUSSCHLUSS: Die ILO übernimmt keine Verantwortung für auf diesem Webportal präsentierte Inhalte, die in einer anderen Sprache als Englisch präsentiert werden, der Sprache, die für die Erstproduktion und Peer-Review von Originalinhalten verwendet wird. Bestimmte Statistiken wurden seitdem nicht aktualisiert die Produktion der 4. Auflage der Encyclopaedia (1998)."