Reinert, Dietmar AJ

Dirección: Berufsgenossenschaftliches Institut für Arbeitssicherheit, Alte Heerstrsse 111, 53754 Sankt Augustin

País: Alemania

Teléfono: 49 2241 231 645

Fax: 49 2241 231 234

E-mail: 100565.2233@compuserve.com

EDUCACION: BA, 1984, Universidad de Bonn; Dr. rer nat, 1987, Universidad de Bonn

Áreas de interés: Sistemas electrónicos programables en aplicaciones relacionadas con la seguridad; software seguro; dispositivos de protección accionados por sensores

Aplicaciones relacionadas con la seguridad

En los últimos años, los microprocesadores han jugado un papel cada vez mayor en el campo de la tecnología de seguridad. Debido a que las computadoras completas (es decir, la unidad central de procesamiento, la memoria y los componentes periféricos) ahora están disponibles en un solo componente como "computadoras de un solo chip", la tecnología de microprocesadores se emplea no solo en el control de máquinas complejas, sino también en salvaguardas de diseño relativamente simple. (por ejemplo, rejillas fotoeléctricas, dispositivos de control a dos manos y bordes de seguridad). El software que controla estos sistemas consta de entre mil y varias decenas de miles de comandos individuales y, por lo general, consta de varios cientos de ramas del programa. Los programas operan en tiempo real y en su mayoría están escritos en el lenguaje ensamblador de los programadores.

La introducción de sistemas controlados por computadora en el ámbito de la tecnología de seguridad ha ido acompañada en todos los equipos técnicos a gran escala no solo de costosos proyectos de investigación y desarrollo, sino también de importantes restricciones diseñadas para mejorar la seguridad. (La tecnología aeroespacial, la tecnología militar y la tecnología de energía atómica pueden citarse aquí como ejemplos de aplicaciones a gran escala). Hasta ahora, el campo colectivo de la producción industrial en masa ha sido tratado solo de manera muy limitada. Esto se debe en parte a que los rápidos ciclos de innovación característicos del diseño de máquinas industriales dificultan la transferencia, salvo de manera muy restringida, de los conocimientos que pueden derivarse de los proyectos de investigación relacionados con la prueba final de máquinas a gran escala. dispositivos de seguridad. Esto hace que el desarrollo de procedimientos de evaluación rápidos y de bajo costo sea un desiderátum (Reinert y Reuss 1991).

Este artículo primero examina las máquinas y las instalaciones en las que los sistemas informáticos actualmente realizan tareas de seguridad, utilizando ejemplos de accidentes que ocurren predominantemente en el área de protección de máquinas para describir el papel particular que desempeñan las computadoras en la tecnología de seguridad. Estos accidentes dan una idea de las precauciones que se deben tomar para que el equipo de seguridad controlado por computadora que actualmente se usa cada vez más no provoque un aumento en el número de accidentes. La sección final del artículo esboza un procedimiento que permitirá que incluso los sistemas informáticos más pequeños alcancen un nivel apropiado de seguridad técnica a un costo justificable y dentro de un período de tiempo aceptable. Los principios indicados en esta parte final se están introduciendo actualmente en los procedimientos de normalización internacional y tendrán implicaciones para todas las áreas de la tecnología de seguridad en las que las computadoras encuentran aplicación.

Ejemplos del uso de software y computadoras en el campo de la protección de máquinas

Los siguientes cuatro ejemplos dejan en claro que el software y las computadoras están entrando cada vez más en las aplicaciones relacionadas con la seguridad en el dominio comercial.

Las instalaciones de señalización de emergencia personal consisten, por regla general, en una estación receptora central y una serie de dispositivos de señalización de emergencia personal. Los dispositivos son transportados por personas que trabajan solas en el lugar. Si alguna de estas personas que trabajan solas se encuentra en una situación de emergencia, puede usar el dispositivo para disparar una alarma por señal de radio en la estación receptora central. Tal activación de alarma dependiente de la voluntad también puede complementarse con un mecanismo de activación independiente de la voluntad activado por sensores integrados en los dispositivos de emergencia personales. Tanto los dispositivos individuales como la estación receptora central suelen estar controlados por microordenadores. Es concebible que la falla de funciones individuales específicas de la computadora incorporada pueda conducir, en una situación de emergencia, a que no se dispare la alarma. Por lo tanto, se deben tomar precauciones para percibir y reparar a tiempo tal pérdida de función.

Las imprentas que se utilizan hoy en día para imprimir revistas son máquinas grandes. Las bandas de papel normalmente se preparan en una máquina separada de manera que se permita una transición sin problemas a un nuevo rollo de papel. Las páginas impresas se pliegan en una máquina plegadora y posteriormente se procesan a través de una cadena de otras máquinas. Esto da como resultado paletas cargadas con revistas completamente cosidas. Aunque tales plantas están automatizadas, hay dos puntos en los que se deben realizar intervenciones manuales: (1) en el enhebrado de las rutas del papel y (2) en la limpieza de obstrucciones causadas por rasgaduras de papel en puntos peligrosos de los rodillos giratorios. Por esta razón, la tecnología de control debe garantizar una velocidad de funcionamiento reducida o un modo de avance lento limitado en el tiempo o en el recorrido durante el ajuste de las prensas. Debido a los complejos procedimientos de dirección involucrados, cada estación de impresión debe estar equipada con su propio controlador lógico programable. Cualquier falla que ocurra en el control de una planta de impresión mientras las rejillas de protección están abiertas debe evitarse que provoque el arranque inesperado de una máquina parada o que la operación exceda las velocidades apropiadamente reducidas.

En grandes fábricas y almacenes, los vehículos robóticos guiados automatizados y sin conductor se mueven en pistas especialmente marcadas. Estas vías pueden ser transitadas en cualquier momento por personas, o los materiales y equipos pueden dejarse inadvertidamente en las vías, ya que no están separadas estructuralmente de otras líneas de tráfico. Por esta razón, se debe utilizar algún tipo de equipo de prevención de colisiones para garantizar que el vehículo se detenga antes de que ocurra una colisión peligrosa con una persona u objeto. En aplicaciones más recientes, la prevención de colisiones se efectúa por medio de escáneres ultrasónicos o de luz láser usados en combinación con un parachoques de seguridad. Dado que estos sistemas funcionan bajo control informático, es posible configurar varias zonas de detección permanentes para que un vehículo pueda modificar su reacción en función de la zona de detección concreta en la que se encuentre una persona. Los fallos en el dispositivo de protección no deben provocar una colisión peligrosa con una persona.

Las guillotinas del dispositivo de control de corte de papel se utilizan para presionar y luego cortar pilas gruesas de papel. Se activan mediante un dispositivo de control a dos manos. El usuario debe alcanzar la zona de peligro de la máquina después de cada corte. Se utiliza una protección inmaterial, generalmente una rejilla de luz, junto con el dispositivo de control a dos manos y un sistema seguro de control de la máquina para evitar lesiones cuando se alimenta papel durante la operación de corte. Casi todas las guillotinas más grandes y modernas que se usan hoy en día están controladas por sistemas de microcomputadoras multicanal. Tanto el manejo a dos manos como la rejilla fotoeléctrica también deben garantizar un funcionamiento seguro.

Accidentes con Sistemas Controlados por Computador

En casi todos los campos de aplicación industrial, se reportan accidentes con software y computadoras (Neumann 1994). En la mayoría de los casos, las fallas de la computadora no provocan lesiones a las personas. Tales incumplimientos, en todo caso, sólo se hacen públicos cuando son de interés público general. Esto significa que los casos de mal funcionamiento o accidente relacionados con computadoras y software en los que se involucran lesiones a personas representan una proporción relativamente alta de todos los casos publicitados. Desafortunadamente, los accidentes que no causan mucha sensación pública no se investigan en cuanto a sus causas con la misma intensidad que los accidentes más prominentes, típicamente en plantas a gran escala. Por este motivo, los ejemplos que siguen se refieren a cuatro descripciones de fallos de funcionamiento o accidentes típicos de sistemas controlados por ordenador fuera del campo de la protección de máquinas, que se utilizan para sugerir lo que debe tenerse en cuenta cuando se hacen juicios sobre tecnología de seguridad.

Accidentes causados por fallas aleatorias en el hardware

El siguiente percance fue causado por una concentración de fallas aleatorias en el hardware combinadas con una falla de programación: Un reactor se sobrecalentó en una planta química, por lo que se abrieron las válvulas de alivio, lo que permitió que el contenido del reactor se descargara a la atmósfera. Este percance ocurrió poco tiempo después de que se diera una advertencia de que el nivel de aceite en una caja de cambios era demasiado bajo. Una cuidadosa investigación del percance mostró que poco después de que el catalizador hubiera iniciado la reacción en el reactor, como consecuencia de lo cual el reactor habría requerido más enfriamiento, la computadora, sobre la base del informe de bajos niveles de aceite en la caja de engranajes, congeló todo. magnitudes bajo su control a un valor fijo. Esto mantuvo el flujo de agua fría a un nivel demasiado bajo y, como resultado, el reactor se sobrecalentó. La investigación posterior mostró que la indicación de niveles bajos de aceite había sido señalada por un componente defectuoso.

El software había respondido de acuerdo a la especificación con el disparo de una alarma y la fijación de todas las variables operativas. Esto fue consecuencia del estudio HAZOP (Hazards and Operability Analysis) (Knowlton 1986) realizado antes del evento, que requería que todas las variables controladas no se modificaran en caso de falla. Dado que el programador no conocía el procedimiento en detalle, este requisito se interpretó en el sentido de que los actuadores controlados (válvulas de control en este caso) no debían modificarse; no se prestó atención a la posibilidad de un aumento de la temperatura. El programador no tuvo en cuenta que después de haber recibido una señal errónea, el sistema podía encontrarse en una situación dinámica del tipo que requería la intervención activa de la computadora para evitar un percance. Además, la situación que condujo al percance era tan improbable que no había sido analizada en detalle en el estudio HAZOP (Levenson 1986). Este ejemplo proporciona una transición a una segunda categoría de causas de accidentes informáticos y de software. Son los fallos sistemáticos que están en el sistema desde el principio, pero que se manifiestan sólo en determinadas situaciones muy concretas que el desarrollador no ha tenido en cuenta.

Accidentes causados por fallas operativas

En las pruebas de campo durante la inspección final de los robots, un técnico tomó prestado el casete de un robot vecino y lo sustituyó por uno diferente sin informar a su colega que lo había hecho. Al regresar a su lugar de trabajo, el colega insertó el casete equivocado. Dado que se paró junto al robot y esperaba una secuencia particular de movimientos de él, una secuencia que resultó diferente debido al programa intercambiado, se produjo una colisión entre el robot y el ser humano. Este accidente describe el ejemplo clásico de una falla operativa. El papel de tales fallas en mal funcionamiento y accidentes está aumentando actualmente debido a la creciente complejidad en la aplicación de mecanismos de seguridad controlados por computadora.

Accidentes causados por fallas sistemáticas en hardware o software

Un torpedo con una ojiva debía haber sido disparado con fines de entrenamiento, desde un buque de guerra en alta mar. Debido a un defecto en el aparato impulsor, el torpedo permaneció en el tubo lanzatorpedos. El capitán decidió regresar al puerto de origen para rescatar el torpedo. Poco después de que el barco comenzara a regresar a casa, el torpedo explotó. Un análisis del accidente reveló que los desarrolladores del torpedo se habían visto obligados a construir en el torpedo un mecanismo diseñado para evitar que regresara a la plataforma de lanzamiento después de haber sido disparado y, por lo tanto, destruyera la nave que lo había lanzado. El mecanismo escogido para ello fue el siguiente: Tras el disparo del torpedo se comprobaba, mediante el sistema de navegación inercial, si su rumbo se había alterado en 180°. Tan pronto como el torpedo sintió que había girado 180°, el torpedo detonó inmediatamente, supuestamente a una distancia segura de la plataforma de lanzamiento. Este mecanismo de detección se activó en el caso del torpedo que no se había lanzado correctamente, con el resultado de que el torpedo explotó después de que el barco hubiera cambiado su rumbo 180°. Este es un ejemplo típico de un accidente que ocurre debido a una falla en las especificaciones. El requisito en las especificaciones de que el torpedo no debe destruir su propio barco si su rumbo cambia no se formuló con suficiente precisión; la precaución fue así programada erróneamente. El error se hizo evidente solo en una situación particular, una que el programador no había tenido en cuenta como una posibilidad.

El 14 de septiembre de 1993, un Lufthansa Airbus A 320 se estrelló mientras aterrizaba en Varsovia (figura 1). Una cuidadosa investigación del accidente mostró que las modificaciones en la lógica de aterrizaje de la computadora de a bordo realizadas después de un accidente con un Lauda Air Boeing 767 en 1991 fueron en parte responsables de este aterrizaje forzoso. Lo que sucedió en el accidente de 1991 fue que la desviación de empuje, que desvía una parte de los gases del motor para frenar el avión durante el aterrizaje, se había activado mientras aún estaba en el aire, lo que obligó a la máquina a caer en picado incontrolable. Por esta razón, se había incorporado un bloqueo electrónico de la desviación del empuje en las máquinas de Airbus. Este mecanismo permitió que la desviación del empuje entrara en vigor solo después de que los sensores en ambos juegos de tren de aterrizaje hubieran señalado la compresión de los amortiguadores bajo la presión de las ruedas al tocar tierra. Sobre la base de información incorrecta, los pilotos del avión en Varsovia anticiparon un fuerte viento lateral.

Figura 1. Lufthansa Airbus después del accidente en Varsovia 1993

Por esta razón, trajeron la máquina con una ligera inclinación y el Airbus aterrizó solo con la rueda derecha, dejando la izquierda soportando menos del peso total. Debido al bloqueo electrónico de la desviación del empuje, el ordenador de a bordo denegó al piloto durante nueve segundos maniobras que hubieran permitido al avión aterrizar con seguridad a pesar de las circunstancias adversas. Este accidente demuestra muy claramente que las modificaciones en los sistemas informáticos pueden conducir a situaciones nuevas y peligrosas si no se considera de antemano el rango de sus posibles consecuencias.

El siguiente ejemplo de mal funcionamiento también demuestra los efectos desastrosos que la modificación de un solo comando puede tener en los sistemas informáticos. El contenido de alcohol de la sangre se determina mediante pruebas químicas utilizando suero sanguíneo claro del que se han centrifugado previamente los glóbulos sanguíneos. El contenido de alcohol del suero es, por lo tanto, mayor (en un factor de 1.2) que el de la sangre total más espesa. Por esta razón, los valores de alcohol en suero deben dividirse por un factor de 1.2 para establecer las cifras de partes por mil legal y médicamente críticas. En la prueba entre laboratorios realizada en 1984, los valores de alcohol en sangre determinados en pruebas idénticas realizadas en diferentes instituciones de investigación utilizando suero debían compararse entre sí. Dado que solo se trataba de una cuestión de comparación, el comando de dividir por 1.2 se borró del programa en una de las instituciones durante la duración del experimento. Una vez finalizada la prueba entre laboratorios, se introdujo erróneamente en el programa en este punto un comando para multiplicar por 1.2. Como resultado, se calcularon aproximadamente 1,500 valores incorrectos de partes por mil entre agosto de 1984 y marzo de 1985. Este error fue crítico para la carrera profesional de los camioneros con niveles de alcohol en sangre entre 1.0 y 1.3 por mil, ya que una sanción legal de confiscación de la licencia de conducir por tiempo prolongado es consecuencia de un valor de 1.3 por mil.

Accidentes causados por influencias de estrés operativo o estrés ambiental

Como consecuencia de una perturbación provocada por la recogida de residuos en la zona efectiva de una punzonadora y mordisqueadora CNC (control numérico computarizado), el usuario efectuó la “parada programada”. Mientras intentaba retirar los desechos con las manos, la varilla de empuje de la máquina comenzó a moverse a pesar de la parada programada y lesionó gravemente al usuario. Un análisis del accidente reveló que no se había tratado de un error en el programa. No se pudo reproducir el inicio inesperado. Se habían observado irregularidades similares en el pasado en otras máquinas del mismo tipo. Parece plausible deducir de estos que el accidente debió haber sido causado por interferencias electromagnéticas. Se informan accidentes similares con robots industriales en Japón (Neumann 1987).

Un mal funcionamiento en la sonda espacial Voyager 2 el 18 de enero de 1986 deja aún más clara la influencia de las tensiones ambientales en los sistemas controlados por computadora. Seis días antes del acercamiento más cercano a Urano, grandes campos de líneas en blanco y negro cubrieron las imágenes de la Voyager 2. Un análisis preciso mostró que un solo bit en una palabra de comando del subsistema de datos de vuelo había causado la falla, observada como las imágenes fueron comprimidas en la sonda. Lo más probable es que este bit se haya salido de su lugar dentro de la memoria del programa por el impacto de una partícula cósmica. La transmisión sin errores de las fotografías comprimidas de la sonda se efectuó solo dos días después, utilizando un programa de reemplazo capaz de pasar por alto el punto de memoria fallido (Laeser, McLaughlin y Wolff 1987).

Resumen de los accidentes presentados

Los accidentes analizados muestran que ciertos riesgos que podrían ser despreciados en condiciones de uso de tecnología electromecánica simple, ganan importancia cuando se utilizan computadoras. Los ordenadores permiten el procesamiento de funciones de seguridad complejas y específicas de la situación. Una especificación inequívoca, libre de errores, completa y verificable de todas las funciones de seguridad se vuelve especialmente importante. Los errores en las especificaciones son difíciles de descubrir y con frecuencia son la causa de accidentes en sistemas complejos. Los controles libremente programables generalmente se introducen con la intención de poder reaccionar de manera flexible y rápida al mercado cambiante. Sin embargo, las modificaciones, particularmente en sistemas complejos, tienen efectos secundarios que son difíciles de prever. Por lo tanto, todas las modificaciones deben estar sujetas a un procedimiento de gestión de cambios estrictamente formal en el que una separación clara de las funciones de seguridad de los sistemas parciales que no son relevantes para la seguridad ayudará a que las consecuencias de las modificaciones para la tecnología de seguridad sean fáciles de evaluar.

Las computadoras funcionan con bajos niveles de electricidad. Por lo tanto, son susceptibles a la interferencia de fuentes de radiación externas. Dado que la modificación de una sola señal entre millones puede provocar un mal funcionamiento, vale la pena prestar especial atención al tema de la compatibilidad electromagnética en relación con las computadoras.

El mantenimiento de los sistemas controlados por computadora se está volviendo cada vez más complejo y, por lo tanto, menos claro. La ergonomía del software del usuario y del software de configuración es, por lo tanto, cada vez más interesante desde el punto de vista de la tecnología de seguridad.

Ningún sistema informático es 100% comprobable. Un mecanismo de control simple con 32 puertos de entrada binarios y 1,000 rutas de software diferentes requiere 4.3 × 1012 Pruebas para un control completo. A un ritmo de 100 pruebas por segundo ejecutadas y evaluadas, una prueba completa tardaría 1,362 años.

Procedimientos y Medidas para la Mejora de los Dispositivos de Seguridad Controlados desde Computador (PC)

Se han desarrollado procedimientos en los últimos 10 años que permiten el dominio de desafíos específicos relacionados con la seguridad en relación con las computadoras. Estos procedimientos se dirigen a las fallas de la computadora descritas en esta sección. Los ejemplos descritos de software y ordenadores en la protección de máquinas y los accidentes analizados muestran que la magnitud del daño y, por lo tanto, también el riesgo involucrado en diversas aplicaciones es extremadamente variable. Por lo tanto, es claro que las precauciones necesarias para la mejora de las computadoras y el software utilizado en tecnología de seguridad deben establecerse en relación con el riesgo.

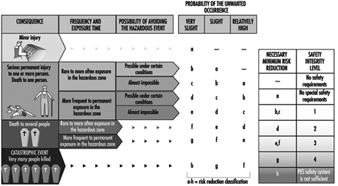

La figura 2 muestra un procedimiento cualitativo mediante el cual se puede determinar la reducción de riesgos necesaria que se puede obtener mediante los sistemas de seguridad, independientemente del alcance y la frecuencia con que se produzcan los daños (Bell y Reinert 1992). Los tipos de fallos en los sistemas informáticos analizados en el apartado “Accidentes con sistemas controlados por ordenador” (anterior) pueden relacionarse con los denominados Niveles de Integridad de la Seguridad, es decir, las facilidades técnicas para la reducción del riesgo.

Figura 2. Procedimiento cualitativo para la determinación del riesgo

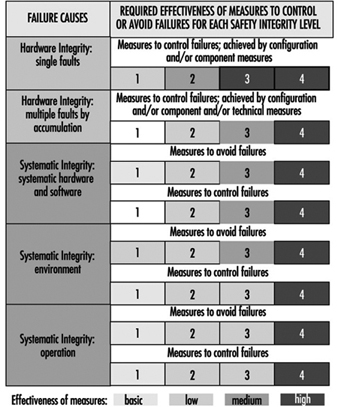

La Figura 3 deja en claro que la efectividad de las medidas tomadas, en cualquier caso dado, para reducir los errores en el software y las computadoras debe crecer con el aumento del riesgo (DIN 1994; IEC 1993).

Figura 3, Efectividad de las precauciones tomadas contra errores independientemente del riesgo

El análisis de los accidentes esbozados arriba muestra que la falla de las protecciones controladas por computadora es causada no solo por fallas aleatorias de los componentes, sino también por condiciones de operación particulares que el programador no ha tenido en cuenta. Las consecuencias no inmediatamente obvias de las modificaciones del programa realizadas en el curso del mantenimiento del sistema constituyen una fuente adicional de error. De ello se deduce que pueden existir fallos en los sistemas de seguridad controlados por microprocesadores que, aunque se produzcan durante el desarrollo del sistema, pueden dar lugar a una situación de peligro sólo durante su funcionamiento. Por lo tanto, se deben tomar precauciones contra tales fallas mientras los sistemas relacionados con la seguridad se encuentran en la etapa de desarrollo. Estas llamadas medidas para evitar fallas deben tomarse no solo durante la fase de concepto, sino también en el proceso de desarrollo, instalación y modificación. Ciertas fallas pueden evitarse si se descubren y corrigen durante este proceso (DIN 1990).

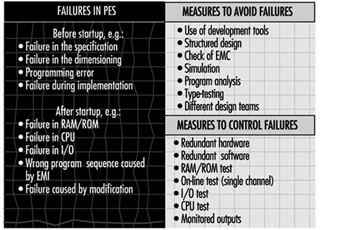

Como deja en claro el último percance descrito, la falla de un solo transistor puede conducir a la falla técnica de equipos automatizados altamente complejos. Dado que cada circuito individual está compuesto por muchos miles de transistores y otros componentes, se deben tomar numerosas medidas para evitar fallas a fin de reconocer tales fallas en el funcionamiento e iniciar una reacción apropiada en el sistema informático. La Figura 4 describe los tipos de fallas en los sistemas electrónicos programables, así como ejemplos de precauciones que se pueden tomar para evitar y controlar las fallas en los sistemas informáticos (DIN 1990; IEC 1992).

Figura 4. Ejemplos de precauciones tomadas para controlar y evitar errores en los sistemas informáticos

Posibilidades y perspectivas de los sistemas electrónicos programables en tecnología de seguridad

Las máquinas e instalaciones modernas son cada vez más complejas y deben realizar tareas cada vez más completas en períodos de tiempo cada vez más cortos. Por esta razón, los sistemas informáticos se han apoderado de casi todas las áreas de la industria desde mediados de la década de 1970. Este aumento en la complejidad por sí solo ha contribuido significativamente al aumento de los costos involucrados en la mejora de la tecnología de seguridad en tales sistemas. Si bien el software y las computadoras representan un gran desafío para la seguridad en el lugar de trabajo, también hacen posible la implementación de nuevos sistemas amigables con los errores en el campo de la tecnología de seguridad.

Un verso divertido pero instructivo de Ernst Jandl ayudará a explicar lo que significa el concepto amigable con los errores. “Lichtung: Manche meinen lechts und rinks kann man nicht velwechsern, werch ein Illtum”. (“Dilection: Muchos creen en la luz y no pueden ser intelcambiados, qué elol”.) A pesar del intercambio de cartas r y l, esta frase es fácilmente entendida por un humano adulto normal. Incluso alguien con poca fluidez en el idioma inglés puede traducirlo al inglés. Sin embargo, la tarea es casi imposible para una computadora traductora por sí sola.

Este ejemplo muestra que un ser humano puede reaccionar de una manera mucho más amigable con los errores que una computadora de lenguaje. Esto significa que los humanos, como todas las demás criaturas vivientes, pueden tolerar los fracasos remitiéndolos a la experiencia. Si uno mira las máquinas en uso hoy en día, puede ver que la mayoría de las máquinas penalizan las fallas del usuario no con un accidente, sino con una disminución en la producción. Esta propiedad conduce a la manipulación o evasión de las salvaguardas. La tecnología informática moderna pone a disposición de la seguridad en el trabajo sistemas que pueden reaccionar de forma inteligente, es decir, de forma modificada. Dichos sistemas hacen posible, por lo tanto, un modo de comportamiento favorable a los errores en las máquinas novedosas. En primer lugar, advierten a los usuarios durante una operación incorrecta y apagan la máquina solo cuando esta es la única forma de evitar un accidente. El análisis de los accidentes muestra que existe en esta área un potencial considerable para reducir los accidentes (Reinert y Reuss 1991).

" EXENCIÓN DE RESPONSABILIDAD: La OIT no se responsabiliza por el contenido presentado en este portal web que se presente en un idioma que no sea el inglés, que es el idioma utilizado para la producción inicial y la revisión por pares del contenido original. Ciertas estadísticas no se han actualizado desde la producción de la 4ª edición de la Enciclopedia (1998)."