Reinert, Dietmar AJ

Endereço: Berufsgenossenschaftliches Institut für Arbeitssicherheit, Alte Heerstrsse 111, 53754 Sankt Augustin

País: Alemanha

Telefone: 49 2241 231 645

Telefax: 49 2241 231 234

E-mail 100565.2233@compuserve.com

Educação: BA, 1984, Universidade de Bonn; Dr rer nat, 1987, Universidade de Bonn

Áreas de interesse: Sistemas eletrônicos programáveis em aplicações relacionadas à segurança; software seguro; dispositivos de proteção acionados por sensor

Aplicações relacionadas à segurança

Nos últimos anos, os microprocessadores desempenharam um papel cada vez maior no campo da tecnologia de segurança. Como computadores inteiros (ou seja, unidade central de processamento, memória e componentes periféricos) estão agora disponíveis em um único componente como “computadores de chip único”, a tecnologia de microprocessador está sendo empregada não apenas no controle de máquinas complexas, mas também em salvaguardas de design relativamente simples (por exemplo, grades de luz, dispositivos de controle bimanual e bordas de segurança). O software que controla esses sistemas compreende entre mil e várias dezenas de milhares de comandos únicos e geralmente consiste em várias centenas de ramificações do programa. Os programas operam em tempo real e são escritos principalmente na linguagem assembly dos programadores.

A introdução de sistemas controlados por computador na esfera da tecnologia de segurança foi acompanhada em todos os equipamentos técnicos de grande escala, não apenas por projetos caros de pesquisa e desenvolvimento, mas também por restrições significativas destinadas a aumentar a segurança. (A tecnologia aeroespacial, a tecnologia militar e a tecnologia de energia atômica podem ser citadas aqui como exemplos de aplicações em larga escala.) Até agora, o campo coletivo da produção industrial em massa foi tratado apenas de maneira muito limitada. Isso se deve em parte ao fato de que os rápidos ciclos de inovação característicos do projeto de máquinas industriais tornam difícil transferir, exceto de maneira muito restrita, o conhecimento que pode ser derivado de projetos de pesquisa relacionados ao teste final de máquinas em larga escala. dispositivos de segurança. Isso torna o desenvolvimento de procedimentos de avaliação rápidos e de baixo custo um desiderato (Reinert e Reuss 1991).

Este artigo primeiro examina máquinas e instalações nas quais os sistemas de computador atualmente executam tarefas de segurança, usando exemplos de acidentes que ocorrem predominantemente na área de proteção de máquinas para descrever o papel específico que os computadores desempenham na tecnologia de segurança. Esses acidentes dão algumas indicações sobre quais precauções devem ser tomadas para que os equipamentos de segurança controlados por computador, cada vez mais amplamente utilizados, não levem a um aumento no número de acidentes. A seção final do artigo esboça um procedimento que permitirá que até mesmo pequenos sistemas de computador sejam levados a um nível apropriado de segurança técnica a um custo justificável e dentro de um período de tempo aceitável. Os princípios indicados nesta parte final estão sendo introduzidos nos procedimentos de padronização internacional e terão implicações para todas as áreas de tecnologia de segurança nas quais os computadores encontram aplicação.

Exemplos de uso de software e computadores no campo de proteção de máquinas

Os quatro exemplos a seguir deixam claro que o software e os computadores estão entrando cada vez mais em aplicações relacionadas à segurança no domínio comercial.

As instalações de sinalização pessoal de emergência consistem, em regra, de uma estação central receptora e de vários dispositivos de sinalização pessoal de emergência. Os dispositivos são transportados por pessoas que trabalham sozinhas no local. Se alguma dessas pessoas trabalhando sozinhas se encontrar em uma situação de emergência, pode usar o dispositivo para disparar um alarme por sinal de rádio na estação receptora central. Tal disparo de alarme dependente da vontade também pode ser complementado por um mecanismo de disparo independente da vontade ativado por sensores embutidos nos dispositivos de emergência pessoais. Ambos os dispositivos individuais e a estação receptora central são freqüentemente controlados por microcomputadores. É concebível que a falha de funções individuais específicas do computador embutido possa levar, em uma situação de emergência, a uma falha no acionamento do alarme. Portanto, precauções devem ser tomadas para perceber e reparar essa perda de função a tempo.

As impressoras usadas hoje para imprimir revistas são máquinas grandes. As teias de papel são normalmente preparadas por uma máquina separada de modo a permitir uma transição perfeita para um novo rolo de papel. As páginas impressas são dobradas por uma máquina de dobragem e subsequentemente trabalhadas através de uma cadeia de outras máquinas. Isso resulta em paletes carregadas com revistas totalmente costuradas. Embora tais plantas sejam automatizadas, há dois pontos em que intervenções manuais devem ser feitas: (1) no enfiamento dos caminhos do papel e (2) na desobstrução causada por rasgos de papel em pontos perigosos dos rolos rotativos. Por esta razão, uma velocidade de operação reduzida ou um modo jogging limitado por caminho ou tempo deve ser assegurado pela tecnologia de controle enquanto as prensas estão sendo ajustadas. Devido aos complexos procedimentos de direção envolvidos, cada estação de impressão deve ser equipada com seu próprio controlador lógico programável. Qualquer falha que ocorra no controle de uma planta de impressão enquanto as grades de proteção estiverem abertas deve ser impedida de levar à inicialização inesperada de uma máquina parada ou à operação em excesso de velocidades apropriadamente reduzidas.

Em grandes fábricas e armazéns, veículos robóticos guiados automaticamente e sem motorista se movem em trilhos especialmente marcados. Esses trilhos podem ser percorridos a qualquer momento por pessoas, ou materiais e equipamentos podem ser deixados inadvertidamente nos trilhos, uma vez que não são separados estruturalmente de outras linhas de tráfego. Por esse motivo, algum tipo de equipamento de prevenção de colisão deve ser usado para garantir que o veículo seja parado antes que ocorra qualquer colisão perigosa com uma pessoa ou objeto. Em aplicações mais recentes, a prevenção de colisões é realizada por meio de scanners ultrassônicos ou de luz laser usados em combinação com um amortecedor de segurança. Como esses sistemas funcionam sob controle computadorizado, é possível configurar várias zonas de detecção permanentes para que um veículo modifique sua reação dependendo da zona de detecção específica em que uma pessoa se encontra. Falhas no dispositivo de proteção não devem levar a uma colisão perigosa com uma pessoa.

As guilhotinas do dispositivo de controle de corte de papel são usadas para pressionar e depois cortar pilhas grossas de papel. Eles são acionados por um dispositivo de controle bimanual. O usuário deve alcançar a zona de perigo da máquina após cada corte. Uma proteção imaterial, geralmente uma grade de luz, é usada em conjunto com o dispositivo de controle bimanual e um sistema seguro de controle da máquina para evitar ferimentos quando o papel é alimentado durante a operação de corte. Quase todas as guilhotinas maiores e mais modernas em uso hoje são controladas por sistemas de microcomputadores multicanal. Tanto a operação bimanual quanto a grade de luz também devem funcionar com segurança.

Acidentes com Sistemas Controlados por Computador

Em quase todos os campos de aplicação industrial, acidentes com software e computadores são relatados (Neumann 1994). Na maioria dos casos, as falhas do computador não causam ferimentos às pessoas. Tais falhas são, em qualquer caso, tornadas públicas apenas quando são de interesse público geral. Isso significa que os casos de mau funcionamento ou acidente relacionados a computadores e softwares que envolvem lesões a pessoas representam uma proporção relativamente alta de todos os casos divulgados. Infelizmente, os acidentes que não causam grande sensação pública não são investigados quanto às suas causas com a mesma intensidade que os acidentes mais proeminentes, geralmente em fábricas de grande porte. Por esta razão, os exemplos a seguir referem-se a quatro descrições de mau funcionamento ou acidentes típicos de sistemas controlados por computador fora do campo de proteção de máquinas, que são usados para sugerir o que deve ser levado em consideração quando são feitos julgamentos sobre tecnologia de segurança.

Acidentes causados por falhas aleatórias no hardware

O seguinte acidente foi causado por uma concentração de falhas aleatórias no hardware combinadas com falhas de programação: Um reator superaqueceu em uma fábrica de produtos químicos, após o que as válvulas de alívio foram abertas, permitindo que o conteúdo do reator fosse descarregado na atmosfera. Esse acidente ocorreu pouco tempo depois de um aviso ter sido dado de que o nível de óleo em uma caixa de câmbio estava muito baixo. A investigação cuidadosa do acidente mostrou que logo após o catalisador ter iniciado a reação no reator - em consequência do qual o reator teria exigido mais resfriamento - o computador, com base no relatório de baixos níveis de óleo na caixa de engrenagens, congelou todos magnitudes sob seu controle em um valor fixo. Isso manteve o fluxo de água fria em um nível muito baixo e, como resultado, o reator superaqueceu. Uma investigação mais aprofundada mostrou que a indicação de níveis baixos de óleo foi sinalizada por um componente defeituoso.

O software respondeu de acordo com a especificação com o disparo de um alarme e a fixação de todas as variáveis operativas. Isso foi consequência do estudo HAZOP (hazards and operability analysis) (Knowlton 1986) feito antes do evento, que exigia que todas as variáveis controladas não fossem modificadas em caso de falha. Como o programador não conhecia o procedimento em detalhes, este requisito foi interpretado como significando que os atuadores controlados (válvulas de controle neste caso) não deveriam ser modificados; nenhuma atenção foi dada à possibilidade de um aumento na temperatura. O programador não levou em consideração que, após receber um sinal errado, o sistema poderia se encontrar em uma situação dinâmica do tipo que exige a intervenção ativa do computador para evitar um acidente. Além disso, a situação que levou ao acidente era tão improvável que não havia sido analisada em detalhes no estudo HAZOP (Levenson 1986). Este exemplo fornece uma transição para uma segunda categoria de causas de acidentes de software e computador. Estas são as falhas sistemáticas que estão no sistema desde o início, mas que se manifestam apenas em algumas situações muito específicas que o desenvolvedor não levou em consideração.

Acidentes causados por falhas operacionais

Em testes de campo durante a inspeção final dos robôs, um técnico pegou emprestado o cassete de um robô vizinho e o substituiu por outro sem informar ao colega que o havia feito. Ao retornar ao local de trabalho, o colega inseriu o cassete errado. Como ele estava ao lado do robô e esperava uma sequência particular de movimentos dele - uma sequência que saiu diferente por causa do programa trocado - ocorreu uma colisão entre o robô e o humano. Este acidente descreve o exemplo clássico de uma falha operacional. O papel de tais falhas em mau funcionamento e acidentes está aumentando devido à crescente complexidade na aplicação de mecanismos de segurança controlados por computador.

Acidentes causados por falhas sistemáticas em hardware ou software

Um torpedo com ogiva deveria ter sido disparado para fins de treinamento, de um navio de guerra em alto mar. Devido a um defeito no aparelho de acionamento, o torpedo permaneceu no tubo do torpedo. O capitão decidiu retornar ao porto de origem para resgatar o torpedo. Pouco depois de o navio começar a voltar para casa, o torpedo explodiu. Uma análise do acidente revelou que os desenvolvedores do torpedo foram obrigados a construir no torpedo um mecanismo projetado para evitar que ele retorne à plataforma de lançamento após ter sido disparado, destruindo assim o navio que o lançou. O mecanismo escolhido para isso foi o seguinte: Após o disparo do torpedo foi feita uma verificação, utilizando o sistema de navegação inercial, para ver se o seu curso havia alterado 180°. Assim que o torpedo percebeu que havia girado 180°, o torpedo detonou imediatamente, supostamente a uma distância segura da plataforma de lançamento. Este mecanismo de detecção foi acionado no caso do torpedo que não havia sido lançado corretamente, fazendo com que o torpedo explodisse após o navio ter mudado seu curso em 180°. Este é um exemplo típico de acidente ocorrido por falha nas especificações. O requisito nas especificações de que o torpedo não deve destruir seu próprio navio caso seu curso mude não foi formulado com precisão suficiente; a precaução foi assim programada erroneamente. O erro tornou-se aparente apenas em uma situação particular, que o programador não havia levado em consideração como uma possibilidade.

Em 14 de setembro de 1993, um Lufthansa Airbus A 320 caiu ao pousar em Varsóvia (figura 1). Uma investigação cuidadosa do acidente mostrou que modificações na lógica de pouso do computador de bordo feitas após um acidente com um Boeing 767 da Lauda Air em 1991 foram parcialmente responsáveis por esse pouso forçado. O que aconteceu no acidente de 1991 foi que a deflexão do empuxo, que desvia parte dos gases do motor para frear o avião durante o pouso, foi acionada ainda no ar, forçando a máquina a um mergulho de nariz incontrolável. Por esta razão, um bloqueio eletrônico da deflexão de empuxo foi incorporado às máquinas Airbus. Esse mecanismo permitia que a deflexão do impulso entrasse em vigor somente após os sensores em ambos os conjuntos de trem de pouso terem sinalizado a compressão dos amortecedores sob a pressão das rodas tocando o solo. Com base em informações incorretas, os pilotos do avião em Varsóvia previram um forte vento lateral.

Figura 1. Lufthansa Airbus após acidente em Varsóvia 1993

Por esse motivo, eles trouxeram a máquina com uma leve inclinação e o Airbus pousou apenas com a roda direita, deixando o rolamento esquerdo com menos do que o peso total. Por conta do travamento eletrônico da deflexão de empuxo, o computador de bordo negou ao piloto pelo espaço de nove segundos manobras que teriam permitido ao avião pousar com segurança apesar das circunstâncias adversas. Este acidente demonstra muito claramente que as modificações nos sistemas de computador podem levar a situações novas e perigosas se o leque de suas possíveis consequências não for considerado com antecedência.

O seguinte exemplo de mau funcionamento também demonstra os efeitos desastrosos que a modificação de um único comando pode ter em sistemas de computador. O teor de álcool do sangue é determinado, em testes químicos, usando soro de sangue claro do qual os glóbulos sanguíneos foram previamente centrifugados. O teor de álcool do soro é, portanto, maior (por um fator de 1.2) do que o do sangue total mais espesso. Por esta razão, os valores de álcool no soro devem ser divididos por um fator de 1.2 a fim de estabelecer as partes por milhar legais e medicamente críticas. No teste interlaboratorial realizado em 1984, deveriam ser comparados os valores de alcoolemia apurados em testes idênticos, realizados em diferentes instituições de pesquisa com soro. Como era apenas uma questão de comparação, o comando para dividir por 1.2 foi apagado do programa em uma das instituições durante o experimento. Após o término do teste interlaboratorial, um comando para multiplicar por 1.2 foi introduzido erroneamente no programa neste local. Aproximadamente 1,500 valores incorretos de partes por mil foram calculados entre agosto de 1984 e março de 1985 como resultado. Esse erro foi crítico para a carreira profissional dos caminhoneiros com alcoolemia entre 1.0 e 1.3 por mil, uma vez que uma penalidade legal de cassação da carteira de habilitação por tempo prolongado é consequência de um valor de 1.3 por mil.

Acidentes causados por influências de tensões operacionais ou ambientais

Em consequência de uma perturbação causada pela recolha de desperdícios na área útil de uma puncionadora e mordiscada CNC (controlo numérico computadorizado), o utilizador efectuou a “paragem programada”. Ao tentar retirar os resíduos com as mãos, a haste da máquina começou a se mover apesar da parada programada e feriu gravemente o usuário. Uma análise do acidente revelou que não se tratava de um erro no programa. A inicialização inesperada não pôde ser reproduzida. Irregularidades semelhantes foram observadas no passado em outras máquinas do mesmo tipo. Parece plausível deduzir disso que o acidente deve ter sido causado por interferência eletromagnética. Acidentes semelhantes com robôs industriais são relatados no Japão (Neumann 1987).

Um mau funcionamento na sonda espacial Voyager 2 em 18 de janeiro de 1986 torna ainda mais clara a influência do estresse ambiental nos sistemas controlados por computador. Seis dias antes da aproximação mais próxima de Urano, grandes campos de linhas em preto e branco cobriam as fotos da Voyager 2. Uma análise precisa mostrou que um único bit em uma palavra de comando do subsistema de dados de voo causou a falha, observada como as imagens foram comprimidas na sonda. Este bit provavelmente foi deslocado dentro da memória do programa pelo impacto de uma partícula cósmica. A transmissão sem erros das fotografias comprimidas da sonda foi realizada apenas dois dias depois, usando um programa de substituição capaz de contornar o ponto de memória com falha (Laeser, McLaughlin e Wolff 1987).

Resumo dos acidentes apresentados

Os acidentes analisados mostram que certos riscos que podem ser negligenciados em condições que utilizam tecnologia eletromecânica simples, ganham importância quando se utiliza computadores. Os computadores permitem o processamento de funções de segurança complexas e específicas da situação. Uma especificação inequívoca, livre de erros, completa e testável de todas as funções de segurança torna-se, por isso, especialmente importante. Erros nas especificações são difíceis de descobrir e frequentemente são a causa de acidentes em sistemas complexos. Os controles livremente programáveis são geralmente introduzidos com a intenção de ser capaz de reagir com flexibilidade e rapidez às mudanças do mercado. As modificações, no entanto, especialmente em sistemas complexos, têm efeitos colaterais difíceis de prever. Todas as modificações devem, portanto, ser submetidas a um gerenciamento estritamente formal do procedimento de mudança, no qual uma separação clara das funções de segurança dos sistemas parciais não relevantes para a segurança ajudará a manter as consequências das modificações para a tecnologia de segurança fáceis de avaliar.

Os computadores funcionam com baixos níveis de eletricidade. Eles são, portanto, suscetíveis à interferência de fontes externas de radiação. Como a modificação de um único sinal entre milhões pode levar a um mau funcionamento, vale a pena dar atenção especial ao tema da compatibilidade eletromagnética em conexão com computadores.

Atualmente, a manutenção de sistemas controlados por computador está se tornando cada vez mais complexa e, portanto, menos clara. A ergonomia do software do usuário e do software de configuração está, portanto, se tornando mais interessante do ponto de vista da tecnologia de segurança.

Nenhum sistema de computador é 100% testável. Um mecanismo de controle simples com 32 portas de entrada binária e 1,000 caminhos de software diferentes requer 4.3 × 1012 testes para uma verificação completa. A uma taxa de 100 testes por segundo executados e avaliados, um teste completo levaria 1,362 anos.

Procedimentos e medidas para a melhoria dos dispositivos de segurança controlados por computador

Nos últimos 10 anos, foram desenvolvidos procedimentos que permitem o domínio de desafios específicos relacionados à segurança em conexão com computadores. Esses procedimentos tratam das falhas do computador descritas nesta seção. Os exemplos descritos de software e computadores em proteções de máquinas e os acidentes analisados mostram que a extensão dos danos e, portanto, também o risco envolvido em várias aplicações são extremamente variáveis. Fica claro, portanto, que os cuidados necessários para o aperfeiçoamento dos computadores e softwares utilizados na tecnologia de segurança devem ser estabelecidos em relação ao risco.

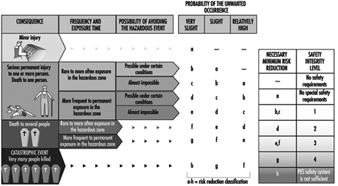

A Figura 2 mostra um procedimento qualitativo por meio do qual a redução de risco necessária obtida usando sistemas de segurança pode ser determinada independentemente da extensão e da frequência com que o dano ocorre (Bell e Reinert 1992). Os tipos de falhas em sistemas computacionais analisados na seção “Acidentes com sistemas controlados por computador” (acima) podem ser relacionados aos chamados Níveis de Integridade de Segurança, ou seja, as facilidades técnicas para redução de riscos.

Figura 2. Procedimento qualitativo para determinação de risco

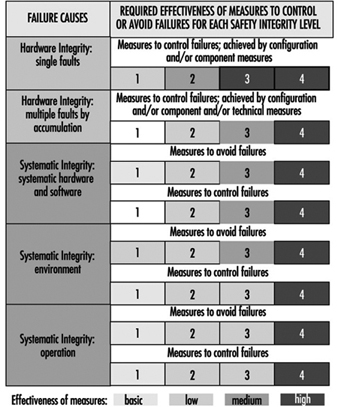

A Figura 3 deixa claro que a eficácia das medidas tomadas, em qualquer caso, para reduzir o erro em software e computadores precisa crescer com risco crescente (DIN 1994; IEC 1993).

Figura 3, Eficácia das precauções tomadas contra erros independentemente do risco

A análise dos acidentes esboçados acima mostra que a falha das proteções controladas por computador é causada não apenas por falhas aleatórias de componentes, mas também por condições operacionais particulares que o programador não levou em consideração. As consequências não imediatamente óbvias das modificações do programa feitas durante a manutenção do sistema constituem outra fonte de erro. Conclui-se que podem ocorrer falhas em sistemas de segurança controlados por microprocessadores que, embora feitas durante o desenvolvimento do sistema, podem levar a uma situação perigosa apenas durante a operação. Precauções contra tais falhas devem, portanto, ser tomadas enquanto os sistemas relacionados à segurança estão em fase de desenvolvimento. Essas chamadas medidas de prevenção de falhas devem ser tomadas não apenas durante a fase de conceito, mas também no processo de desenvolvimento, instalação e modificação. Certas falhas podem ser evitadas se forem descobertas e corrigidas durante este processo (DIN 1990).

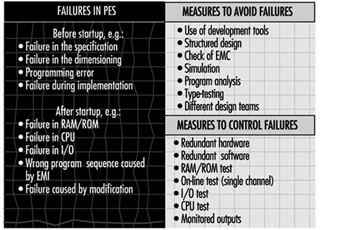

Como o último contratempo descrito deixa claro, a quebra de um único transistor pode levar à falha técnica de equipamentos automatizados de alta complexidade. Uma vez que cada circuito único é composto de muitos milhares de transistores e outros componentes, várias medidas de prevenção de falhas devem ser tomadas para reconhecer tais falhas como aparecem na operação e para iniciar uma reação apropriada no sistema de computador. A Figura 4 descreve tipos de falhas em sistemas eletrônicos programáveis, bem como exemplos de precauções que podem ser tomadas para evitar e controlar falhas em sistemas de computador (DIN 1990; IEC 1992).

Figura 4. Exemplos de precauções tomadas para controlar e evitar erros em sistemas de computador

Possibilidades e Perspectivas de Sistemas Eletrônicos Programáveis em Tecnologia de Segurança

Máquinas e instalações modernas estão se tornando cada vez mais complexas e devem realizar tarefas cada vez mais abrangentes em períodos de tempo cada vez mais curtos. Por esse motivo, os sistemas de computador dominaram quase todas as áreas da indústria desde meados da década de 1970. Esse aumento de complexidade por si só contribuiu significativamente para o aumento dos custos envolvidos na melhoria da tecnologia de segurança em tais sistemas. Embora o software e os computadores representem um grande desafio para a segurança no trabalho, eles também possibilitam a implementação de novos sistemas amigáveis ao erro no campo da tecnologia de segurança.

Um verso engraçado, mas instrutivo, de Ernst Jandl ajudará a explicar o que significa o conceito amigável ao erro. “Lichtung: Manche meinen lechts und rinks kann man nicht velwechsern, werch ein Illtum”. (“Dileção: Muitos acreditam que luz e reft não podem ser trocados por inteligência, que ellol”.) Apesar da troca de cartas r e l, esta frase é facilmente compreendida por um ser humano adulto normal. Mesmo alguém com pouca fluência no idioma inglês pode traduzi-lo para o inglês. A tarefa é, no entanto, quase impossível para um computador tradutor sozinho.

Este exemplo mostra que um ser humano pode reagir de uma maneira muito mais amigável ao erro do que um computador de linguagem. Isso significa que os humanos, como todas as outras criaturas vivas, podem tolerar falhas referindo-se a elas na experiência. Se olharmos para as máquinas em uso hoje, veremos que a maioria das máquinas penaliza as falhas do usuário não com um acidente, mas com uma diminuição da produção. Esta propriedade leva à manipulação ou evasão de salvaguardas. A moderna informática coloca à disposição da segurança do trabalho sistemas que podem reagir de forma inteligente, ou seja, de forma modificada. Tais sistemas tornam possível um modo de comportamento amigável ao erro em novas máquinas. Eles alertam os usuários durante uma operação errada antes de tudo e desligam a máquina somente quando esta é a única maneira de evitar um acidente. A análise dos acidentes mostra que existe nesta área um potencial considerável de redução de acidentes (Reinert e Reuss 1991).

" ISENÇÃO DE RESPONSABILIDADE: A OIT não se responsabiliza pelo conteúdo apresentado neste portal da Web em qualquer idioma que não seja o inglês, que é o idioma usado para a produção inicial e revisão por pares do conteúdo original. Algumas estatísticas não foram atualizadas desde a produção da 4ª edição da Enciclopédia (1998)."