Toxikologie in der Gesundheits- und Sicherheitsverordnung

Die Toxikologie spielt eine wichtige Rolle bei der Entwicklung von Vorschriften und anderen Arbeitsschutzmaßnahmen. Um Arbeitsunfälle und Berufskrankheiten zu vermeiden, basieren Entscheidungen zunehmend auf Informationen, die vor oder ohne die Art der menschlichen Exposition erhältlich sind, die definitive Informationen über das Risiko liefern würden, wie z. B. epidemiologische Studien. Darüber hinaus können toxikologische Studien, wie sie in diesem Kapitel beschrieben werden, genaue Informationen über Dosis und Wirkung unter den kontrollierten Bedingungen der Laborforschung liefern; Diese Informationen sind in der unkontrollierten Umgebung beruflicher Expositionen oft schwer zu erhalten. Diese Informationen müssen jedoch sorgfältig ausgewertet werden, um die Wahrscheinlichkeit schädlicher Wirkungen beim Menschen, die Art dieser schädlichen Wirkungen und die quantitative Beziehung zwischen Expositionen und Wirkungen abzuschätzen.

Seit den 1980er Jahren wurde in vielen Ländern der Entwicklung objektiver Methoden zur Nutzung toxikologischer Informationen bei der Entscheidungsfindung in Regulierungsfragen große Aufmerksamkeit geschenkt. Formale Methoden, häufig bezeichnet als Risikobewertung, wurden in diesen Ländern sowohl von Regierungs- als auch von Nichtregierungsorganisationen vorgeschlagen und verwendet. Die Risikobewertung wurde unterschiedlich definiert; Grundsätzlich handelt es sich um einen Bewertungsprozess, der Toxikologie, Epidemiologie und Expositionsinformationen umfasst, um die Wahrscheinlichkeit unerwünschter Wirkungen im Zusammenhang mit der Exposition gegenüber gefährlichen Stoffen oder Bedingungen zu identifizieren und abzuschätzen. Die Risikobewertung kann qualitativer Natur sein und die Art einer nachteiligen Wirkung und eine allgemeine Schätzung der Wahrscheinlichkeit angeben, oder sie kann quantitativ sein und Schätzungen der Anzahl betroffener Personen bei bestimmten Expositionsniveaus enthalten. In vielen Regulierungssystemen erfolgt die Risikobewertung in vier Stufen: Gefahrenerkennung, die Beschreibung der Art der toxischen Wirkung; Dosis-Wirkungs-Bewertung, eine halbquantitative oder quantitative Analyse der Beziehung zwischen Exposition (oder Dosis) und Schweregrad oder Wahrscheinlichkeit einer toxischen Wirkung; Expositionsbewertung, die Bewertung von Informationen über die Bandbreite der Expositionen, die für Bevölkerungsgruppen im Allgemeinen oder für Untergruppen innerhalb von Bevölkerungsgruppen wahrscheinlich auftreten; Risikocharakterisierung, die Zusammenstellung aller oben genannten Informationen zu einem Ausdruck der Größenordnung des Risikos, das unter bestimmten Expositionsbedingungen zu erwarten ist (siehe NRC 1983 für eine Erklärung dieser Grundsätze).

In diesem Abschnitt werden zur Veranschaulichung drei Ansätze zur Risikobewertung vorgestellt. Es ist unmöglich, ein umfassendes Kompendium von Risikobewertungsmethoden bereitzustellen, die weltweit verwendet werden, und diese Auswahl sollte nicht als verbindlich angesehen werden. Es sollte beachtet werden, dass es Tendenzen zur Harmonisierung von Risikobewertungsmethoden gibt, teilweise als Reaktion auf Bestimmungen in den jüngsten GATT-Abkommen. Derzeit laufen zwei Prozesse zur internationalen Harmonisierung von Risikobewertungsmethoden durch das Internationale Programm für Chemikaliensicherheit (IPCS) und die Organisation für wirtschaftliche Zusammenarbeit und Entwicklung (OECD). Diese Organisationen halten auch aktuelle Informationen über nationale Ansätze zur Risikobewertung bereit.

Aktivitätsbeziehungen strukturieren

Bei der Analyse von Struktur-Aktivitäts-Beziehungen (SAR) werden Informationen über die Molekularstruktur von Chemikalien genutzt, um wichtige Eigenschaften in Bezug auf Persistenz, Verteilung, Aufnahme und Absorption sowie Toxizität vorherzusagen. SAR ist eine alternative Methode zur Identifizierung potenziell gefährlicher Chemikalien, die verspricht, Industrien und Regierungen bei der Priorisierung von Stoffen für die weitere Bewertung oder für die frühzeitige Entscheidungsfindung für neue Chemikalien zu unterstützen. Die Toxikologie ist ein zunehmend teures und ressourcenintensives Unterfangen. Zunehmende Bedenken hinsichtlich des Potenzials von Chemikalien, nachteilige Auswirkungen auf exponierte menschliche Populationen zu verursachen, haben Regulierungs- und Gesundheitsbehörden dazu veranlasst, den Umfang und die Empfindlichkeit von Tests zum Nachweis toxikologischer Gefahren zu erweitern. Gleichzeitig haben die tatsächlichen und vermeintlichen Regulierungslasten für die Industrie Bedenken hinsichtlich der Praktikabilität von Toxizitätstestmethoden und Datenanalysen geweckt. Gegenwärtig hängt die Bestimmung der chemischen Karzinogenität von Lebenszeittests an mindestens zwei Arten beiderlei Geschlechts bei mehreren Dosen mit sorgfältiger histopathologischer Analyse mehrerer Organe sowie dem Nachweis präneoplastischer Veränderungen in Zellen und Zielorganen ab. In den Vereinigten Staaten wird der Krebs-Bioassay auf über 3 Millionen Dollar (1995 Dollar) geschätzt.

Selbst mit unbegrenzten finanziellen Mitteln würde der Testaufwand für die etwa 70,000 existierenden Chemikalien, die heute weltweit hergestellt werden, die verfügbaren Ressourcen ausgebildeter Toxikologen übersteigen. Es würden Jahrhunderte erforderlich sein, um selbst eine Erstbewertung dieser Chemikalien abzuschließen (NRC 1984). In vielen Ländern haben ethische Bedenken hinsichtlich der Verwendung von Tieren in Toxizitätstests zugenommen, was zusätzlichen Druck auf die Verwendung von Standardmethoden für Toxizitätstests ausübt. SAR wurde in der pharmazeutischen Industrie weit verbreitet verwendet, um Moleküle mit einem Potenzial für eine vorteilhafte Verwendung in der Behandlung zu identifizieren (Hansch und Zhang 1993). In der Umwelt- und Arbeitsschutzpolitik wird SAR verwendet, um die Ausbreitung von Verbindungen in der physikalisch-chemischen Umgebung vorherzusagen und neue Chemikalien für eine weitere Bewertung der potenziellen Toxizität zu screenen. Gemäß dem US-amerikanischen Toxic Substances Control Act (TSCA) verwendet die EPA seit 1979 einen SAR-Ansatz als „erstes Screening“ neuer Chemikalien im Premanufacture Notification (PMN)-Prozess; Australien verwendet einen ähnlichen Ansatz im Rahmen seines Verfahrens zur Meldung neuer Chemikalien (NICNAS). In den USA ist die SAR-Analyse eine wichtige Grundlage für die Feststellung, dass eine vernünftige Grundlage für die Schlussfolgerung besteht, dass die Herstellung, Verarbeitung, Verteilung, Verwendung oder Entsorgung des Stoffes ein unzumutbares Verletzungsrisiko für die menschliche Gesundheit oder die Umwelt darstellt, wie in Abschnitt gefordert 5(f) TSCA. Auf der Grundlage dieser Feststellung kann die EPA dann tatsächliche Tests des Stoffes gemäß Abschnitt 6 des TSCA verlangen.

Begründung für SAR

Die wissenschaftliche Begründung für SAR basiert auf der Annahme, dass die Molekularstruktur einer Chemikalie wichtige Aspekte ihres Verhaltens in physikalisch-chemischen und biologischen Systemen vorhersagt (Hansch und Leo 1979).

SAR-Prozess

Der SAR-Überprüfungsprozess umfasst die Identifizierung der chemischen Struktur, einschließlich empirischer Formulierungen, sowie der reinen Verbindung; Identifizierung strukturanaloger Substanzen; Durchsuchen von Datenbanken und Literatur nach Informationen über strukturelle Analoga; und Analyse von Toxizität und anderen Daten zu Strukturanaloga. In einigen seltenen Fällen können Informationen über die Struktur der Verbindung allein ausreichen, um eine SAR-Analyse zu unterstützen, die auf gut verstandenen Toxizitätsmechanismen basiert. Mehrere Datenbanken zu SAR wurden zusammengestellt, ebenso wie computergestützte Methoden zur Vorhersage der Molekülstruktur.

Mit diesen Informationen können die folgenden Endpunkte mit SAR geschätzt werden:

- Physikalisch-chemische Parameter: Siedepunkt, Dampfdruck, Wasserlöslichkeit, Oktanol/Wasser-Verteilungskoeffizient

- biologische/ökologische Verbleibsparameter: biologischer Abbau, Bodensorption, Photoabbau, Pharmakokinetik

- Toxizitätsparameter: Toxizität für Wasserorganismen, Resorption, akute Toxizität für Säugetiere (Limit-Test oder LD50), Haut-, Lungen- und Augenreizung, Sensibilisierung, subchronische Toxizität, Mutagenität.

Es ist zu beachten, dass für so wichtige Gesundheitsendpunkte wie Karzinogenität, Entwicklungstoxizität, Reproduktionstoxizität, Neurotoxizität, Immuntoxizität oder andere Zielorganwirkungen keine SAR-Methoden existieren. Dies ist auf drei Faktoren zurückzuführen: das Fehlen einer großen Datenbank zum Testen von SAR-Hypothesen, das Fehlen von Kenntnissen über strukturelle Determinanten der toxischen Wirkung und die Vielzahl von Zielzellen und Mechanismen, die an diesen Endpunkten beteiligt sind (siehe „Die Vereinigten Staaten Ansatz zur Risikobewertung von reproduktionstoxischen und neurotoxischen Stoffen“). Einige begrenzte Versuche, SAR zur Vorhersage der Pharmakokinetik unter Verwendung von Informationen über Verteilungskoeffizienten und Löslichkeit zu verwenden (Johanson und Naslund 1988). Umfangreichere quantitative SAR wurden durchgeführt, um den P450-abhängigen Metabolismus einer Reihe von Verbindungen und die Bindung von Dioxin- und PCB-ähnlichen Molekülen an den zytosolischen „Dioxin“-Rezeptor vorherzusagen (Hansch und Zhang 1993).

Es hat sich gezeigt, dass SAR für einige der oben aufgeführten Endpunkte eine unterschiedliche Vorhersagbarkeit aufweist, wie in Tabelle 1 gezeigt. Diese Tabelle enthält Daten aus zwei Vergleichen der vorhergesagten Aktivität mit tatsächlichen Ergebnissen, die durch empirische Messungen oder Toxizitätstests erhalten wurden. SAR, durchgeführt von Experten der US EPA, schnitt bei der Vorhersage physikalisch-chemischer Eigenschaften schlechter ab als bei der Vorhersage der biologischen Aktivität, einschließlich des biologischen Abbaus. Bei Toxizitätsendpunkten schnitt SAR am besten ab, um Mutagenität vorherzusagen. Ashby und Tennant (1991) stellten in einer umfassenderen Studie bei ihrer Analyse von NTP-Chemikalien ebenfalls eine gute Vorhersagbarkeit der kurzfristigen Genotoxizität fest. Diese Ergebnisse sind angesichts des derzeitigen Verständnisses der molekularen Mechanismen der Genotoxizität (siehe „Gentoxikologie“) und der Rolle der Elektrophilie bei der DNA-Bindung nicht überraschend. Im Gegensatz dazu neigte SAR dazu, die systemische und subchronische Toxizität bei Säugetieren zu unterschätzen und die akute Toxizität für Wasserorganismen zu überschätzen.

Tabelle 1. Vergleich von SAR- und Testdaten: OECD/NTP-Analysen

| Endpunkt | Zustimmung (%) | Ablehnung (%) | Nummer |

| Siedepunkt | 50 | 50 | 30 |

| Dampfdruck | 63 | 37 | 113 |

| Wasserlöslichkeit | 68 | 32 | 133 |

| Verteilungskoeffizient | 61 | 39 | 82 |

| Bioabbau | 93 | 7 | 107 |

| Fischtoxizität | 77 | 22 | 130 |

| Daphnientoxizität | 67 | 33 | 127 |

| Akute Säugetiertoxizität (LD50 ) | 80 | 201 | 142 |

| Hautreizung | 82 | 18 | 144 |

| Augen Irritation | 78 | 22 | 144 |

| Hautsensibilisierung | 84 | 16 | 144 |

| Subchronische Toxizität | 57 | 32 | 143 |

| Mutagenität2 | 88 | 12 | 139 |

| Mutagenität3 | 82-944 | 1-10 | 301 |

| Kanzerogenität3 : Zweijähriger Bioassay | 72-954 | - | 301 |

Quelle: Daten der OECD, persönliche Mitteilung C. Auer, US EPA. In dieser Analyse wurden nur diejenigen Endpunkte verwendet, für die vergleichbare SAR-Vorhersagen und tatsächliche Testdaten verfügbar waren. NTP-Daten stammen von Ashby und Tennant 1991.

1 Besorgniserregend war das Versäumnis von SAR, die akute Toxizität bei 12 % der getesteten Chemikalien vorherzusagen.

2 OECD-Daten, basierend auf Ames-Test-Konkordanz mit SAR

3 NTP-Daten, basierend auf Gentox-Assays im Vergleich zu SAR-Vorhersagen für mehrere Klassen von „strukturell alarmierenden Chemikalien“.

4 Die Übereinstimmung variiert mit der Klasse; höchste Übereinstimmung war mit aromatischen Amino/Nitro-Verbindungen; am niedrigsten bei „verschiedenen“ Strukturen.

Für andere toxische Endpunkte hat SAR, wie oben erwähnt, einen weniger nachweisbaren Nutzen. Vorhersagen zur Säugetiertoxizität werden durch das Fehlen von SAR für die Toxikokinetik komplexer Moleküle erschwert. Dennoch wurden einige Versuche unternommen, SAR-Prinzipien für komplexe Endpunkte der Toxizität bei Säugetieren vorzuschlagen (siehe beispielsweise Bernstein (1984) für eine SAR-Analyse potenzieller reproduktionstoxischer Stoffe für Männer). In den meisten Fällen ist die Datenbank zu klein, um strukturbasierte Vorhersagen gründlich zu testen.

An dieser Stelle kann der Schluss gezogen werden, dass SAR hauptsächlich nützlich sein kann, um die Investition in Toxizitätstestressourcen zu priorisieren oder um frühzeitig Bedenken hinsichtlich potenzieller Gefahren zu äußern. Nur im Fall von Mutagenität ist es wahrscheinlich, dass die SAR-Analyse selbst zuverlässig verwendet werden kann, um andere Entscheidungen zu informieren. Für keinen Endpunkt ist es wahrscheinlich, dass SAR die Art von quantitativen Informationen liefern kann, die für Risikobewertungszwecke erforderlich sind, wie an anderer Stelle in diesem Kapitel und erörtert Enzyklopädie.

In-vitro-Toxizitätstest

Das Aufkommen anspruchsvoller Technologien in der Molekular- und Zellbiologie hat eine relativ schnelle Entwicklung in den Biowissenschaften, einschließlich der Toxikologie, vorangetrieben. Tatsächlich verlagert sich der Fokus der Toxikologie von ganzen Tieren und Populationen ganzer Tiere auf die Zellen und Moleküle einzelner Tiere und Menschen. Seit Mitte der 1980er Jahre haben Toxikologen damit begonnen, diese neuen Methoden zur Bewertung der Auswirkungen von Chemikalien auf lebende Systeme einzusetzen. Als logische Weiterentwicklung werden solche Methoden für Zwecke der Toxizitätsprüfung angepasst. Diese wissenschaftlichen Fortschritte haben mit sozialen und wirtschaftlichen Faktoren zusammengearbeitet, um eine Änderung bei der Bewertung der Produktsicherheit und des potenziellen Risikos zu bewirken.

Wirtschaftliche Faktoren beziehen sich insbesondere auf die Menge der zu testenden Materialien. Jedes Jahr werden unzählige neue Kosmetika, Arzneimittel, Pestizide, Chemikalien und Haushaltsprodukte auf den Markt gebracht. Alle diese Produkte müssen auf ihre potenzielle Toxizität bewertet werden. Darüber hinaus gibt es einen Rückstand an Chemikalien, die bereits verwendet werden und nicht ausreichend getestet wurden. Die enorme Aufgabe, detaillierte Sicherheitsinformationen zu all diesen Chemikalien mit herkömmlichen Ganztierversuchsmethoden zu erhalten, wäre sowohl zeit- als auch kostenintensiv, wenn sie überhaupt bewältigt werden könnte.

Es gibt auch gesellschaftliche Probleme im Zusammenhang mit der öffentlichen Gesundheit und Sicherheit sowie die zunehmende Besorgnis der Öffentlichkeit über die Verwendung von Tieren für Produktsicherheitstests. Im Hinblick auf die menschliche Sicherheit haben Interessengruppen des öffentlichen Interesses und des Umweltschutzes erheblichen Druck auf Regierungsbehörden ausgeübt, strengere Vorschriften für Chemikalien anzuwenden. Ein aktuelles Beispiel dafür war eine Bewegung einiger Umweltgruppen, Chlor und chlorhaltige Verbindungen in den Vereinigten Staaten zu verbieten. Einer der Beweggründe für solch ein extremes Vorgehen liegt in der Tatsache, dass die meisten dieser Verbindungen nie ausreichend getestet wurden. Aus toxikologischer Sicht ist das Konzept, eine ganze Klasse verschiedener Chemikalien nur aufgrund des Vorhandenseins von Chlor zu verbieten, sowohl wissenschaftlich als auch unverantwortlich. Es ist jedoch verständlich, dass aus Sicht der Öffentlichkeit eine gewisse Sicherheit bestehen muss, dass in die Umwelt freigesetzte Chemikalien kein erhebliches Gesundheitsrisiko darstellen. Eine solche Situation unterstreicht die Notwendigkeit effizienterer und schnellerer Methoden zur Bewertung der Toxizität.

Das andere gesellschaftliche Anliegen, das sich auf den Bereich der Toxizitätstests ausgewirkt hat, ist der Tierschutz. Die wachsende Zahl von Tierschutzgruppen auf der ganzen Welt hat erheblichen Widerstand gegen die Verwendung ganzer Tiere für Produktsicherheitstests geäußert. Es wurden aktive Kampagnen gegen Hersteller von Kosmetika, Haushalts- und Körperpflegeprodukten und Arzneimitteln geführt, um Tierversuche zu stoppen. Diese Bemühungen in Europa haben zur Verabschiedung der Sechsten Änderung der Richtlinie 76/768/EWG (Kosmetikrichtlinie) geführt. Die Folge dieser Richtlinie ist, dass kosmetische Mittel oder kosmetische Inhaltsstoffe, die nach dem 1. Januar 1998 an Tieren getestet wurden, nicht in der Europäischen Union vermarktet werden dürfen, es sei denn, alternative Methoden sind unzureichend validiert. Obwohl diese Richtlinie keine Zuständigkeit für den Verkauf solcher Produkte in den Vereinigten Staaten oder anderen Ländern hat, wird sie Unternehmen mit internationalen Märkten, einschließlich Europa, erheblich beeinträchtigen.

Das Konzept der Alternativen, das die Grundlage für die Entwicklung von anderen Tests als denen an ganzen Tieren bildet, wird von den dreien definiert Rs: Reduktion in der Anzahl der verwendeten Tiere; Raffinesse von Protokollen, damit die Tiere weniger Stress oder Unbehagen erfahren; und Ersatz von aktuellen Tierversuchen mit In-vitro-Tests (dh Tests, die außerhalb des lebenden Tieres durchgeführt werden), Computermodellen oder Tests an niederen Wirbeltieren oder wirbellosen Arten. Die Drei Rs wurden in einem Buch vorgestellt, das 1959 von zwei britischen Wissenschaftlern, WMS Russell und Rex Burch, veröffentlicht wurde. Die Prinzipien der humanen experimentellen Technik. Russell und Burch behaupteten, dass der einzige Weg, auf dem gültige wissenschaftliche Ergebnisse erzielt werden könnten, die humane Behandlung von Tieren sei, und waren der Ansicht, dass Methoden entwickelt werden sollten, um die Verwendung von Tieren zu reduzieren und sie letztendlich zu ersetzen. Interessanterweise fanden die von Russell und Burch umrissenen Prinzipien bis zum Wiederaufleben der Tierschutzbewegung Mitte der 1970er Jahre wenig Beachtung. Heute das Konzept der Drei Rs ist in Bezug auf Forschung, Erprobung und Ausbildung ganz vorne mit dabei.

Zusammenfassend lässt sich sagen, dass die Entwicklung von In-vitro-Testmethoden von einer Vielzahl von Faktoren beeinflusst wurde, die in den letzten zehn bis 20 Jahren zusammengekommen sind. Es ist schwer festzustellen, ob einer dieser Faktoren allein eine so tiefgreifende Wirkung auf die Toxizitätsteststrategien gehabt hätte.

Konzept der In-vitro-Toxizitätstests

Dieser Abschnitt konzentriert sich ausschließlich auf In-vitro-Methoden zur Bewertung der Toxizität als eine der Alternativen zu Ganztierversuchen. Weitere nicht-tierische Alternativen wie Computermodellierung und quantitative Struktur-Wirkungs-Beziehungen werden in anderen Artikeln dieses Kapitels diskutiert.

In-vitro-Studien werden im Allgemeinen in tierischen oder menschlichen Zellen oder Geweben außerhalb des Körpers durchgeführt. In vitro bedeutet wörtlich „in Glas“ und bezieht sich auf Verfahren, die an lebendem Material oder Bestandteilen von lebendem Material durchgeführt werden, das in Petrischalen oder in Reagenzgläsern unter definierten Bedingungen kultiviert wird. Diese können In-vivo-Studien oder Studien, die „am lebenden Tier“ durchgeführt werden, gegenübergestellt werden. Während es schwierig, wenn nicht sogar unmöglich ist, die Auswirkungen einer Chemikalie auf einen komplexen Organismus zu prognostizieren, wenn die Beobachtungen auf einen einzigen Zelltyp in einer Schale beschränkt sind, liefern In-vitro-Studien auch eine beträchtliche Menge an Informationen über die intrinsische Toxizität als zelluläre und molekulare Toxizitätsmechanismen. Darüber hinaus bieten sie viele Vorteile gegenüber In-vivo-Studien, da sie im Allgemeinen kostengünstiger sind und unter besser kontrollierten Bedingungen durchgeführt werden können. Darüber hinaus können diese Methoden trotz der Tatsache, dass immer noch eine kleine Anzahl von Tieren benötigt wird, um Zellen für In-vitro-Kulturen zu erhalten, als Reduktionsalternativen (da im Vergleich zu In-vivo-Studien viel weniger Tiere verwendet werden) und Verfeinerungsalternativen (weil sie die Notwendigkeit beseitigen) betrachtet werden Tiere den nachteiligen toxischen Folgen von In-vivo-Experimenten auszusetzen).

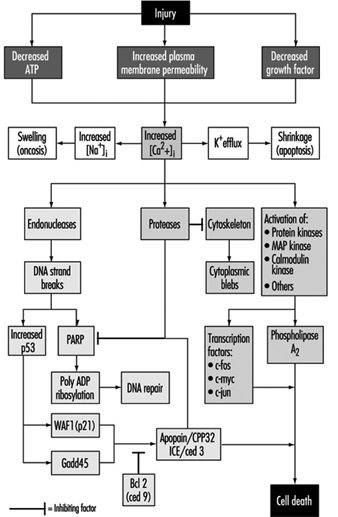

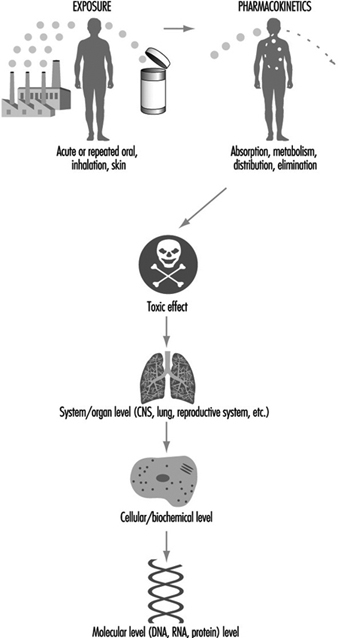

Um die Ergebnisse von In-vitro-Toxizitätstests zu interpretieren, ihre potenzielle Nützlichkeit bei der Bewertung der Toxizität zu bestimmen und sie mit dem gesamten toxikologischen Prozess in vivo in Beziehung zu setzen, ist es notwendig zu verstehen, welcher Teil des toxikologischen Prozesses untersucht wird. Der gesamte toxikologische Prozess besteht aus Ereignissen, die damit beginnen, dass der Organismus einem physikalischen oder chemischen Mittel ausgesetzt wird, sich durch zelluläre und molekulare Wechselwirkungen weiterentwickeln und sich schließlich in der Reaktion des gesamten Organismus manifestieren. In-vitro-Tests beschränken sich im Allgemeinen auf den Teil des toxikologischen Prozesses, der auf zellulärer und molekularer Ebene stattfindet. Zu den Arten von Informationen, die aus In-vitro-Studien gewonnen werden können, gehören Stoffwechselwege, Wechselwirkung aktiver Metaboliten mit zellulären und molekularen Zielen und potenziell messbare toxische Endpunkte, die als molekulare Biomarker für die Exposition dienen können. Im Idealfall wäre der Toxizitätsmechanismus jeder Chemikalie aufgrund der Exposition gegenüber Organismen bekannt, sodass die aus In-vitro-Tests erhaltenen Informationen vollständig interpretiert und mit der Reaktion des gesamten Organismus in Beziehung gesetzt werden könnten. Dies ist jedoch praktisch unmöglich, da relativ wenige vollständige toxikologische Mechanismen aufgeklärt wurden. Daher sind Toxikologen mit einer Situation konfrontiert, in der die Ergebnisse eines In-vitro-Tests nicht als völlig genaue Vorhersage der In-vivo-Toxizität verwendet werden können, da der Mechanismus unbekannt ist. Jedoch werden während des Entwicklungsprozesses eines In-vitro-Tests häufig Komponenten der zellulären und molekularen Toxizitätsmechanismen aufgeklärt.

Eine der zentralen ungelösten Fragen bei der Entwicklung und Durchführung von In-vitro-Tests hängt mit der folgenden Überlegung zusammen: Sollen sie mechanistisch fundiert sein oder reicht es, wenn sie deskriptiv sind? Aus wissenschaftlicher Sicht ist es unbestreitbar besser, nur mechanistisch basierte Tests als Ersatz für In-vivo-Tests einzusetzen. In Ermangelung vollständiger mechanistischer Kenntnisse ist die Aussicht, In-vitro-Tests zu entwickeln, die Ganztierversuche in naher Zukunft vollständig ersetzen, jedoch nahezu gleich Null. Dies schließt jedoch die Verwendung von aussagekräftigeren Arten von Assays als frühe Screening-Instrumente nicht aus, was derzeit der Fall ist. Diese Screens haben zu einer deutlichen Reduzierung des Einsatzes von Tieren geführt. Bis zu dem Zeitpunkt, an dem mehr mechanistische Informationen generiert werden, kann es daher erforderlich sein, in begrenztem Umfang Tests anzuwenden, deren Ergebnisse einfach gut mit den in vivo erhaltenen korrelieren.

In-vitro-Tests auf Zytotoxizität

In diesem Abschnitt werden mehrere In-vitro-Tests beschrieben, die zur Bewertung des zytotoxischen Potenzials einer Chemikalie entwickelt wurden. Diese Tests sind größtenteils einfach durchzuführen und die Analyse kann automatisiert werden. Ein häufig verwendeter In-vitro-Test für Zytotoxizität ist der Neutralrot-Assay. Dieser Assay wird an Zellen in Kultur durchgeführt, und für die meisten Anwendungen können die Zellen in Kulturschalen gehalten werden, die 96 kleine Vertiefungen mit jeweils 6.4 mm Durchmesser enthalten. Da jede Vertiefung für eine einzelne Bestimmung verwendet werden kann, kann diese Anordnung mehrere Konzentrationen der Prüfchemikalie sowie Positiv- und Negativkontrollen mit jeweils einer ausreichenden Anzahl von Wiederholungen aufnehmen. Nach der Behandlung der Zellen mit verschiedenen Konzentrationen der Prüfchemikalie im Bereich von mindestens zwei Größenordnungen (z. B. von 0.01 mM bis 1 mM) sowie Positiv- und Negativkontrollchemikalien werden die Zellen gespült und mit Neutralrot behandelt, a Farbstoff, der nur von lebenden Zellen aufgenommen und zurückgehalten werden kann. Der Farbstoff kann nach dem Entfernen der Prüfchemikalie hinzugefügt werden, um unmittelbare Wirkungen zu bestimmen, oder er kann zu verschiedenen Zeitpunkten nach dem Entfernen der Prüfchemikalie hinzugefügt werden, um kumulative oder verzögerte Wirkungen zu bestimmen. Die Intensität der Farbe in jeder Vertiefung entspricht der Anzahl lebender Zellen in dieser Vertiefung. Die Farbintensität wird mit einem Spektrophotometer gemessen, das mit einem Plattenlesegerät ausgestattet sein kann. Der Plattenleser ist so programmiert, dass er einzelne Messungen für jede der 96 Vertiefungen der Kulturschale liefert. Diese automatisierte Methodik ermöglicht es dem Forscher, schnell ein Konzentrations-Wirkungs-Experiment durchzuführen und statistisch nützliche Daten zu erhalten.

Ein weiterer relativ einfacher Assay für Zytotoxizität ist der MTT-Test. MTT (3[4,5-Dimethylthiazol-2-yl]-2,5-Diphenyltetrazoliumbromid) ist ein Tetrazolium-Farbstoff, der durch mitochondriale Enzyme zu einer blauen Farbe reduziert wird. Nur Zellen mit lebensfähigen Mitochondrien behalten die Fähigkeit, diese Reaktion durchzuführen; daher steht die Farbintensität in direktem Zusammenhang mit dem Grad der mitochondrialen Integrität. Dies ist ein nützlicher Test zum Nachweis allgemeiner zytotoxischer Verbindungen sowie von Mitteln, die spezifisch auf Mitochondrien abzielen.

Die Messung der Laktatdehydrogenase (LDH)-Aktivität wird auch als breit angelegter Assay für Zytotoxizität verwendet. Dieses Enzym ist normalerweise im Zytoplasma lebender Zellen vorhanden und wird durch undichte Zellmembranen von toten oder sterbenden Zellen, die durch ein toxisches Mittel beeinträchtigt wurden, in das Zellkulturmedium freigesetzt. Kleine Mengen des Kulturmediums können zu verschiedenen Zeitpunkten nach der chemischen Behandlung der Zellen entfernt werden, um die Menge an freigesetztem LDH zu messen und den Zeitverlauf der Toxizität zu bestimmen. Während der LDH-Freisetzungstest eine sehr allgemeine Bewertung der Zytotoxizität ist, ist er nützlich, da er einfach durchzuführen ist und in Echtzeit durchgeführt werden kann.

Es werden viele neue Methoden entwickelt, um Zellschäden zu erkennen. Anspruchsvollere Methoden verwenden fluoreszierende Sonden, um eine Vielzahl von intrazellulären Parametern zu messen, wie z. B. die Calciumfreisetzung und Änderungen des pH-Werts und des Membranpotentials. Im Allgemeinen sind diese Sonden sehr empfindlich und können subtilere zelluläre Veränderungen erkennen, wodurch die Notwendigkeit, den Zelltod als Endpunkt zu verwenden, reduziert wird. Zusätzlich können viele dieser Fluoreszenz-Assays durch die Verwendung von 96-Well-Platten und Fluoreszenzplatten-Lesegeräten automatisiert werden.

Sobald Daten zu einer Reihe von Chemikalien mit einem dieser Tests gesammelt wurden, können die relativen Toxizitäten bestimmt werden. Die relative Toxizität einer Chemikalie, bestimmt in einem In-vitro-Test, kann als die Konzentration ausgedrückt werden, die eine 50 %-ige Wirkung auf die Endpunktreaktion unbehandelter Zellen ausübt. Diese Bestimmung wird als EC bezeichnet50 (Effektiv CKonzentration für 50% der Zellen) und kann verwendet werden, um die Toxizität verschiedener Chemikalien in vitro zu vergleichen. (Ein ähnlicher Begriff, der zur Bewertung der relativen Toxizität verwendet wird, ist IC50, die die Konzentration einer Chemikalie angibt, die eine 50%ige Hemmung eines zellulären Prozesses bewirkt, z. B. die Fähigkeit zur Aufnahme von Neutralrot.) Es ist nicht einfach zu beurteilen, ob die relative In-vitro-Toxizität der Chemikalien mit ihrer relativen Toxizität vergleichbar ist vivo-Toxizitäten, da es im in vivo-System so viele Störfaktoren wie Toxikokinetik, Metabolismus, Reparatur- und Abwehrmechanismen gibt. Da die meisten dieser Assays außerdem allgemeine Zytotoxizitätsendpunkte messen, sind sie nicht mechanistisch begründet. Daher ist die Übereinstimmung zwischen relativen In-vitro- und In-vivo-Toxizitäten einfach korrelativ. Trotz der zahlreichen Komplexitäten und Schwierigkeiten bei der Extrapolation von In-vitro- auf In-vivo-Tests erweisen sich diese In-vitro-Tests als sehr wertvoll, da sie einfach und kostengünstig durchzuführen sind und als Screens verwendet werden können, um hochgiftige Medikamente oder Chemikalien in frühen Stadien der Krankheit zu identifizieren Entwicklung.

Zielorgantoxizität

In-vitro-Tests können auch zur Beurteilung der spezifischen Zielorgantoxizität verwendet werden. Es gibt eine Reihe von Schwierigkeiten, die mit der Gestaltung solcher Tests verbunden sind, wobei die bemerkenswerteste die Unfähigkeit von In-vitro-Systemen ist, viele der Merkmale des Organs in vivo aufrechtzuerhalten. Wenn Zellen Tieren entnommen und in Kultur gebracht werden, neigen sie häufig entweder dazu, schnell zu degenerieren und/oder zu dedifferenzieren, dh sie verlieren ihre organähnlichen Funktionen und werden generischer. Dies stellt insofern ein Problem dar, als die Kulturen innerhalb eines kurzen Zeitraums, in der Regel wenige Tage, nicht mehr zur Beurteilung organspezifischer Wirkungen eines Toxins geeignet sind.

Viele dieser Probleme werden aufgrund der jüngsten Fortschritte in der Molekular- und Zellbiologie überwunden. Informationen, die über die zelluläre Umgebung in vivo erhalten werden, können zum Modulieren von Kulturbedingungen in vitro verwendet werden. Seit Mitte der 1980er Jahre wurden neue Wachstumsfaktoren und Zytokine entdeckt, und viele davon sind jetzt im Handel erhältlich. Die Zugabe dieser Faktoren zu Zellen in Kultur hilft, ihre Integrität zu bewahren und kann auch dazu beitragen, differenziertere Funktionen für längere Zeiträume beizubehalten. Andere Grundlagenstudien haben das Wissen über die Ernährungs- und Hormonanforderungen von Zellen in Kultur erweitert, so dass neue Medien formuliert werden können. Kürzlich wurden auch Fortschritte bei der Identifizierung sowohl natürlich vorkommender als auch künstlicher extrazellulärer Matrizen gemacht, auf denen Zellen kultiviert werden können. Die Kultivierung von Zellen auf diesen verschiedenen Matrizen kann tiefgreifende Auswirkungen sowohl auf ihre Struktur als auch auf ihre Funktion haben. Ein großer Vorteil, der sich aus diesem Wissen ergibt, ist die Fähigkeit, die Umgebung von Zellen in Kultur genau zu kontrollieren und die Auswirkungen dieser Faktoren auf grundlegende Zellprozesse und ihre Reaktionen auf verschiedene chemische Mittel einzeln zu untersuchen. Kurz gesagt, diese Systeme können einen großartigen Einblick in organspezifische Toxizitätsmechanismen liefern.

Viele Zielorgan-Toxizitätsstudien werden in Primärzellen durchgeführt, die definitionsgemäß frisch aus einem Organ isoliert werden und in der Regel eine begrenzte Lebensdauer in Kultur aufweisen. Es gibt viele Vorteile, Primärkulturen eines einzelnen Zelltyps aus einem Organ für die Toxizitätsbewertung zu haben. Aus mechanistischer Sicht sind solche Kulturen nützlich, um spezifische zelluläre Ziele einer Chemikalie zu untersuchen. In einigen Fällen können zwei oder mehr Zelltypen aus einem Organ zusammen kultiviert werden, und dies stellt einen zusätzlichen Vorteil bereit, indem man Zell-Zell-Wechselwirkungen als Reaktion auf ein Toxin betrachten kann. Einige Kokultursysteme für die Haut wurden so konstruiert, dass sie in vivo eine dreidimensionale Struktur bilden, die der Haut ähnelt. Es ist auch möglich, Zellen aus verschiedenen Organen – zum Beispiel Leber und Niere – zu kultivieren. Diese Art von Kultur wäre nützlich, um die für Nierenzellen spezifischen Wirkungen einer Chemikalie zu beurteilen, die in der Leber bioaktiviert werden muss.

Molekularbiologische Werkzeuge haben auch eine wichtige Rolle bei der Entwicklung kontinuierlicher Zelllinien gespielt, die für Zielorgan-Toxizitätstests nützlich sein können. Diese Zelllinien werden durch Transfektion von DNA in Primärzellen erzeugt. Beim Transfektionsverfahren werden die Zellen und die DNA so behandelt, dass die DNA von den Zellen aufgenommen werden kann. Die DNA stammt normalerweise von einem Virus und enthält ein Gen oder Gene, die es den Zellen ermöglichen, wenn sie exprimiert werden, unsterblich zu werden (dh in der Lage zu sein, über längere Zeiträume in Kultur zu leben und zu wachsen). Die DNA kann auch so verändert werden, dass das immortalisierende Gen von einem induzierbaren Promotor kontrolliert wird. Der Vorteil dieser Art von Konstrukt besteht darin, dass sich die Zellen nur dann teilen, wenn sie den geeigneten chemischen Stimulus erhalten, um die Expression des immortalisierenden Gens zu ermöglichen. Ein Beispiel für ein solches Konstrukt ist das große T-Antigen-Gen aus Simian Virus 40 (SV40) (das immortalisierende Gen), dem die Promotorregion des Metallothionein-Gens vorangeht, das durch die Anwesenheit eines Metalls im Kulturmedium induziert wird. Daher können die Zellen, nachdem das Gen in die Zellen transfiziert wurde, mit niedrigen Zinkkonzentrationen behandelt werden, um den MT-Promotor zu stimulieren und die Expression des T-Antigen-Gens einzuschalten. Unter diesen Bedingungen proliferieren die Zellen. Wenn Zink aus dem Medium entfernt wird, hören die Zellen auf, sich zu teilen und kehren unter idealen Bedingungen in einen Zustand zurück, in dem sie ihre gewebespezifischen Funktionen ausüben.

Die Fähigkeit, unsterblich gemachte Zellen zu erzeugen, hat zusammen mit den Fortschritten in der Zellkulturtechnologie wesentlich zur Schaffung von Zelllinien aus vielen verschiedenen Organen, einschließlich Gehirn, Niere und Leber, beigetragen. Bevor diese Zelllinien jedoch als Ersatz für die echten Zelltypen verwendet werden können, müssen sie sorgfältig charakterisiert werden, um festzustellen, wie „normal“ sie wirklich sind.

Andere In-vitro-Systeme zur Untersuchung der Zielorgantoxizität sind mit zunehmender Komplexität verbunden. Mit fortschreitender Komplexität von In-vitro-Systemen von der Einzelzell- zur Ganzorgankultur werden sie vergleichbarer mit dem In-vivo-Milieu, aber gleichzeitig werden sie angesichts der erhöhten Anzahl von Variablen viel schwieriger zu kontrollieren. Was durch den Übergang zu einer höheren Organisationsebene gewonnen werden kann, kann daher durch die Unfähigkeit des Forschers verloren gehen, die experimentelle Umgebung zu kontrollieren. Tabelle 1 vergleicht einige der Eigenschaften verschiedener In-vitro-Systeme, die zur Untersuchung der Hepatotoxizität verwendet wurden.

Tabelle 1. Vergleich von In-vitro-Systemen für Hepatotoxizitätsstudien

| System | Komplexität (Ebene der Interaktion) |

Fähigkeit, leberspezifische Funktionen beizubehalten | Mögliche Dauer der Kultur | Fähigkeit, die Umgebung zu kontrollieren |

| Immortalisierte Zelllinien | einige Zelle zu Zelle (variiert je nach Zelllinie) | schlecht bis gut (variiert je nach Zelllinie) | unbestimmt | Ausgezeichnet |

| Primäre Hepatozytenkulturen | Zelle zu Zelle | mäßig bis ausgezeichnet (variiert je nach Kulturbedingungen) | Tage bis Wochen | Ausgezeichnet |

| Co-Kulturen von Leberzellen | Zelle zu Zelle (zwischen gleichen und unterschiedlichen Zelltypen) | gut bis großartig | Wochen | Ausgezeichnet |

| Leberscheiben | Zelle zu Zelle (unter allen Zelltypen) | gut bis großartig | Stunden bis Tage | gut |

| Isolierte, perfundierte Leber | Zelle zu Zelle (unter allen Zelltypen) und innerhalb eines Organs | Ausgezeichnet | Stunden | Messe |

Präzise geschnittene Gewebeschnitte werden zunehmend für toxikologische Studien verwendet. Es gibt neue Instrumente, die es dem Forscher ermöglichen, gleichmäßige Gewebescheiben in einer sterilen Umgebung zu schneiden. Gewebeschnitte bieten gegenüber Zellkultursystemen einen gewissen Vorteil, da alle Zelltypen des Organs vorhanden sind und sie ihre in vivo-Architektur und interzelluläre Kommunikation beibehalten. Somit können In-vitro-Studien durchgeführt werden, um den Zielzelltyp innerhalb eines Organs zu bestimmen sowie um die spezifische Zielorgantoxizität zu untersuchen. Ein Nachteil der Schnitte besteht darin, dass sie nach den ersten 24 Stunden der Kultivierung schnell degenerieren, hauptsächlich aufgrund der schlechten Diffusion von Sauerstoff zu den Zellen im Inneren der Schnitte. Jüngste Studien haben jedoch gezeigt, dass eine effizientere Belüftung durch sanfte Rotation erreicht werden kann. Dies ermöglicht zusammen mit der Verwendung eines komplexeren Mediums, dass die Scheiben bis zu 96 Stunden überleben.

Gewebeexplantate haben ein ähnliches Konzept wie Gewebeschnitte und können auch verwendet werden, um die Toxizität von Chemikalien in bestimmten Zielorganen zu bestimmen. Gewebeexplantate werden hergestellt, indem ein kleines Gewebestück (für Teratogenitätsstudien ein intakter Embryo) entnommen und für weitere Untersuchungen in Kultur gebracht wird. Explantatkulturen waren für kurzfristige Toxizitätsstudien nützlich, einschließlich Reizung und Ätzwirkung in der Haut, Asbeststudien in der Luftröhre und Neurotoxizitätsstudien in Hirngewebe.

Zur Beurteilung der Zielorgantoxizität können auch isoliert perfundierte Organe herangezogen werden. Diese Systeme bieten einen ähnlichen Vorteil wie Gewebeschnitte und Explantate, da alle Zelltypen vorhanden sind, jedoch ohne die Belastung des Gewebes durch die Manipulationen, die mit der Herstellung von Schnitten verbunden sind. Darüber hinaus ermöglichen sie die Aufrechterhaltung von Wechselwirkungen zwischen Organen. Ein Hauptnachteil ist ihre kurzfristige Lebensfähigkeit, die ihre Verwendung für In-vitro-Toxizitätstests einschränkt. Als Alternative können diese Kulturen als Verfeinerung angesehen werden, da die Tiere nicht die nachteiligen Folgen einer In-vivo-Behandlung mit Giftstoffen erfahren. Ihre Verwendung verringert jedoch die Anzahl der erforderlichen Tiere nicht wesentlich.

Zusammenfassend stehen mehrere Arten von In-vitro-Systemen zur Bewertung der Zielorgantoxizität zur Verfügung. Mit einer oder mehreren dieser Techniken können viele Informationen über Toxizitätsmechanismen gewonnen werden. Die Schwierigkeit besteht darin, zu wissen, wie man von einem In-vitro-System, das einen relativ kleinen Teil des toxikologischen Prozesses darstellt, auf den gesamten in vivo ablaufenden Prozess extrapoliert.

In-vitro-Tests auf Augenreizung

Der vielleicht umstrittenste Ganztier-Toxizitätstest aus Sicht des Tierschutzes ist der Draize-Test auf Augenreizung, der an Kaninchen durchgeführt wird. Bei diesem Test wird eine kleine feste Dosis einer Chemikalie in eines der Augen des Kaninchens gegeben, während das andere Auge als Kontrolle dient. Der Grad der Reizung und Entzündung wird zu verschiedenen Zeitpunkten nach der Exposition bewertet. Es werden große Anstrengungen unternommen, um Methoden zu entwickeln, um diesen Test zu ersetzen, der nicht nur aus humanen Gründen, sondern auch wegen der Subjektivität der Beobachtungen und der Variabilität der Ergebnisse kritisiert wurde. Es ist interessant festzustellen, dass sich der Draize-Test trotz der heftigen Kritik als bemerkenswert erfolgreich bei der Vorhersage von Reizstoffen für das menschliche Auge erwiesen hat, insbesondere von leicht bis mäßig reizenden Substanzen, die mit anderen Methoden schwer zu identifizieren sind. Die Anforderungen an In-vitro-Alternativen sind daher groß.

Die Suche nach Alternativen zum Draize-Test ist kompliziert, auch wenn ihr Erfolg prognostiziert wird. Zahlreiche In-vitro- und andere Alternativen wurden entwickelt und teilweise umgesetzt. Verfeinerungsalternativen zum Draize-Test, die per Definition weniger schmerzhaft oder quälend für die Tiere sind, umfassen den Low-Volume-Augentest, bei dem kleinere Mengen an Testmaterial in die Augen der Kaninchen eingebracht werden, nicht nur aus humanen Gründen, sondern um besser die Mengen nachahmen, denen Menschen tatsächlich versehentlich ausgesetzt sind. Eine weitere Verbesserung besteht darin, dass Substanzen mit einem pH-Wert von weniger als 2 oder mehr als 11.5 nicht mehr an Tieren getestet werden, da sie als stark augenreizend bekannt sind.

Zwischen 1980 und 1989 ist die Zahl der Kaninchen, die für Augenreizungstests von Kosmetika verwendet werden, um schätzungsweise 87 % zurückgegangen. In-vitro-Tests wurden als Teil eines Tier-Testing-Ansatzes integriert, um diese enorme Reduzierung von Ganztiertests zu erreichen. Dieser Ansatz ist ein mehrstufiger Prozess, der mit einer gründlichen Untersuchung der historischen Augenreizungsdaten und einer physikalischen und chemischen Analyse der zu bewertenden Chemikalie beginnt. Wenn diese beiden Prozesse nicht genügend Informationen liefern, wird eine Reihe von In-vitro-Tests durchgeführt. Die zusätzlichen Daten aus den In-vitro-Tests könnten dann ausreichen, um die Sicherheit des Stoffes zu beurteilen. Wenn nicht, wäre der letzte Schritt, begrenzte In-vivo-Tests durchzuführen. Es ist leicht einzusehen, wie dieser Ansatz die Zahl der Tiere, die zur Vorhersage der Sicherheit einer Testsubstanz erforderlich sind, eliminieren oder zumindest drastisch reduzieren kann.

Die Reihe von In-vitro-Tests, die im Rahmen dieser Tier-Testing-Strategie verwendet werden, hängt von den Anforderungen der jeweiligen Branche ab. Augenreizungstests werden von einer Vielzahl von Branchen durchgeführt, von der Kosmetik über die Pharmazie bis hin zu Industriechemikalien. Die Art der von den einzelnen Branchen geforderten Informationen ist unterschiedlich, und daher ist es nicht möglich, eine einzelne Reihe von In-vitro-Tests zu definieren. Eine Testbatterie ist im Allgemeinen so konzipiert, dass sie fünf Parameter bewertet: Zytotoxizität, Veränderungen in der Gewebephysiologie und -biochemie, quantitative Struktur-Wirkungs-Beziehungen, Entzündungsmediatoren sowie Erholung und Reparatur. Ein Beispiel für einen Test auf Zytotoxizität, die eine mögliche Ursache für Irritationen ist, ist der Neutralrottest unter Verwendung von kultivierten Zellen (siehe oben). Veränderungen in der Zellphysiologie und Biochemie, die sich aus der Exposition gegenüber einer Chemikalie ergeben, können in Kulturen menschlicher Hornhautepithelzellen untersucht werden. Alternativ haben Forscher auch intakte oder sezierte Rinder- oder Hühneraugäpfel aus Schlachthöfen verwendet. Viele der in diesen Ganzorgankulturen gemessenen Endpunkte sind die gleichen wie die in vivo gemessenen, wie z. B. Hornhauttrübung und Hornhautschwellung.

Entzündungen sind häufig eine Komponente von chemikalieninduzierten Augenverletzungen, und es gibt eine Reihe von Assays, um diesen Parameter zu untersuchen. Verschiedene biochemische Assays weisen das Vorhandensein von Mediatoren nach, die während des Entzündungsprozesses freigesetzt werden, wie Arachidonsäure und Zytokine. Auch die Chorioallantoismembran (CAM) des Hühnereis kann als Indikator für eine Entzündung herangezogen werden. Beim CAM-Assay wird ein kleines Stück der Schale eines 14- bis XNUMX-tägigen Hühnerembryos entfernt, um die CAM freizulegen. Die Chemikalie wird dann auf die CAM aufgetragen und Entzündungszeichen, wie etwa Gefäßblutungen, werden danach zu verschiedenen Zeitpunkten bewertet.

Einer der am schwierigsten in vitro zu beurteilenden in vivo-Prozesse ist die Genesung und Reparatur einer Augenverletzung. Ein neu entwickeltes Instrument, das Silizium-Mikrophysiometer, misst kleine Änderungen des extrazellulären pH-Werts und kann zur Überwachung von kultivierten Zellen in Echtzeit verwendet werden. Es hat sich gezeigt, dass diese Analyse ziemlich gut mit der In-vivo-Erholung korreliert und als In-vitro-Test für dieses Verfahren verwendet wurde. Dies war ein kurzer Überblick über die Arten von Tests, die als Alternativen zum Draize-Test für Augenreizungen eingesetzt werden. Es ist wahrscheinlich, dass innerhalb der nächsten Jahre eine vollständige Reihe von In-vitro-Testbatterien definiert und jede für ihren spezifischen Zweck validiert wird.

Validierung

Der Schlüssel zur behördlichen Akzeptanz und Implementierung von In-vitro-Testmethoden ist die Validierung, der Prozess, durch den die Glaubwürdigkeit eines Kandidatentests für einen bestimmten Zweck festgestellt wird. Sowohl in den Vereinigten Staaten als auch in Europa wurden Anstrengungen unternommen, um den Validierungsprozess zu definieren und zu koordinieren. Die Europäische Union gründete 1993 das Europäische Zentrum für die Validierung alternativer Methoden (ECVAM), um die dortigen Bemühungen zu koordinieren und mit amerikanischen Organisationen wie dem Johns Hopkins Center for Alternatives to Animal Testing (CAAT), einem akademischen Zentrum in den Vereinigten Staaten, zusammenzuarbeiten , und das Interagency Coordinating Committee for the Validation of Alternative Methods (ICCVAM), das sich aus Vertretern der National Institutes of Health, der US Environmental Protection Agency, der US Food and Drug Administration und der Consumer Products Safety Commission zusammensetzt.

Die Validierung von In-vitro-Tests erfordert eine umfangreiche Organisation und Planung. Es muss ein Konsens zwischen staatlichen Regulierungsbehörden und industriellen und akademischen Wissenschaftlern über akzeptable Verfahren und eine ausreichende Aufsicht durch einen wissenschaftlichen Beirat bestehen, um sicherzustellen, dass die Protokolle festgelegten Standards entsprechen. Die Validierungsstudien sollten in einer Reihe von Referenzlabors unter Verwendung kalibrierter Chemikaliensätze aus einer Chemikalienbank und Zellen oder Geweben aus einer einzigen Quelle durchgeführt werden. Sowohl die laborinterne Wiederholbarkeit als auch die interlaboratorische Reproduzierbarkeit eines Kandidatentests müssen nachgewiesen und die Ergebnisse einer angemessenen statistischen Analyse unterzogen werden. Nachdem die Ergebnisse aus den verschiedenen Komponenten der Validierungsstudien zusammengestellt wurden, kann der wissenschaftliche Beirat Empfehlungen zur Validität des/der Kandidatentests für einen bestimmten Zweck abgeben. Darüber hinaus sollen die Ergebnisse der Studien in peer-reviewed Journals veröffentlicht und in eine Datenbank gestellt werden.

Die Definition des Validierungsprozesses ist derzeit noch in Arbeit. Jede neue Validierungsstudie liefert Informationen, die für das Design der nächsten Studie nützlich sind. Internationale Kommunikation und Zusammenarbeit sind für die zügige Entwicklung einer allgemein akzeptablen Reihe von Protokollen unerlässlich, insbesondere angesichts der erhöhten Dringlichkeit, die durch die Verabschiedung der EG-Kosmetikrichtlinie auferlegt wird. Diese Rechtsvorschriften können in der Tat den nötigen Anstoß für ernsthafte Validierungsbemühungen geben. Erst durch den Abschluss dieses Prozesses kann die Akzeptanz von In-vitro-Methoden durch die verschiedenen Regulierungsbehörden beginnen.

Fazit

Dieser Artikel hat einen breiten Überblick über den aktuellen Stand der In-vitro-Toxizitätsprüfung gegeben. Die Wissenschaft der In-vitro-Toxikologie ist relativ jung, wächst aber exponentiell. Die Herausforderung für die kommenden Jahre besteht darin, das durch zelluläre und molekulare Studien generierte mechanistische Wissen in den riesigen Bestand an In-vivo-Daten einzubeziehen, um eine vollständigere Beschreibung toxikologischer Mechanismen zu liefern und ein Paradigma zu etablieren, mit dem In-vitro-Daten verwendet werden können Toxizität in vivo vorherzusagen. Nur durch die konzertierten Bemühungen von Toxikologen und Regierungsvertretern kann der inhärente Wert dieser In-vitro-Methoden realisiert werden.

Bewertung der genetischen Toxizität

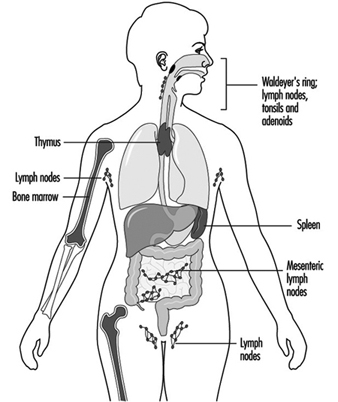

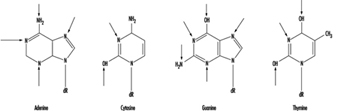

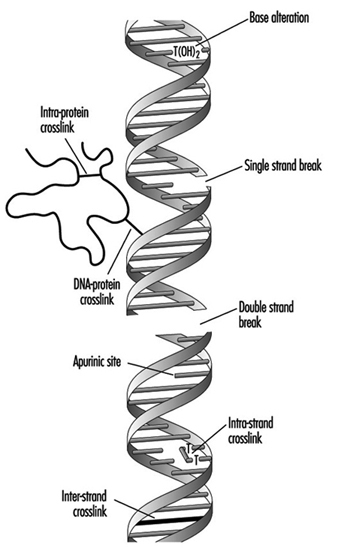

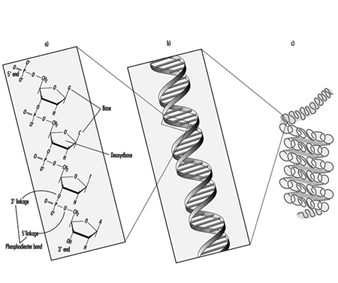

Die Bewertung der genetischen Toxizität ist die Bewertung von Wirkstoffen auf ihre Fähigkeit, eine der drei allgemeinen Arten von Veränderungen (Mutationen) im genetischen Material (DNA) hervorzurufen: Gen, Chromosomen und Genom. In Organismen wie dem Menschen bestehen die Gene aus DNA, die aus einzelnen Einheiten besteht, die Nukleotidbasen genannt werden. Die Gene sind in diskreten physikalischen Strukturen angeordnet, die als Chromosomen bezeichnet werden. Genotoxizität kann erhebliche und irreversible Auswirkungen auf die menschliche Gesundheit haben. Genotoxische Schäden sind ein entscheidender Schritt bei der Entstehung von Krebs und können auch an der Entstehung von Geburtsfehlern und fötalem Tod beteiligt sein. Die drei oben erwähnten Klassen von Mutationen können in jeder der beiden Arten von Geweben auftreten, die Organismen wie Menschen besitzen: Spermien oder Eier (Keimzellen) und das übrige Gewebe (somatische Zellen).

Assays, die Genmutationen messen, sind solche, die die Substitution, Addition oder Deletion von Nukleotiden innerhalb eines Gens nachweisen. Assays, die chromosomale Mutationen messen, sind solche, die Brüche oder chromosomale Umlagerungen nachweisen, an denen ein oder mehrere Chromosomen beteiligt sind. Assays, die genomische Mutationen messen, sind solche, die Veränderungen in der Anzahl der Chromosomen erkennen, ein Zustand, der als Aneuploidie bezeichnet wird. Die Bewertung der genetischen Toxizität hat sich seit der Entwicklung des ersten Assays zum Nachweis genotoxischer (mutagener) Wirkstoffe durch Herman Muller im Jahr 1927 erheblich verändert. Seitdem wurden mehr als 200 Assays entwickelt, die Mutationen in der DNA messen; jedoch werden heute üblicherweise weniger als zehn Assays zur Bewertung der genetischen Toxizität verwendet. Dieser Artikel gibt einen Überblick über diese Assays, beschreibt, was sie messen, und untersucht die Rolle dieser Assays bei der Toxizitätsbewertung.

Identifizierung von KrebsgefahrenVor der Entwicklung des Bereich der genetischen Toxikologie

Die genetische Toxikologie ist zu einem integralen Bestandteil des gesamten Risikobewertungsprozesses geworden und hat in letzter Zeit als zuverlässiger Prädiktor für krebserzeugende Aktivität an Bedeutung gewonnen. Vor der Entwicklung der genetischen Toxikologie (vor 1970) wurden und werden jedoch andere Methoden verwendet, um potenzielle Krebsgefahren für den Menschen zu identifizieren. Es gibt sechs Hauptkategorien von Methoden, die derzeit zur Identifizierung von Krebsrisiken beim Menschen verwendet werden: epidemiologische Studien, langfristige In-vivo-Bioassays, mittelfristige In-vivo-Bioassays, kurzfristige In-vivo- und In-vitro-Bioassays, künstliche Intelligenz (Struktur-Aktivität), und mechanismusbasierte Inferenz.

Tabelle 1 gibt Vor- und Nachteile dieser Methoden an.

Tabelle 1. Vor- und Nachteile aktueller Methoden zur Identifizierung menschlicher Krebsrisiken

| Vorteile | Nachteile | |

| Epidemiologische Studien | (1) Menschen sind die ultimativen Krankheitsindikatoren; (2) empfindliche oder anfällige Populationen zu bewerten; (3) berufliche Expositionskohorten; (4) Umweltwächterwarnungen |

(1) im Allgemeinen retrospektiv (Sterbeurkunden, Erinnerungsverzerrungen usw.); (2) unsensibel, kostspielig, langwierig; (3) zuverlässige Expositionsdaten, die manchmal nicht verfügbar oder schwer zu beschaffen sind; (4) kombinierte, mehrfache und komplexe Expositionen; Fehlen geeigneter Kontrollkohorten; (5) Experimente an Menschen nicht durchgeführt; (6) Krebserkennung, nicht Prävention |

| Langzeit-in-vivo-Bioassays | (1) prospektive und retrospektive (Validierungs-)Bewertungen; (2) ausgezeichnete Korrelation mit identifizierten menschlichen Karzinogenen; (3) bekannte Expositionsniveaus und -bedingungen; (4) identifiziert chemische Toxizitäts- und Karzinogenitätswirkungen; (5) relativ schnell erhaltene Ergebnisse; (6) qualitative Vergleiche zwischen chemischen Klassen; (7) integrative und interaktive biologische Systeme, die eng mit dem Menschen verwandt sind | (1) selten repliziert, ressourcenintensiv; (3) begrenzte Einrichtungen, die für solche Experimente geeignet sind; (4) Debatte über Artenextrapolation; (5) die verwendeten Expositionen liegen oft weit über denen, denen Menschen ausgesetzt sind; (6) Die Exposition gegenüber einer einzelnen Chemikalie entspricht nicht der Exposition des Menschen, die im Allgemeinen mehreren Chemikalien gleichzeitig ausgesetzt ist |

| Mittel- und kurzfristige In-vivo- und In-vitro-Bioassays | (1) schneller und kostengünstiger als andere Assays; (2) große Proben, die leicht repliziert werden können; (3) biologisch bedeutsame Endpunkte werden gemessen (Mutation usw.); (4) können als Screening-Assays verwendet werden, um Chemikalien für Langzeit-Bioassays auszuwählen |

(1) in vitro nicht vollständig prädiktiv für in vivo; (2) normalerweise organismus- oder organspezifisch; (3) Potenzen, die nicht mit ganzen Tieren oder Menschen vergleichbar sind |

| Verbindungen zwischen chemischer Struktur und biologischer Aktivität | (1) relativ einfach, schnell und kostengünstig; (2) zuverlässig für bestimmte chemische Klassen (z. B. Nitrosamine und Benzidin-Farbstoffe); (3) aus biologischen Daten entwickelt, aber nicht von zusätzlichen biologischen Experimenten abhängig | (1) nicht „biologisch“; (2) viele Ausnahmen von formulierten Regeln; (3) retrospektiv und selten (aber zunehmend) prospektiv |

| Mechanismusbasierte Schlussfolgerungen | (1) ziemlich genau für bestimmte Klassen von Chemikalien; (2) erlaubt Verfeinerungen von Hypothesen; (3) können Risikobewertungen auf empfindliche Bevölkerungsgruppen ausrichten | (1) Mechanismen der chemischen Karzinogenese undefiniert, mehrfach und wahrscheinlich chemikalien- oder klassenspezifisch; (2) kann es versäumen, Ausnahmen von allgemeinen Mechanismen hervorzuheben |

Begründung und konzeptionelle Grundlage für genetische Toxikologie-Assays

Obwohl sich die genaue Art und Anzahl der für die Bewertung der genetischen Toxizität verwendeten Assays ständig weiterentwickeln und von Land zu Land unterschiedlich sind, umfassen die gebräuchlichsten Assays für (1) Genmutationen in Bakterien und/oder kultivierten Säugetierzellen und (2) Chromosomenmutationen in kultivierte Säugetierzellen und/oder Knochenmark in lebenden Mäusen. Einige der Assays innerhalb dieser zweiten Kategorie können auch Aneuploidie nachweisen. Obwohl diese Assays keine Mutationen in Keimzellen nachweisen, werden sie hauptsächlich wegen der zusätzlichen Kosten und der Komplexität der Durchführung von Keimzellassays verwendet. Dennoch werden Keimzellassays an Mäusen verwendet, wenn Informationen über Keimzellwirkungen erwünscht sind.

Systematische Studien über einen Zeitraum von 25 Jahren (1970-1995), insbesondere beim US National Toxicology Program in North Carolina, haben zur Verwendung einer diskreten Anzahl von Assays zum Nachweis der mutagenen Aktivität von Mitteln geführt. Die Begründung für die Bewertung der Nützlichkeit der Assays basierte auf ihrer Fähigkeit, Mittel nachzuweisen, die bei Nagetieren Krebs verursachen und die im Verdacht stehen, beim Menschen Krebs zu verursachen (dh Karzinogene). Denn Studien der letzten Jahrzehnte haben gezeigt, dass Krebszellen Mutationen in bestimmten Genen enthalten und dass viele Karzinogene auch Mutagene sind. Daher wird angenommen, dass Krebszellen somatische Zellmutationen enthalten, und Karzinogenese wird als eine Art von somatischer Zellmutagenese angesehen.

Die heute am häufigsten verwendeten genetischen Toxizitätsassays wurden nicht nur wegen ihrer großen Datenbank, relativ niedrigen Kosten und einfachen Durchführung ausgewählt, sondern weil sie gezeigt haben, dass sie viele Nagetier- und vermutlich auch menschliche Karzinogene nachweisen. Folglich werden genetische Toxizitätstests verwendet, um die potenzielle Karzinogenität von Wirkstoffen vorherzusagen.

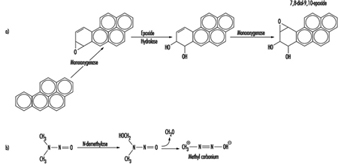

Eine wichtige konzeptionelle und praktische Entwicklung auf dem Gebiet der genetischen Toxikologie war die Erkenntnis, dass viele Karzinogene durch Enzyme im Körper modifiziert werden, wodurch veränderte Formen (Metaboliten) entstehen, die häufig die ultimative karzinogene und mutagene Form der Ausgangschemikalie darstellen. Um diesen Metabolismus in einer Petrischale zu duplizieren, zeigte Heinrich Malling, dass die Zugabe eines Präparats aus Nagetierleber viele der Enzyme enthielt, die notwendig sind, um diese metabolische Umwandlung oder Aktivierung durchzuführen. Daher verwenden viele genetische Toxizitätsassays, die in Schalen oder Röhrchen (in vitro) durchgeführt werden, die Zugabe ähnlicher Enzympräparate. Einfache Präparate werden als S9-Mix und gereinigte Präparate als Mikrosomen bezeichnet. Einige Bakterien- und Säugetierzellen wurden nun gentechnisch verändert, um einige der Gene von Nagetieren oder Menschen zu enthalten, die diese Enzyme produzieren, wodurch die Notwendigkeit reduziert wird, S9-Mix oder Mikrosomen hinzuzufügen.

Genetische Toxikologie-Assays und -Techniken

Die primären bakteriellen Systeme, die für das genetische Toxizitäts-Screening verwendet werden, sind der Salmonella (Ames)-Mutagenitätstest und, in viel geringerem Ausmaß, der Stamm WP2 von Escherichia coli. Studien Mitte der 1980er Jahre zeigten, dass die Verwendung von nur zwei Stämmen des Salmonella-Systems (TA98 und TA100) ausreichte, um etwa 90 % der bekannten Salmonella-Mutagene nachzuweisen. Somit werden diese zwei Stämme für die meisten Screening-Zwecke verwendet; Es stehen jedoch verschiedene andere Stämme für umfangreichere Tests zur Verfügung.

Diese Assays werden auf verschiedene Weise durchgeführt, aber zwei allgemeine Verfahren sind die Platten-Inkorporations- und Flüssigsuspensions-Assays. Beim Platten-Inkorporations-Assay werden die Zellen, die Testchemikalie und (falls gewünscht) das S9 zusammen in einen verflüssigten Agar gegeben und auf die Oberfläche einer Agar-Petriplatte gegossen. Der Top-Agar härtet innerhalb weniger Minuten aus, und die Platten werden zwei bis drei Tage lang inkubiert. Nach dieser Zeit sind mutierte Zellen gewachsen, um visuell erkennbare Zellcluster, sogenannte Kolonien, zu bilden, die dann gezählt werden. Das Agar-Medium enthält selektive Mittel oder ist aus Bestandteilen zusammengesetzt, so dass nur die neu mutierten Zellen wachsen werden. Der Flüssigkeitsinkubationsassay ist ähnlich, außer dass die Zellen, das Testmittel und S9 zusammen in einer Flüssigkeit inkubiert werden, die keinen verflüssigten Agar enthält, und dann die Zellen von dem Testmittel und S9 freigewaschen und auf dem Agar ausgesät werden.

Mutationen in kultivierten Säugetierzellen werden hauptsächlich in einem von zwei Genen nachgewiesen: hpt und tk. Ähnlich wie bei den bakteriellen Assays werden Säugetierzelllinien (aus Nagetier- oder menschlichen Zellen entwickelt) dem Testmittel in Plastikkulturschalen oder -röhrchen ausgesetzt und dann in Kulturschalen ausgesät, die Medium mit einem selektiven Mittel enthalten, das nur das Wachstum mutierter Zellen zulässt . Die für diesen Zweck verwendeten Assays schließen den CHO/HPRT, den TK6 und das Maus-Lymphom L5178Y/TK ein+/- Tests. Andere Zelllinien, die verschiedene DNA-Reparaturmutationen sowie einige am Stoffwechsel beteiligte menschliche Gene enthalten, werden ebenfalls verwendet. Diese Systeme ermöglichen die Wiederherstellung von Mutationen innerhalb des Gens (Genmutation) sowie von Mutationen, die Bereiche des Chromosoms betreffen, die das Gen flankieren (chromosomale Mutation). Diese letztere Art von Mutation wird jedoch in viel größerem Ausmaß durch die wiederhergestellt tk Gensysteme als durch die hpt Gensysteme aufgrund der Lage der tk Gen.

Ähnlich wie der Flüssiginkubationsassay auf bakterielle Mutagenität umfassen Mutagenitätsassays von Säugetierzellen im Allgemeinen das mehrstündige Aussetzen der Zellen in Kulturschalen oder -röhrchen in Gegenwart des Testmittels und S9. Die Zellen werden dann gewaschen, für einige weitere Tage kultiviert, damit die normalen (Wildtyp-)Genprodukte abgebaut und die neu mutierten Genprodukte exprimiert und angereichert werden können, und dann werden sie in Medium ausgesät, das ein selektives Mittel enthält, das dies zulässt nur die mutierten Zellen wachsen. Wie bei den bakteriellen Assays wachsen die mutierten Zellen zu visuell nachweisbaren Kolonien heran, die dann gezählt werden.

Chromosomenmutationen werden hauptsächlich durch zytogenetische Assays identifiziert, bei denen Nagetiere und/oder Nagetier- oder menschliche Zellen in Kulturschalen einer Testchemikalie ausgesetzt werden, eine oder mehrere Zellteilungen stattfinden können, die Chromosomen gefärbt werden und die Chromosomen dann visuell durch ein Mikroskop untersucht werden um Veränderungen in der Struktur oder Anzahl der Chromosomen zu erkennen. Obwohl eine Vielzahl von Endpunkten untersucht werden können, sind die beiden, die derzeit von den Aufsichtsbehörden als die aussagekräftigsten akzeptiert werden, Chromosomenaberrationen und eine Unterkategorie namens Mikronuklei.

Um Zellen auf das Vorhandensein von Chromosomenaberrationen zu untersuchen, sind erhebliche Schulungen und Fachkenntnisse erforderlich, was dies zu einem zeit- und kostenintensiven Verfahren macht. Im Gegensatz dazu erfordern Mikronuklei wenig Training und ihre Erkennung kann automatisiert werden. Mikrokerne erscheinen als kleine Punkte innerhalb der Zelle, die sich vom Kern unterscheiden, der die Chromosomen enthält. Mikrokerne entstehen entweder durch Chromosomenbruch oder durch Aneuploidie. Aufgrund der Leichtigkeit, Mikrokerne im Vergleich zu Chromosomenaberrationen zu bestimmen, und weil neuere Studien darauf hindeuten, dass Mittel, die Chromosomenaberrationen im Knochenmark von lebenden Mäusen induzieren, im Allgemeinen Mikrokerne in diesem Gewebe induzieren, werden Mikrokerne heute allgemein als Hinweis auf die Fähigkeit einer gemessen Mittel zur Induktion chromosomaler Mutationen.

Keimzellassays werden zwar weitaus seltener eingesetzt als die anderen oben beschriebenen Assays, sind aber unverzichtbar, um festzustellen, ob ein Agens ein Risiko für die Keimzellen darstellt, deren Mutationen zu gesundheitlichen Auswirkungen auf nachfolgende Generationen führen können. Die am häufigsten verwendeten Keimzellen-Assays finden bei Mäusen statt und umfassen Systeme, die (1) erbliche Translokationen (Austausche) zwischen Chromosomen (erblicher Translokations-Assay), (2) Gen- oder Chromosomenmutationen nachweisen, an denen spezifische Gene (sichtbarer oder biochemischer spezifischer Locus) beteiligt sind Assays) und (3) Mutationen, die die Lebensfähigkeit beeinträchtigen (Dominant-Letal-Assay). Wie bei den somatischen Zellassays besteht die Arbeitsannahme bei den Keimzellassays darin, dass in diesen Assays positive Mittel als potenzielle humane Keimzellmutagene angesehen werden.

Aktueller Stand und Zukunftsaussichten

Jüngste Studien haben gezeigt, dass nur drei Informationen erforderlich waren, um etwa 90 % einer Reihe von 41 Nagetier-Karzinogenen (dh mutmaßliche menschliche Karzinogene und somatische Zellmutagene) nachzuweisen. Dazu gehörten (1) Kenntnisse der chemischen Struktur des Mittels, insbesondere wenn es elektrophile Einheiten enthält (siehe Abschnitt über Struktur-Wirkungs-Beziehungen); (2) Salmonella-Mutagenitätsdaten; und (3) Daten aus einem 90-Tage-Test auf chronische Toxizität bei Nagetieren (Mäuse und Ratten). Tatsächlich sind im Wesentlichen alle von der IARC deklarierten menschlichen Karzinogene allein mit dem Salmonella-Assay und dem Maus-Knochenmark-Mikronukleus-Assay als Mutagen nachweisbar. Die Verwendung dieser Mutagenitätstests zum Nachweis potenzieller menschlicher Karzinogene wird weiter gestützt durch die Erkenntnis, dass die meisten menschlichen Karzinogene sowohl bei Ratten als auch bei Mäusen karzinogen sind (trans-species Karzinogene) und dass die meisten trans-species Karzinogene bei Salmonellen mutagen sind und/oder Mikronuklei induzieren im Knochenmark der Maus.

Mit Fortschritten in der DNA-Technologie, dem Humangenomprojekt und einem besseren Verständnis der Rolle von Mutationen bei Krebs werden neue Genotoxizitätsassays entwickelt, die wahrscheinlich in Standard-Screening-Verfahren integriert werden. Dazu gehören die Verwendung von transgenen Zellen und Nagetieren. Transgene Systeme sind solche, bei denen ein Gen einer anderen Spezies in eine Zelle oder einen Organismus eingeführt wurde. Zum Beispiel werden jetzt transgene Mäuse experimentell verwendet, die den Nachweis von Mutationen in jedem Organ oder Gewebe des Tieres ermöglichen, basierend auf der Einführung eines bakteriellen Gens in die Maus. Bakterienzellen wie Salmonella und Säugetierzellen (einschließlich menschlicher Zelllinien) sind jetzt verfügbar, die Gene enthalten, die am Metabolismus von karzinogenen/mutagenen Stoffen beteiligt sind, wie die P450-Gene. Molekulare Analyse der tatsächlichen Mutationen, die im Transgen innerhalb transgener Nagetiere oder innerhalb nativer Gene wie z hpt, oder der Zielgene in Salmonella können jetzt durchgeführt werden, so dass die genaue Art der durch die Chemikalien induzierten Mutationen bestimmt werden kann, Einblicke in den Wirkungsmechanismus der Chemikalie erhalten und Vergleiche mit Mutationen bei Menschen ermöglichen, die mutmaßlich dem Agens ausgesetzt waren .

Molekulare Fortschritte in der Zytogenetik erlauben jetzt eine detailliertere Bewertung chromosomaler Mutationen. Dazu gehört die Verwendung von Sonden (kleine DNA-Stücke), die an bestimmte Gene binden (hybridisieren). Neuanordnungen von Genen auf dem Chromosom können dann durch die veränderte Position der Sonden aufgedeckt werden, die fluoreszieren und leicht als farbige Sektoren auf den Chromosomen sichtbar gemacht werden. Der Einzelzell-Gelelektrophorese-Assay für DNA-Brüche (allgemein als „Comet“-Assay bezeichnet) ermöglicht den Nachweis von DNA-Brüchen innerhalb einzelner Zellen und kann in Kombination mit zytogenetischen Techniken zu einem äußerst nützlichen Werkzeug zum Nachweis von Chromosomenschäden werden.

Nach vielen Jahren der Nutzung und dem Aufbau einer großen und systematisch aufgebauten Datenbank kann die genetische Toxizitätsbewertung nun mit nur wenigen Assays zu relativ geringen Kosten in kurzer Zeit (wenige Wochen) durchgeführt werden. Die erzeugten Daten können verwendet werden, um die Fähigkeit eines Mittels vorherzusagen, ein Nagetier und vermutlich menschliches Karzinogen/Mutagen somatischer Zellen zu sein. Eine solche Fähigkeit ermöglicht es, das Einbringen von mutagenen und karzinogenen Stoffen in die Umwelt zu begrenzen und alternative, nicht mutagene Stoffe zu entwickeln. Zukünftige Studien sollten zu noch besseren Methoden mit größerer Vorhersagekraft als die derzeitigen Assays führen.

Biomarker

Das Wort Biomarker ist die Abkürzung für biologischer Marker, ein Begriff, der sich auf ein messbares Ereignis bezieht, das in einem biologischen System wie dem menschlichen Körper auftritt. Dieses Ereignis wird dann als Widerspiegelung oder Marker eines allgemeineren Zustands des Organismus oder der Lebenserwartung interpretiert. In der Arbeitsmedizin wird ein Biomarker im Allgemeinen als Indikator für den Gesundheitszustand oder das Krankheitsrisiko verwendet.

Biomarker werden sowohl für In-vitro- als auch für In-vivo-Studien verwendet, die Menschen einschließen können. Üblicherweise werden drei spezifische Arten von biologischen Markern identifiziert. Obwohl einige Biomarker möglicherweise schwer zu klassifizieren sind, werden sie normalerweise in Biomarker der Exposition, Biomarker der Wirkung oder Biomarker der Empfindlichkeit unterteilt (siehe Tabelle 1).

Tabelle 1. Beispiele für Biomarker der Exposition oder Wirkungsbiomarker, die in toxikologischen Studien im Arbeitsschutz verwendet werden

| Stichprobe | Messung | Zweck |

| Expositions-Biomarker | ||

| Fettgewebe | Dioxin | Dioxinbelastung |

| Blut | Führen (Lead) | Belastung durch Blei |

| Knochen | Aluminium | Aluminium-Exposition |

| Ausgeatmeter Atem | Toluol | Toluol-Exposition |

| Haarfarbe | Merkur | Exposition gegenüber Methylquecksilber |

| Serum | Benzol | Benzol-Exposition |

| Urin | Phenol | Benzol-Exposition |

| Effekt-Biomarker | ||

| Blut | Carboxyhämoglobin | Kohlenmonoxidbelastung |

| rote Blutkörperchen | Zink-Protoporphyrin | Belastung durch Blei |

| Serum | Cholinesterase | Organophosphat-Exposition |

| Urin | Mikroglobuline | Nephrotoxische Exposition |

| Weiße Blutkörperchen | DNA-Addukte | Mutagen-Exposition |

Bei einem akzeptablen Maß an Validität können Biomarker für mehrere Zwecke eingesetzt werden. Auf individueller Basis kann ein Biomarker verwendet werden, um eine Diagnose einer bestimmten Art von Vergiftung oder einer anderen chemisch induzierten nachteiligen Wirkung zu unterstützen oder zu widerlegen. Bei einem gesunden Probanden kann ein Biomarker auch die individuelle Überempfindlichkeit gegenüber bestimmten chemischen Expositionen widerspiegeln und kann daher als Grundlage für die Risikovorhersage und Beratung dienen. In Gruppen exponierter Arbeitnehmer können einige Expositions-Biomarker angewendet werden, um das Ausmaß der Einhaltung von Umweltschutzvorschriften oder die Wirksamkeit von Präventionsbemühungen im Allgemeinen zu bewerten.

Biomarker der Exposition

Ein Expositions-Biomarker kann eine exogene Verbindung (oder ein Metabolit) im Körper, ein interaktives Produkt zwischen der Verbindung (oder dem Metaboliten) und einer endogenen Komponente oder ein anderes Ereignis im Zusammenhang mit der Exposition sein. Am häufigsten umfassen Biomarker für Expositionen gegenüber stabilen Verbindungen wie Metallen Messungen der Metallkonzentrationen in geeigneten Proben wie Blut, Serum oder Urin. Bei flüchtigen Chemikalien kann deren Konzentration in der ausgeatmeten Luft (nach Inhalation von kontaminationsfreier Luft) beurteilt werden. Wenn die Verbindung im Körper metabolisiert wird, können ein oder mehrere Metaboliten als Biomarker der Exposition ausgewählt werden; Metaboliten werden häufig in Urinproben bestimmt.

Moderne Analysemethoden können die Trennung von Isomeren oder Kongeneren organischer Verbindungen und die Bestimmung der Speziation von Metallverbindungen oder Isotopenverhältnissen bestimmter Elemente ermöglichen. Anspruchsvolle Analysen ermöglichen die Bestimmung von Veränderungen in der Struktur von DNA oder anderen Makromolekülen, die durch die Bindung mit reaktiven Chemikalien verursacht werden. Solche fortschrittlichen Techniken werden zweifellos erheblich an Bedeutung für Anwendungen in Biomarkerstudien gewinnen, und niedrigere Nachweisgrenzen und eine bessere analytische Validität werden diese Biomarker wahrscheinlich noch nützlicher machen.

Besonders vielversprechende Entwicklungen sind bei Biomarkern für die Exposition gegenüber mutagenen Chemikalien aufgetreten. Diese Verbindungen sind reaktiv und können Addukte mit Makromolekülen wie Proteinen oder DNA bilden. DNA-Addukte können in weißen Blutkörperchen oder Gewebebiopsien nachgewiesen werden, und spezifische DNA-Fragmente können mit dem Urin ausgeschieden werden. Beispielsweise führt die Exposition gegenüber Ethylenoxid zu Reaktionen mit DNA-Basen, und nach Entfernung der beschädigten Base wird N-7-(2-Hydroxyethyl)guanin im Urin ausgeschieden. Einige Addukte beziehen sich möglicherweise nicht direkt auf eine bestimmte Exposition. Beispielsweise spiegelt 8-Hydroxy-2´-desoxyguanosin eine oxidative Schädigung der DNA wider, und diese Reaktion kann durch mehrere chemische Verbindungen ausgelöst werden, von denen die meisten auch eine Lipidperoxidation induzieren.

Auch andere Makromoleküle können durch Adduktbildung oder Oxidation verändert werden. Von besonderem Interesse ist, dass solche reaktiven Verbindungen Hämoglobin-Addukte erzeugen können, die als Biomarker der Exposition gegenüber den Verbindungen bestimmt werden können. Der Vorteil besteht darin, dass aus einer Blutprobe reichlich Hämoglobin gewonnen werden kann und angesichts der viermonatigen Lebensdauer der roten Blutkörperchen die mit den Aminosäuren des Proteins gebildeten Addukte die Gesamtbelastung während dieses Zeitraums anzeigen.

Addukte können durch empfindliche Techniken wie Hochleistungs-Lipidchromatographie bestimmt werden, und einige immunologische Methoden sind ebenfalls verfügbar. Im Allgemeinen sind die Analysemethoden neu, teuer und müssen weiterentwickelt und validiert werden. Eine bessere Empfindlichkeit kann durch die Verwendung von erreicht werden 32P Post-Labeling-Assay, was ein unspezifischer Hinweis darauf ist, dass eine DNA-Schädigung stattgefunden hat. Alle diese Techniken sind potenziell nützlich für die biologische Überwachung und wurden in einer wachsenden Zahl von Studien angewendet. Es werden jedoch einfachere und empfindlichere analytische Methoden benötigt. Angesichts der begrenzten Spezifität einiger Methoden bei geringer Exposition können Tabakrauchen oder andere Faktoren die Messergebnisse erheblich beeinflussen und somit zu Interpretationsschwierigkeiten führen.

Die Exposition gegenüber mutagenen Verbindungen oder gegenüber Verbindungen, die zu Mutagenen metabolisiert werden, kann auch durch Beurteilung der Mutagenität des Urins einer exponierten Person bestimmt werden. Die Urinprobe wird mit einem Bakterienstamm inkubiert, in dem eine bestimmte Punktmutation leicht messbar exprimiert ist. Wenn in der Urinprobe mutagene Chemikalien vorhanden sind, kommt es zu einer erhöhten Mutationsrate in den Bakterien.

Expositionsbiomarker müssen im Hinblick auf die zeitliche Variation der Exposition und den Bezug zu verschiedenen Kompartimenten bewertet werden. Daher müssen der/die durch den Biomarker repräsentierte(n) Zeitrahmen, d. h. das Ausmaß, in dem die Biomarkermessung frühere Exposition(en) und/oder akkumulierte Körperbelastung widerspiegelt, aus toxikokinetischen Daten bestimmt werden, um das Ergebnis zu interpretieren. Insbesondere sollte berücksichtigt werden, inwieweit der Biomarker auf eine Retention in bestimmten Zielorganen hinweist. Obwohl Blutproben häufig für Biomarkerstudien verwendet werden, wird peripheres Blut im Allgemeinen nicht als Kompartiment angesehen, obwohl es als Transportmedium zwischen Kompartimenten fungiert. Das Ausmaß, in dem die Konzentration im Blut die Spiegel in verschiedenen Organen widerspiegelt, variiert stark zwischen verschiedenen Chemikalien und hängt normalerweise auch von der Dauer der Exposition sowie der Zeit seit der Exposition ab.

Manchmal wird diese Art von Nachweis verwendet, um einen Biomarker als Indikator für die (gesamte) absorbierte Dosis oder als Indikator für die effektive Dosis (dh die Menge, die das Zielgewebe erreicht hat) zu klassifizieren. Beispielsweise kann die Exposition gegenüber einem bestimmten Lösungsmittel anhand von Daten über die tatsächliche Konzentration des Lösungsmittels im Blut zu einem bestimmten Zeitpunkt nach der Exposition bewertet werden. Diese Messung spiegelt die Menge des Lösungsmittels wider, die in den Körper aufgenommen wurde. Ein Teil der absorbierten Menge wird aufgrund des Dampfdrucks des Lösungsmittels ausgeatmet. Während das Lösungsmittel im Blut zirkuliert, interagiert es mit verschiedenen Komponenten des Körpers und wird schließlich durch Enzyme abgebaut. Das Ergebnis der Stoffwechselvorgänge kann durch die Bestimmung spezifischer Mercaptursäuren, die durch Konjugation mit Glutathion entstehen, beurteilt werden. Die kumulative Ausscheidung von Mercaptursäuren kann die effektive Dosis besser widerspiegeln als die Blutkonzentration.

Lebensereignisse wie Reproduktion und Alterung können die Verteilung einer Chemikalie beeinflussen. Die Verteilung von Chemikalien im Körper wird durch eine Schwangerschaft erheblich beeinflusst, und viele Chemikalien können die Plazentaschranke passieren und so zu einer Exposition des Fötus führen. Laktation kann zur Ausscheidung von fettlöslichen Chemikalien führen, was zu einer verringerten Retention bei der Mutter zusammen mit einer erhöhten Aufnahme durch den Säugling führt. Bei Gewichtsabnahme oder Entwicklung einer Osteoporose können gespeicherte Chemikalien freigesetzt werden, was dann zu einer erneuten und langwierigen „körpereigenen“ Belastung von Zielorganen führen kann. Andere Faktoren können die individuelle Absorption, den Metabolismus, die Retention und Verteilung chemischer Verbindungen beeinflussen, und einige Biomarker für die Empfindlichkeit sind verfügbar (siehe unten).

Biomarker der Wirkung

Ein Wirkungsmarker kann eine endogene Komponente oder ein Maß für die Funktionsfähigkeit oder ein anderer Indikator für den Zustand oder das Gleichgewicht des Körpers oder Organsystems sein, das durch die Exposition beeinflusst wird. Solche Effektmarker sind im Allgemeinen präklinische Indikatoren für Anomalien.

Diese Biomarker können spezifisch oder unspezifisch sein. Die spezifischen Biomarker sind nützlich, da sie auf eine biologische Wirkung einer bestimmten Exposition hinweisen und somit Hinweise liefern, die potenziell für präventive Zwecke verwendet werden können. Die unspezifischen Biomarker weisen nicht auf eine einzelne Wirkungsursache hin, sondern können aufgrund einer Mischexposition die gesamte, integrierte Wirkung widerspiegeln. Beide Arten von Biomarkern können daher im Arbeitsschutz von erheblichem Nutzen sein.

Es gibt keine klare Unterscheidung zwischen Expositions-Biomarkern und Wirkungs-Biomarkern. Beispielsweise könnte man sagen, dass die Adduktbildung eher eine Wirkung als die Exposition widerspiegelt. Wirkungsbiomarker weisen jedoch meist auf Veränderungen der Funktionen von Zellen, Geweben oder des gesamten Körpers hin. Einige Forscher zählen grobe Veränderungen wie eine Zunahme des Lebergewichts von exponierten Labortieren oder ein vermindertes Wachstum bei Kindern als Biomarker für die Wirkung. Wirkungsbiomarker sollten im Sinne des Arbeitsschutzes auf solche beschränkt werden, die auf subklinische oder reversible biochemische Veränderungen, wie z. B. Hemmung von Enzymen, hinweisen. Der wohl am häufigsten verwendete Wirkungsbiomarker ist die Hemmung der Cholinesterase durch bestimmte Insektizide, also Organophosphate und Carbamate. In den meisten Fällen ist dieser Effekt vollständig reversibel, und die Enzymhemmung spiegelt die Gesamtexposition gegenüber dieser speziellen Gruppe von Insektiziden wider.

Einige Expositionen führen nicht zu einer Enzymhemmung, sondern zu einer erhöhten Aktivität eines Enzyms. Dies ist bei mehreren Enzymen der P450-Familie der Fall (siehe „Genetische Determinanten der toxischen Reaktion“). Sie können durch den Kontakt mit bestimmten Lösungsmitteln und polyaromatischen Kohlenwasserstoffen (PAKs) induziert werden. Da diese Enzyme hauptsächlich in Geweben exprimiert werden, aus denen eine Biopsie möglicherweise schwierig zu gewinnen ist, wird die Enzymaktivität indirekt in vivo bestimmt, indem eine Verbindung verabreicht wird, die von diesem bestimmten Enzym metabolisiert wird, und dann das Abbauprodukt im Urin oder Plasma gemessen wird.