Kinder Kategorien

27. Biologische Überwachung (6)

27. Biologische Überwachung

Kapitelherausgeber: Robert Lauwerys

Inhaltsverzeichnis

Tabellen und Abbildungen

Allgemeine Grundsätze

Vito Foà und Lorenzo Alessio

Qualitätssicherung

D. Gompertz

Metalle und metallorganische Verbindungen

P. Hoet und Robert Lauwerys

Organische Lösungsmittel

Masayuki Ikeda

Genotoxische Chemikalien

Marja Sorsa

Pestizide

Marco Maroni und Adalberto Ferioli

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. ACGIH, DFG & andere Grenzwerte für Metalle

2. Beispiele für Chemikalien- und biologisches Monitoring

3. Biologische Überwachung auf organische Lösungsmittel

4. Genotoxizität von Chemikalien, bewertet von IARC

5. Biomarker und einige Zell-/Gewebeproben und Genotoxizität

6. Menschliche Karzinogene, berufliche Exposition und zytogenetische Endpunkte

8. Exposition durch Produktion und Verwendung von Pestiziden

9. Akute OP-Toxizität bei verschiedenen Graden der ACHE-Hemmung

10 Variationen von ACHE & PCHE & ausgewählten Gesundheitszuständen

11 Cholinesterase-Aktivitäten von nicht exponierten gesunden Menschen

12 Alkylphosphate im Urin und OP-Pestizide

13 Alkylphosphatmessungen im Urin & OP

14 Carbamat-Metaboliten im Urin

15 Dithiocarbamat-Metaboliten im Urin

16 Vorgeschlagene Indizes für die biologische Überwachung von Pestiziden

17 Empfohlene biologische Grenzwerte (Stand 1996)

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

28. Epidemiologie und Statistik (12)

28. Epidemiologie und Statistik

Kapitel-Editoren: Franco Merletti, Colin L. Soskolne und Paolo Vineis

Inhaltsverzeichnis

Tabellen und Abbildungen

Epidemiologische Methode für Arbeitssicherheit und Gesundheitsschutz

Franco Merletti, Colin L. Soskolne und Paolo Vineis

Expositionsbewertung

M. Gerald Ott

Zusammenfassung der Expositionsmaßnahmen im Arbeitsleben

Colin L. Soskolne

Messung der Auswirkungen von Expositionen

Shelia Hoar Zahm

Fallbeispiel: Maßnahmen

Franco Merletti, Colin L. Soskolne und Paola Vineis

Optionen im Studiendesign

Sven Herberg

Validitätsprobleme im Studiendesign

Annie J. Sasco

Einfluss zufälliger Messfehler

Paolo Vineis und Colin L. Soskolne

Statistische Methoden

Annibale Biggeri und Mario Braga

Kausalitätsbewertung und Ethik in der epidemiologischen Forschung

Paolo Vineis

Fallstudien zur Veranschaulichung methodischer Probleme bei der Überwachung von Berufskrankheiten

Jung-Der Wang

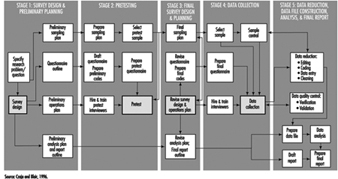

Fragebögen in der epidemiologischen Forschung

Steven D. Stellman und Colin L. Soskolne

Asbest Historische Perspektive

Laurent Garfinkel

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. Fünf ausgewählte zusammenfassende Maßnahmen zur Exposition im Berufsleben

2. Maße für das Auftreten von Krankheiten

3. Assoziationsmaße für eine Kohortenstudie

4. Assoziationsmaße für Fall-Kontroll-Studien

5. Allgemeines Häufigkeitstabellenlayout für Kohortendaten

6. Musterlayout von Fallkontrolldaten

7. Layout-Fallkontrolldaten – eine Kontrolle pro Fall

8. Hypothetische Kohorte von 1950 Individuen zu T2

9. Indizes der zentralen Tendenz und Streuung

10 Ein binomiales Experiment & Wahrscheinlichkeiten

11 Mögliche Ergebnisse eines binomialen Experiments

12 Binomialverteilung, 15 Erfolge/30 Versuche

13 Binomialverteilung, p = 0.25; 30 Versuche

14 Fehler XNUMX. Art & Leistung; x = 12, n = 30, a = 0.05

15 Fehler XNUMX. Art & Leistung; x = 12, n = 40, a = 0.05

16 632 Arbeitnehmer, die 20 Jahre oder länger Asbest ausgesetzt waren

17 O/E Zahl der Todesfälle unter 632 Asbestarbeitern

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

29. Ergonomie (27)

29. Ergonomie

Kapitel-Editoren: Wolfgang Laurig und Joachim Vedder

Inhaltsverzeichnis

Tabellen und Abbildungen

Überblick

Wolfgang Laurig und Joachim Vedder

Ziele, Prinzipien und Methoden

Wesen und Ziele der Ergonomie

William T. Singleton

Analyse von Aktivitäten, Aufgaben und Arbeitssystemen

Véronique De Keyser

Ergonomie und Standardisierung

Friedhelm Nachreiner

Prüflisten

Pranab Kumar Nag

Physikalische und physiologische Aspekte

Anthropometrie

Melchiorre Masali

Muskelarbeit

Juhani Smolander und Veikko Louhevaara

Körperhaltungen bei der Arbeit

Ilkka Kurinka

Biomechanik

Frank Darby

Allgemeine Müdigkeit

Etienne Grandjean

Müdigkeit und Erholung

Rolf Helbig und Walter Rohmert

Psychologische Aspekte

Geistige Arbeitsbelastung

Winfried Hacker

Wachsamkeit

Herbert Heuer

Geistige Müdigkeit

Peter Richter

Organisatorische Aspekte der Arbeit

Arbeitsorganisation

Eberhard Ulich und Gudela Grote

Schlafentzug

Kazutaka Kogi

Gestaltung von Arbeitssystemen

Workstations

Roland Kadefors

Tools

TM Fraser

Bedienelemente, Anzeigen und Bedienfelder

Karl HE Kroemer

Informationsverarbeitung und Design

Andries F. Sanders

Designen für alle

Entwerfen für bestimmte Gruppen

Witz H. Grady-van den Nieuwboer

Fallstudie: Die internationale Klassifikation der Funktionseinschränkung beim Menschen

Kulturelle Unterschiede

Houshang Shahnavaz

Ältere Arbeitnehmer

Antoine Laville und Serge Volkoff

Arbeitnehmer mit besonderen Bedürfnissen

Witz H. Grady-van den Nieuwboer

Vielfalt und Bedeutung der Ergonomie – zwei Beispiele

Systemdesign in der Diamantherstellung

Issachar Gilad

Missachtung ergonomischer Gestaltungsprinzipien: Tschernobyl

Wladimir M. Munipov

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. Grundlegende anthropometrische Kernliste

2. Ermüdung und Erholung abhängig vom Aktivitätsniveau

3. Regeln der Kombinationswirkung zweier Stressfaktoren auf die Belastung

4. Es wird zwischen mehreren negativen Folgen psychischer Belastung unterschieden

5. Arbeitsorientierte Prinzipien zur Produktionsgestaltung

6. Partizipation im organisatorischen Kontext

7. Benutzerbeteiligung am Technologieprozess

8. Unregelmäßige Arbeitszeiten und Schlafentzug

9. Aspekte von Früh-, Anker- und Verzögerungsschlaf

10 Kontrollieren Sie Bewegungen und erwartete Effekte

11 Steuerungs-Wirkungs-Beziehungen gängiger Handsteuerungen

12 Regeln für die Anordnung von Kontrollen

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

30. Arbeitshygiene (6)

30. Arbeitshygiene

Kapitel-Editor: Robert F. Herrick

Inhaltsverzeichnis

Tabellen und Abbildungen

Ziele, Definitionen und allgemeine Informationen

Berenice I. Ferrari Goelzer

Gefahren erkennen

Linnea Lillienberg

Bewertung der Arbeitsumgebung

Lori A. Todd

Arbeitshygiene: Expositionskontrolle durch Intervention

James Stewart

Die biologische Grundlage für die Expositionsbewertung

Dick Heederik

Arbeitsplatzgrenzwerte

Dennis J. Pausenbach

Tische

1. Gefahren durch Chemikalien; biologische und physikalische Wirkstoffe

2. Arbeitsplatzgrenzwerte (OELs) – verschiedene Länder

Zahlen

31. Personenschutz (7)

31. Persönlicher Schutz

Kapitel-Editor: Robert F. Herrick

Inhaltsverzeichnis

Tabellen und Abbildungen

Überblick und Philosophie des Personenschutzes

Robert F. Herrick

Augen- und Gesichtsschutz

Kikuzi Kimura

Fuß- und Beinschutz

Toyohiko Miura

Kopfschutz

Isabelle Balty und Alain Mayer

Gehörschutz

John R. Franks und Elliott H. Berger

Schutzkleidung

S.Zack Mansdorf

Atemschutz

Thomas J. Nelson

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. Transmissionsanforderungen (ISO 4850-1979)

2. Schutzmaßstäbe - Gasschweißen & Lötschweißen

3. Schutzwaage - Sauerstoffschneiden

4. Schutzmaßstäbe - Plasmalichtbogenschneiden

5. Schutzwaagen - Lichtbogenschweißen oder Fugenhobeln

6. Schutzmaßstäbe - Plasma-Lichtbogen-Direktschweißen

7. Schutzhelm: ISO-Norm 3873-1977

8. Geräuschreduzierungsbewertung eines Gehörschutzes

9. Berechnung der A-bewerteten Rauschunterdrückung

10 Beispiele für Hautgefahrenkategorien

11 Physikalische, chemische und biologische Leistungsanforderungen

12 Sachgefahren im Zusammenhang mit bestimmten Tätigkeiten

13 Zugewiesene Schutzfaktoren aus ANSI Z88 2 (1992)

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

32. Aufzeichnungssysteme und Überwachung (9)

32. Aufzeichnungssysteme und Überwachung

Kapitel-Editor: Steven D. Stellman

Inhaltsverzeichnis

Tabellen und Abbildungen

Überwachungs- und Meldesysteme für Berufskrankheiten

Steven B. Markowitz

Überwachung von Arbeitsgefahren

David H. Wegman und Steven D. Stellman

Überwachung in Entwicklungsländern

David Koh und Kee-Seng Chia

Entwicklung und Anwendung eines Klassifizierungssystems für Arbeitsunfälle und Berufskrankheiten

Elyce Biddle

Risikoanalyse von nicht tödlichen Verletzungen und Krankheiten am Arbeitsplatz

John W. Ruser

Fallstudie: Arbeitnehmerschutz und Statistiken zu Unfällen und Berufskrankheiten - HVBG, Deutschland

Martin Butz und Burkhard Hoffmann

Fallstudie: Wismut – Eine Neuauflage der Uranexposition

Heinz Otten und Horst Schulz

Messstrategien und -techniken für die berufsbedingte Expositionsabschätzung in der Epidemiologie

Frank Bochmann und Helmut Blome

Fallstudie: Arbeitsmedizinische Erhebungen in China

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. Angiosarkom der Leber - Weltregister

2. Berufskrankheit, USA, 1986 versus 1992

3. US-Todesfälle durch Pneumokoniose und Pleuramesotheliom

4. Musterliste meldepflichtiger Berufskrankheiten

5. Codestruktur für die Meldung von Krankheiten und Verletzungen, USA

6. Nichttödliche Arbeitsunfälle und Berufskrankheiten, USA 1993

7. Risiko von Arbeitsunfällen und Berufskrankheiten

8. Relatives Risiko für sich wiederholende Bewegungszustände

9. Arbeitsunfälle, Deutschland, 1981-93

10 Schleifmaschinen bei Unfällen in der Metallverarbeitung, Deutschland, 1984-93

11 Berufskrankheit, Deutschland, 1980-93

12 Infektionskrankheiten, Deutschland, 1980-93

13 Strahlenbelastung in den Wismut-Bergwerken

14 Berufskrankheiten im Wismuter Uranbergwerk 1952-90

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

33. Toxikologie (21)

33. Toxikologie

Kapitelherausgeberin: Ellen K. Silbergeld

Inhaltsverzeichnis

Tabellen und Abbildungen

Einleitung

Ellen K. Silbergeld, Kapitelredakteurin

Allgemeine Prinzipien der Toxikologie

Definitionen und Konzepte

Bo Holmberg, Johan Hogberg und Gunnar Johanson

Toxikokinetik

Dušan Djuric

Zielorgan und kritische Wirkungen

Marek Jakubowski

Auswirkungen von Alter, Geschlecht und anderen Faktoren

Spomenka Telisman

Genetische Determinanten der toxischen Reaktion

Daniel W. Nebert und Ross A. McKinnon

Mechanismen der Toxizität

Einführung und Konzepte

Philip G. Watanabe

Zellschädigung und Zelltod

Benjamin F. Trump und Irene K. Berezesky

Genetische Toxikologie

R. Rita Misra und Michael P. Waalkes

Immuntoxikologie

Joseph G. Vos und Henk van Loveren

Zielorgan-Toxikologie

Ellen K. Silbergeld

Toxikologische Testmethoden

Biomarker

Philipp Grandjean

Bewertung der genetischen Toxizität

David M. DeMarini und James Huff

In-vitro-Toxizitätstest

Joanne Zürlo

Aktivitätsbeziehungen strukturieren

Ellen K. Silbergeld

Regulatorische Toxikologie

Toxikologie in der Gesundheits- und Sicherheitsverordnung

Ellen K. Silbergeld

Prinzipien der Gefahrenidentifizierung - Der japanische Ansatz

Masayuki Ikeda

Der Ansatz der Vereinigten Staaten zur Risikobewertung von reproduktionstoxischen und neurotoxischen Wirkstoffen

Ellen K. Silbergeld

Ansätze zur Gefahrenidentifizierung - IARC

Harri Vainio und Julian Wilbourn

Anhang – Gesamtbewertungen der Karzinogenität beim Menschen: IARC-Monographien, Bände 1–69 (836)

Karzinogen-Risikobewertung: Andere Ansätze

Cees A. van der Heijden

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

- Beispiele für kritische Organe und kritische Effekte

- Grundlegende Wirkungen möglicher Mehrfachwechselwirkungen von Metallen

- Hämoglobinaddukte bei Arbeitern, die Anilin und Acetanilid ausgesetzt waren

- Erbliche, krebsanfällige Erkrankungen und Defekte in der DNA-Reparatur

- Beispiele für Chemikalien, die in menschlichen Zellen genotoxisch wirken

- Klassifizierung von Tests für Immunmarker

- Beispiele für Biomarker der Exposition

- Vor- und Nachteile von Methoden zur Identifizierung von Krebsrisiken beim Menschen

- Vergleich von In-vitro-Systemen für Hepatotoxizitätsstudien

- Vergleich von SAR- und Testdaten: OECD/NTP-Analysen

- Regulierung chemischer Stoffe durch Gesetze, Japan

- Prüfgegenstände gemäß dem Gesetz zur Kontrolle chemischer Substanzen, Japan

- Chemische Substanzen und das Gesetz zur Kontrolle chemischer Substanzen

- Ausgewählte größere Neurotoxizitätsvorfälle

- Beispiele für spezialisierte Tests zur Messung der Neurotoxizität

- Endpunkte in der Reproduktionstoxikologie

- Vergleich von Niedrigdosis-Extrapolationsverfahren

- Häufig zitierte Modelle zur Charakterisierung des Karzinogenrisikos

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

Allgemeine Müdigkeit

Dieser Artikel ist eine Adaption der 3. Auflage der Encyclopaedia of Occupational Health and Safety.

Die beiden Begriffe Ermüdung und Ruhe sind allen aus eigener Erfahrung bekannt. Mit dem Wort „Müdigkeit“ werden ganz unterschiedliche Zustände bezeichnet, die alle eine Verringerung der Leistungsfähigkeit und Widerstandskraft bewirken. Die sehr unterschiedliche Verwendung des Begriffs Ermüdung hat zu einer fast chaotischen Verwirrung geführt, und es bedarf einiger Klärung der gängigen Vorstellungen. Die Physiologie hat lange Zeit zwischen Muskelermüdung und allgemeiner Ermüdung unterschieden. Ersteres ist ein akutes Schmerzphänomen, das in der Muskulatur lokalisiert ist: Die allgemeine Erschöpfung ist durch ein Gefühl nachlassender Arbeitsbereitschaft gekennzeichnet. Dieser Artikel befasst sich nur mit der allgemeinen Ermüdung, die auch „psychische Ermüdung“ oder „nervöse Ermüdung“ genannt werden kann, und der Ruhe, die sie erfordert.

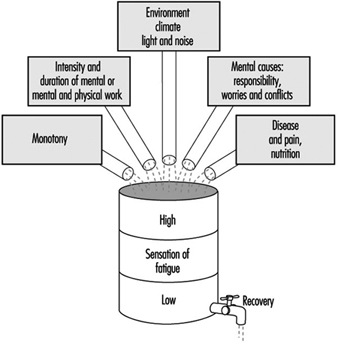

Allgemeine Müdigkeit kann ganz unterschiedliche Ursachen haben, von denen die wichtigsten in Abbildung 1 dargestellt sind. Die Wirkung ist so, als ob sich im Laufe des Tages alle unterschiedlichen erlebten Belastungen im Organismus ansammeln und nach und nach ein Gefühl der Steigerung erzeugen Ermüdung. Dieses Gefühl veranlasst die Entscheidung, die Arbeit einzustellen; seine Wirkung ist die eines physiologischen Vorspiels zum Schlafen.

Abbildung 1. Schematische Darstellung der kumulativen Wirkung der alltäglichen Ursachen von Müdigkeit

Müdigkeit ist eine heilsame Empfindung, wenn man sich hinlegen und ausruhen kann. Missachtet man dieses Gefühl jedoch und zwingt sich weiter zu arbeiten, verstärkt sich das Ermüdungsgefühl, bis es belastend und schließlich überwältigend wird. Diese tägliche Erfahrung zeigt deutlich die biologische Bedeutung der Ermüdung, die zur Erhaltung des Lebens eine Rolle spielt, ähnlich wie andere Empfindungen wie zum Beispiel Durst, Hunger, Angst usw.

Ruhe wird in Abbildung 1 als Entleerung eines Fasses dargestellt. Das Ruhephänomen kann normal stattfinden, wenn der Organismus ungestört bleibt oder zumindest ein wesentlicher Körperteil keiner Belastung ausgesetzt ist. Das erklärt die entscheidende Rolle, die an Werktagen alle Arbeitspausen spielen, von der kurzen Pause während der Arbeit bis zum nächtlichen Schlaf. Das Gleichnis vom Fass verdeutlicht, wie notwendig es für das normale Leben ist, ein gewisses Gleichgewicht zwischen der Gesamtbelastung des Organismus und der Summe der Ruhemöglichkeiten zu erreichen.

Neurophysiologische Interpretation von Müdigkeit

Die Fortschritte der Neurophysiologie in den letzten Jahrzehnten haben wesentlich zu einem besseren Verständnis der Phänomene beigetragen, die durch Ermüdung im zentralen Nervensystem ausgelöst werden.

Der Physiologe Hess hat als erster beobachtet, dass die elektrische Reizung gewisser dienzephaler Strukturen, insbesondere gewisser Strukturen des medialen Kerns des Thalamus, allmählich eine hemmende Wirkung hervorrief, die sich in einer Verschlechterung der Reaktionsfähigkeit äußerte und zum Einschlafen neigen. Wenn die Stimulation eine gewisse Zeit fortgesetzt wurde, folgte der allgemeinen Entspannung Schläfrigkeit und schließlich Schlaf. Später wurde bewiesen, dass sich ausgehend von diesen Strukturen eine aktive Hemmung bis zur Großhirnrinde erstrecken kann, wo alle bewussten Phänomene zentriert sind. Dies spiegelt sich nicht nur im Verhalten wider, sondern auch in der elektrischen Aktivität der Großhirnrinde. Anderen Experimenten gelang es auch, Hemmungen von anderen subkortikalen Regionen auszulösen.

Aus all diesen Studien lässt sich der Schluss ziehen, dass es im Zwischen- und Mittelhirn Strukturen gibt, die ein wirksames Hemmsystem darstellen und Ermüdung mit all ihren Begleiterscheinungen auslösen.

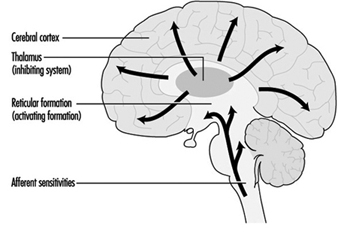

Hemmung und Aktivierung

Zahlreiche Versuche an Tieren und Menschen haben gezeigt, dass die allgemeine Reaktionsbereitschaft beider nicht nur von diesem Hemmungssystem abhängt, sondern wesentlich auch von einem antagonistisch funktionierenden System, dem sogenannten retikulären aufsteigenden Aktivierungssystem. Aus Experimenten wissen wir, dass die Formatio reticularis Strukturen enthält, die den Wachheitsgrad und damit die allgemeine Reaktionsbereitschaft steuern. Nervenverbindungen bestehen zwischen diesen Strukturen und der Großhirnrinde, wo die aktivierenden Einflüsse auf das Bewusstsein ausgeübt werden. Darüber hinaus erhält das aktivierende System Reize von den Sinnesorganen. Andere Nervenverbindungen leiten Impulse aus der Großhirnrinde – dem Bereich des Wahrnehmens und Denkens – an das Aktivierungssystem weiter. Auf der Grundlage dieser neurophysiologischen Konzepte lässt sich feststellen, dass sowohl äußere Reize als auch Einflüsse aus den Bewusstseinsbereichen beim Passieren des aktivierenden Systems eine Reaktionsbereitschaft stimulieren können.

Darüber hinaus lassen viele andere Untersuchungen den Schluss zu, dass sich Reizungen des aktivierenden Systems häufig auch von den vegetativen Zentren aus ausbreiten und den Organismus veranlassen, sich auf den Energieaufwand, auf Arbeit, Kampf, Flucht usw. zu orientieren (ergotrope Umwandlung von die inneren Organe). Umgekehrt scheint es, dass die Stimulation des Hemmsystems im Bereich des vegetativen Nervensystems den Organismus zu Ruhestrebungen, Wiederherstellung der Energiereserven, Assimilationsphänomenen (trophotrope Umwandlung) veranlasst.

Durch die Synthese all dieser neurophysiologischen Befunde lässt sich folgende Vorstellung von Erschöpfung aufstellen: Ermüdungszustand und -gefühl sind bedingt durch die funktionelle Reaktion des Bewusstseins in der Großhirnrinde, die ihrerseits von zwei sich gegensätzlichen Systemen gesteuert wird – das hemmende System und das aktivierende System. Die Arbeitsbereitschaft des Menschen hängt also in jedem Moment vom Grad der Aktivierung der beiden Systeme ab: Überwiegt das hemmende System, befindet sich der Organismus in einem Ermüdungszustand; Wenn das aktivierende System dominant ist, zeigt es eine erhöhte Arbeitsbereitschaft.

Diese psychophysiologische Konzeption der Erschöpfung ermöglicht es, einige ihrer manchmal schwer zu erklärenden Symptome zu verstehen. So kann zum Beispiel ein Gefühl der Müdigkeit plötzlich verschwinden, wenn ein unerwartetes äußeres Ereignis eintritt oder wenn sich emotionale Anspannung entwickelt. In beiden Fällen ist klar, dass das aktivierende System stimuliert wurde. Umgekehrt, wenn die Umgebung eintönig ist oder die Arbeit langweilig erscheint, wird die Funktion des aktivierenden Systems herabgesetzt und das hemmende System wird dominant. Dies erklärt, warum Müdigkeit in einer monotonen Situation auftritt, ohne dass der Organismus belastet wird.

Abbildung 2 zeigt schematisch die Vorstellung der wechselseitig antagonistischen Hemmungs- und Aktivierungssysteme.

Abbildung 2. Schematische Darstellung der Steuerung der Arbeitsbereitschaft durch hemmende und aktivierende Systeme

Klinische Müdigkeit

Es ist eine allgemeine Erfahrung, dass eine starke Ermüdung, die Tag für Tag auftritt, allmählich zu einem Zustand chronischer Erschöpfung führt. Das Ermüdungsgefühl verstärkt sich dann und tritt nicht nur abends nach der Arbeit auf, sondern schon tagsüber, manchmal sogar vor Arbeitsbeginn. Ein Gefühl von Unwohlsein, häufig emotionaler Natur, begleitet diesen Zustand. Bei Fatigue-Patienten werden häufig folgende Symptome beobachtet: erhöhte psychische Emotionalität (asoziales Verhalten, Inkompatibilität), Depressionsneigung (unmotivierte Angst) und Antriebslosigkeit mit Antriebslosigkeit. Diese psychischen Wirkungen gehen oft mit einem unspezifischen Unwohlsein einher und äußern sich durch psychosomatische Symptome: Kopfschmerzen, Schwindel, Herz- und Atemfunktionsstörungen, Appetitlosigkeit, Verdauungsstörungen, Schlaflosigkeit etc.

In Anbetracht der Tendenz zu krankhaften Symptomen, die mit chronischer Erschöpfung einhergehen, kann sie mit Recht als klinische Ermüdung bezeichnet werden. Es besteht eine Tendenz zu vermehrten Fehlzeiten, insbesondere zu mehr Kurzzeitabsenzen. Dies scheint sowohl durch das Ruhebedürfnis als auch durch eine erhöhte Morbidität verursacht zu sein. Der Zustand chronischer Erschöpfung tritt besonders bei Personen auf, die psychischen Konflikten oder Schwierigkeiten ausgesetzt sind. Es ist manchmal sehr schwierig, die äußeren und inneren Ursachen zu unterscheiden. Tatsächlich ist es fast unmöglich, Ursache und Wirkung bei klinischer Müdigkeit zu unterscheiden: Eine negative Einstellung zur Arbeit, zu Vorgesetzten oder zum Arbeitsplatz kann genauso gut Ursache für klinische Müdigkeit sein wie die Folge.

Untersuchungen haben gezeigt, dass die in Telekommunikationsdiensten beschäftigten Telefonisten und Aufsichtspersonen eine signifikante Zunahme der physiologischen Ermüdungserscheinungen nach ihrer Arbeit aufwiesen (visuelle Reaktionszeit, Flickerfusionsfrequenz, Geschicklichkeitstests). Ärztliche Untersuchungen ergaben bei diesen beiden Arbeitergruppen eine deutliche Zunahme von neurotischen Zuständen, Reizbarkeit, Schlafstörungen und chronischem Mattigkeitsgefühl im Vergleich zu einer ähnlichen Gruppe von Frauen, die in den technischen Zweigen der Post, des Telefons beschäftigt waren und Telegrafiedienste. Die Häufung der Symptome war nicht immer auf eine negative Einstellung der betroffenen Frauen zu ihrem Arbeitsplatz oder ihren Arbeitsbedingungen zurückzuführen.

Vorsichtsmaßnahmen

Es gibt kein Allheilmittel gegen Müdigkeit, aber es kann viel getan werden, um das Problem zu lindern, indem man auf die allgemeinen Arbeitsbedingungen und die physische Umgebung am Arbeitsplatz achtet. Viel kann beispielsweise durch die richtige Einteilung der Arbeitszeiten, die Bereitstellung angemessener Ruhezeiten und geeigneter Kantinen und Toiletten erreicht werden; Arbeitnehmern sollte auch angemessener bezahlter Urlaub gewährt werden. Auch die ergonomische Untersuchung des Arbeitsplatzes kann zur Reduzierung von Ermüdungserscheinungen beitragen, indem sichergestellt wird, dass Sitze, Tische und Werkbänke angemessen dimensioniert sind und der Arbeitsablauf richtig organisiert ist. Darüber hinaus können sich Lärmschutz, Klimaanlage, Heizung, Belüftung und Beleuchtung positiv auf die Verzögerung des Auftretens von Ermüdung bei Arbeitnehmern auswirken.

Monotonie und Anspannung können auch durch kontrollierte Verwendung von Farbe und Dekoration in der Umgebung, Musikintervalle und manchmal Pausen für körperliche Übungen für sitzende Arbeiter gemildert werden. Auch die Ausbildung der Arbeiter und insbesondere des Aufsichts- und Managementpersonals spielt eine wichtige Rolle.

Zielorgan-Toxikologie

Die Untersuchung und Charakterisierung von Chemikalien und anderen Agenzien auf toxische Eigenschaften erfolgt häufig auf der Grundlage spezifischer Organe und Organsysteme. In diesem Kapitel wurden zwei Ziele für eine eingehende Diskussion ausgewählt: das Immunsystem und das Gen. Diese Beispiele wurden ausgewählt, um ein komplexes Zielorgansystem und ein molekulares Ziel innerhalb von Zellen darzustellen. Für eine umfassendere Diskussion der Toxikologie von Zielorganen wird der Leser auf toxikologische Standardtexte wie Casarett und Doull und Hayes verwiesen. Das International Programme on Chemical Safety (IPCS) hat ebenfalls mehrere Kriteriendokumente zur Zielorgantoxikologie nach Organsystemen veröffentlicht.

Zielorgantoxikologische Studien werden gewöhnlich auf der Grundlage von Informationen durchgeführt, die das Potenzial für spezifische toxische Wirkungen einer Substanz anzeigen, entweder aus epidemiologischen Daten oder aus allgemeinen akuten oder chronischen Toxizitätsstudien, oder auf der Grundlage besonderer Bedenken zum Schutz bestimmter Organfunktionen, wie z B. Fortpflanzung oder fötale Entwicklung. In einigen Fällen werden bestimmte Toxizitätstests für Zielorgane ausdrücklich von gesetzlichen Behörden vorgeschrieben, wie z Stoffkontrollgesetz (siehe „Prinzipien der Gefahrenerkennung: Der japanische Ansatz“).

Wie in „Zielorgan und kritische Wirkungen“ erörtert, basiert die Identifizierung eines kritischen Organs auf der Erkennung des Organs oder Organsystems, das zuerst negativ oder auf die niedrigsten Dosen oder Expositionen reagiert. Diese Informationen werden dann verwendet, um spezifische toxikologische Untersuchungen oder genauer definierte Toxizitätstests zu konzipieren, die darauf ausgelegt sind, empfindlichere Hinweise auf eine Vergiftung im Zielorgan hervorzurufen. Toxikologische Studien zu Zielorganen können auch verwendet werden, um Wirkungsmechanismen zu bestimmen und bei der Risikobewertung verwendet zu werden (siehe „The United States approach to risk assessment of reproduction toxicants and neurotoxic agents“).

Methoden der Zielorgantoxizitätsstudien

Zielorgane können durch Exposition intakter Organismen und detaillierte Analyse der Funktion und Histopathologie im Zielorgan oder durch In-vitro-Exposition von Zellen, Gewebeschnitten oder ganzen Organen untersucht werden, die für kurze oder lange Zeiträume in Kultur gehalten werden (siehe „Mechanismen der Toxikologie: Einführung und Konzepte“). In einigen Fällen stehen möglicherweise auch Gewebe menschlicher Probanden für Zielorgan-Toxizitätsstudien zur Verfügung, und diese können Gelegenheiten bieten, Annahmen über die artenübergreifende Extrapolation zu validieren. Allerdings muss bedacht werden, dass solche Studien keine Angaben zur relativen Toxikokinetik liefern.

Im Allgemeinen weisen Toxizitätsstudien auf Zielorgane die folgenden gemeinsamen Merkmale auf: detaillierte histopathologische Untersuchung des Zielorgans, einschließlich Post-Mortem-Untersuchung, Gewebegewicht und Untersuchung fixierter Gewebe; biochemische Studien kritischer Wege im Zielorgan, wie z. B. wichtige Enzymsysteme; Funktionsstudien zur Fähigkeit des Organs und der Zellbestandteile, erwartete Stoffwechsel- und andere Funktionen auszuführen; und Analyse von Biomarkern der Exposition und frühen Wirkungen in Zielorganzellen.

Detaillierte Kenntnisse der Zielorganphysiologie, Biochemie und Molekularbiologie können in Zielorganstudien eingebracht werden. Da zum Beispiel die Synthese und Sekretion von Proteinen mit kleinem Molekulargewicht ein wichtiger Aspekt der Nierenfunktion ist, beziehen Nephrotoxizitätsstudien häufig besondere Aufmerksamkeit auf diese Parameter (IPCS 1991). Da die Kommunikation von Zelle zu Zelle ein grundlegender Prozess der Funktion des Nervensystems ist, können Zielorganstudien zur Neurotoxizität detaillierte neurochemische und biophysikalische Messungen der Neurotransmittersynthese, -aufnahme, -speicherung, -freisetzung und -bindung sowie elektrophysiologische Messungen von Membranveränderungen umfassen Potenzial, das mit diesen Ereignissen verbunden ist.

Ein großer Schwerpunkt wird auf die Entwicklung von In-vitro-Methoden für die Zielorgantoxizität gelegt, um die Verwendung ganzer Tiere zu ersetzen oder zu reduzieren. Wesentliche Fortschritte bei diesen Methoden wurden für reproduktionstoxische Stoffe erzielt (Heindel und Chapin 1993).

Zusammenfassend werden Zielorgan-Toxizitätsstudien im Allgemeinen als höherwertiger Test zur Bestimmung der Toxizität durchgeführt. Die Auswahl spezifischer Zielorgane für die weitere Bewertung hängt von den Ergebnissen von Screening-Level-Tests ab, wie z. B. den akuten oder subchronischen Tests, die von der OECD und der Europäischen Union verwendet werden; Einige Zielorgane und Organsysteme können a priori Kandidaten für eine spezielle Untersuchung sein, da Bedenken bestehen, bestimmte Arten von nachteiligen Auswirkungen auf die Gesundheit zu verhindern.

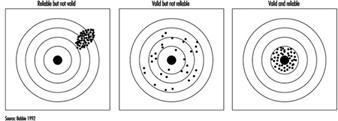

Validitätsprobleme im Studiendesign

Das Bedürfnis nach Geltung

Die Epidemiologie zielt darauf ab, das Krankheitserleben in Bevölkerungen zu verstehen. Insbesondere kann es genutzt werden, um Einblicke in die beruflichen Ursachen von Erkrankungen zu erhalten. Dieses Wissen stammt aus Studien, die an Gruppen von Menschen mit einer Krankheit durchgeführt wurden, indem sie mit Menschen ohne diese Krankheit verglichen wurden. Ein weiterer Ansatz besteht darin, zu untersuchen, welche Krankheiten Menschen bekommen, die in bestimmten Berufen mit besonderen Belastungen arbeiten, und diese Krankheitsbilder mit denen von nicht ähnlich exponierten Personen zu vergleichen. Diese Studien liefern Schätzungen des Krankheitsrisikos für bestimmte Expositionen. Damit Informationen aus solchen Studien zur Erstellung von Präventionsprogrammen, zur Anerkennung von Berufskrankheiten und zur angemessenen Entschädigung der von Expositionen betroffenen Arbeitnehmer verwendet werden können, müssen diese Studien valide sein.

Gültigkeit kann als die Fähigkeit einer Studie definiert werden, den wahren Sachverhalt widerzuspiegeln. Eine gültige Studie ist daher eine Studie, die den Zusammenhang (entweder positiv, negativ oder nicht vorhanden) zwischen einer Exposition und einer Krankheit korrekt misst. Sie beschreibt Richtung und Ausmaß eines echten Risikos. Es werden zwei Arten von Validität unterschieden: interne und externe Validität. Interne Validität ist die Fähigkeit einer Studie, das widerzuspiegeln, was wirklich unter den Studienteilnehmern passiert ist; Die externe Validität spiegelt wider, was in der Bevölkerung passieren könnte.

Validität bezieht sich auf die Wahrhaftigkeit einer Messung. Validität ist von der Genauigkeit der Messung zu unterscheiden, die von der Größe der Studie und der Effizienz des Studiendesigns abhängt.

Interne Gültigkeit

Eine Studie gilt als intern valide, wenn sie frei von Verzerrungen ist und somit den bei den Studienteilnehmern bestehenden Zusammenhang zwischen Exposition und Krankheit wirklich widerspiegelt. Ein beobachtetes Krankheitsrisiko im Zusammenhang mit einer Exposition kann zwar aus einem realen Zusammenhang resultieren und daher valide sein, aber es kann auch den Einfluss von Vorurteilen widerspiegeln. Eine Voreingenommenheit wird ein verzerrtes Bild der Realität geben.

Drei Haupttypen von Vorurteilen, auch genannt systematische Fehler, werden normalerweise unterschieden:

- Auswahlbias

- Informations- oder Beobachtungsverzerrung

- verwirrend

Sie werden im Folgenden anhand von Beispielen aus dem arbeitsmedizinischen Umfeld kurz vorgestellt.

Selektionsvorspannung

Ein Selektionsbias tritt auf, wenn der Eintritt in die Studie durch die Kenntnis des Expositionsstatus des potenziellen Studienteilnehmers beeinflusst wird. Dieses Problem tritt daher nur dann auf, wenn die Krankheit zum Zeitpunkt (bevor) die Person in die Studie aufgenommen wurde, bereits aufgetreten ist. Im epidemiologischen Umfeld geschieht dies typischerweise in Fall-Kontroll-Studien oder in retrospektiven Kohortenstudien. Dies bedeutet, dass eine Person eher als Fall betrachtet wird, wenn bekannt ist, dass sie exponiert war. Drei Umstände können zu einem solchen Ereignis führen, das auch von der Schwere der Krankheit abhängt.

Selbstselektionsverzerrung

Dies kann vorkommen, wenn Personen, die wissen, dass sie in der Vergangenheit bekannten oder vermuteten schädlichen Produkten ausgesetzt waren, und die überzeugt sind, dass ihre Krankheit das Ergebnis der Exposition ist, einen Arzt wegen Symptomen konsultieren, die andere Personen, die nicht so exponiert waren, möglicherweise ignoriert haben. Dies ist besonders wahrscheinlich bei Krankheiten, die nur wenige auffällige Symptome aufweisen. Ein Beispiel kann ein früher Schwangerschaftsverlust oder eine spontane Abtreibung bei weiblichen Krankenschwestern sein, die mit Arzneimitteln zur Krebsbehandlung umgehen. Diese Frauen sind sich der Fortpflanzungsphysiologie bewusster als die meisten anderen und, da sie sich Sorgen um ihre Fähigkeit machen, Kinder zu bekommen, erkennen oder etikettieren sie möglicherweise eher als spontane Abtreibung, was andere Frauen nur als Verzögerung des Beginns der Menstruation betrachten würden. Ein weiteres Beispiel aus einer retrospektiven Kohortenstudie, zitiert von Rothman (1986), betrifft eine Studie des Centers for Disease Control über Leukämie unter Truppen, die bei einem US-Atomtest in Nevada anwesend waren. Von den auf dem Testgelände anwesenden Truppen wurden 76 % aufgespürt und bildeten die Kohorte. Davon wurden 82 % von den Ermittlern gefunden, aber weitere 18 % kontaktierten die Ermittler selbst, nachdem sie von der Öffentlichkeit über die Studie gehört hatten. Vier Fälle von Leukämie waren unter den 82 % vorhanden, die von CDC verfolgt wurden, und vier Fälle waren unter den selbst überwiesenen 18 % vorhanden. Dies deutet stark darauf hin, dass die Fähigkeit der Ermittler, exponierte Personen zu identifizieren, mit dem Leukämie-Risiko zusammenhängt.

Diagnostische Verzerrung

Dies wird der Fall sein, wenn die Ärzte eine bestimmte Krankheit eher diagnostizieren, wenn sie wissen, was der Patient zuvor ausgesetzt war. Als beispielsweise die meisten Farben bleihaltig waren, war ein Symptom einer Erkrankung der peripheren Nerven, das als periphere Neuritis mit Lähmung bezeichnet wird, auch als „Handgelenkstropfen“ der Maler bekannt. Die Kenntnis des Berufs des Patienten erleichterte bereits im Frühstadium die Diagnose der Erkrankung, während bei Studienteilnehmern ohne bekannte berufliche Bleibelastung die Identifizierung des Erregers deutlich erschwert wäre.

Bias aufgrund der Weigerung, an einer Studie teilzunehmen

Wenn Menschen, ob gesund oder krank, gebeten werden, an einer Studie teilzunehmen, spielen mehrere Faktoren eine Rolle, ob sie zustimmen oder nicht. Die Bereitschaft, unterschiedlich lange Fragebögen zu beantworten, die manchmal nach heiklen Themen fragen, und noch mehr, Blut oder andere biologische Proben abzugeben, kann vom Grad des Eigeninteresses der Person bestimmt werden. Jemand, der sich der früheren möglichen Exposition bewusst ist, ist möglicherweise bereit, dieser Anfrage nachzukommen, in der Hoffnung, dass sie dabei hilft, die Ursache der Krankheit zu finden, während jemand der Meinung ist, dass er nichts Gefährlichem ausgesetzt war, oder der nicht interessiert ist wissen, können die Einladung zur Teilnahme an der Studie ablehnen. Dies kann zu einer Auswahl der Personen führen, die letztendlich Studienteilnehmer sein werden, im Vergleich zu allen, die es hätten sein können.

Informationsverzerrung

Dies wird auch als Beobachtungsverzerrung bezeichnet und betrifft den Krankheitsverlauf in Folgestudien und die Expositionsbeurteilung in Fall-Kontroll-Studien.

Differenzielle Ergebnisbewertung in prospektiven Folgestudien (Kohortenstudien).

Zu Beginn der Studie werden zwei Gruppen definiert: eine exponierte Gruppe und eine nicht exponierte Gruppe. Probleme der diagnostischen Verzerrung entstehen, wenn die Suche nach Fällen zwischen diesen beiden Gruppen unterschiedlich ist. Stellen Sie sich zum Beispiel eine Kohorte von Personen vor, die einer versehentlichen Freisetzung von Dioxin in einer bestimmten Branche ausgesetzt sind. Für die hochexponierte Gruppe wird ein aktives Nachsorgesystem mit regelmäßigen ärztlichen Untersuchungen und biologischem Monitoring eingerichtet, während der Rest der Erwerbsbevölkerung nur routinemäßig betreut wird. Es ist sehr wahrscheinlich, dass in der eng überwachten Gruppe mehr Krankheiten identifiziert werden, was zu einer potenziellen Überschätzung des Risikos führen würde.

Differenzielle Verluste in retrospektiven Kohortenstudien

In retrospektiven Kohortenstudien kann der umgekehrte Mechanismus zu dem im vorhergehenden Absatz beschriebenen auftreten. Die übliche Vorgehensweise bei diesen Studien ist, mit den Akten aller Personen zu beginnen, die in der Vergangenheit in einer bestimmten Branche beschäftigt waren, und Krankheit oder Sterblichkeit nach der Beschäftigung zu bewerten. Leider sind in fast allen Studien die Akten unvollständig, und die Tatsache, dass eine Person vermisst wird, kann entweder mit dem Expositionsstatus oder dem Krankheitsstatus oder mit beidem zusammenhängen. Beispielsweise wurden in einer kürzlich in der chemischen Industrie durchgeführten Studie bei Arbeitern, die aromatischen Aminen ausgesetzt waren, acht Tumore in einer Gruppe von 777 Arbeitern gefunden, die einem zytologischen Screening auf Harntumoren unterzogen worden waren. Insgesamt wurden nur 34 Datensätze als fehlend befunden, was einem Verlust von 4.4 % in der Expositionsbewertungsdatei entspricht, aber bei Blasenkrebsfällen fehlten Expositionsdaten für zwei von acht Fällen oder 25 %. Dies zeigt, dass die Akten von Personen, die zu Fällen wurden, mit größerer Wahrscheinlichkeit verloren gingen als die Akten anderer Mitarbeiter. Dies kann durch häufigere Stellenwechsel innerhalb des Unternehmens (die mit Expositionseffekten verbunden sein können), Kündigung, Entlassung oder reinen Zufall geschehen.

Differenzielle Bewertung der Exposition in Fall-Kontroll-Studien

Bei Fall-Kontroll-Studien ist die Erkrankung bei Studienbeginn bereits aufgetreten und es werden Informationen zu früheren Expositionen abgefragt. Voreingenommenheit kann entweder aus der Einstellung des Interviewers oder des Studienteilnehmers zur Untersuchung resultieren. Die Informationen werden normalerweise von geschulten Interviewern gesammelt, die sich der Hypothese, die der Forschung zugrunde liegt, bewusst sein können oder auch nicht. In einer bevölkerungsbezogenen Fall-Kontroll-Studie zu Blasenkrebs beispielsweise, die in einer hochindustrialisierten Region durchgeführt wurde, ist sich das Studienpersonal möglicherweise der Tatsache bewusst, dass bestimmte Chemikalien, wie beispielsweise aromatische Amine, Risikofaktoren für Blasenkrebs sind. Wenn sie auch wissen, wer die Krankheit entwickelt hat und wer nicht, können sie mit den Teilnehmern, die an Blasenkrebs erkrankt sind, wahrscheinlich eingehendere Interviews führen als mit den Kontrollen. Sie bestehen möglicherweise auf detaillierteren Informationen über frühere Berufe und suchen systematisch nach der Exposition gegenüber aromatischen Aminen, während sie für Kontrollen die Berufe eher routinemäßig erfassen. Die resultierende Vorspannung wird als bekannt Expositionsverdacht voreingenommen.

Auch die Teilnehmer selbst können für eine solche Voreingenommenheit verantwortlich sein. Das nennt man Voreingenommenheit erinnern um es von der Voreingenommenheit des Interviewers zu unterscheiden. Beide haben den Expositionsverdacht als Mechanismus für die Voreingenommenheit. Erkrankte Personen können einen beruflichen Ursprung ihrer Krankheit vermuten und werden daher versuchen, sich so genau wie möglich an alle gefährlichen Stoffe zu erinnern, denen sie möglicherweise ausgesetzt waren. Beim Umgang mit undefinierten Produkten neigen sie möglicherweise dazu, sich an die Namen konkreter Chemikalien zu erinnern, insbesondere wenn ihnen eine Liste verdächtiger Produkte zur Verfügung gestellt wird. Im Gegensatz dazu durchlaufen Kontrollen mit geringerer Wahrscheinlichkeit denselben Denkprozess.

Verwirrend

Confounding liegt vor, wenn der beobachtete Zusammenhang zwischen Exposition und Krankheit teilweise das Ergebnis einer Vermischung der Wirkung der untersuchten Exposition und eines anderen Faktors ist. Nehmen wir zum Beispiel an, dass wir bei Schweißern ein erhöhtes Lungenkrebsrisiko feststellen. Wir sind versucht, sofort zu schließen, dass es einen kausalen Zusammenhang zwischen der Exposition gegenüber Schweißrauch und Lungenkrebs gibt. Wir wissen aber auch, dass Rauchen der mit Abstand wichtigste Risikofaktor für Lungenkrebs ist. Wenn Informationen verfügbar sind, beginnen wir daher damit, den Raucherstatus von Schweißern und anderen Studienteilnehmern zu überprüfen. Wir können feststellen, dass Schweißer eher rauchen als Nicht-Schweißer. In dieser Situation ist bekannt, dass das Rauchen mit Lungenkrebs in Verbindung gebracht wird, und gleichzeitig wurde in unserer Studie festgestellt, dass das Rauchen auch mit dem Beruf des Schweißers in Verbindung gebracht wird. In epidemiologischer Hinsicht bedeutet dies, dass Rauchen, das sowohl mit Lungenkrebs als auch mit Schweißen in Verbindung gebracht wird, den Zusammenhang zwischen Schweißen und Lungenkrebs verfälscht.

Interaktions- oder Effektmodifikation

Im Gegensatz zu allen oben aufgeführten Aspekten, nämlich Selektion, Information und Confounding, die Verzerrungen darstellen, ist Interaktion keine Verzerrung aufgrund von Problemen im Studiendesign oder in der Analyse, sondern spiegelt die Realität und ihre Komplexität wider. Ein Beispiel für dieses Phänomen ist das folgende: Die Belastung durch Radon ist ein Risikofaktor für Lungenkrebs, ebenso wie das Rauchen. Darüber hinaus haben Rauchen und Radonexposition unterschiedliche Auswirkungen auf das Lungenkrebsrisiko, je nachdem, ob sie zusammen oder isoliert wirken. Die meisten Berufsstudien zu diesem Thema wurden unter Untertagebergleuten durchgeführt und haben teilweise widersprüchliche Ergebnisse geliefert. Insgesamt scheint es Argumente für eine Wechselwirkung von Rauchen und Radonexposition bei der Entstehung von Lungenkrebs zu geben. Das bedeutet, dass das Lungenkrebsrisiko durch Radonexposition auch bei Nichtrauchern erhöht wird, aber dass die Risikoerhöhung durch Radon bei Rauchern viel größer ist als bei Nichtrauchern. Epidemiologisch sprechen wir von einer multiplikativen Wirkung. Im Gegensatz zum oben beschriebenen Confounding muss die Interaktion sorgfältig analysiert und in der Analyse beschrieben und nicht einfach kontrolliert werden, da sie das widerspiegelt, was auf biologischer Ebene passiert, und nicht nur eine Folge eines schlechten Studiendesigns ist. Seine Erklärung führt zu einer valideren Interpretation der Ergebnisse einer Studie.

Externe Validität

Dieses Problem kann erst behoben werden, nachdem sichergestellt wurde, dass die interne Gültigkeit gesichert ist. Wenn wir davon überzeugt sind, dass die in der Studie beobachteten Ergebnisse reale Assoziationen widerspiegeln, können wir uns fragen, ob wir diese Ergebnisse auf die größere Population, aus der die Studienteilnehmer selbst gezogen wurden, oder sogar auf andere identische Populationen extrapolieren können oder zumindest sehr ähnlich. Die häufigste Frage ist, ob die für Männer erzielten Ergebnisse auch für Frauen gelten. Studien und insbesondere berufsepidemiologische Untersuchungen werden seit Jahren ausschließlich bei Männern durchgeführt. Studien unter Chemikern, die in den 1960er und 1970er Jahren in den Vereinigten Staaten, dem Vereinigten Königreich und Schweden durchgeführt wurden, ergaben alle ein erhöhtes Risiko für bestimmte Krebsarten – nämlich Leukämie, Lymphome und Bauchspeicheldrüsenkrebs. Aus dem, was wir über die Wirkungen der Exposition gegenüber Lösungsmitteln und einigen anderen Chemikalien wussten, hätten wir damals schon ableiten können, dass die Laborarbeit auch ein krebserzeugendes Risiko für Frauen mit sich bringt. Dies zeigte sich tatsächlich, als Mitte der 1980er Jahre schließlich die erste Studie unter Chemikerinnen veröffentlicht wurde, die ähnliche Ergebnisse wie bei Männern ergab. Es ist erwähnenswert, dass es sich bei anderen gefundenen übermäßigen Krebsarten um Tumore der Brust und der Eierstöcke handelte, die traditionell nur mit endogenen Faktoren oder der Fortpflanzung in Verbindung gebracht wurden, bei denen jedoch neu vermutete Umweltfaktoren wie Pestizide eine Rolle spielen könnten. Zu den berufsbedingten Determinanten von Krebserkrankungen bei Frauen muss noch viel mehr Arbeit geleistet werden.

Strategien für ein valides Studium

Eine vollkommen gültige Studie kann es nie geben, aber es obliegt dem Forscher, so viele Verzerrungen wie möglich zu vermeiden oder zumindest zu minimieren. Dies kann oft am besten in der Phase des Studiendesigns erfolgen, kann aber auch während der Analyse durchgeführt werden.

Studiendesign

Auswahl- und Informationsverzerrung können nur durch das sorgfältige Design einer epidemiologischen Studie und die sorgfältige Umsetzung aller sich daraus ergebenden täglichen Richtlinien, einschließlich der sorgfältigen Beachtung der Qualitätssicherung, für die Durchführung der Studie unter Feldbedingungen vermieden werden. Confounding kann entweder in der Entwurfs- oder in der Analysephase behandelt werden.

Auswahl

Kriterien für die Berücksichtigung eines Teilnehmers als Fall müssen explizit definiert werden. Man kann oder sollte zumindest nicht versuchen, schlecht definierte klinische Zustände zu untersuchen. Eine Möglichkeit zur Minimierung der Auswirkungen, die die Kenntnis der Exposition auf die Krankheitsbewertung haben kann, besteht darin, nur schwere Fälle einzubeziehen, die unabhängig von Informationen zur Krankengeschichte des Patienten diagnostiziert worden wären. Im Bereich Krebs werden Studien oft auf Fälle mit histologischem Nachweis der Erkrankung beschränkt, um den Einschluss von Borderline-Läsionen zu vermeiden. Dies bedeutet auch, dass die untersuchten Gruppen gut definiert sind. Beispielsweise ist in der Krebsepidemiologie wohlbekannt, dass Krebsarten verschiedener histologischer Typen innerhalb eines gegebenen Organs unterschiedliche Risikofaktoren haben können. Bei ausreichender Fallzahl ist es besser, das Adenokarzinom der Lunge vom Plattenepithelkarzinom der Lunge zu trennen. Was auch immer die endgültigen Kriterien für die Aufnahme in die Studie sein mögen, sie sollten immer klar definiert und beschrieben werden. Beispielsweise sollte der genaue Code der Krankheit anhand der Internationalen Klassifikation der Krankheiten (ICD) und bei Krebs auch der Internationalen Klassifikation der Krankheiten – Onkologie (ICD-O) angegeben werden.

Sobald die Kriterien festgelegt sind, sollten Anstrengungen unternommen werden, um die Teilnahme an der Studie zu maximieren. Die Entscheidung, eine Teilnahme abzulehnen, wird kaum zufällig getroffen und führt daher zu Voreingenommenheit. Studien sollten zunächst den Klinikern vorgestellt werden, die die Patienten behandeln. Ihre Zustimmung ist erforderlich, um Patienten anzusprechen, und daher müssen sie davon überzeugt werden, die Studie zu unterstützen. Ein oft überzeugendes Argument ist, dass die Studie im Interesse der öffentlichen Gesundheit ist. In diesem Stadium ist es jedoch besser, die genaue zu bewertende Hypothese nicht zu diskutieren, um eine übermäßige Beeinflussung der beteiligten Kliniker zu vermeiden. Ärzte sollten nicht aufgefordert werden, Nebentätigkeiten zu übernehmen; Es ist einfacher, medizinisches Personal davon zu überzeugen, eine Studie zu unterstützen, wenn von den Prüfärzten Mittel bereitgestellt werden, um alle zusätzlichen Aufgaben durchzuführen, die über die Routineversorgung hinausgehen und durch die Studie erforderlich sind. Interviewer und Datenextraktoren sollten den Krankheitsstatus ihrer Patienten nicht kennen.

Ähnliche Aufmerksamkeit sollte den Informationen geschenkt werden, die den Teilnehmern zur Verfügung gestellt werden. Das Ziel der Studie muss breit und neutral beschrieben werden, aber auch überzeugend und überzeugend sein. Es ist wichtig, dass Fragen der Vertraulichkeit und von Interesse für die öffentliche Gesundheit vollständig verstanden werden, während medizinischer Fachjargon vermieden wird. In den meisten Situationen wird der Einsatz von finanziellen oder anderen Anreizen nicht als angemessen erachtet, obwohl eine Entschädigung für alle Kosten bereitgestellt werden sollte, die einem Teilnehmer möglicherweise entstehen. Nicht zuletzt sollte die allgemeine Bevölkerung über ausreichende wissenschaftliche Kenntnisse verfügen, um die Bedeutung solcher Forschung zu verstehen. Sowohl die Vorteile als auch die Risiken der Teilnahme müssen jedem potenziellen Teilnehmer erklärt werden, wenn er Fragebögen ausfüllen und/oder biologische Proben zur Aufbewahrung und/oder Analyse bereitstellen muss. Es sollte kein Zwang angewendet werden, um eine vorherige und vollständig informierte Zustimmung zu erhalten. Bei Studien, die ausschließlich auf Aufzeichnungen basieren, muss die vorherige Zustimmung der für die Wahrung der Vertraulichkeit dieser Aufzeichnungen zuständigen Stellen eingeholt werden. In diesen Fällen kann in der Regel auf die Zustimmung der einzelnen Teilnehmer verzichtet werden. Stattdessen reicht die Zustimmung von Gewerkschafts- und Regierungsbeamten aus. Epidemiologische Untersuchungen bedrohen nicht das Privatleben des Einzelnen, sondern sind ein potenzielles Hilfsmittel zur Verbesserung der Gesundheit der Bevölkerung. Vor der Durchführung einer Studie ist die Zustimmung eines institutionellen Prüfungsausschusses (oder Ethikprüfungsausschusses) erforderlich, und vieles von dem, was oben gesagt wurde, wird von ihm für seine Überprüfung erwartet.

Informationen

In prospektiven Folgestudien müssen die Mittel zur Beurteilung des Krankheits- oder Mortalitätsstatus für exponierte und nicht exponierte Teilnehmer identisch sein. Insbesondere sollte nicht auf unterschiedliche Quellen zurückgegriffen werden, wie z. B. nur die Abfrage in einem zentralen Mortalitätsregister für nicht exponierte Teilnehmer und die Nutzung einer intensiven aktiven Überwachung für exponierte Teilnehmer. Ebenso muss die Todesursache auf streng vergleichbare Weise ermittelt werden. Das bedeutet, wenn ein System verwendet wird, um Zugang zu offiziellen Dokumenten für die nicht exponierte Bevölkerung, die oft die allgemeine Bevölkerung ist, zu erhalten, sollte man niemals planen, noch genauere Informationen durch Krankenakten oder Interviews über die Teilnehmer selbst oder ihre Familien zu erhalten die exponierte Untergruppe.

In retrospektiven Kohortenstudien sollten Anstrengungen unternommen werden, um festzustellen, wie genau die untersuchte Population mit der interessierenden Population verglichen wird. Man sollte sich vor möglichen unterschiedlichen Verlusten in exponierten und nicht exponierten Gruppen hüten, indem man verschiedene Quellen zur Zusammensetzung der Bevölkerung verwendet. Beispielsweise kann es sinnvoll sein, Gehaltslisten mit Gewerkschaftsmitgliedslisten oder anderen Berufsverzeichnissen zu vergleichen. Diskrepanzen müssen ausgeglichen werden, und das für die Studie angenommene Protokoll muss genau befolgt werden.

In Fall-Kontroll-Studien gibt es andere Optionen, um Verzerrungen zu vermeiden. Interviewer, Studienpersonal und Studienteilnehmer müssen sich der genauen zu untersuchenden Hypothese nicht bewusst sein. Wenn sie die getestete Assoziation nicht kennen, ist es weniger wahrscheinlich, dass sie versuchen, die erwartete Antwort zu geben. Das Studienpersonal über die Forschungshypothese im Dunkeln zu lassen, ist tatsächlich oft sehr unpraktisch. Der Interviewer kennt fast immer die Expositionen mit dem größten potenziellen Interesse sowie wer ein Fall und wer eine Kontrolle ist. Wir müssen uns daher auf ihre Ehrlichkeit und auch auf ihre Ausbildung in Grundlagenforschungsmethodik verlassen, die Teil ihres beruflichen Hintergrunds sein sollte; Objektivität ist das Markenzeichen auf allen Stufen der Wissenschaft.

Es ist einfacher, die Studienteilnehmer nicht über den genauen Forschungsgegenstand zu informieren. Gute, grundlegende Erläuterungen zur Notwendigkeit der Erhebung von Daten für ein besseres Verständnis von Gesundheit und Krankheit sind in der Regel ausreichend und genügen den Anforderungen einer Ethikprüfung.

Verwirrend

Confounding ist die einzige Verzerrung, die entweder in der Phase des Studiendesigns oder, sofern angemessene Informationen verfügbar sind, in der Analysephase behandelt werden kann. Wenn zum Beispiel das Alter als potenzieller Confounder der interessierenden Assoziation angesehen wird, weil das Alter mit dem Krankheitsrisiko (d. h. Krebs wird im höheren Alter häufiger) und auch mit der Exposition (Expositionsbedingungen variieren mit dem Alter oder mit altersbedingten Faktoren wie Qualifikation, berufliche Position und Beschäftigungsdauer) gibt es mehrere Lösungsansätze. Am einfachsten ist es, die Studie auf einen bestimmten Altersbereich zu begrenzen – nehmen Sie beispielsweise nur kaukasische Männer im Alter von 40 bis 50 Jahren auf. Dies liefert Elemente für eine einfache Analyse, hat aber auch den Nachteil, dass die Anwendung der Ergebnisse auf einen einzelnen beschränkt wird Geschlecht Alter/Rassengruppe. Eine andere Lösung ist das Matching nach Alter. Das bedeutet, dass für jeden Fall ein gleichaltriger Referent benötigt wird. Dies ist eine attraktive Idee, aber man muss die mögliche Schwierigkeit berücksichtigen, diese Anforderung zu erfüllen, wenn die Anzahl der passenden Faktoren zunimmt. Darüber hinaus wird es nach der Zuordnung eines Faktors unmöglich, seine Rolle beim Auftreten von Krankheiten zu bewerten. Die letzte Lösung besteht darin, genügend Informationen über potenzielle Confounder in der Studiendatenbank zu haben, um sie in der Analyse zu überprüfen. Dies kann entweder durch eine einfache stratifizierte Analyse oder mit ausgefeilteren Tools wie der multivariaten Analyse erfolgen. Es sollte jedoch daran erinnert werden, dass eine Analyse niemals in der Lage sein wird, eine schlecht konzipierte oder durchgeführte Studie zu kompensieren.

Fazit

Das Potenzial für Verzerrungen in der epidemiologischen Forschung ist seit langem bekannt. Dies war kein allzu großes Problem, wenn die untersuchten Assoziationen stark waren (wie dies bei Rauchen und Lungenkrebs der Fall ist) und daher einige Ungenauigkeiten kein allzu schwerwiegendes Problem verursachten. Jetzt, da es an der Zeit ist, schwächere Risikofaktoren zu bewerten, wird der Bedarf an besseren Instrumenten von größter Bedeutung. Dazu gehört die Notwendigkeit exzellenter Studiendesigns und die Möglichkeit, die Vorteile verschiedener traditioneller Designs wie Fall-Kontroll- oder Kohortenstudien mit innovativeren Ansätzen wie in einer Kohorte verschachtelten Fall-Kontroll-Studien zu kombinieren. Außerdem kann die Verwendung von Biomarkern die Möglichkeit bieten, genauere Einschätzungen aktueller und möglicherweise früherer Expositionen sowie für die frühen Krankheitsstadien zu erhalten.

Müdigkeit und Erholung

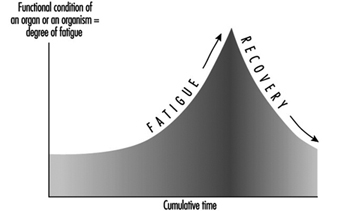

Ermüdung und Erholung sind periodische Prozesse in jedem lebenden Organismus. Fatigue kann als ein Zustand beschrieben werden, der durch ein Ermüdungsgefühl verbunden mit einer Verringerung oder ungewollten Schwankung der Leistungsfähigkeit gekennzeichnet ist (Rohmert 1973).

Nicht alle Funktionen des menschlichen Organismus ermüden durch den Gebrauch. Auch im Schlaf atmen wir zum Beispiel und unser Herz pumpt ohne Pause. Offensichtlich sind die Grundfunktionen Atmung und Herztätigkeit lebenslang ohne Ermüdung und ohne Erholungspausen möglich.

Andererseits stellen wir nach längerer schwerer Arbeit fest, dass die Kapazität nachlässt – was wir nennen Müdigkeit. Dies gilt nicht nur für die Muskelaktivität. Auch die Sinnesorgane oder die Nervenzentren ermüden. Es ist jedoch das Ziel jeder Zelle, die durch ihre Aktivität verlorene Kapazität auszugleichen, ein Prozess, den wir nennen Erholung.

Stress, Belastung, Ermüdung und Erholung

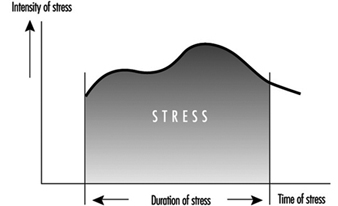

Die Begriffe Ermüdung und Erholung bei der menschlichen Arbeit sind eng verwandt mit den ergonomischen Begriffen Belastung und Belastung (Rohmert 1984) (Abbildung 1).

Abbildung 1. Stress, Belastung und Ermüdung

Stress bedeutet die Summe aller Arbeitsparameter im Arbeitssystem, die den Menschen bei der Arbeit beeinflussen, die hauptsächlich über das Rezeptorsystem wahrgenommen oder empfunden werden oder die das Effektorsystem beanspruchen. Die Belastungsparameter ergeben sich aus der Arbeitsaufgabe (muskuläre Arbeit, nichtmuskuläre Arbeit – aufgabenorientierte Dimensionen und Faktoren) und aus den physikalischen, chemischen und sozialen Bedingungen, unter denen die Arbeit zu verrichten ist (Lärm, Klima, Beleuchtung, Vibration). , Schichtarbeit etc. – situationsbezogene Dimensionen und Faktoren).

Die Intensität/Schwierigkeit, die Dauer und die Zusammensetzung (dh die gleichzeitige und sukzessive Verteilung dieser spezifischen Anforderungen) der Belastungsfaktoren ergibt eine kombinierte Belastung, die alle exogenen Wirkungen eines Arbeitssystems auf den arbeitenden Menschen ausüben. Diese kombinierte Belastung kann je nach Verhalten der arbeitenden Person aktiv bewältigt oder passiv hingenommen werden. Der aktive Fall beinhaltet Aktivitäten, die auf die Effizienz des Arbeitssystems gerichtet sind, während der passive Fall Reaktionen hervorruft (freiwillig oder unfreiwillig), die hauptsächlich mit der Minimierung von Stress verbunden sind. Das Verhältnis von Belastung und Aktivität wird entscheidend von den individuellen Eigenschaften und Bedürfnissen der arbeitenden Person beeinflusst. Haupteinflussfaktoren sind die leistungsbestimmenden Faktoren der Motivation und Konzentration sowie die der Disposition, die als Fähigkeiten und Fertigkeiten bezeichnet werden können.

Die verhaltensrelevanten Belastungen, die sich bei bestimmten Tätigkeiten manifestieren, verursachen individuell unterschiedliche Belastungen. Die Belastungen können durch die Reaktion physiologischer oder biochemischer Indikatoren (z. B. Erhöhung der Herzfrequenz) angezeigt oder wahrgenommen werden. Damit sind die Belastungen anfällig für eine „psycho-physische Skalierung“, die das Belastungserleben der arbeitenden Person abschätzt. In einem verhaltensorientierten Ansatz kann das Vorliegen einer Belastung auch aus einer Aktivitätsanalyse abgeleitet werden. Die Intensität, mit der Belastungsindikatoren (physiologisch-biochemische, behavioristische oder psychophysische) reagieren, hängt von der Intensität, Dauer und Kombination von Belastungsfaktoren sowie von den individuellen Eigenschaften, Fähigkeiten, Fertigkeiten und Bedürfnissen der arbeitenden Person ab.

Trotz ständiger Belastungen können sich die aus den Tätigkeitsfeldern, Leistungen und Belastungen abgeleiteten Kennzahlen im Laufe der Zeit verändern (zeitlicher Effekt). Solche zeitlichen Schwankungen sind als Anpassungsprozesse der organischen Systeme zu interpretieren. Die positiven Wirkungen bewirken eine Verringerung der Belastung/Verbesserung der Aktivität oder Leistungsfähigkeit (z. B. durch Training). Im negativen Fall führen sie jedoch zu einer erhöhten Belastung/reduzierten Aktivität oder Leistungsfähigkeit (z. B. Müdigkeit, Monotonie).

Die positiven Effekte können zum Tragen kommen, wenn die vorhandenen Fähigkeiten und Fertigkeiten im Arbeitsprozess selbst verbessert werden, z. B. beim leichten Überschreiten der Trainingsreizschwelle. Die negativen Auswirkungen treten wahrscheinlich auf, wenn im Laufe des Arbeitsprozesses sogenannte Belastungsgrenzen (Rohmert 1984) überschritten werden. Diese Ermüdung führt zu einer Verringerung der physiologischen und psychischen Funktionen, die durch Erholung kompensiert werden können.

Zur Wiederherstellung der ursprünglichen Leistungsfähigkeit sind Ruhepausen oder zumindest Zeiten geringerer Belastung notwendig (Luczak 1993).

Wenn der Anpassungsprozess über definierte Schwellen hinausgeführt wird, kann das eingesetzte organische System geschädigt werden, so dass es zu einem teilweisen oder vollständigen Ausfall seiner Funktionen kommt. Eine irreversible Funktionseinschränkung kann auftreten, wenn die Belastung viel zu hoch ist (Akutschaden) oder wenn die Erholung längere Zeit nicht möglich ist (chronischer Schaden). Ein typisches Beispiel für einen solchen Schaden ist der lärmbedingte Hörverlust.

Modelle der Ermüdung

Ermüdung kann je nach Belastungsform und Belastungskombination vielfältig sein und lässt sich noch nicht allgemein definieren. Die biologischen Ermüdungsvorgänge sind im Allgemeinen nicht direkt messbar, so dass sich die Definitionen hauptsächlich an den Ermüdungssymptomen orientieren. Diese Ermüdungserscheinungen lassen sich beispielsweise in die folgenden drei Kategorien einteilen.

- Physiologische Symptome: Müdigkeit wird als Abnahme der Funktionen von Organen oder des gesamten Organismus interpretiert. Es kommt zu physiologischen Reaktionen, zB zu einer Erhöhung der Herzfrequenz oder der elektrischen Muskelaktivität (Laurig 1970).

- Verhaltenssymptome: Ermüdung wird hauptsächlich als Abnahme der Leistungsparameter interpretiert. Beispiele sind zunehmende Fehler beim Lösen bestimmter Aufgaben oder eine zunehmende Variabilität der Leistung.

- Psycho-körperliche Symptome: Ermüdung wird je nach Intensität, Dauer und Zusammensetzung der Belastungsfaktoren als Zunahme des Anstrengungsgefühls und Verschlechterung des Empfindungsvermögens interpretiert.

Im Prozess der Erschöpfung können alle drei Symptome eine Rolle spielen, sie können jedoch zu unterschiedlichen Zeitpunkten auftreten.

Physiologische Reaktionen in organischen Systemen, insbesondere denen, die an der Arbeit beteiligt sind, können zuerst auftreten. Später kann das Anstrengungsgefühl beeinträchtigt werden. Leistungsveränderungen äußern sich im Allgemeinen in einer abnehmenden Regelmäßigkeit der Arbeit oder in einer zunehmenden Fehlermenge, wobei der Mittelwert der Leistung noch nicht betroffen sein darf. Im Gegenteil, der Berufstätige kann bei entsprechender Motivation sogar versuchen, die Leistungsfähigkeit willentlich aufrechtzuerhalten. Der nächste Schritt kann eine deutliche Leistungsminderung bis hin zum Leistungseinbruch sein. Die physiologischen Symptome können zu einem Zusammenbruch des Organismus einschließlich Veränderungen der Persönlichkeitsstruktur und zu Erschöpfung führen. Der Prozess der Ermüdung wird in der Theorie der sukzessiven Destabilisierung erklärt (Luczak 1983).

Der Haupttrend von Ermüdung und Erholung ist in Abbildung 2 dargestellt.

Abbildung 2. Haupttrend von Ermüdung und Erholung

Prognose von Ermüdung und Erholung

Auf dem Gebiet der Ergonomie besteht ein besonderes Interesse daran, die Ermüdung in Abhängigkeit von Intensität, Dauer und Zusammensetzung von Belastungsfaktoren vorherzusagen und die notwendige Erholungszeit zu bestimmen. Tabelle 1 zeigt diese unterschiedlichen Aktivitätsniveaus und Betrachtungszeiten sowie mögliche Gründe für Ermüdung und unterschiedliche Erholungsmöglichkeiten.

Tabelle 1. Ermüdung und Erholung in Abhängigkeit vom Aktivitätsniveau

|

Aktivitätsgrad |

Zeitraum |

Müdigkeit ab |

Erholung durch |

|

Arbeitsleben |

Jahrzehntelange |

Überanstrengung für |

Ruhestand |

|

Phasen des Berufslebens |

Jahre |

Überanstrengung für |

Feiertage |

|

Folgen von |

Monate/Wochen |

Ungünstige Verschiebung |

Wochenende, frei |

|

Eine Arbeitsschicht |

Eines Tages |

Stress oben |

Freizeit, Ruhe |

|

Aufträge |

Stunden |

Stress oben |

Ruhezeit |

|

Teil einer Aufgabe |

Minuten |

Stress oben |

Stresswechsel |

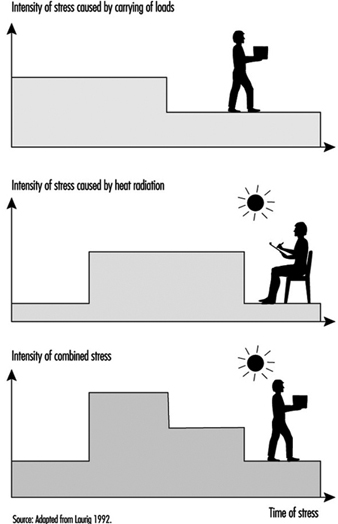

Bei der ergonomischen Analyse von Belastung und Ermüdung zur Bestimmung der notwendigen Erholungszeit ist die Betrachtung der Dauer eines Arbeitstages am wichtigsten. Die Methoden solcher Analysen beginnen mit der Bestimmung der verschiedenen Belastungsfaktoren als Funktion der Zeit (Laurig 1992) (Abbildung 3).

Abbildung 3. Stress als Funktion der Zeit

Die Belastungsfaktoren werden aus den konkreten Arbeitsinhalten und den Arbeitsbedingungen bestimmt. Arbeitsinhalte können die Krafterzeugung (z. B. beim Handhaben von Lasten), die Koordination motorischer und sensorischer Funktionen (z. B. beim Montieren oder Kranfahren), das Umsetzen von Informationen in Reaktion (z. B. beim Steuern), die Transformationen von Eingaben sein zur Ausgabe von Informationen (z. B. beim Programmieren, Übersetzen) und zum Produzieren von Informationen (z. B. beim Entwerfen, Problemlösen). Die Arbeitsbedingungen beinhalten physikalische (z. B. Lärm, Vibration, Hitze), chemische (chemische Arbeitsstoffe) und soziale (z. B. Kollegen, Schichtarbeit) Aspekte.

Im einfachsten Fall gibt es einen einzigen wichtigen Stressfaktor, während die anderen vernachlässigt werden können. In diesen Fällen, insbesondere wenn die Belastungsfaktoren aus muskulärer Arbeit resultieren, ist es oft möglich, die notwendigen Ruhezeiten zu berechnen, da die Grundbegriffe bekannt sind.

Beispielsweise hängt die ausreichende Ruhezugabe bei statischer Muskelarbeit von der Kraft und Dauer der Muskelkontraktion ab wie in einer durch Multiplikation verknüpften Exponentialfunktion nach der Formel:

![]()

mit

RA = Ruhegeld in Prozent von t

t = Kontraktionsdauer (Einwirkzeit) in Minuten

T = maximal mögliche Kontraktionsdauer in Minuten

f = die für die statische Kraft benötigte Kraft und

F = maximale Kraft.

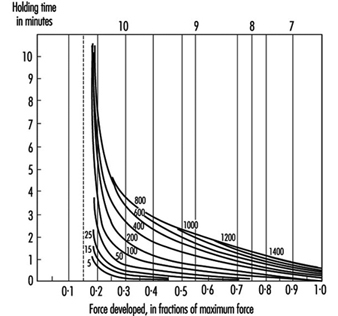

Der Zusammenhang zwischen Kraft, Haltezeit und Ruhezuschlägen ist in Bild 4 dargestellt.

Abbildung 4. Prozentuale Restzugaben für verschiedene Kombinationen von Haltekräften und Zeit

Ähnliche Gesetze existieren für schwere dynamische Muskelarbeit (Rohmert 1962), aktive leichte Muskelarbeit (Laurig 1974) oder andere industrielle Muskelarbeit (Schmidtke 1971). Seltener findet man vergleichbare Gesetze für nichtkörperliche Arbeit, zB für das Rechnen (Schmidtke 1965). Einen Überblick über bestehende Methoden zur Bestimmung der Ruhezulagen für überwiegend isolierte Muskel- und Nicht-Muskelarbeit geben Laurig (1981) und Luczak (1982).

Schwieriger ist die Situation, wenn eine Kombination verschiedener Belastungsfaktoren vorliegt, wie in Abbildung 5 dargestellt, die gleichzeitig auf den arbeitenden Menschen einwirken (Laurig 1992).

Abbildung 5. Die Kombination zweier Stressfaktoren

So kann beispielsweise die Kombination zweier Belastungsfaktoren je nach Kombinationsgesetz zu unterschiedlichen Dehnungsreaktionen führen. Die kombinierte Wirkung verschiedener Stressfaktoren kann indifferent, kompensatorisch oder kumulativ sein.

Bei indifferenten Kombinationsgesetzen wirken die unterschiedlichen Stressfaktoren auf unterschiedliche Teilsysteme des Organismus. Jedes dieser Subsysteme kann die Dehnung kompensieren, ohne dass die Dehnung in ein gemeinsames Subsystem eingespeist wird. Die Gesamtdehnung hängt vom höchsten Stressfaktor ab, und somit werden keine Superpositionsgesetze benötigt.

Eine kompensatorische Wirkung liegt vor, wenn die Kombination verschiedener Belastungsfaktoren zu einer geringeren Belastung führt als jeder Belastungsfaktor allein. Durch die Kombination von Muskelarbeit und niedrigen Temperaturen kann die Gesamtbelastung reduziert werden, da bei niedrigen Temperaturen die durch die Muskelarbeit entstehende Wärme aus dem Körper abgeführt werden kann.

Ein kumulativer Effekt entsteht, wenn sich mehrere Stressfaktoren überlagern, also einen physiologischen „Flaschenhals“ passieren müssen. Ein Beispiel ist die Kombination von Muskelarbeit und Hitzebelastung. Beide Stressfaktoren wirken als gemeinsamer Flaschenhals auf das Kreislaufsystem mit resultierender kumulativer Belastung.

Mögliche Kombinationseffekte zwischen Muskelarbeit und körperlichen Bedingungen sind bei Bruder (1993) beschrieben (siehe Tabelle 2).

Tabelle 2. Regeln der Kombinationswirkung zweier Stressfaktoren auf die Dehnung

|

Kälte |

Vibration |

Beleuchtung |

Lärm |

|

|

Schwere dynamische Arbeit |

- |

+ |

0 |

0 |

|

Aktive leichte Muskelarbeit |

+ |

+ |

0 |

0 |

|

Statische Muskelarbeit |

+ |

+ |

0 |

0 |

0 gleichgültiger Effekt; + kumulativer Effekt; – Ausgleichswirkung.

Quelle: Adaptiert von Bruder 1993.

Für den in der Praxis üblichen Fall der Kombination von mehr als zwei Belastungsfaktoren liegen nur begrenzte wissenschaftliche Erkenntnisse vor. Gleiches gilt für die sukzessive Kombination von Belastungsfaktoren (dh die Belastungswirkung verschiedener Belastungsfaktoren, die nacheinander auf den Arbeitnehmer einwirken). Für solche Fälle wird in der Praxis die notwendige Erholungszeit bestimmt, indem physiologische oder psychologische Parameter gemessen und als integrierende Werte verwendet werden.

Einfluss zufälliger Messfehler

Fehler bei der Expositionsmessung können je nach Verteilung der Fehler unterschiedliche Auswirkungen auf die untersuchte Expositions-Krankheits-Beziehung haben. Wenn eine epidemiologische Studie blind durchgeführt wurde (dh Messungen wurden ohne Kenntnis des Krankheits- oder Gesundheitszustands der Studienteilnehmer durchgeführt), erwarten wir, dass der Messfehler gleichmäßig über die Schichten des Krankheits- oder Gesundheitszustands verteilt wird.

Tabelle 1 zeigt ein Beispiel: Angenommen, wir rekrutieren eine Kohorte von Personen, die bei der Arbeit einem Giftstoff ausgesetzt sind, um eine häufige Krankheit zu untersuchen. Den Expositionsstatus ermitteln wir erst bei der Rekrutierung (T0) und nicht zu weiteren Zeitpunkten der Nachbeobachtung. Nehmen wir jedoch an, dass eine Reihe von Personen tatsächlich ihren Expositionsstatus im folgenden Jahr ändern: Zum Zeitpunkt T1, sind 250 der ursprünglich 1,200 exponierten Personen nicht mehr exponiert, während 150 der ursprünglich 750 nicht exponierten Personen begonnen haben, dem Giftstoff ausgesetzt zu sein. Also zum Zeitpunkt T1, 1,100 Personen sind exponiert und 850 nicht exponiert. Infolgedessen haben wir eine „Fehlklassifizierung“ der Exposition basierend auf unserer anfänglichen Messung des Expositionsstatus zum Zeitpunkt T0. Diese Personen werden dann nach 20 Jahren (zum Zeitpunkt T2) und das kumulative Krankheitsrisiko bewertet. (Im Beispiel wird davon ausgegangen, dass nur eine Exposition von mehr als einem Jahr Anlass zur Sorge gibt.)

Tabelle 1. Hypothetische Kohorte von 1950 Personen (exponiert und nicht exponiert bei der Arbeit), rekrutiert zum Zeitpunkt T0 und dessen Krankheitsstatus zum Zeitpunkt T festgestellt wird2

|

Uhrzeit |

|||

|

T0 |

T1 |

T2 |

|

Exponierte Arbeiter 1200 250 Beenden der Exposition 1100 (1200-250+150)

Krankheitsfälle zum Zeitpunkt T2 = 220 unter exponierten Arbeitern

Nicht exponierte Arbeiter 750 150 Beginn der Exposition 850 (750-150+250)

Krankheitsfälle zum Zeitpunkt T2 = 85 bei nicht exponierten Arbeitern

Das wahres Risiko der Krankheit zum Zeitpunkt T2 beträgt 20 % bei exponierten Arbeitnehmern (220/1100),

und 10 % bei nicht exponierten Arbeitnehmern (85/850) (Risikoverhältnis = 2.0).

Geschätztes Risiko bei T2 der Krankheit unter denen, die als T. exponiert eingestuft wurden0: 20 %

(dh wahres Risiko bei den Exponierten) ´ 950 (dh 1200-250) + 10 %

(dh wahres Risiko bei Nichtexposition) ´ 250 = (190+25)/1200 = 17.9 %

Geschätztes Risiko bei T2 der Krankheit unter denen, die als nicht exponiert eingestuft sind

T0: 20 % (dh wahres Risiko bei den Exponierten) × 150 +10 %

(d. h. wahres Risiko ohne Exposition) × 600 (d. h. 750-150) = (30+60)/750 = 12 %

Geschätztes Risikoverhältnis = 17.9 % / 12 % = 1.49

Die Fehlklassifizierung hängt in diesem Beispiel eher vom Studiendesign und den Merkmalen der Bevölkerung ab als von technischen Beschränkungen der Expositionsmessung. Die Fehlklassifizierung bewirkt, dass das „wahre“ Verhältnis von 2.0 zwischen dem kumulativen Risiko bei exponierten Personen und nicht exponierten Personen zu einem „beobachteten“ Verhältnis von 1.49 wird (Tabelle 1). Diese Unterschätzung des Risikoverhältnisses ergibt sich aus einer „Verwischung“ der Beziehung zwischen Exposition und Krankheit, die auftritt, wenn die Fehlklassifizierung der Exposition, wie in diesem Fall, gleichmäßig nach Krankheit oder Gesundheitszustand verteilt wird (d. h. die Expositionsmessung ist nicht davon beeinflusst, ob die Person an der von uns untersuchten Krankheit litt oder nicht).

Im Gegensatz dazu kann es entweder zu einer Unter- oder Überschätzung des Zusammenhangs von Interesse kommen, wenn die Fehlklassifizierung der Exposition nicht gleichmäßig über das Ergebnis von Interesse verteilt ist. In dem Beispiel haben wir vielleicht vorspannen, und nicht nur eine Verwischung des ätiologischen Zusammenhangs, wenn die Einstufung der Exposition von der Krankheit oder dem Gesundheitszustand der Arbeitnehmer abhängt. Dies könnte beispielsweise eintreten, wenn wir beschließen, biologische Proben von einer Gruppe exponierter Arbeiter und von einer Gruppe nicht exponierter Arbeiter zu sammeln, um frühzeitige Veränderungen im Zusammenhang mit der Exposition bei der Arbeit zu erkennen. Proben von exponierten Arbeitern könnten dann genauer analysiert werden als Proben von nicht exponierten; wissenschaftliche Neugier könnte den Forscher dazu veranlassen, zusätzliche Biomarker bei den exponierten Personen zu messen (einschließlich z. B. DNA-Addukte in Lymphozyten oder Urinmarker für oxidative DNA-Schäden), in der Annahme, dass diese Personen wissenschaftlich „interessanter“ sind. Dies ist eine weit verbreitete Einstellung, die jedoch zu ernsthaften Vorurteilen führen kann.

Statistische Methoden

Über die Rolle der Statistik in der epidemiologischen Forschung zu kausalen Zusammenhängen wird viel diskutiert. In der Epidemiologie ist Statistik in erster Linie eine Sammlung von Methoden zur Bewertung von Daten auf der Grundlage von menschlichen (und auch tierischen) Populationen. Statistik ist insbesondere eine Technik zur Quantifizierung und Messung unsicherer Phänomene. Alle wissenschaftlichen Untersuchungen, die sich mit nichtdeterministischen, variablen Aspekten der Realität befassen, könnten von der statistischen Methodik profitieren. In der Epidemiologie ist Variabilität der Beobachtungseinheit inhärent – eine Person ist keine deterministische Einheit. Während experimentelle Designs dahingehend verbessert werden würden, dass sie die Annahmen der Statistik in Bezug auf zufällige Variationen besser erfüllen, ist dieser Ansatz aus ethischen und praktischen Gründen nicht allzu verbreitet. Stattdessen beschäftigt sich die Epidemiologie mit Beobachtungsforschung, die sowohl zufällige als auch andere Quellen der Variabilität mit sich bringt.

Die statistische Theorie befasst sich damit, wie unstrukturierte Variabilität in den Daten kontrolliert werden kann, um gültige Schlussfolgerungen aus empirischen Beobachtungen zu ziehen. In Ermangelung einer Erklärung für das variable Verhalten des untersuchten Phänomens nimmt die Statistik dies an zufällig– das heißt, nicht-systematische Abweichungen von einem durchschnittlichen Naturzustand (siehe Greenland 1990 für eine Kritik dieser Annahmen).

Wissenschaft stützt sich auf Empirie Beweis um zu zeigen, ob seine theoretischen Modelle von Naturereignissen Gültigkeit haben. Tatsächlich bestimmen die Methoden der statistischen Theorie, inwieweit Beobachtungen in der realen Welt mit der Sicht der Wissenschaftler auf ein Phänomen in mathematischer Modellform übereinstimmen. Statistische Methoden, die auf Mathematik basieren, müssen daher sorgfältig ausgewählt werden; Es gibt viele Beispiele zum Thema „Wie man mit Statistiken lügt“. Epidemiologen sollten sich daher der Angemessenheit der Techniken bewusst sein, die sie anwenden, um das Krankheitsrisiko zu messen. Insbesondere bei der Interpretation sowohl statistisch signifikanter als auch statistisch nicht signifikanter Ergebnisse ist große Sorgfalt geboten.