Kinder Kategorien

27. Biologische Überwachung (6)

27. Biologische Überwachung

Kapitelherausgeber: Robert Lauwerys

Inhaltsverzeichnis

Tabellen und Abbildungen

Allgemeine Grundsätze

Vito Foà und Lorenzo Alessio

Qualitätssicherung

D. Gompertz

Metalle und metallorganische Verbindungen

P. Hoet und Robert Lauwerys

Organische Lösungsmittel

Masayuki Ikeda

Genotoxische Chemikalien

Marja Sorsa

Pestizide

Marco Maroni und Adalberto Ferioli

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. ACGIH, DFG & andere Grenzwerte für Metalle

2. Beispiele für Chemikalien- und biologisches Monitoring

3. Biologische Überwachung auf organische Lösungsmittel

4. Genotoxizität von Chemikalien, bewertet von IARC

5. Biomarker und einige Zell-/Gewebeproben und Genotoxizität

6. Menschliche Karzinogene, berufliche Exposition und zytogenetische Endpunkte

8. Exposition durch Produktion und Verwendung von Pestiziden

9. Akute OP-Toxizität bei verschiedenen Graden der ACHE-Hemmung

10 Variationen von ACHE & PCHE & ausgewählten Gesundheitszuständen

11 Cholinesterase-Aktivitäten von nicht exponierten gesunden Menschen

12 Alkylphosphate im Urin und OP-Pestizide

13 Alkylphosphatmessungen im Urin & OP

14 Carbamat-Metaboliten im Urin

15 Dithiocarbamat-Metaboliten im Urin

16 Vorgeschlagene Indizes für die biologische Überwachung von Pestiziden

17 Empfohlene biologische Grenzwerte (Stand 1996)

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

28. Epidemiologie und Statistik (12)

28. Epidemiologie und Statistik

Kapitel-Editoren: Franco Merletti, Colin L. Soskolne und Paolo Vineis

Inhaltsverzeichnis

Tabellen und Abbildungen

Epidemiologische Methode für Arbeitssicherheit und Gesundheitsschutz

Franco Merletti, Colin L. Soskolne und Paolo Vineis

Expositionsbewertung

M. Gerald Ott

Zusammenfassung der Expositionsmaßnahmen im Arbeitsleben

Colin L. Soskolne

Messung der Auswirkungen von Expositionen

Shelia Hoar Zahm

Fallbeispiel: Maßnahmen

Franco Merletti, Colin L. Soskolne und Paola Vineis

Optionen im Studiendesign

Sven Herberg

Validitätsprobleme im Studiendesign

Annie J. Sasco

Einfluss zufälliger Messfehler

Paolo Vineis und Colin L. Soskolne

Statistische Methoden

Annibale Biggeri und Mario Braga

Kausalitätsbewertung und Ethik in der epidemiologischen Forschung

Paolo Vineis

Fallstudien zur Veranschaulichung methodischer Probleme bei der Überwachung von Berufskrankheiten

Jung-Der Wang

Fragebögen in der epidemiologischen Forschung

Steven D. Stellman und Colin L. Soskolne

Asbest Historische Perspektive

Laurent Garfinkel

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. Fünf ausgewählte zusammenfassende Maßnahmen zur Exposition im Berufsleben

2. Maße für das Auftreten von Krankheiten

3. Assoziationsmaße für eine Kohortenstudie

4. Assoziationsmaße für Fall-Kontroll-Studien

5. Allgemeines Häufigkeitstabellenlayout für Kohortendaten

6. Musterlayout von Fallkontrolldaten

7. Layout-Fallkontrolldaten – eine Kontrolle pro Fall

8. Hypothetische Kohorte von 1950 Individuen zu T2

9. Indizes der zentralen Tendenz und Streuung

10 Ein binomiales Experiment & Wahrscheinlichkeiten

11 Mögliche Ergebnisse eines binomialen Experiments

12 Binomialverteilung, 15 Erfolge/30 Versuche

13 Binomialverteilung, p = 0.25; 30 Versuche

14 Fehler XNUMX. Art & Leistung; x = 12, n = 30, a = 0.05

15 Fehler XNUMX. Art & Leistung; x = 12, n = 40, a = 0.05

16 632 Arbeitnehmer, die 20 Jahre oder länger Asbest ausgesetzt waren

17 O/E Zahl der Todesfälle unter 632 Asbestarbeitern

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

29. Ergonomie (27)

29. Ergonomie

Kapitel-Editoren: Wolfgang Laurig und Joachim Vedder

Inhaltsverzeichnis

Tabellen und Abbildungen

Überblick

Wolfgang Laurig und Joachim Vedder

Ziele, Prinzipien und Methoden

Wesen und Ziele der Ergonomie

William T. Singleton

Analyse von Aktivitäten, Aufgaben und Arbeitssystemen

Véronique De Keyser

Ergonomie und Standardisierung

Friedhelm Nachreiner

Prüflisten

Pranab Kumar Nag

Physikalische und physiologische Aspekte

Anthropometrie

Melchiorre Masali

Muskelarbeit

Juhani Smolander und Veikko Louhevaara

Körperhaltungen bei der Arbeit

Ilkka Kurinka

Biomechanik

Frank Darby

Allgemeine Müdigkeit

Etienne Grandjean

Müdigkeit und Erholung

Rolf Helbig und Walter Rohmert

Psychologische Aspekte

Geistige Arbeitsbelastung

Winfried Hacker

Wachsamkeit

Herbert Heuer

Geistige Müdigkeit

Peter Richter

Organisatorische Aspekte der Arbeit

Arbeitsorganisation

Eberhard Ulich und Gudela Grote

Schlafentzug

Kazutaka Kogi

Gestaltung von Arbeitssystemen

Workstations

Roland Kadefors

Tools

TM Fraser

Bedienelemente, Anzeigen und Bedienfelder

Karl HE Kroemer

Informationsverarbeitung und Design

Andries F. Sanders

Designen für alle

Entwerfen für bestimmte Gruppen

Witz H. Grady-van den Nieuwboer

Fallstudie: Die internationale Klassifikation der Funktionseinschränkung beim Menschen

Kulturelle Unterschiede

Houshang Shahnavaz

Ältere Arbeitnehmer

Antoine Laville und Serge Volkoff

Arbeitnehmer mit besonderen Bedürfnissen

Witz H. Grady-van den Nieuwboer

Vielfalt und Bedeutung der Ergonomie – zwei Beispiele

Systemdesign in der Diamantherstellung

Issachar Gilad

Missachtung ergonomischer Gestaltungsprinzipien: Tschernobyl

Wladimir M. Munipov

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. Grundlegende anthropometrische Kernliste

2. Ermüdung und Erholung abhängig vom Aktivitätsniveau

3. Regeln der Kombinationswirkung zweier Stressfaktoren auf die Belastung

4. Es wird zwischen mehreren negativen Folgen psychischer Belastung unterschieden

5. Arbeitsorientierte Prinzipien zur Produktionsgestaltung

6. Partizipation im organisatorischen Kontext

7. Benutzerbeteiligung am Technologieprozess

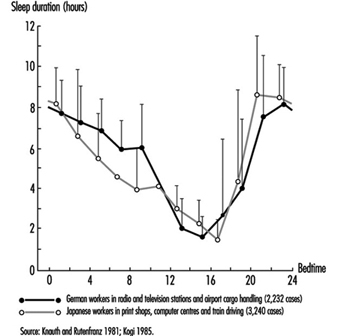

8. Unregelmäßige Arbeitszeiten und Schlafentzug

9. Aspekte von Früh-, Anker- und Verzögerungsschlaf

10 Kontrollieren Sie Bewegungen und erwartete Effekte

11 Steuerungs-Wirkungs-Beziehungen gängiger Handsteuerungen

12 Regeln für die Anordnung von Kontrollen

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

30. Arbeitshygiene (6)

30. Arbeitshygiene

Kapitel-Editor: Robert F. Herrick

Inhaltsverzeichnis

Tabellen und Abbildungen

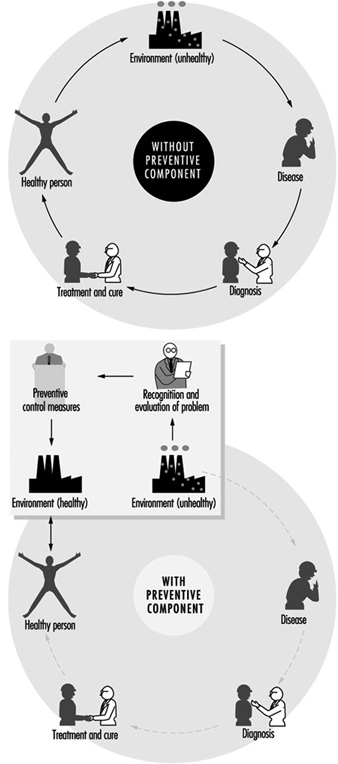

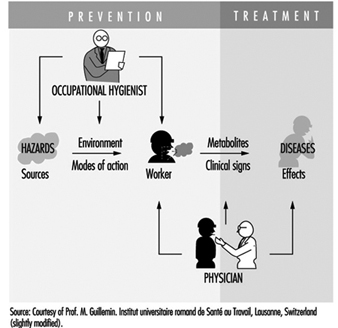

Ziele, Definitionen und allgemeine Informationen

Berenice I. Ferrari Goelzer

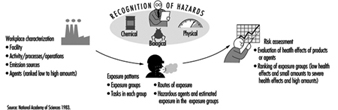

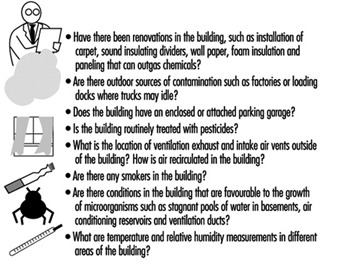

Gefahren erkennen

Linnea Lillienberg

Bewertung der Arbeitsumgebung

Lori A. Todd

Arbeitshygiene: Expositionskontrolle durch Intervention

James Stewart

Die biologische Grundlage für die Expositionsbewertung

Dick Heederik

Arbeitsplatzgrenzwerte

Dennis J. Pausenbach

Tische

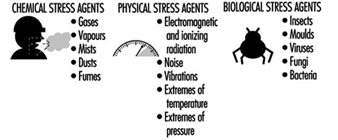

1. Gefahren durch Chemikalien; biologische und physikalische Wirkstoffe

2. Arbeitsplatzgrenzwerte (OELs) – verschiedene Länder

Zahlen

31. Personenschutz (7)

31. Persönlicher Schutz

Kapitel-Editor: Robert F. Herrick

Inhaltsverzeichnis

Tabellen und Abbildungen

Überblick und Philosophie des Personenschutzes

Robert F. Herrick

Augen- und Gesichtsschutz

Kikuzi Kimura

Fuß- und Beinschutz

Toyohiko Miura

Kopfschutz

Isabelle Balty und Alain Mayer

Gehörschutz

John R. Franks und Elliott H. Berger

Schutzkleidung

S.Zack Mansdorf

Atemschutz

Thomas J. Nelson

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. Transmissionsanforderungen (ISO 4850-1979)

2. Schutzmaßstäbe - Gasschweißen & Lötschweißen

3. Schutzwaage - Sauerstoffschneiden

4. Schutzmaßstäbe - Plasmalichtbogenschneiden

5. Schutzwaagen - Lichtbogenschweißen oder Fugenhobeln

6. Schutzmaßstäbe - Plasma-Lichtbogen-Direktschweißen

7. Schutzhelm: ISO-Norm 3873-1977

8. Geräuschreduzierungsbewertung eines Gehörschutzes

9. Berechnung der A-bewerteten Rauschunterdrückung

10 Beispiele für Hautgefahrenkategorien

11 Physikalische, chemische und biologische Leistungsanforderungen

12 Sachgefahren im Zusammenhang mit bestimmten Tätigkeiten

13 Zugewiesene Schutzfaktoren aus ANSI Z88 2 (1992)

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

32. Aufzeichnungssysteme und Überwachung (9)

32. Aufzeichnungssysteme und Überwachung

Kapitel-Editor: Steven D. Stellman

Inhaltsverzeichnis

Tabellen und Abbildungen

Überwachungs- und Meldesysteme für Berufskrankheiten

Steven B. Markowitz

Überwachung von Arbeitsgefahren

David H. Wegman und Steven D. Stellman

Überwachung in Entwicklungsländern

David Koh und Kee-Seng Chia

Entwicklung und Anwendung eines Klassifizierungssystems für Arbeitsunfälle und Berufskrankheiten

Elyce Biddle

Risikoanalyse von nicht tödlichen Verletzungen und Krankheiten am Arbeitsplatz

John W. Ruser

Fallstudie: Arbeitnehmerschutz und Statistiken zu Unfällen und Berufskrankheiten - HVBG, Deutschland

Martin Butz und Burkhard Hoffmann

Fallstudie: Wismut – Eine Neuauflage der Uranexposition

Heinz Otten und Horst Schulz

Messstrategien und -techniken für die berufsbedingte Expositionsabschätzung in der Epidemiologie

Frank Bochmann und Helmut Blome

Fallstudie: Arbeitsmedizinische Erhebungen in China

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

1. Angiosarkom der Leber - Weltregister

2. Berufskrankheit, USA, 1986 versus 1992

3. US-Todesfälle durch Pneumokoniose und Pleuramesotheliom

4. Musterliste meldepflichtiger Berufskrankheiten

5. Codestruktur für die Meldung von Krankheiten und Verletzungen, USA

6. Nichttödliche Arbeitsunfälle und Berufskrankheiten, USA 1993

7. Risiko von Arbeitsunfällen und Berufskrankheiten

8. Relatives Risiko für sich wiederholende Bewegungszustände

9. Arbeitsunfälle, Deutschland, 1981-93

10 Schleifmaschinen bei Unfällen in der Metallverarbeitung, Deutschland, 1984-93

11 Berufskrankheit, Deutschland, 1980-93

12 Infektionskrankheiten, Deutschland, 1980-93

13 Strahlenbelastung in den Wismut-Bergwerken

14 Berufskrankheiten im Wismuter Uranbergwerk 1952-90

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

33. Toxikologie (21)

33. Toxikologie

Kapitelherausgeberin: Ellen K. Silbergeld

Inhaltsverzeichnis

Tabellen und Abbildungen

Einleitung

Ellen K. Silbergeld, Kapitelredakteurin

Allgemeine Prinzipien der Toxikologie

Definitionen und Konzepte

Bo Holmberg, Johan Hogberg und Gunnar Johanson

Toxikokinetik

Dušan Djuric

Zielorgan und kritische Wirkungen

Marek Jakubowski

Auswirkungen von Alter, Geschlecht und anderen Faktoren

Spomenka Telisman

Genetische Determinanten der toxischen Reaktion

Daniel W. Nebert und Ross A. McKinnon

Mechanismen der Toxizität

Einführung und Konzepte

Philip G. Watanabe

Zellschädigung und Zelltod

Benjamin F. Trump und Irene K. Berezesky

Genetische Toxikologie

R. Rita Misra und Michael P. Waalkes

Immuntoxikologie

Joseph G. Vos und Henk van Loveren

Zielorgan-Toxikologie

Ellen K. Silbergeld

Toxikologische Testmethoden

Biomarker

Philipp Grandjean

Bewertung der genetischen Toxizität

David M. DeMarini und James Huff

In-vitro-Toxizitätstest

Joanne Zürlo

Aktivitätsbeziehungen strukturieren

Ellen K. Silbergeld

Regulatorische Toxikologie

Toxikologie in der Gesundheits- und Sicherheitsverordnung

Ellen K. Silbergeld

Prinzipien der Gefahrenidentifizierung - Der japanische Ansatz

Masayuki Ikeda

Der Ansatz der Vereinigten Staaten zur Risikobewertung von reproduktionstoxischen und neurotoxischen Wirkstoffen

Ellen K. Silbergeld

Ansätze zur Gefahrenidentifizierung - IARC

Harri Vainio und Julian Wilbourn

Anhang – Gesamtbewertungen der Karzinogenität beim Menschen: IARC-Monographien, Bände 1–69 (836)

Karzinogen-Risikobewertung: Andere Ansätze

Cees A. van der Heijden

Tische

Klicken Sie unten auf einen Link, um die Tabelle im Artikelkontext anzuzeigen.

- Beispiele für kritische Organe und kritische Effekte

- Grundlegende Wirkungen möglicher Mehrfachwechselwirkungen von Metallen

- Hämoglobinaddukte bei Arbeitern, die Anilin und Acetanilid ausgesetzt waren

- Erbliche, krebsanfällige Erkrankungen und Defekte in der DNA-Reparatur

- Beispiele für Chemikalien, die in menschlichen Zellen genotoxisch wirken

- Klassifizierung von Tests für Immunmarker

- Beispiele für Biomarker der Exposition

- Vor- und Nachteile von Methoden zur Identifizierung von Krebsrisiken beim Menschen

- Vergleich von In-vitro-Systemen für Hepatotoxizitätsstudien

- Vergleich von SAR- und Testdaten: OECD/NTP-Analysen

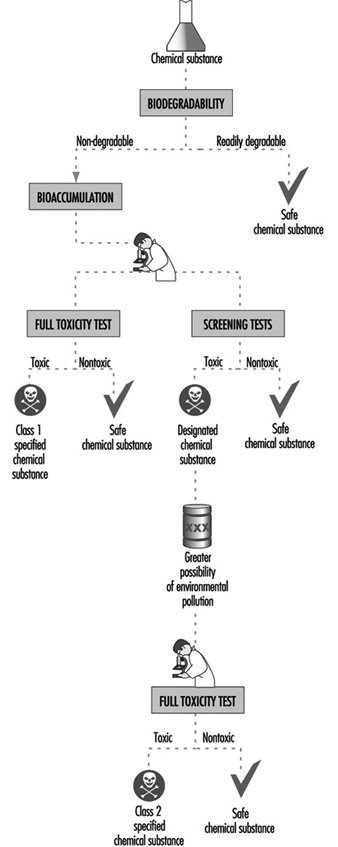

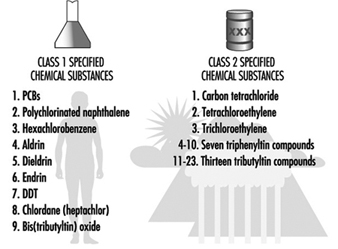

- Regulierung chemischer Stoffe durch Gesetze, Japan

- Prüfgegenstände gemäß dem Gesetz zur Kontrolle chemischer Substanzen, Japan

- Chemische Substanzen und das Gesetz zur Kontrolle chemischer Substanzen

- Ausgewählte größere Neurotoxizitätsvorfälle

- Beispiele für spezialisierte Tests zur Messung der Neurotoxizität

- Endpunkte in der Reproduktionstoxikologie

- Vergleich von Niedrigdosis-Extrapolationsverfahren

- Häufig zitierte Modelle zur Charakterisierung des Karzinogenrisikos

Zahlen

Zeigen Sie auf eine Miniaturansicht, um die Bildunterschrift anzuzeigen, klicken Sie, um die Abbildung im Artikelkontext anzuzeigen.

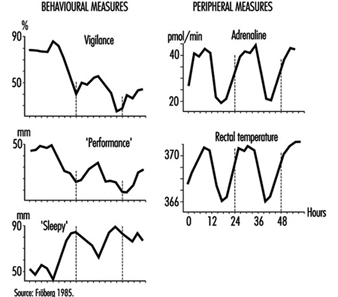

Geistige Müdigkeit

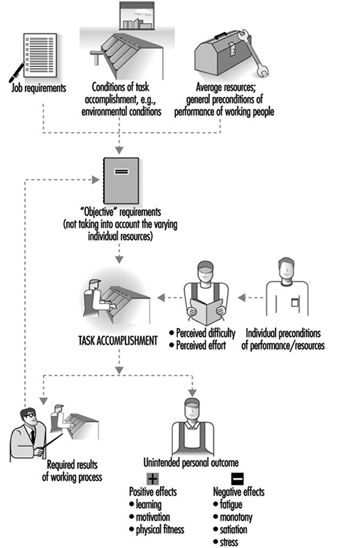

Psychische Belastungen sind eine normale Folge des Bewältigungsprozesses mit psychischer Arbeitsbelastung (MWL). Dauerbelastung oder hohe Arbeitsintensität können zu kurzfristigen Folgen von Über- (Müdigkeit) und Unterbelastung (Eintönigkeit, Sättigung) und zu langfristigen Folgen (z. B. Stresssymptome und arbeitsbedingte Erkrankungen) führen. Die Aufrechterhaltung der stabilen Handlungsregulation unter Belastung kann durch Veränderung des Handlungsstils (durch Variation von Informationsfindungs- und Entscheidungsstrategien), durch Absenkung des Leistungsbedarfs (durch Neudefinition von Aufgaben) realisiert werden und Abbau von Qualitätsstandards) und durch eine kompensatorische Steigerung der psychophysiologischen Belastung und anschließende Reduktion der Belastung während der Arbeitszeit.

Dieses Verständnis des Prozesses der psychischen Belastung kann als transaktionaler Prozess der Handlungsregulation bei der Auferlegung von Belastungsfaktoren konzeptualisiert werden, die neben den negativen Komponenten des Belastungsprozesses auch die positiven Aspekte des Lernens wie Akkretion, Tuning und Restrukturierung beinhalten Motivation (siehe Abbildung 2).

Abbildung 1. Bestandteile des Dehnungsprozesses und seine Folgen

Psychische Erschöpfung kann als ein Prozess der zeitreversiblen Abnahme der Verhaltensstabilität in Leistung, Stimmung und Aktivität nach längerer Arbeitszeit definiert werden. Dieser Zustand ist temporär reversibel durch Veränderung der Arbeitsanforderungen, der Umwelteinflüsse oder Reize und durch Schlaf vollständig reversibel.

Geistige Erschöpfung ist eine Folge der Ausführung von Aufgaben mit hohem Schwierigkeitsgrad, die überwiegend Informationsverarbeitung beinhalten und/oder von längerer Dauer sind. Im Gegensatz zur Monotonie, die Erholung der Dekremente ist zeitaufwändig und tritt nicht plötzlich nach sich ändernden Aufgabenbedingungen auf. Ermüdungserscheinungen werden auf mehreren Ebenen der Verhaltensregulation identifiziert: Fehlregulation in der biologischen Homöostase zwischen Umwelt und Organismus, Fehlregulation in den kognitiven Prozessen zielgerichteten Handelns und Stabilitätsverlust in zielgerichteter Motivation und Leistungsniveau.

Symptome geistiger Erschöpfung können in allen Subsystemen des menschlichen Informationsverarbeitungssystems identifiziert werden:

- Wahrnehmung: reduzierte Augenbewegungen, reduzierte Unterscheidung von Signalen, Schwellenverschlechterung

- Informationsverarbeitung: Verlängerung der Entscheidungszeit, Handlungsfehler, Entscheidungsunsicherheit, Blockaden, „Risikostrategien“ in Handlungsabläufen, Störungen der sensomotorischen Bewegungskoordination

- Gedächtnisfunktionen: Verlängerung von Informationen in Ultrakurzzeitspeichern, Störungen der Wiederholungsvorgänge im Kurzzeitgedächtnis, Verzögerung der Informationsübertragung im Langzeitgedächtnis und bei Gedächtnissuchvorgängen.

Differentialdiagnostik der psychischen Ermüdung

Zur Abgrenzung von psychischer Erschöpfung, Monotonie, psychischer Erschöpfung und Stress (im engeren Sinne) liegen genügend Kriterien vor (Tab. 1).

Tabelle 1. Differenzierung mehrerer negativer Folgen psychischer Belastung

|

Eigenschaften |

Geistige Müdigkeit |

Monotonie |

Sättigung |

Stress |

|

Wesentliche |

Schlechte Passform in Bezug auf Überlastung |

Schlechte Passform in Bezug auf |

Verlust des wahrgenommenen Sinns für Aufgaben |

Tore wahrgenommen |

|

Stimmung |

Müdigkeit ohne |

Müdigkeit mit |

Reizbarkeit |

Angst, Bedrohung |

|

Emotionen |

Neutral |

Neutral |

Erhöhte affektive Abneigung |

Erhöhte Angst |

|

Aktivierung |

Ständig |

Nicht durchgehend |

Mehr |

Mehr |

|

Recovery |

Zeitaufwendig |

Plötzlich nach Aufgabenwechsel |

? |

Langfristig |

|

abwehr |

Aufgabengestaltung, |

Bereicherung der Arbeitsinhalte |

Ziele setzen |

Arbeitsplatz neu gestalten, |

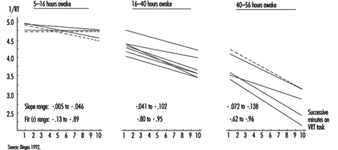

Grade der geistigen Ermüdung

Die gut beschriebene Phänomenologie der psychischen Ermüdung (Schmidtke 1965), viele gültige Erhebungsmethoden und die große Menge an experimentellen und Feldergebnissen bieten die Möglichkeit einer ordinalen Skalierung von Graden der psychischen Ermüdung (Hacker und Richter 1994). Die Skalierung basiert auf der Fähigkeit des Individuums, mit Verhaltensdekrementen fertig zu werden:

Niveau 1: Optimale und effiziente Leistung: keine Anzeichen von Leistungs-, Stimmungs- und Aktivierungsminderung.

Niveau 2: Vollständige Kompensation, gekennzeichnet durch erhöhte periphere psychophysiologische Aktivierung (z. B. gemessen durch Elektromyogramm der Fingermuskulatur), wahrgenommene Steigerung der mentalen Anstrengung, erhöhte Variabilität der Leistungskriterien.

Niveau 3: Labile Kompensation zusätzlich zu der in Stufe 2 beschriebenen: Handlungsfehler, wahrgenommene Müdigkeit, zunehmende (kompensatorische) psychophysiologische Aktivität in zentralen Indikatoren, Herzfrequenz, Blutdruck.

Niveau 4: Reduzierte Effizienz zusätzlich zu der in Stufe 3 beschriebenen: Abnahme der Leistungskriterien.

Niveau 5: Noch weitere Funktionsstörungen: Störungen in den sozialen Beziehungen und der Zusammenarbeit am Arbeitsplatz; Symptome klinischer Erschöpfung wie Verlust der Schlafqualität und vitale Erschöpfung.

Vorbeugung gegen geistige Ermüdung

Die Gestaltung von Aufgabenstrukturen, Umgebung, Ruhezeiten während der Arbeitszeit und ausreichend Schlaf sind die Mittel, um Symptome der psychischen Ermüdung zu reduzieren, damit keine klinischen Folgen auftreten:

1. Änderungen in der Aufgabenstruktur. Die Gestaltung von Voraussetzungen für eine adäquate Lern- und Aufgabenstrukturierung ist nicht nur ein Mittel, um die Entwicklung effizienter Arbeitsstrukturen voranzutreiben, sondern ist auch unerlässlich, um einer Fehlanpassung im Sinne einer psychischen Über- oder Unterforderung vorzubeugen:

- Die Lasten der Informationsverarbeitung können durch die Entwicklung effizienter interner Aufgabendarstellungen und der Organisation von Informationen entlastet werden. Die daraus resultierende Erweiterung der kognitiven Kapazität wird Informationsbedürfnisse und Ressourcen besser aufeinander abstimmen.

- Menschenzentrierte Technologien mit hoher Kompatibilität zwischen der Reihenfolge der präsentierten Informationen und der erforderlichen Aufgabe (Norman 1993) werden die für die Informationsumcodierung erforderliche mentale Anstrengung reduzieren und folglich Ermüdungs- und Stresssymptome lindern.

- Eine ausgewogene Koordination unterschiedlicher Regulierungsebenen (Fähigkeiten, Regeln und Wissen) kann den Aufwand reduzieren und darüber hinaus die menschliche Zuverlässigkeit erhöhen (Rasmussen 1983).

- Die Schulung von Mitarbeitern in zielgerichteten Aktionssequenzen vor tatsächlichen Problemen wird ihr Gefühl für geistige Anstrengung erleichtern, indem sie ihre Arbeit klarer, vorhersehbarer und offensichtlicher unter ihrer Kontrolle machen. Ihr psychophysiologisches Aktivierungsniveau wird effektiv reduziert.

2. Einführung von Systemen für Kurzzeitpausen während der Arbeit. Die positiven Auswirkungen solcher Pausen hängen von der Einhaltung einiger Voraussetzungen ab. Mehr kurze Pausen sind effizienter als weniger lange Pausen; Wirkungen hängen von einem festen und damit vorhersehbaren Zeitplan ab; und die Pauseninhalte sollten eine Ausgleichsfunktion zu den körperlichen und geistigen Arbeitsanforderungen haben.

3. Ausreichend Entspannung und Schlaf. Spezielle Mitarbeiter-Assistenz-Programme und Stressbewältigungstechniken können die Entspannungsfähigkeit unterstützen und der Entstehung chronischer Müdigkeit vorbeugen (Sethi, Caro und Schuler 1987).

In-vitro-Toxizitätstest

Das Aufkommen anspruchsvoller Technologien in der Molekular- und Zellbiologie hat eine relativ schnelle Entwicklung in den Biowissenschaften, einschließlich der Toxikologie, vorangetrieben. Tatsächlich verlagert sich der Fokus der Toxikologie von ganzen Tieren und Populationen ganzer Tiere auf die Zellen und Moleküle einzelner Tiere und Menschen. Seit Mitte der 1980er Jahre haben Toxikologen damit begonnen, diese neuen Methoden zur Bewertung der Auswirkungen von Chemikalien auf lebende Systeme einzusetzen. Als logische Weiterentwicklung werden solche Methoden für Zwecke der Toxizitätsprüfung angepasst. Diese wissenschaftlichen Fortschritte haben mit sozialen und wirtschaftlichen Faktoren zusammengearbeitet, um eine Änderung bei der Bewertung der Produktsicherheit und des potenziellen Risikos zu bewirken.

Wirtschaftliche Faktoren beziehen sich insbesondere auf die Menge der zu testenden Materialien. Jedes Jahr werden unzählige neue Kosmetika, Arzneimittel, Pestizide, Chemikalien und Haushaltsprodukte auf den Markt gebracht. Alle diese Produkte müssen auf ihre potenzielle Toxizität bewertet werden. Darüber hinaus gibt es einen Rückstand an Chemikalien, die bereits verwendet werden und nicht ausreichend getestet wurden. Die enorme Aufgabe, detaillierte Sicherheitsinformationen zu all diesen Chemikalien mit herkömmlichen Ganztierversuchsmethoden zu erhalten, wäre sowohl zeit- als auch kostenintensiv, wenn sie überhaupt bewältigt werden könnte.

Es gibt auch gesellschaftliche Probleme im Zusammenhang mit der öffentlichen Gesundheit und Sicherheit sowie die zunehmende Besorgnis der Öffentlichkeit über die Verwendung von Tieren für Produktsicherheitstests. Im Hinblick auf die menschliche Sicherheit haben Interessengruppen des öffentlichen Interesses und des Umweltschutzes erheblichen Druck auf Regierungsbehörden ausgeübt, strengere Vorschriften für Chemikalien anzuwenden. Ein aktuelles Beispiel dafür war eine Bewegung einiger Umweltgruppen, Chlor und chlorhaltige Verbindungen in den Vereinigten Staaten zu verbieten. Einer der Beweggründe für solch ein extremes Vorgehen liegt in der Tatsache, dass die meisten dieser Verbindungen nie ausreichend getestet wurden. Aus toxikologischer Sicht ist das Konzept, eine ganze Klasse verschiedener Chemikalien nur aufgrund des Vorhandenseins von Chlor zu verbieten, sowohl wissenschaftlich als auch unverantwortlich. Es ist jedoch verständlich, dass aus Sicht der Öffentlichkeit eine gewisse Sicherheit bestehen muss, dass in die Umwelt freigesetzte Chemikalien kein erhebliches Gesundheitsrisiko darstellen. Eine solche Situation unterstreicht die Notwendigkeit effizienterer und schnellerer Methoden zur Bewertung der Toxizität.

Das andere gesellschaftliche Anliegen, das sich auf den Bereich der Toxizitätstests ausgewirkt hat, ist der Tierschutz. Die wachsende Zahl von Tierschutzgruppen auf der ganzen Welt hat erheblichen Widerstand gegen die Verwendung ganzer Tiere für Produktsicherheitstests geäußert. Es wurden aktive Kampagnen gegen Hersteller von Kosmetika, Haushalts- und Körperpflegeprodukten und Arzneimitteln geführt, um Tierversuche zu stoppen. Diese Bemühungen in Europa haben zur Verabschiedung der Sechsten Änderung der Richtlinie 76/768/EWG (Kosmetikrichtlinie) geführt. Die Folge dieser Richtlinie ist, dass kosmetische Mittel oder kosmetische Inhaltsstoffe, die nach dem 1. Januar 1998 an Tieren getestet wurden, nicht in der Europäischen Union vermarktet werden dürfen, es sei denn, alternative Methoden sind unzureichend validiert. Obwohl diese Richtlinie keine Zuständigkeit für den Verkauf solcher Produkte in den Vereinigten Staaten oder anderen Ländern hat, wird sie Unternehmen mit internationalen Märkten, einschließlich Europa, erheblich beeinträchtigen.

Das Konzept der Alternativen, das die Grundlage für die Entwicklung von anderen Tests als denen an ganzen Tieren bildet, wird von den dreien definiert Rs: Reduktion in der Anzahl der verwendeten Tiere; Raffinesse von Protokollen, damit die Tiere weniger Stress oder Unbehagen erfahren; und Ersatz von aktuellen Tierversuchen mit In-vitro-Tests (dh Tests, die außerhalb des lebenden Tieres durchgeführt werden), Computermodellen oder Tests an niederen Wirbeltieren oder wirbellosen Arten. Die Drei Rs wurden in einem Buch vorgestellt, das 1959 von zwei britischen Wissenschaftlern, WMS Russell und Rex Burch, veröffentlicht wurde. Die Prinzipien der humanen experimentellen Technik. Russell und Burch behaupteten, dass der einzige Weg, auf dem gültige wissenschaftliche Ergebnisse erzielt werden könnten, die humane Behandlung von Tieren sei, und waren der Ansicht, dass Methoden entwickelt werden sollten, um die Verwendung von Tieren zu reduzieren und sie letztendlich zu ersetzen. Interessanterweise fanden die von Russell und Burch umrissenen Prinzipien bis zum Wiederaufleben der Tierschutzbewegung Mitte der 1970er Jahre wenig Beachtung. Heute das Konzept der Drei Rs ist in Bezug auf Forschung, Erprobung und Ausbildung ganz vorne mit dabei.

Zusammenfassend lässt sich sagen, dass die Entwicklung von In-vitro-Testmethoden von einer Vielzahl von Faktoren beeinflusst wurde, die in den letzten zehn bis 20 Jahren zusammengekommen sind. Es ist schwer festzustellen, ob einer dieser Faktoren allein eine so tiefgreifende Wirkung auf die Toxizitätsteststrategien gehabt hätte.

Konzept der In-vitro-Toxizitätstests

Dieser Abschnitt konzentriert sich ausschließlich auf In-vitro-Methoden zur Bewertung der Toxizität als eine der Alternativen zu Ganztierversuchen. Weitere nicht-tierische Alternativen wie Computermodellierung und quantitative Struktur-Wirkungs-Beziehungen werden in anderen Artikeln dieses Kapitels diskutiert.

In-vitro-Studien werden im Allgemeinen in tierischen oder menschlichen Zellen oder Geweben außerhalb des Körpers durchgeführt. In vitro bedeutet wörtlich „in Glas“ und bezieht sich auf Verfahren, die an lebendem Material oder Bestandteilen von lebendem Material durchgeführt werden, das in Petrischalen oder in Reagenzgläsern unter definierten Bedingungen kultiviert wird. Diese können In-vivo-Studien oder Studien, die „am lebenden Tier“ durchgeführt werden, gegenübergestellt werden. Während es schwierig, wenn nicht sogar unmöglich ist, die Auswirkungen einer Chemikalie auf einen komplexen Organismus zu prognostizieren, wenn die Beobachtungen auf einen einzigen Zelltyp in einer Schale beschränkt sind, liefern In-vitro-Studien auch eine beträchtliche Menge an Informationen über die intrinsische Toxizität als zelluläre und molekulare Toxizitätsmechanismen. Darüber hinaus bieten sie viele Vorteile gegenüber In-vivo-Studien, da sie im Allgemeinen kostengünstiger sind und unter besser kontrollierten Bedingungen durchgeführt werden können. Darüber hinaus können diese Methoden trotz der Tatsache, dass immer noch eine kleine Anzahl von Tieren benötigt wird, um Zellen für In-vitro-Kulturen zu erhalten, als Reduktionsalternativen (da im Vergleich zu In-vivo-Studien viel weniger Tiere verwendet werden) und Verfeinerungsalternativen (weil sie die Notwendigkeit beseitigen) betrachtet werden Tiere den nachteiligen toxischen Folgen von In-vivo-Experimenten auszusetzen).

Um die Ergebnisse von In-vitro-Toxizitätstests zu interpretieren, ihre potenzielle Nützlichkeit bei der Bewertung der Toxizität zu bestimmen und sie mit dem gesamten toxikologischen Prozess in vivo in Beziehung zu setzen, ist es notwendig zu verstehen, welcher Teil des toxikologischen Prozesses untersucht wird. Der gesamte toxikologische Prozess besteht aus Ereignissen, die damit beginnen, dass der Organismus einem physikalischen oder chemischen Mittel ausgesetzt wird, sich durch zelluläre und molekulare Wechselwirkungen weiterentwickeln und sich schließlich in der Reaktion des gesamten Organismus manifestieren. In-vitro-Tests beschränken sich im Allgemeinen auf den Teil des toxikologischen Prozesses, der auf zellulärer und molekularer Ebene stattfindet. Zu den Arten von Informationen, die aus In-vitro-Studien gewonnen werden können, gehören Stoffwechselwege, Wechselwirkung aktiver Metaboliten mit zellulären und molekularen Zielen und potenziell messbare toxische Endpunkte, die als molekulare Biomarker für die Exposition dienen können. Im Idealfall wäre der Toxizitätsmechanismus jeder Chemikalie aufgrund der Exposition gegenüber Organismen bekannt, sodass die aus In-vitro-Tests erhaltenen Informationen vollständig interpretiert und mit der Reaktion des gesamten Organismus in Beziehung gesetzt werden könnten. Dies ist jedoch praktisch unmöglich, da relativ wenige vollständige toxikologische Mechanismen aufgeklärt wurden. Daher sind Toxikologen mit einer Situation konfrontiert, in der die Ergebnisse eines In-vitro-Tests nicht als völlig genaue Vorhersage der In-vivo-Toxizität verwendet werden können, da der Mechanismus unbekannt ist. Jedoch werden während des Entwicklungsprozesses eines In-vitro-Tests häufig Komponenten der zellulären und molekularen Toxizitätsmechanismen aufgeklärt.

Eine der zentralen ungelösten Fragen bei der Entwicklung und Durchführung von In-vitro-Tests hängt mit der folgenden Überlegung zusammen: Sollen sie mechanistisch fundiert sein oder reicht es, wenn sie deskriptiv sind? Aus wissenschaftlicher Sicht ist es unbestreitbar besser, nur mechanistisch basierte Tests als Ersatz für In-vivo-Tests einzusetzen. In Ermangelung vollständiger mechanistischer Kenntnisse ist die Aussicht, In-vitro-Tests zu entwickeln, die Ganztierversuche in naher Zukunft vollständig ersetzen, jedoch nahezu gleich Null. Dies schließt jedoch die Verwendung von aussagekräftigeren Arten von Assays als frühe Screening-Instrumente nicht aus, was derzeit der Fall ist. Diese Screens haben zu einer deutlichen Reduzierung des Einsatzes von Tieren geführt. Bis zu dem Zeitpunkt, an dem mehr mechanistische Informationen generiert werden, kann es daher erforderlich sein, in begrenztem Umfang Tests anzuwenden, deren Ergebnisse einfach gut mit den in vivo erhaltenen korrelieren.

In-vitro-Tests auf Zytotoxizität

In diesem Abschnitt werden mehrere In-vitro-Tests beschrieben, die zur Bewertung des zytotoxischen Potenzials einer Chemikalie entwickelt wurden. Diese Tests sind größtenteils einfach durchzuführen und die Analyse kann automatisiert werden. Ein häufig verwendeter In-vitro-Test für Zytotoxizität ist der Neutralrot-Assay. Dieser Assay wird an Zellen in Kultur durchgeführt, und für die meisten Anwendungen können die Zellen in Kulturschalen gehalten werden, die 96 kleine Vertiefungen mit jeweils 6.4 mm Durchmesser enthalten. Da jede Vertiefung für eine einzelne Bestimmung verwendet werden kann, kann diese Anordnung mehrere Konzentrationen der Prüfchemikalie sowie Positiv- und Negativkontrollen mit jeweils einer ausreichenden Anzahl von Wiederholungen aufnehmen. Nach der Behandlung der Zellen mit verschiedenen Konzentrationen der Prüfchemikalie im Bereich von mindestens zwei Größenordnungen (z. B. von 0.01 mM bis 1 mM) sowie Positiv- und Negativkontrollchemikalien werden die Zellen gespült und mit Neutralrot behandelt, a Farbstoff, der nur von lebenden Zellen aufgenommen und zurückgehalten werden kann. Der Farbstoff kann nach dem Entfernen der Prüfchemikalie hinzugefügt werden, um unmittelbare Wirkungen zu bestimmen, oder er kann zu verschiedenen Zeitpunkten nach dem Entfernen der Prüfchemikalie hinzugefügt werden, um kumulative oder verzögerte Wirkungen zu bestimmen. Die Intensität der Farbe in jeder Vertiefung entspricht der Anzahl lebender Zellen in dieser Vertiefung. Die Farbintensität wird mit einem Spektrophotometer gemessen, das mit einem Plattenlesegerät ausgestattet sein kann. Der Plattenleser ist so programmiert, dass er einzelne Messungen für jede der 96 Vertiefungen der Kulturschale liefert. Diese automatisierte Methodik ermöglicht es dem Forscher, schnell ein Konzentrations-Wirkungs-Experiment durchzuführen und statistisch nützliche Daten zu erhalten.

Ein weiterer relativ einfacher Assay für Zytotoxizität ist der MTT-Test. MTT (3[4,5-Dimethylthiazol-2-yl]-2,5-Diphenyltetrazoliumbromid) ist ein Tetrazolium-Farbstoff, der durch mitochondriale Enzyme zu einer blauen Farbe reduziert wird. Nur Zellen mit lebensfähigen Mitochondrien behalten die Fähigkeit, diese Reaktion durchzuführen; daher steht die Farbintensität in direktem Zusammenhang mit dem Grad der mitochondrialen Integrität. Dies ist ein nützlicher Test zum Nachweis allgemeiner zytotoxischer Verbindungen sowie von Mitteln, die spezifisch auf Mitochondrien abzielen.

Die Messung der Laktatdehydrogenase (LDH)-Aktivität wird auch als breit angelegter Assay für Zytotoxizität verwendet. Dieses Enzym ist normalerweise im Zytoplasma lebender Zellen vorhanden und wird durch undichte Zellmembranen von toten oder sterbenden Zellen, die durch ein toxisches Mittel beeinträchtigt wurden, in das Zellkulturmedium freigesetzt. Kleine Mengen des Kulturmediums können zu verschiedenen Zeitpunkten nach der chemischen Behandlung der Zellen entfernt werden, um die Menge an freigesetztem LDH zu messen und den Zeitverlauf der Toxizität zu bestimmen. Während der LDH-Freisetzungstest eine sehr allgemeine Bewertung der Zytotoxizität ist, ist er nützlich, da er einfach durchzuführen ist und in Echtzeit durchgeführt werden kann.

Es werden viele neue Methoden entwickelt, um Zellschäden zu erkennen. Anspruchsvollere Methoden verwenden fluoreszierende Sonden, um eine Vielzahl von intrazellulären Parametern zu messen, wie z. B. die Calciumfreisetzung und Änderungen des pH-Werts und des Membranpotentials. Im Allgemeinen sind diese Sonden sehr empfindlich und können subtilere zelluläre Veränderungen erkennen, wodurch die Notwendigkeit, den Zelltod als Endpunkt zu verwenden, reduziert wird. Zusätzlich können viele dieser Fluoreszenz-Assays durch die Verwendung von 96-Well-Platten und Fluoreszenzplatten-Lesegeräten automatisiert werden.

Sobald Daten zu einer Reihe von Chemikalien mit einem dieser Tests gesammelt wurden, können die relativen Toxizitäten bestimmt werden. Die relative Toxizität einer Chemikalie, bestimmt in einem In-vitro-Test, kann als die Konzentration ausgedrückt werden, die eine 50 %-ige Wirkung auf die Endpunktreaktion unbehandelter Zellen ausübt. Diese Bestimmung wird als EC bezeichnet50 (Effektiv CKonzentration für 50% der Zellen) und kann verwendet werden, um die Toxizität verschiedener Chemikalien in vitro zu vergleichen. (Ein ähnlicher Begriff, der zur Bewertung der relativen Toxizität verwendet wird, ist IC50, die die Konzentration einer Chemikalie angibt, die eine 50%ige Hemmung eines zellulären Prozesses bewirkt, z. B. die Fähigkeit zur Aufnahme von Neutralrot.) Es ist nicht einfach zu beurteilen, ob die relative In-vitro-Toxizität der Chemikalien mit ihrer relativen Toxizität vergleichbar ist vivo-Toxizitäten, da es im in vivo-System so viele Störfaktoren wie Toxikokinetik, Metabolismus, Reparatur- und Abwehrmechanismen gibt. Da die meisten dieser Assays außerdem allgemeine Zytotoxizitätsendpunkte messen, sind sie nicht mechanistisch begründet. Daher ist die Übereinstimmung zwischen relativen In-vitro- und In-vivo-Toxizitäten einfach korrelativ. Trotz der zahlreichen Komplexitäten und Schwierigkeiten bei der Extrapolation von In-vitro- auf In-vivo-Tests erweisen sich diese In-vitro-Tests als sehr wertvoll, da sie einfach und kostengünstig durchzuführen sind und als Screens verwendet werden können, um hochgiftige Medikamente oder Chemikalien in frühen Stadien der Krankheit zu identifizieren Entwicklung.

Zielorgantoxizität

In-vitro-Tests können auch zur Beurteilung der spezifischen Zielorgantoxizität verwendet werden. Es gibt eine Reihe von Schwierigkeiten, die mit der Gestaltung solcher Tests verbunden sind, wobei die bemerkenswerteste die Unfähigkeit von In-vitro-Systemen ist, viele der Merkmale des Organs in vivo aufrechtzuerhalten. Wenn Zellen Tieren entnommen und in Kultur gebracht werden, neigen sie häufig entweder dazu, schnell zu degenerieren und/oder zu dedifferenzieren, dh sie verlieren ihre organähnlichen Funktionen und werden generischer. Dies stellt insofern ein Problem dar, als die Kulturen innerhalb eines kurzen Zeitraums, in der Regel wenige Tage, nicht mehr zur Beurteilung organspezifischer Wirkungen eines Toxins geeignet sind.

Viele dieser Probleme werden aufgrund der jüngsten Fortschritte in der Molekular- und Zellbiologie überwunden. Informationen, die über die zelluläre Umgebung in vivo erhalten werden, können zum Modulieren von Kulturbedingungen in vitro verwendet werden. Seit Mitte der 1980er Jahre wurden neue Wachstumsfaktoren und Zytokine entdeckt, und viele davon sind jetzt im Handel erhältlich. Die Zugabe dieser Faktoren zu Zellen in Kultur hilft, ihre Integrität zu bewahren und kann auch dazu beitragen, differenziertere Funktionen für längere Zeiträume beizubehalten. Andere Grundlagenstudien haben das Wissen über die Ernährungs- und Hormonanforderungen von Zellen in Kultur erweitert, so dass neue Medien formuliert werden können. Kürzlich wurden auch Fortschritte bei der Identifizierung sowohl natürlich vorkommender als auch künstlicher extrazellulärer Matrizen gemacht, auf denen Zellen kultiviert werden können. Die Kultivierung von Zellen auf diesen verschiedenen Matrizen kann tiefgreifende Auswirkungen sowohl auf ihre Struktur als auch auf ihre Funktion haben. Ein großer Vorteil, der sich aus diesem Wissen ergibt, ist die Fähigkeit, die Umgebung von Zellen in Kultur genau zu kontrollieren und die Auswirkungen dieser Faktoren auf grundlegende Zellprozesse und ihre Reaktionen auf verschiedene chemische Mittel einzeln zu untersuchen. Kurz gesagt, diese Systeme können einen großartigen Einblick in organspezifische Toxizitätsmechanismen liefern.

Viele Zielorgan-Toxizitätsstudien werden in Primärzellen durchgeführt, die definitionsgemäß frisch aus einem Organ isoliert werden und in der Regel eine begrenzte Lebensdauer in Kultur aufweisen. Es gibt viele Vorteile, Primärkulturen eines einzelnen Zelltyps aus einem Organ für die Toxizitätsbewertung zu haben. Aus mechanistischer Sicht sind solche Kulturen nützlich, um spezifische zelluläre Ziele einer Chemikalie zu untersuchen. In einigen Fällen können zwei oder mehr Zelltypen aus einem Organ zusammen kultiviert werden, und dies stellt einen zusätzlichen Vorteil bereit, indem man Zell-Zell-Wechselwirkungen als Reaktion auf ein Toxin betrachten kann. Einige Kokultursysteme für die Haut wurden so konstruiert, dass sie in vivo eine dreidimensionale Struktur bilden, die der Haut ähnelt. Es ist auch möglich, Zellen aus verschiedenen Organen – zum Beispiel Leber und Niere – zu kultivieren. Diese Art von Kultur wäre nützlich, um die für Nierenzellen spezifischen Wirkungen einer Chemikalie zu beurteilen, die in der Leber bioaktiviert werden muss.

Molekularbiologische Werkzeuge haben auch eine wichtige Rolle bei der Entwicklung kontinuierlicher Zelllinien gespielt, die für Zielorgan-Toxizitätstests nützlich sein können. Diese Zelllinien werden durch Transfektion von DNA in Primärzellen erzeugt. Beim Transfektionsverfahren werden die Zellen und die DNA so behandelt, dass die DNA von den Zellen aufgenommen werden kann. Die DNA stammt normalerweise von einem Virus und enthält ein Gen oder Gene, die es den Zellen ermöglichen, wenn sie exprimiert werden, unsterblich zu werden (dh in der Lage zu sein, über längere Zeiträume in Kultur zu leben und zu wachsen). Die DNA kann auch so verändert werden, dass das immortalisierende Gen von einem induzierbaren Promotor kontrolliert wird. Der Vorteil dieser Art von Konstrukt besteht darin, dass sich die Zellen nur dann teilen, wenn sie den geeigneten chemischen Stimulus erhalten, um die Expression des immortalisierenden Gens zu ermöglichen. Ein Beispiel für ein solches Konstrukt ist das große T-Antigen-Gen aus Simian Virus 40 (SV40) (das immortalisierende Gen), dem die Promotorregion des Metallothionein-Gens vorangeht, das durch die Anwesenheit eines Metalls im Kulturmedium induziert wird. Daher können die Zellen, nachdem das Gen in die Zellen transfiziert wurde, mit niedrigen Zinkkonzentrationen behandelt werden, um den MT-Promotor zu stimulieren und die Expression des T-Antigen-Gens einzuschalten. Unter diesen Bedingungen proliferieren die Zellen. Wenn Zink aus dem Medium entfernt wird, hören die Zellen auf, sich zu teilen und kehren unter idealen Bedingungen in einen Zustand zurück, in dem sie ihre gewebespezifischen Funktionen ausüben.

Die Fähigkeit, unsterblich gemachte Zellen zu erzeugen, hat zusammen mit den Fortschritten in der Zellkulturtechnologie wesentlich zur Schaffung von Zelllinien aus vielen verschiedenen Organen, einschließlich Gehirn, Niere und Leber, beigetragen. Bevor diese Zelllinien jedoch als Ersatz für die echten Zelltypen verwendet werden können, müssen sie sorgfältig charakterisiert werden, um festzustellen, wie „normal“ sie wirklich sind.

Andere In-vitro-Systeme zur Untersuchung der Zielorgantoxizität sind mit zunehmender Komplexität verbunden. Mit fortschreitender Komplexität von In-vitro-Systemen von der Einzelzell- zur Ganzorgankultur werden sie vergleichbarer mit dem In-vivo-Milieu, aber gleichzeitig werden sie angesichts der erhöhten Anzahl von Variablen viel schwieriger zu kontrollieren. Was durch den Übergang zu einer höheren Organisationsebene gewonnen werden kann, kann daher durch die Unfähigkeit des Forschers verloren gehen, die experimentelle Umgebung zu kontrollieren. Tabelle 1 vergleicht einige der Eigenschaften verschiedener In-vitro-Systeme, die zur Untersuchung der Hepatotoxizität verwendet wurden.

Tabelle 1. Vergleich von In-vitro-Systemen für Hepatotoxizitätsstudien

| System | Komplexität (Ebene der Interaktion) |

Fähigkeit, leberspezifische Funktionen beizubehalten | Mögliche Dauer der Kultur | Fähigkeit, die Umgebung zu kontrollieren |

| Immortalisierte Zelllinien | einige Zelle zu Zelle (variiert je nach Zelllinie) | schlecht bis gut (variiert je nach Zelllinie) | unbestimmt | Ausgezeichnet |

| Primäre Hepatozytenkulturen | Zelle zu Zelle | mäßig bis ausgezeichnet (variiert je nach Kulturbedingungen) | Tage bis Wochen | Ausgezeichnet |

| Co-Kulturen von Leberzellen | Zelle zu Zelle (zwischen gleichen und unterschiedlichen Zelltypen) | gut bis großartig | Wochen | Ausgezeichnet |

| Leberscheiben | Zelle zu Zelle (unter allen Zelltypen) | gut bis großartig | Stunden bis Tage | gut |

| Isolierte, perfundierte Leber | Zelle zu Zelle (unter allen Zelltypen) und innerhalb eines Organs | Ausgezeichnet | Stunden | Messe |

Präzise geschnittene Gewebeschnitte werden zunehmend für toxikologische Studien verwendet. Es gibt neue Instrumente, die es dem Forscher ermöglichen, gleichmäßige Gewebescheiben in einer sterilen Umgebung zu schneiden. Gewebeschnitte bieten gegenüber Zellkultursystemen einen gewissen Vorteil, da alle Zelltypen des Organs vorhanden sind und sie ihre in vivo-Architektur und interzelluläre Kommunikation beibehalten. Somit können In-vitro-Studien durchgeführt werden, um den Zielzelltyp innerhalb eines Organs zu bestimmen sowie um die spezifische Zielorgantoxizität zu untersuchen. Ein Nachteil der Schnitte besteht darin, dass sie nach den ersten 24 Stunden der Kultivierung schnell degenerieren, hauptsächlich aufgrund der schlechten Diffusion von Sauerstoff zu den Zellen im Inneren der Schnitte. Jüngste Studien haben jedoch gezeigt, dass eine effizientere Belüftung durch sanfte Rotation erreicht werden kann. Dies ermöglicht zusammen mit der Verwendung eines komplexeren Mediums, dass die Scheiben bis zu 96 Stunden überleben.

Gewebeexplantate haben ein ähnliches Konzept wie Gewebeschnitte und können auch verwendet werden, um die Toxizität von Chemikalien in bestimmten Zielorganen zu bestimmen. Gewebeexplantate werden hergestellt, indem ein kleines Gewebestück (für Teratogenitätsstudien ein intakter Embryo) entnommen und für weitere Untersuchungen in Kultur gebracht wird. Explantatkulturen waren für kurzfristige Toxizitätsstudien nützlich, einschließlich Reizung und Ätzwirkung in der Haut, Asbeststudien in der Luftröhre und Neurotoxizitätsstudien in Hirngewebe.

Zur Beurteilung der Zielorgantoxizität können auch isoliert perfundierte Organe herangezogen werden. Diese Systeme bieten einen ähnlichen Vorteil wie Gewebeschnitte und Explantate, da alle Zelltypen vorhanden sind, jedoch ohne die Belastung des Gewebes durch die Manipulationen, die mit der Herstellung von Schnitten verbunden sind. Darüber hinaus ermöglichen sie die Aufrechterhaltung von Wechselwirkungen zwischen Organen. Ein Hauptnachteil ist ihre kurzfristige Lebensfähigkeit, die ihre Verwendung für In-vitro-Toxizitätstests einschränkt. Als Alternative können diese Kulturen als Verfeinerung angesehen werden, da die Tiere nicht die nachteiligen Folgen einer In-vivo-Behandlung mit Giftstoffen erfahren. Ihre Verwendung verringert jedoch die Anzahl der erforderlichen Tiere nicht wesentlich.

Zusammenfassend stehen mehrere Arten von In-vitro-Systemen zur Bewertung der Zielorgantoxizität zur Verfügung. Mit einer oder mehreren dieser Techniken können viele Informationen über Toxizitätsmechanismen gewonnen werden. Die Schwierigkeit besteht darin, zu wissen, wie man von einem In-vitro-System, das einen relativ kleinen Teil des toxikologischen Prozesses darstellt, auf den gesamten in vivo ablaufenden Prozess extrapoliert.

In-vitro-Tests auf Augenreizung

Der vielleicht umstrittenste Ganztier-Toxizitätstest aus Sicht des Tierschutzes ist der Draize-Test auf Augenreizung, der an Kaninchen durchgeführt wird. Bei diesem Test wird eine kleine feste Dosis einer Chemikalie in eines der Augen des Kaninchens gegeben, während das andere Auge als Kontrolle dient. Der Grad der Reizung und Entzündung wird zu verschiedenen Zeitpunkten nach der Exposition bewertet. Es werden große Anstrengungen unternommen, um Methoden zu entwickeln, um diesen Test zu ersetzen, der nicht nur aus humanen Gründen, sondern auch wegen der Subjektivität der Beobachtungen und der Variabilität der Ergebnisse kritisiert wurde. Es ist interessant festzustellen, dass sich der Draize-Test trotz der heftigen Kritik als bemerkenswert erfolgreich bei der Vorhersage von Reizstoffen für das menschliche Auge erwiesen hat, insbesondere von leicht bis mäßig reizenden Substanzen, die mit anderen Methoden schwer zu identifizieren sind. Die Anforderungen an In-vitro-Alternativen sind daher groß.

Die Suche nach Alternativen zum Draize-Test ist kompliziert, auch wenn ihr Erfolg prognostiziert wird. Zahlreiche In-vitro- und andere Alternativen wurden entwickelt und teilweise umgesetzt. Verfeinerungsalternativen zum Draize-Test, die per Definition weniger schmerzhaft oder quälend für die Tiere sind, umfassen den Low-Volume-Augentest, bei dem kleinere Mengen an Testmaterial in die Augen der Kaninchen eingebracht werden, nicht nur aus humanen Gründen, sondern um besser die Mengen nachahmen, denen Menschen tatsächlich versehentlich ausgesetzt sind. Eine weitere Verbesserung besteht darin, dass Substanzen mit einem pH-Wert von weniger als 2 oder mehr als 11.5 nicht mehr an Tieren getestet werden, da sie als stark augenreizend bekannt sind.

Zwischen 1980 und 1989 ist die Zahl der Kaninchen, die für Augenreizungstests von Kosmetika verwendet werden, um schätzungsweise 87 % zurückgegangen. In-vitro-Tests wurden als Teil eines Tier-Testing-Ansatzes integriert, um diese enorme Reduzierung von Ganztiertests zu erreichen. Dieser Ansatz ist ein mehrstufiger Prozess, der mit einer gründlichen Untersuchung der historischen Augenreizungsdaten und einer physikalischen und chemischen Analyse der zu bewertenden Chemikalie beginnt. Wenn diese beiden Prozesse nicht genügend Informationen liefern, wird eine Reihe von In-vitro-Tests durchgeführt. Die zusätzlichen Daten aus den In-vitro-Tests könnten dann ausreichen, um die Sicherheit des Stoffes zu beurteilen. Wenn nicht, wäre der letzte Schritt, begrenzte In-vivo-Tests durchzuführen. Es ist leicht einzusehen, wie dieser Ansatz die Zahl der Tiere, die zur Vorhersage der Sicherheit einer Testsubstanz erforderlich sind, eliminieren oder zumindest drastisch reduzieren kann.

Die Reihe von In-vitro-Tests, die im Rahmen dieser Tier-Testing-Strategie verwendet werden, hängt von den Anforderungen der jeweiligen Branche ab. Augenreizungstests werden von einer Vielzahl von Branchen durchgeführt, von der Kosmetik über die Pharmazie bis hin zu Industriechemikalien. Die Art der von den einzelnen Branchen geforderten Informationen ist unterschiedlich, und daher ist es nicht möglich, eine einzelne Reihe von In-vitro-Tests zu definieren. Eine Testbatterie ist im Allgemeinen so konzipiert, dass sie fünf Parameter bewertet: Zytotoxizität, Veränderungen in der Gewebephysiologie und -biochemie, quantitative Struktur-Wirkungs-Beziehungen, Entzündungsmediatoren sowie Erholung und Reparatur. Ein Beispiel für einen Test auf Zytotoxizität, die eine mögliche Ursache für Irritationen ist, ist der Neutralrottest unter Verwendung von kultivierten Zellen (siehe oben). Veränderungen in der Zellphysiologie und Biochemie, die sich aus der Exposition gegenüber einer Chemikalie ergeben, können in Kulturen menschlicher Hornhautepithelzellen untersucht werden. Alternativ haben Forscher auch intakte oder sezierte Rinder- oder Hühneraugäpfel aus Schlachthöfen verwendet. Viele der in diesen Ganzorgankulturen gemessenen Endpunkte sind die gleichen wie die in vivo gemessenen, wie z. B. Hornhauttrübung und Hornhautschwellung.

Entzündungen sind häufig eine Komponente von chemikalieninduzierten Augenverletzungen, und es gibt eine Reihe von Assays, um diesen Parameter zu untersuchen. Verschiedene biochemische Assays weisen das Vorhandensein von Mediatoren nach, die während des Entzündungsprozesses freigesetzt werden, wie Arachidonsäure und Zytokine. Auch die Chorioallantoismembran (CAM) des Hühnereis kann als Indikator für eine Entzündung herangezogen werden. Beim CAM-Assay wird ein kleines Stück der Schale eines 14- bis XNUMX-tägigen Hühnerembryos entfernt, um die CAM freizulegen. Die Chemikalie wird dann auf die CAM aufgetragen und Entzündungszeichen, wie etwa Gefäßblutungen, werden danach zu verschiedenen Zeitpunkten bewertet.

Einer der am schwierigsten in vitro zu beurteilenden in vivo-Prozesse ist die Genesung und Reparatur einer Augenverletzung. Ein neu entwickeltes Instrument, das Silizium-Mikrophysiometer, misst kleine Änderungen des extrazellulären pH-Werts und kann zur Überwachung von kultivierten Zellen in Echtzeit verwendet werden. Es hat sich gezeigt, dass diese Analyse ziemlich gut mit der In-vivo-Erholung korreliert und als In-vitro-Test für dieses Verfahren verwendet wurde. Dies war ein kurzer Überblick über die Arten von Tests, die als Alternativen zum Draize-Test für Augenreizungen eingesetzt werden. Es ist wahrscheinlich, dass innerhalb der nächsten Jahre eine vollständige Reihe von In-vitro-Testbatterien definiert und jede für ihren spezifischen Zweck validiert wird.

Validierung

Der Schlüssel zur behördlichen Akzeptanz und Implementierung von In-vitro-Testmethoden ist die Validierung, der Prozess, durch den die Glaubwürdigkeit eines Kandidatentests für einen bestimmten Zweck festgestellt wird. Sowohl in den Vereinigten Staaten als auch in Europa wurden Anstrengungen unternommen, um den Validierungsprozess zu definieren und zu koordinieren. Die Europäische Union gründete 1993 das Europäische Zentrum für die Validierung alternativer Methoden (ECVAM), um die dortigen Bemühungen zu koordinieren und mit amerikanischen Organisationen wie dem Johns Hopkins Center for Alternatives to Animal Testing (CAAT), einem akademischen Zentrum in den Vereinigten Staaten, zusammenzuarbeiten , und das Interagency Coordinating Committee for the Validation of Alternative Methods (ICCVAM), das sich aus Vertretern der National Institutes of Health, der US Environmental Protection Agency, der US Food and Drug Administration und der Consumer Products Safety Commission zusammensetzt.

Die Validierung von In-vitro-Tests erfordert eine umfangreiche Organisation und Planung. Es muss ein Konsens zwischen staatlichen Regulierungsbehörden und industriellen und akademischen Wissenschaftlern über akzeptable Verfahren und eine ausreichende Aufsicht durch einen wissenschaftlichen Beirat bestehen, um sicherzustellen, dass die Protokolle festgelegten Standards entsprechen. Die Validierungsstudien sollten in einer Reihe von Referenzlabors unter Verwendung kalibrierter Chemikaliensätze aus einer Chemikalienbank und Zellen oder Geweben aus einer einzigen Quelle durchgeführt werden. Sowohl die laborinterne Wiederholbarkeit als auch die interlaboratorische Reproduzierbarkeit eines Kandidatentests müssen nachgewiesen und die Ergebnisse einer angemessenen statistischen Analyse unterzogen werden. Nachdem die Ergebnisse aus den verschiedenen Komponenten der Validierungsstudien zusammengestellt wurden, kann der wissenschaftliche Beirat Empfehlungen zur Validität des/der Kandidatentests für einen bestimmten Zweck abgeben. Darüber hinaus sollen die Ergebnisse der Studien in peer-reviewed Journals veröffentlicht und in eine Datenbank gestellt werden.

Die Definition des Validierungsprozesses ist derzeit noch in Arbeit. Jede neue Validierungsstudie liefert Informationen, die für das Design der nächsten Studie nützlich sind. Internationale Kommunikation und Zusammenarbeit sind für die zügige Entwicklung einer allgemein akzeptablen Reihe von Protokollen unerlässlich, insbesondere angesichts der erhöhten Dringlichkeit, die durch die Verabschiedung der EG-Kosmetikrichtlinie auferlegt wird. Diese Rechtsvorschriften können in der Tat den nötigen Anstoß für ernsthafte Validierungsbemühungen geben. Erst durch den Abschluss dieses Prozesses kann die Akzeptanz von In-vitro-Methoden durch die verschiedenen Regulierungsbehörden beginnen.

Fazit

Dieser Artikel hat einen breiten Überblick über den aktuellen Stand der In-vitro-Toxizitätsprüfung gegeben. Die Wissenschaft der In-vitro-Toxikologie ist relativ jung, wächst aber exponentiell. Die Herausforderung für die kommenden Jahre besteht darin, das durch zelluläre und molekulare Studien generierte mechanistische Wissen in den riesigen Bestand an In-vivo-Daten einzubeziehen, um eine vollständigere Beschreibung toxikologischer Mechanismen zu liefern und ein Paradigma zu etablieren, mit dem In-vitro-Daten verwendet werden können Toxizität in vivo vorherzusagen. Nur durch die konzertierten Bemühungen von Toxikologen und Regierungsvertretern kann der inhärente Wert dieser In-vitro-Methoden realisiert werden.

Aktivitätsbeziehungen strukturieren

Bei der Analyse von Struktur-Aktivitäts-Beziehungen (SAR) werden Informationen über die Molekularstruktur von Chemikalien genutzt, um wichtige Eigenschaften in Bezug auf Persistenz, Verteilung, Aufnahme und Absorption sowie Toxizität vorherzusagen. SAR ist eine alternative Methode zur Identifizierung potenziell gefährlicher Chemikalien, die verspricht, Industrien und Regierungen bei der Priorisierung von Stoffen für die weitere Bewertung oder für die frühzeitige Entscheidungsfindung für neue Chemikalien zu unterstützen. Die Toxikologie ist ein zunehmend teures und ressourcenintensives Unterfangen. Zunehmende Bedenken hinsichtlich des Potenzials von Chemikalien, nachteilige Auswirkungen auf exponierte menschliche Populationen zu verursachen, haben Regulierungs- und Gesundheitsbehörden dazu veranlasst, den Umfang und die Empfindlichkeit von Tests zum Nachweis toxikologischer Gefahren zu erweitern. Gleichzeitig haben die tatsächlichen und vermeintlichen Regulierungslasten für die Industrie Bedenken hinsichtlich der Praktikabilität von Toxizitätstestmethoden und Datenanalysen geweckt. Gegenwärtig hängt die Bestimmung der chemischen Karzinogenität von Lebenszeittests an mindestens zwei Arten beiderlei Geschlechts bei mehreren Dosen mit sorgfältiger histopathologischer Analyse mehrerer Organe sowie dem Nachweis präneoplastischer Veränderungen in Zellen und Zielorganen ab. In den Vereinigten Staaten wird der Krebs-Bioassay auf über 3 Millionen Dollar (1995 Dollar) geschätzt.

Selbst mit unbegrenzten finanziellen Mitteln würde der Testaufwand für die etwa 70,000 existierenden Chemikalien, die heute weltweit hergestellt werden, die verfügbaren Ressourcen ausgebildeter Toxikologen übersteigen. Es würden Jahrhunderte erforderlich sein, um selbst eine Erstbewertung dieser Chemikalien abzuschließen (NRC 1984). In vielen Ländern haben ethische Bedenken hinsichtlich der Verwendung von Tieren in Toxizitätstests zugenommen, was zusätzlichen Druck auf die Verwendung von Standardmethoden für Toxizitätstests ausübt. SAR wurde in der pharmazeutischen Industrie weit verbreitet verwendet, um Moleküle mit einem Potenzial für eine vorteilhafte Verwendung in der Behandlung zu identifizieren (Hansch und Zhang 1993). In der Umwelt- und Arbeitsschutzpolitik wird SAR verwendet, um die Ausbreitung von Verbindungen in der physikalisch-chemischen Umgebung vorherzusagen und neue Chemikalien für eine weitere Bewertung der potenziellen Toxizität zu screenen. Gemäß dem US-amerikanischen Toxic Substances Control Act (TSCA) verwendet die EPA seit 1979 einen SAR-Ansatz als „erstes Screening“ neuer Chemikalien im Premanufacture Notification (PMN)-Prozess; Australien verwendet einen ähnlichen Ansatz im Rahmen seines Verfahrens zur Meldung neuer Chemikalien (NICNAS). In den USA ist die SAR-Analyse eine wichtige Grundlage für die Feststellung, dass eine vernünftige Grundlage für die Schlussfolgerung besteht, dass die Herstellung, Verarbeitung, Verteilung, Verwendung oder Entsorgung des Stoffes ein unzumutbares Verletzungsrisiko für die menschliche Gesundheit oder die Umwelt darstellt, wie in Abschnitt gefordert 5(f) TSCA. Auf der Grundlage dieser Feststellung kann die EPA dann tatsächliche Tests des Stoffes gemäß Abschnitt 6 des TSCA verlangen.

Begründung für SAR

Die wissenschaftliche Begründung für SAR basiert auf der Annahme, dass die Molekularstruktur einer Chemikalie wichtige Aspekte ihres Verhaltens in physikalisch-chemischen und biologischen Systemen vorhersagt (Hansch und Leo 1979).

SAR-Prozess

Der SAR-Überprüfungsprozess umfasst die Identifizierung der chemischen Struktur, einschließlich empirischer Formulierungen, sowie der reinen Verbindung; Identifizierung strukturanaloger Substanzen; Durchsuchen von Datenbanken und Literatur nach Informationen über strukturelle Analoga; und Analyse von Toxizität und anderen Daten zu Strukturanaloga. In einigen seltenen Fällen können Informationen über die Struktur der Verbindung allein ausreichen, um eine SAR-Analyse zu unterstützen, die auf gut verstandenen Toxizitätsmechanismen basiert. Mehrere Datenbanken zu SAR wurden zusammengestellt, ebenso wie computergestützte Methoden zur Vorhersage der Molekülstruktur.

Mit diesen Informationen können die folgenden Endpunkte mit SAR geschätzt werden:

- Physikalisch-chemische Parameter: Siedepunkt, Dampfdruck, Wasserlöslichkeit, Oktanol/Wasser-Verteilungskoeffizient

- biologische/ökologische Verbleibsparameter: biologischer Abbau, Bodensorption, Photoabbau, Pharmakokinetik

- Toxizitätsparameter: Toxizität für Wasserorganismen, Resorption, akute Toxizität für Säugetiere (Limit-Test oder LD50), Haut-, Lungen- und Augenreizung, Sensibilisierung, subchronische Toxizität, Mutagenität.

Es ist zu beachten, dass für so wichtige Gesundheitsendpunkte wie Karzinogenität, Entwicklungstoxizität, Reproduktionstoxizität, Neurotoxizität, Immuntoxizität oder andere Zielorganwirkungen keine SAR-Methoden existieren. Dies ist auf drei Faktoren zurückzuführen: das Fehlen einer großen Datenbank zum Testen von SAR-Hypothesen, das Fehlen von Kenntnissen über strukturelle Determinanten der toxischen Wirkung und die Vielzahl von Zielzellen und Mechanismen, die an diesen Endpunkten beteiligt sind (siehe „Die Vereinigten Staaten Ansatz zur Risikobewertung von reproduktionstoxischen und neurotoxischen Stoffen“). Einige begrenzte Versuche, SAR zur Vorhersage der Pharmakokinetik unter Verwendung von Informationen über Verteilungskoeffizienten und Löslichkeit zu verwenden (Johanson und Naslund 1988). Umfangreichere quantitative SAR wurden durchgeführt, um den P450-abhängigen Metabolismus einer Reihe von Verbindungen und die Bindung von Dioxin- und PCB-ähnlichen Molekülen an den zytosolischen „Dioxin“-Rezeptor vorherzusagen (Hansch und Zhang 1993).

Es hat sich gezeigt, dass SAR für einige der oben aufgeführten Endpunkte eine unterschiedliche Vorhersagbarkeit aufweist, wie in Tabelle 1 gezeigt. Diese Tabelle enthält Daten aus zwei Vergleichen der vorhergesagten Aktivität mit tatsächlichen Ergebnissen, die durch empirische Messungen oder Toxizitätstests erhalten wurden. SAR, durchgeführt von Experten der US EPA, schnitt bei der Vorhersage physikalisch-chemischer Eigenschaften schlechter ab als bei der Vorhersage der biologischen Aktivität, einschließlich des biologischen Abbaus. Bei Toxizitätsendpunkten schnitt SAR am besten ab, um Mutagenität vorherzusagen. Ashby und Tennant (1991) stellten in einer umfassenderen Studie bei ihrer Analyse von NTP-Chemikalien ebenfalls eine gute Vorhersagbarkeit der kurzfristigen Genotoxizität fest. Diese Ergebnisse sind angesichts des derzeitigen Verständnisses der molekularen Mechanismen der Genotoxizität (siehe „Gentoxikologie“) und der Rolle der Elektrophilie bei der DNA-Bindung nicht überraschend. Im Gegensatz dazu neigte SAR dazu, die systemische und subchronische Toxizität bei Säugetieren zu unterschätzen und die akute Toxizität für Wasserorganismen zu überschätzen.

Tabelle 1. Vergleich von SAR- und Testdaten: OECD/NTP-Analysen

| Endpunkt | Zustimmung (%) | Ablehnung (%) | Nummer |

| Siedepunkt | 50 | 50 | 30 |

| Dampfdruck | 63 | 37 | 113 |

| Wasserlöslichkeit | 68 | 32 | 133 |

| Verteilungskoeffizient | 61 | 39 | 82 |

| Bioabbau | 93 | 7 | 107 |

| Fischtoxizität | 77 | 22 | 130 |

| Daphnientoxizität | 67 | 33 | 127 |

| Akute Säugetiertoxizität (LD50 ) | 80 | 201 | 142 |

| Hautreizung | 82 | 18 | 144 |

| Augen Irritation | 78 | 22 | 144 |

| Hautsensibilisierung | 84 | 16 | 144 |

| Subchronische Toxizität | 57 | 32 | 143 |

| Mutagenität2 | 88 | 12 | 139 |

| Mutagenität3 | 82-944 | 1-10 | 301 |

| Kanzerogenität3 : Zweijähriger Bioassay | 72-954 | - | 301 |

Quelle: Daten der OECD, persönliche Mitteilung C. Auer, US EPA. In dieser Analyse wurden nur diejenigen Endpunkte verwendet, für die vergleichbare SAR-Vorhersagen und tatsächliche Testdaten verfügbar waren. NTP-Daten stammen von Ashby und Tennant 1991.

1 Besorgniserregend war das Versäumnis von SAR, die akute Toxizität bei 12 % der getesteten Chemikalien vorherzusagen.

2 OECD-Daten, basierend auf Ames-Test-Konkordanz mit SAR

3 NTP-Daten, basierend auf Gentox-Assays im Vergleich zu SAR-Vorhersagen für mehrere Klassen von „strukturell alarmierenden Chemikalien“.

4 Die Übereinstimmung variiert mit der Klasse; höchste Übereinstimmung war mit aromatischen Amino/Nitro-Verbindungen; am niedrigsten bei „verschiedenen“ Strukturen.

Für andere toxische Endpunkte hat SAR, wie oben erwähnt, einen weniger nachweisbaren Nutzen. Vorhersagen zur Säugetiertoxizität werden durch das Fehlen von SAR für die Toxikokinetik komplexer Moleküle erschwert. Dennoch wurden einige Versuche unternommen, SAR-Prinzipien für komplexe Endpunkte der Toxizität bei Säugetieren vorzuschlagen (siehe beispielsweise Bernstein (1984) für eine SAR-Analyse potenzieller reproduktionstoxischer Stoffe für Männer). In den meisten Fällen ist die Datenbank zu klein, um strukturbasierte Vorhersagen gründlich zu testen.

An dieser Stelle kann der Schluss gezogen werden, dass SAR hauptsächlich nützlich sein kann, um die Investition in Toxizitätstestressourcen zu priorisieren oder um frühzeitig Bedenken hinsichtlich potenzieller Gefahren zu äußern. Nur im Fall von Mutagenität ist es wahrscheinlich, dass die SAR-Analyse selbst zuverlässig verwendet werden kann, um andere Entscheidungen zu informieren. Für keinen Endpunkt ist es wahrscheinlich, dass SAR die Art von quantitativen Informationen liefern kann, die für Risikobewertungszwecke erforderlich sind, wie an anderer Stelle in diesem Kapitel und erörtert Enzyklopädie.

Überblick

In der 3. Auflage der ILO's Enzyklopädie, erschienen 1983, wurde Ergonomie in einem nur etwa vier Seiten langen Artikel zusammengefasst. Seit dem Erscheinen der 3. Auflage hat sich die Gewichtung und das Verständnis von Zusammenhängen in Sicherheit und Gesundheit stark verändert: Die Welt lässt sich nicht mehr ohne Weiteres in Medizin, Sicherheit und Gefahrenabwehr einordnen. Nahezu alle Branchen der Produktions- und Dienstleistungsindustrie haben im letzten Jahrzehnt große Anstrengungen unternommen, um Produktivität und Qualität zu verbessern. Aus diesem Umstrukturierungsprozess sind praktische Erfahrungen entstanden, die deutlich machen, dass Produktivität und Qualität in direktem Zusammenhang mit der Gestaltung der Arbeitsbedingungen stehen. Ein direktes wirtschaftliches Maß für die Produktivität – die Kosten für krankheitsbedingte Fehlzeiten – wird von den Arbeitsbedingungen beeinflusst. Daher sollte es möglich sein, Produktivität und Qualität zu steigern und Fehlzeiten zu vermeiden, indem der Gestaltung der Arbeitsbedingungen mehr Aufmerksamkeit geschenkt wird.

Zusammenfassend lässt sich die einfache Hypothese der modernen Ergonomie so formulieren: Schmerzen und Erschöpfung verursachen Gesundheitsgefährdung, Produktivitätsverschwendung und Qualitätsminderung, die ein Maß für Kosten und Nutzen menschlicher Arbeit sind.

Diese einfache Hypothese steht im Gegensatz zur Arbeitsmedizin, die sich in der Regel auf die Feststellung der Ätiologie von Berufskrankheiten beschränkt. Ziel der Arbeitsmedizin ist es, Bedingungen zu schaffen, unter denen die Wahrscheinlichkeit, solche Erkrankungen zu entwickeln, minimiert wird. Unter ergonomischen Gesichtspunkten lassen sich diese Bedingungen am einfachsten in Form von Anforderungen und Belastungsgrenzen formulieren. Arbeitsmedizin lässt sich zusammenfassend als „Begrenzung durch medizinisch-wissenschaftliche Studien“ zusammenfassen. Die traditionelle Ergonomie sieht ihre Rolle darin, Methoden zu formulieren, mit denen durch Gestaltung und Arbeitsorganisation die arbeitsmedizinisch festgestellten Grenzen in die Praxis umgesetzt werden können. Traditionelle Ergonomie könnte man dann als Entwicklung von „Korrekturen durch wissenschaftliche Studien“ bezeichnen, wobei unter „Korrekturen“ alle Arbeitsgestaltungsempfehlungen zu verstehen sind, die dazu auffordern, Belastungsgrenzen nur zu beachten, um Gesundheitsgefährdungen vorzubeugen. Charakteristisch für solche Korrekturempfehlungen ist, dass der Praktiker mit dem Problem der Anwendung am Ende allein gelassen wird – es gibt keine multidisziplinäre Teamarbeit.

Das ursprüngliche Ziel, die Ergonomie 1857 zu erfinden, steht im Gegensatz zu dieser Art „Ergonomie durch Korrektur“:

... ein wissenschaftlicher Ansatz, der es uns ermöglicht, die besten Früchte der Lebensarbeit zum Nutzen für uns selbst und für andere mit minimalem Aufwand und maximaler Befriedigung zu ernten (Jastrzebowski 1857).

Die Wurzel des Begriffs „Ergonomie“ stammt aus dem Griechischen „nomos“ bedeutet Herrschaft und „ergo“ bedeutet Arbeit. Man könnte vorschlagen, dass die Ergonomie „Regeln“ für ein zukunftsorientiertes, vorausschauendes Designkonzept entwickelt. Im Gegensatz zur „korrigierenden Ergonomie“ ist die Idee der Vorausschauende Ergonomie basiert auf der Anwendung ergonomischer Empfehlungen, die gleichzeitig die Rentabilitätsmargen berücksichtigen (Laurig 1992).

Die Grundregeln für die Entwicklung dieses Ansatzes lassen sich aus der Praxis ableiten und durch Ergebnisse arbeitshygienischer und ergonomischer Forschung untermauern. Mit anderen Worten, Vorausschauende Ergonomie bedeutet, nach Alternativen in der Arbeitsgestaltung zu suchen, die Ermüdung und Erschöpfung des Arbeitssubjekts vorbeugen, um die menschliche Leistungsfähigkeit zu fördern („... zum Wohle unserer selbst und anderer“). Dieser umfassende Ansatz von Vorausschauende Ergonomie umfasst die Arbeitsplatz- und Gerätegestaltung sowie die Gestaltung von Arbeitsbedingungen, die durch eine zunehmende Informationsverarbeitung und eine sich verändernde Arbeitsorganisation bestimmt werden. Vorausschauende Ergonomie ist daher ein interdisziplinärer Ansatz von Forschern und Praktikern aus den unterschiedlichsten Bereichen, die das gleiche Ziel verfolgen, und ein Teil einer allgemeinen Grundlage für ein modernes Verständnis von Arbeitssicherheit und Gesundheitsschutz (UNESCO 1992).

Basierend auf diesem Verständnis, die Ergonomie Kapitel in der 4. Ausgabe der IAO Enzyklopädie umfasst die unterschiedlichen Wissens- und Erfahrungscluster, die sich an den Eigenschaften und Fähigkeiten der Arbeitnehmer orientieren und darauf abzielen, die Ressource „Menschliche Arbeit“ optimal zu nutzen, indem die Arbeit „ergonomischer“, also humaner gestaltet wird.

Die Themenwahl und die Gliederung der Artikel in diesem Kapitel folgt der Gliederung typischer Fragestellungen aus der Praxis, wie sie in der Industrie praktiziert werden. Beginnend mit der Ziele, Prinzipien und Methoden der Ergonomie behandeln die folgenden Artikel grundlegende Prinzipien aus den Grundlagenwissenschaften wie Physiologie und Psychologie. Auf dieser Grundlage stellen die nächsten Beiträge wesentliche Aspekte einer ergonomischen Gestaltung der Arbeitsbedingungen von der Arbeitsorganisation bis zur Produktgestaltung vor. „Designing for everyone“ legt besonderen Wert auf einen ergonomischen Ansatz, der sich an den Eigenschaften und Fähigkeiten des Mitarbeiters orientiert, ein Konzept, das in der Praxis oft übersehen wird. Die Bedeutung und Vielfalt der Ergonomie wird an zwei Beispielen am Ende des Kapitels aufgezeigt und findet sich auch darin wieder, dass viele weitere Kapitel dieser Ausgabe der ILO Enzyklopädie stehen in direktem Zusammenhang mit Ergonomie, wie z Hitze und Kälte, Lärm, Vibration, Visuelle Anzeigeeinheiten, und praktisch alle Kapitel in den Abschnitten Unfall- und Sicherheitsmanagement und Management und Politik.

Arbeitsorganisation

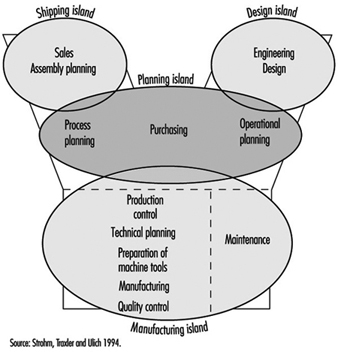

Gestaltung von Produktionssystemen

Viele Unternehmen investieren Millionen in computergestützte Produktionssysteme und schöpfen gleichzeitig ihre Humanressourcen nicht voll aus, deren Wert durch Investitionen in Ausbildung deutlich gesteigert werden kann. Tatsächlich kann der Einsatz von qualifiziertem Mitarbeiterpotenzial statt hochkomplexer Automatisierung unter Umständen nicht nur die Investitionskosten deutlich senken, sondern auch die Flexibilität und Systemfähigkeit deutlich steigern.

Ursachen für ineffizienten Einsatz von Technologie

Die angestrebten Verbesserungen durch Investitionen in moderne Technik werden häufig nicht einmal annähernd erreicht (Strohm, Kuark und Schilling 1993; Ulich 1994). Die wichtigsten Gründe dafür sind Probleme in den Bereichen Technik, Organisation und Mitarbeiterqualifikation.

Für Probleme mit der Technik lassen sich drei Hauptursachen identifizieren:

- Unzureichende Technologie. Aufgrund der Schnelligkeit technologischer Veränderungen wurden neue Technologien, die auf den Markt kamen, manchmal unzureichenden kontinuierlichen Verwendbarkeitstests unterzogen, was zu ungeplanten Ausfallzeiten führen kann.

- Ungeeignete Technik. Technologie, die für große Unternehmen entwickelt wurde, ist für kleinere Unternehmen oft nicht geeignet. Wenn ein kleines Unternehmen ein für ein großes Unternehmen entwickeltes Produktionsplanungs- und -steuerungssystem einführt, kann es sich selbst die für seinen Erfolg oder sogar sein Überleben notwendige Flexibilität nehmen.

- Zu komplexe Technik. Wenn Konstrukteure und Entwickler ihr gesamtes Planungswissen einsetzen, um das technisch Machbare zu realisieren, ohne die Erfahrung der Produktionsbeteiligten zu berücksichtigen, können komplexe Automatisierungssysteme entstehen, die nicht mehr einfach zu beherrschen sind.

Organisationsprobleme sind in erster Linie darauf zurückzuführen, dass ständig versucht wird, neueste Technologien in ungeeignete Organisationsstrukturen zu implementieren. Beispielsweise macht es wenig Sinn, Computer der dritten, vierten und fünften Generation in Organisationen der zweiten Generation einzuführen. Aber genau das tun viele Unternehmen (Savage und Appleton 1988). In vielen Unternehmen ist ein radikaler Umbau der Organisation Voraussetzung für den erfolgreichen Einsatz neuer Technologien. Dazu gehört insbesondere eine Auseinandersetzung mit den Konzepten der Produktionsplanung und -steuerung. Letztlich kann eine lokale Selbststeuerung durch qualifiziertes Bedienpersonal unter Umständen deutlich effizienter und wirtschaftlicher sein als ein technisch hoch entwickeltes Produktionsplanungs- und Steuerungssystem.

Probleme bei der Qualifizierung von Mitarbeitern entstehen vor allem dadurch, dass eine Vielzahl von Unternehmen die Notwendigkeit von Qualifizierungsmaßnahmen im Zusammenhang mit der Einführung computergestützter Produktionssysteme nicht erkennen. Darüber hinaus wird die Ausbildung zu häufig als Kostenfaktor angesehen, der kontrolliert und minimiert werden muss, und nicht als strategische Investition. Tatsächlich können Anlagenstillstandszeiten und die daraus resultierenden Kosten oft effektiv reduziert werden, indem Fehler auf der Grundlage der Kompetenz und des anlagenspezifischen Wissens und der Erfahrung des Bedieners diagnostiziert und behoben werden können. Dies ist insbesondere in eng gekoppelten Produktionsanlagen der Fall (Köhler et al. 1989). Gleiches gilt für die Einführung neuer Produkte oder Produktvarianten. Viele Beispiele ineffizienten exzessiven Technologieeinsatzes zeugen von solchen Zusammenhängen.

Die Konsequenz der hier kurz vorgestellten Analyse ist, dass die Einführung computergestützter Produktionssysteme nur dann Erfolg versprechend ist, wenn sie in ein Gesamtkonzept integriert ist, das darauf abzielt, den Technologieeinsatz, die Organisationsstruktur und die Steigerung der Mitarbeiterqualifikation gemeinsam zu optimieren .

Von der Aufgabe zum Design sozio-technischer Systeme

Arbeitspsychologische Konzepte des Production Design basieren auf der Primat von

die Aufgabe. Einerseits bildet die Aufgabe die Schnittstelle zwischen Individuum und Organisation (Volpert 1987). Andererseits verbindet die Aufgabe das soziale Subsystem mit dem technischen Subsystem. „Die Aufgabe muss der Artikulationspunkt zwischen sozialem und technischem System sein – die Verknüpfung der Arbeit im technischen System mit dem ihr zugeordneten Rollenverhalten im sozialen System“ (Blumberg 1988).

Das bedeutet, dass ein soziotechnisches System, beispielsweise eine Produktionsinsel, primär durch die Aufgabe definiert wird, die es zu erfüllen hat. Die Arbeitsverteilung zwischen Mensch und Maschine spielt dabei eine zentrale Rolle, denn sie entscheidet darüber, ob der Mensch als verlängerter Arm der Maschine mit einer in einer Automatisierungs-„Lücke“ übriggebliebenen Funktion „funktioniert“ oder ob die Maschine als verlängerter Arm der Maschine fungiert Person, mit einer Werkzeugfunktion, die menschliche Fähigkeiten und Kompetenzen unterstützt. Wir bezeichnen diese gegensätzlichen Positionen als „technikorientiert“ und „arbeitsorientiert“ (Ulich 1994).

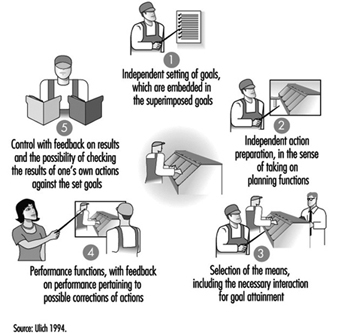

Das Konzept der vollständigen Aufgabe

Das Prinzip der vollständigen Aktivität (Hacker 1986) bzw komplette Aufgabe spielt in arbeitspsychologischen Konzepten zur Definition von Arbeitsaufgaben und zur Arbeitsteilung zwischen Mensch und Maschine eine zentrale Rolle. Erledigte Aufgaben sind solche, „über die der Einzelne eine beträchtliche persönliche Kontrolle hat“ und die „starke Kräfte im Einzelnen hervorrufen, um sie zu erledigen oder fortzusetzen“. Vollständige Aufgaben tragen zur „Entwicklung dessen bei, was als ‚Aufgabenorientierung‘ beschrieben wurde – das heißt, ein Zustand, in dem das Interesse des Einzelnen geweckt, engagiert und durch den Charakter der Aufgabe gelenkt wird“ (Emery 1959). . Abbildung 1 fasst Vollständigkeitsmerkmale zusammen, die bei Maßnahmen zur arbeitsorientierten Gestaltung von Produktionssystemen berücksichtigt werden müssen.

Abbildung 1. Merkmale vollständiger Aufgaben

- Die eigenständige Zielsetzung, die in übergeordnete Ziele einfließen kann, erfordert eine Abkehr von der zentralen Planung und Steuerung hin zu einer dezentralen Shopfloor-Steuerung, die die Möglichkeit bietet, innerhalb definierter Zeiträume selbstbestimmte Entscheidungen zu treffen.