Catégories Enfants

27. Surveillance biologique (6)

27. Surveillance biologique

Éditeur de chapitre : Robert Lauwerys

Table des matières

Tableaux et figures

Principes généraux

Vito Foà et Lorenzo Alessio

Assurance qualité

D. Gompertz

Métaux et composés organométalliques

P. Hoet et Robert Lauwerys

Solvants organiques

Masayuki Ikeda

Produits chimiques génotoxiques

Marja Sorsa

Pesticides

Marco Maroni et Adalberto Ferioli

Tables

Cliquez sur un lien ci-dessous pour afficher le tableau dans le contexte de l'article.

1. ACGIH, DFG et autres valeurs limites pour les métaux

2. Exemples de produits chimiques et de surveillance biologique

3. Surveillance biologique des solvants organiques

4. Génotoxicité des produits chimiques évaluée par le CIRC

5. Biomarqueurs et certains échantillons de cellules/tissus et génotoxicité

6. Agents cancérigènes pour l'homme, exposition professionnelle et paramètres cytogénétiques

8. Exposition due à la production et à l'utilisation de pesticides

9. Toxicité aiguë de l'OP à différents niveaux d'inhibition de l'ACHE

10. Variations de ACHE & PCHE et conditions de santé sélectionnées

11. Activités de la cholinestérase chez des personnes en bonne santé non exposées

12. Phosphates d'alkyle urinaires et pesticides OP

13. Dosage des alkylphosphates urinaires & OP

14. Métabolites urinaires des carbamates

15. Métabolites urinaires du dithiocarbamate

16. Indices proposés pour la surveillance biologique des pesticides

17. Valeurs limites biologiques recommandées (à partir de 1996)

Figures

Pointez sur une vignette pour voir la légende de la figure, cliquez pour voir la figure dans le contexte de l'article.

28. Épidémiologie et statistiques (12)

28. Épidémiologie et statistiques

Éditeurs de chapitre : Franco Merletti, Colin L. Soskolne et Paolo Vineis

Table des matières

Tableaux et figures

Méthode épidémiologique appliquée à la santé et à la sécurité au travail

Franco Merletti, Colin L. Soskolne et Paolo Vineis

Évaluation de l'exposition

M. Gérald Ott

Résumé des mesures d'exposition au travail

Colin L. Soskolné

Mesurer les effets des expositions

Shelia Hoar Zahm

Étude de cas : Mesures

Franco Merletti, Colin L. Soskolne et Paola Vineis

Options dans la conception de l'étude

Sven Hernberg

Problèmes de validité dans la conception de l'étude

Annie J.Sasco

Impact de l'erreur de mesure aléatoire

Paolo Vineis et Colin L. Soskolne

Méthodes statistiques

Annibale Biggeri et Mario Braga

Évaluation de la causalité et éthique dans la recherche épidémiologique

Paolo Vineis

Études de cas illustrant les enjeux méthodologiques de la surveillance des maladies professionnelles

Jung-Der Wang

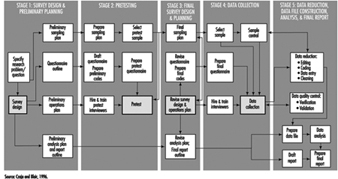

Questionnaires en recherche épidémiologique

Steven D. Stellman et Colin L. Soskolne

Perspective historique de l'amiante

Laurent Garfinkel

Tables

Cliquez sur un lien ci-dessous pour afficher le tableau dans le contexte de l'article.

1. Cinq mesures sommaires sélectionnées de l'exposition au travail

2. Mesures de l'apparition de la maladie

3. Mesures d'association pour une étude de cohorte

4. Mesures d'association pour les études cas-témoins

5. Disposition générale du tableau de fréquence pour les données de cohorte

6. Exemple de mise en page des données cas-témoins

7. Mise en page des données cas-témoin - un contrôle par cas

8. Cohorte hypothétique de 1950 individus à T2

9. Indices de tendance centrale & dispersion

10. Une expérience binomiale & probabilités

11. Résultats possibles d'une expérience binomiale

12. Distribution binomiale, 15 succès/30 essais

13. Distribution binomiale, p = 0.25 ; 30 essais

14. Erreur de type II et alimentation ; x = 12, n = 30, a = 0.05

15. Erreur de type II et alimentation ; x = 12, n = 40, a = 0.05

16. 632 travailleurs exposés à l'amiante 20 ans ou plus

17. O/E nombre de décès parmi 632 travailleurs de l'amiante

Figures

Pointez sur une vignette pour voir la légende de la figure, cliquez pour voir la figure dans le contexte de l'article.

29. Ergonomie (27)

29. Ergonomie

Éditeurs de chapitre : Wolfgang Laurig et Joachim Vedder

Table des matières

Tableaux et figures

Vue d’ensemble

Wolfgang Laurig et Joachim Vedder

Objectifs, principes et méthodes

La nature et les objectifs de l'ergonomie

William T.Singleton

Analyse des activités, des tâches et des systèmes de travail

Véronique De Keyser

Ergonomie et standardisation

Friedhelm Nachreiner

Listes de contrôle

Pranab Kumar Nag

Aspects physiques et physiologiques

Anthropométrie

Melchiorre Masali

Travail musculaire

Juhani Smolander et Veikko Louhevaara

Postures au travail

Ilkka Kuorinka

Biomécanique

Franck Darby

Fatigue générale

Étienne Grandjean

Fatigue et récupération

Rolf Helbig et Walter Rohmert

Aspects psychologiques

Charge de travail mentale

Winfried Hacker

Vigilance

Herbert Heuer

Fatigue mentale

Pierre Richter

Aspects organisationnels du travail

Organisation du travail

Eberhard Ulich et Gudela Grote

Privation de sommeil

Kazutaka Kogi

Conception de systèmes de travail

Stations de travail

Roland Kadefors

Outils

TM Fraser

Commandes, indicateurs et panneaux

Karl HE Kroemer

Traitement de l'information et conception

Andries F. Sanders

Concevoir pour tout le monde

Concevoir pour des groupes spécifiques

Blague H. Grady-van den Nieuwboer

Étude de cas : La classification internationale des limitations fonctionnelles chez les personnes

Les différences culturelles

Houshang Shahnavaz

Travailleurs âgés

Antoine Laville et Serge Volkoff

Travailleurs ayant des besoins spéciaux

Blague H. Grady-van den Nieuwboer

Diversité et importance de l'ergonomie - Deux exemples

Conception de systèmes dans la fabrication de diamants

Issacar Guilad

Ne pas tenir compte des principes de conception ergonomique : Tchernobyl

Vladimir M. Munipov

Tables

Cliquez sur un lien ci-dessous pour afficher le tableau dans le contexte de l'article.

1. Liste de base anthropométrique de base

2. Fatigue et récupération en fonction des niveaux d'activité

3. Règles de combinaison des effets de deux facteurs de stress sur la déformation

4. Faire la différence entre plusieurs conséquences négatives de la tension mentale

5. Principes axés sur le travail pour la structuration de la production

6. Participation au contexte organisationnel

7. Participation des utilisateurs au processus technologique

8. Horaires de travail irréguliers et privation de sommeil

9. Aspects des sommeils avancés, ancrés et retardés

10. Contrôler les mouvements et les effets attendus

11. Relations contrôle-effet des commandes manuelles courantes

12. Règles de disposition des commandes

13. Lignes directrices pour les étiquettes

Figures

Pointez sur une vignette pour voir la légende de la figure, cliquez pour voir la figure dans le contexte de l'article.

30. Hygiène du travail (6)

30. Hygiène du travail

Éditeur de chapitre : Robert F. Herrick

Table des matières

Tableaux et figures

Objectifs, définitions et informations générales

Bérénice I. Ferrari Goelzer

Reconnaissance des dangers

Linnéa Lillienberg

Évaluation de l'environnement de travail

Lori A.Todd

Hygiène du travail : contrôle des expositions par l'intervention

James Stewart

La base biologique de l'évaluation de l'exposition

Dick Heederik

Limites d'exposition professionnelle

Dennis J. Paustenbach

Tables

1. Dangers des produits chimiques ; agents biologiques et physiques

2. Limites d'exposition professionnelle (LEP) - divers pays

Figures

31. Protection personnelle (7)

31. Protection personnelle

Éditeur de chapitre : Robert F. Herrick

Table des matières

Tableaux et figures

Présentation et philosophie de la protection personnelle

Robert F. Herrick

Protecteurs des yeux et du visage

Kikuzi Kimura

Protection des pieds et des jambes

Toyohiko Miura

Protection de la tête

Isabelle Balty et Alain Mayer

Protection auditive

John R. Franks et Elliott H. Berger

Vêtements de protection

S.Zack Mansdorf

Protection respiratoire

Thomas J. Nelson

Tables

Cliquez sur un lien ci-dessous pour afficher le tableau dans le contexte de l'article.

1. Exigences de transmission (ISO 4850-1979)

2. Balances de protection - soudage au gaz et soudo-brasage

3. Echelles de protection - oxycoupage

4. Échelles de protection - coupage plasma

5. Échelles de protection - soudage à l'arc électrique ou gougeage

6. Échelles de protection - soudage plasma à l'arc direct

7. Casque de sécurité : Norme ISO 3873-1977

8. Taux de réduction du bruit d'un protecteur auditif

9. Calcul de la réduction de bruit pondérée A

10. Exemples de catégories de danger cutané

11. Exigences de performances physiques, chimiques et biologiques

12. Dangers matériels associés à des activités particulières

13. Facteurs de protection attribués selon ANSI Z88 2 (1992)

Figures

Pointez sur une vignette pour voir la légende de la figure, cliquez pour voir la figure dans le contexte de l'article.

32. Systèmes d'enregistrement et surveillance (9)

32. Systèmes d'enregistrement et surveillance

Éditeur de chapitre : Steven D.Stellman

Table des matières

Tableaux et figures

Systèmes de surveillance et de notification des maladies professionnelles

Steven B. Markowitz

Surveillance des risques professionnels

David H. Wegman et Steven D. Stellman

Surveillance dans les pays en développement

David Koh et Kee-Seng Chia

Élaboration et application d'un système de classification des lésions et maladies professionnelles

Élyce Biddle

Analyse des risques des blessures et maladies professionnelles non mortelles

John W.Ruser

Étude de cas : Protection des travailleurs et statistiques sur les accidents et les maladies professionnelles - HVBG, Allemagne

Martin Butz et Burkhard Hoffmann

Étude de cas : Wismut - Une exposition à l'uranium revisitée

Heinz Otten et Horst Schulz

Stratégies et techniques de mesure pour l'évaluation de l'exposition professionnelle en épidémiologie

Frank Bochmann et Helmut Blome

Étude de cas : Enquêtes sur la santé au travail en Chine

Tables

Cliquez sur un lien ci-dessous pour afficher le tableau dans le contexte de l'article.

1. Angiosarcome du foie - registre mondial

2. Maladie professionnelle, États-Unis, 1986 par rapport à 1992

3. États-Unis Décès dus à la pneumoconiose et au mésothéliome pleural

4. Exemple de liste de maladies professionnelles à déclaration obligatoire

5. Structure du code de déclaration des maladies et des blessures, États-Unis

6. Blessures et maladies professionnelles non mortelles, États-Unis 1993

7. Risque d'accidents du travail et de maladies professionnelles

8. Risque relatif pour les conditions de mouvement répétitif

9. Accidents du travail, Allemagne, 1981-93

10. Rectifieuses dans les accidents de la métallurgie, Allemagne, 1984-93

11. Maladie professionnelle, Allemagne, 1980-93

12. Maladies infectieuses, Allemagne, 1980-93

13. Exposition aux radiations dans les mines de Wismut

14. Maladies professionnelles dans les mines d'uranium de Wismut 1952-90

Figures

Pointez sur une vignette pour voir la légende de la figure, cliquez pour voir la figure dans le contexte de l'article.

33. Toxicologie (21)

33. Toxicologie

Rédactrice de chapitre : Ellen K. Silbergeld

Table des matières

Tableaux et figures

Introduction

Ellen K. Silbergeld, rédactrice en chef

Principes généraux de toxicologie

Définitions et concepts

Bo Holmberg, Johan Hogberg et Gunnar Johanson

Toxicocinétique

Dušan Djuric

Organe cible et effets critiques

Marek Jakubowski

Effets de l'âge, du sexe et d'autres facteurs

Spomenka Telishman

Déterminants génétiques de la réponse toxique

Daniel W. Nebert et Ross A. McKinnon

Mécanismes de toxicité

Introduction et notions

Philip G. Watanabe

Lésion cellulaire et mort cellulaire

Benjamin F. Trump et Irene K. Berezesky

Toxicologie génétique

R. Rita Misra et Michael P. Waalkes

Immunotoxicologie

Joseph G. Vos et Henk van Loveren

Toxicologie des organes cibles

Ellen K.Silbergeld

Méthodes d'essais toxicologiques

Biomarqueurs

Philippe Grandjean

Évaluation de la toxicité génétique

David M. DeMarini et James Huff

Tests de toxicité in vitro

Joanne Zurlo

Structurer les relations d'activité

Ellen K.Silbergeld

Toxicologie réglementaire

Toxicologie dans la réglementation de la santé et de la sécurité

Ellen K.Silbergeld

Principes d'identification des dangers - L'approche japonaise

Masayuki Ikeda

L'approche des États-Unis en matière d'évaluation des risques des toxiques pour la reproduction et des agents neurotoxiques

Ellen K.Silbergeld

Approches d'identification des dangers - IARC

Harri Vainio et Julian Wilbourn

Évaluation du risque cancérigène : autres approches

Cees A. van der Heijden

Tables

Cliquez sur un lien ci-dessous pour afficher le tableau dans le contexte de l'article.

- Exemples d'organes critiques et d'effets critiques

- Effets de base des interactions multiples possibles des métaux

- Adduits à l'hémoglobine chez les travailleurs exposés à l'aniline et à l'acétanilide

- Troubles héréditaires prédisposés au cancer et défauts de réparation de l'ADN

- Exemples de produits chimiques qui présentent une génotoxicité dans les cellules humaines

- Classification des tests pour les marqueurs immunitaires

- Exemples de biomarqueurs d'exposition

- Avantages et inconvénients des méthodes d'identification des risques de cancer chez l'homme

- Comparaison des systèmes in vitro pour les études d'hépatotoxicité

- Comparaison des données SAR et des tests : analyses OCDE/NTP

- Réglementation des substances chimiques par des lois, Japon

- Éléments de test en vertu de la loi sur le contrôle des substances chimiques, Japon

- Substances chimiques et loi sur le contrôle des substances chimiques

- Incidents majeurs de neurotoxicité sélectionnés

- Exemples de tests spécialisés pour mesurer la neurotoxicité

- Critères d'évaluation en toxicologie de la reproduction

- Comparaison des procédures d'extrapolation à faible dose

- Modèles fréquemment cités dans la caractérisation des risques cancérigènes

Figures

Pointez sur une vignette pour voir la légende de la figure, cliquez pour voir la figure dans le contexte de l'article.

Fatigue générale

Cet article est adapté de la 3e édition de l'Encyclopaedia of Occupational Health and Safety.

Les deux concepts de fatigue et de repos sont familiers à tous par expérience personnelle. Le mot « fatigue » est utilisé pour désigner des conditions très différentes, qui entraînent toutes une réduction de la capacité de travail et de la résistance. L'utilisation très variée du concept de fatigue a entraîné une confusion presque chaotique et une clarification des idées actuelles est nécessaire. Pendant longtemps, la physiologie a distingué la fatigue musculaire de la fatigue générale. Le premier est un phénomène douloureux aigu localisé dans les muscles : la fatigue générale se caractérise par un sentiment de diminution de la volonté de travailler. Cet article ne traite que de la fatigue générale, que l'on peut aussi appeler « fatigue psychique » ou « fatigue nerveuse » et du repos qu'elle nécessite.

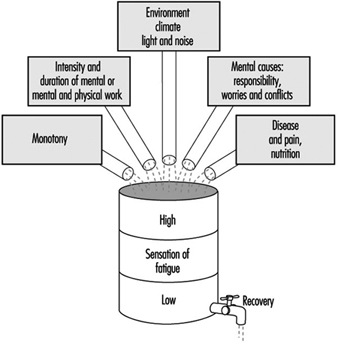

La fatigue générale peut être due à des causes assez différentes, dont les plus importantes sont présentées dans la figure 1. L'effet est comme si, au cours de la journée, tous les différents stress subis s'accumulaient dans l'organisme, produisant progressivement une sensation de fatigue croissante. fatigue. Ce sentiment incite à la décision d'arrêter de travailler ; son effet est celui d'un prélude physiologique au sommeil.

Figure 1. Présentation schématique de l'effet cumulatif des causes quotidiennes de la fatigue

La fatigue est une sensation salutaire si l'on peut s'allonger et se reposer. Cependant, si l'on ne tient pas compte de ce sentiment et que l'on se force à continuer à travailler, le sentiment de fatigue augmente jusqu'à devenir angoissant et finalement écrasant. Cette expérience quotidienne démontre bien la signification biologique de la fatigue qui joue un rôle dans le maintien de la vie, semblable à celui joué par d'autres sensations comme, par exemple, la soif, la faim, la peur, etc.

Le repos est représenté sur la figure 1 comme la vidange d'un tonneau. Le phénomène de repos peut se dérouler normalement si l'organisme reste intact ou si au moins une partie essentielle du corps n'est pas soumise à des contraintes. C'est ce qui explique le rôle déterminant que jouent les journées de travail toutes les pauses de travail, de la courte pause pendant le travail au sommeil nocturne. La comparaison du tonneau illustre combien il est nécessaire pour une vie normale d'atteindre un certain équilibre entre la charge totale supportée par l'organisme et la somme des possibilités de repos.

Interprétation neurophysiologique de la fatigue

Les progrès de la neurophysiologie au cours des dernières décennies ont largement contribué à une meilleure compréhension des phénomènes déclenchés par la fatigue dans le système nerveux central.

Le physiologiste Hess a été le premier à observer que la stimulation électrique de certaines des structures diencéphaliques, et plus particulièrement de certaines des structures du noyau médial du thalamus, produisait progressivement un effet inhibiteur qui se traduisait par une altération de la capacité de réaction. et dans une tendance à dormir. Si la stimulation était poursuivie pendant un certain temps, la relaxation générale était suivie de somnolence et enfin de sommeil. Il a été prouvé plus tard qu'à partir de ces structures, une inhibition active peut s'étendre jusqu'au cortex cérébral où se concentrent tous les phénomènes conscients. Cela se reflète non seulement dans le comportement, mais aussi dans l'activité électrique du cortex cérébral. D'autres expériences ont également réussi à initier des inhibitions à partir d'autres régions sous-corticales.

La conclusion que l'on peut tirer de toutes ces études est qu'il existe des structures situées dans le diencéphale et le mésencéphale qui représentent un système inhibiteur efficace et qui déclenchent la fatigue avec tous les phénomènes qui l'accompagnent.

Inhibition et activation

De nombreuses expériences réalisées sur des animaux et des humains ont montré que leur disposition générale à réagir dépend non seulement de ce système d'inhibition mais aussi essentiellement d'un système fonctionnant de manière antagoniste, appelé système d'activation ascendant réticulaire. Nous savons par expériences que la formation réticulaire contient des structures qui contrôlent le degré d'éveil, et par conséquent les dispositions générales à une réaction. Des liens nerveux existent entre ces structures et le cortex cérébral où s'exercent les influences activatrices sur la conscience. De plus, le système d'activation reçoit une stimulation des organes sensoriels. D'autres connexions nerveuses transmettent des impulsions du cortex cérébral - la zone de perception et de pensée - au système d'activation. Sur la base de ces concepts neurophysiologiques, on peut établir que des stimuli externes, ainsi que des influences provenant des aires de la conscience, peuvent, en passant par le système activateur, stimuler une disposition à une réaction.

De plus, de nombreuses autres investigations permettent de conclure que la stimulation du système activateur se propage fréquemment aussi à partir des centres végétatifs, et amène l'organisme à s'orienter vers la dépense d'énergie, vers le travail, la lutte, la fuite, etc. (conversion ergotrope de les organes internes). A l'inverse, il apparaît que la stimulation du système inhibiteur au sein de la sphère du système nerveux végétatif fait tendre l'organisme vers le repos, reconstitution de ses réserves d'énergie, phénomènes d'assimilation (conversion trophotrope).

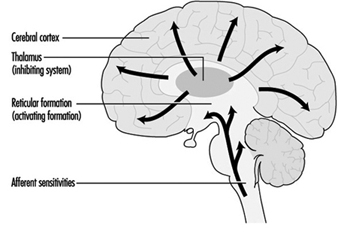

Par synthèse de toutes ces découvertes neurophysiologiques, on peut établir la conception suivante de la fatigue : l'état et la sensation de fatigue sont conditionnés par la réaction fonctionnelle de la conscience dans le cortex cérébral, qui est, à son tour, régi par deux systèmes mutuellement antagonistes : le système d'inhibition et le système d'activation. Ainsi, la disposition de l'homme au travail dépend à chaque instant du degré d'activation des deux systèmes : si le système inhibiteur est dominant, l'organisme sera en état de fatigue ; lorsque le système d'activation est dominant, il présentera une disposition accrue au travail.

Cette conception psychophysiologique de la fatigue permet de comprendre certains de ses symptômes parfois difficiles à expliquer. Ainsi, par exemple, une sensation de fatigue peut disparaître brutalement lorsqu'un événement extérieur inattendu survient ou lorsque la tension émotionnelle se développe. Il est clair dans ces deux cas que le système activateur a été stimulé. A l'inverse, si l'environnement est monotone ou que le travail semble ennuyeux, le fonctionnement du système activateur est diminué et le système inhibiteur devient dominant. Ceci explique pourquoi la fatigue apparaît dans une situation monotone sans que l'organisme ne soit soumis à une quelconque charge de travail.

La figure 2 décrit schématiquement la notion de systèmes mutuellement antagonistes d'inhibition et d'activation.

Figure 2. Présentation schématique du contrôle de la disposition au travail au moyen de systèmes d'inhibition et d'activation

Fatigue clinique

Il est de notoriété publique qu'une fatigue prononcée survenant jour après jour produira progressivement un état de fatigue chronique. La sensation de fatigue s'intensifie alors et survient non seulement le soir après le travail mais déjà dans la journée, parfois même avant le début du travail. Un sentiment de malaise, souvent de nature émotive, accompagne cet état. Les symptômes suivants sont souvent observés chez les personnes souffrant de fatigue : émotivité psychique accrue (comportement antisocial, incompatibilité), tendance à la dépression (anxiété non motivée) et manque d'énergie avec perte d'initiative. Ces effets psychiques s'accompagnent souvent d'un malaise non spécifique et se manifestent par des symptômes psychosomatiques : maux de tête, vertiges, troubles fonctionnels cardiaques et respiratoires, perte d'appétit, troubles digestifs, insomnie, etc.

Compte tenu de la tendance aux symptômes morbides qui accompagnent la fatigue chronique, on peut à juste titre parler de fatigue clinique. Il y a une tendance à l'augmentation de l'absentéisme, et en particulier à plus d'absences pour de courtes périodes. Cela semble être causé à la fois par le besoin de repos et par une morbidité accrue. L'état de fatigue chronique survient particulièrement chez les personnes exposées à des conflits ou difficultés psychiques. Il est parfois très difficile de distinguer les causes externes et internes. En fait, il est presque impossible de distinguer la cause et l'effet de la fatigue clinique : une attitude négative envers le travail, les supérieurs ou le lieu de travail peut tout aussi bien être la cause de la fatigue clinique que le résultat.

Des recherches ont montré que les standardistes et le personnel d'encadrement employés dans les services de télécommunications présentaient une augmentation significative des symptômes physiologiques de fatigue après leur travail (temps de réaction visuelle, fréquence de fusion des scintillements, tests de dextérité). Les investigations médicales ont révélé que dans ces deux groupes de travailleurs, il y avait une augmentation significative des états névrotiques, de l'irritabilité, des troubles du sommeil et de la sensation chronique de lassitude, par rapport à un groupe similaire de femmes employées dans les branches techniques de la poste, du téléphone et les services télégraphiques. L'accumulation de symptômes n'était pas toujours due à une attitude négative de la part des femmes affectées à leur emploi ou à leurs conditions de travail.

Mesures préventives

Il n'y a pas de panacée contre la fatigue, mais on peut faire beaucoup pour atténuer le problème en prêtant attention aux conditions générales de travail et à l'environnement physique sur le lieu de travail. Par exemple, on peut faire beaucoup en organisant correctement les heures de travail, en prévoyant des périodes de repos adéquates et des cantines et des toilettes appropriées ; des congés payés adéquats devraient également être accordés aux travailleurs. L'étude ergonomique du lieu de travail peut également aider à réduire la fatigue en s'assurant que les sièges, les tables et les établis sont de dimensions appropriées et que le flux de travail est correctement organisé. De plus, le contrôle du bruit, la climatisation, le chauffage, la ventilation et l'éclairage peuvent tous avoir un effet bénéfique sur le retardement de l'apparition de la fatigue chez les travailleurs.

La monotonie et la tension peuvent également être atténuées par une utilisation contrôlée de la couleur et de la décoration dans l'environnement, des intervalles de musique et parfois des pauses pour des exercices physiques pour les travailleurs sédentaires. La formation des travailleurs et en particulier du personnel d'encadrement et de direction joue également un rôle important.

Toxicologie des organes cibles

L'étude et la caractérisation des produits chimiques et autres agents pour leurs propriétés toxiques sont souvent entreprises sur la base d'organes et de systèmes d'organes spécifiques. Dans ce chapitre, deux cibles ont été sélectionnées pour une discussion approfondie : le système immunitaire et le gène. Ces exemples ont été choisis pour représenter un système d'organe cible complexe et une cible moléculaire dans les cellules. Pour une discussion plus complète de la toxicologie des organes cibles, le lecteur est renvoyé aux textes de toxicologie standard tels que Casarett et Doull, et Hayes. Le Programme international sur la sécurité chimique (IPCS) a également publié plusieurs documents de référence sur la toxicologie des organes cibles, par système d'organes.

Les études de toxicologie des organes cibles sont généralement entreprises sur la base d'informations indiquant le potentiel d'effets toxiques spécifiques d'une substance, soit à partir de données épidémiologiques, soit à partir d'études générales de toxicité aiguë ou chronique, soit sur la base de préoccupations particulières visant à protéger certaines fonctions d'organes, telles que que la reproduction ou le développement fœtal. Dans certains cas, des tests de toxicité pour des organes cibles spécifiques sont expressément mandatés par des autorités statutaires, tels que les tests de neurotoxicité en vertu de la loi américaine sur les pesticides (voir « L'approche des États-Unis pour l'évaluation des risques des toxiques pour la reproduction et des agents neurotoxiques », et les tests de mutagénicité en vertu de la loi japonaise sur les produits chimiques). Loi sur le contrôle des substances (voir « Principes d'identification des dangers : l'approche japonaise »).

Comme indiqué dans la section « Organe cible et effets critiques », l'identification d'un organe critique est basée sur la détection de l'organe ou du système d'organes qui réagit le premier négativement ou aux doses ou expositions les plus faibles. Ces informations sont ensuite utilisées pour concevoir des investigations toxicologiques spécifiques ou des tests de toxicité plus définis qui sont conçus pour élucider des indications plus sensibles d'intoxication dans l'organe cible. Les études de toxicologie des organes cibles peuvent également être utilisées pour déterminer les mécanismes d'action, utiles dans l'évaluation des risques (voir « L'approche des États-Unis pour l'évaluation des risques des toxiques pour la reproduction et des agents neurotoxiques »).

Méthodes d'études de toxicité pour les organes cibles

Les organes cibles peuvent être étudiés par exposition d'organismes intacts et analyse détaillée de la fonction et de l'histopathologie dans l'organe cible, ou par exposition in vitro de cellules, de tranches de tissus ou d'organes entiers maintenus pendant des périodes de courte ou de longue durée en culture (voir "Mécanismes de toxicologie : Introduction et concepts »). Dans certains cas, des tissus de sujets humains peuvent également être disponibles pour des études de toxicité sur des organes cibles, et ceux-ci peuvent fournir des opportunités pour valider les hypothèses d'extrapolation inter-espèces. Cependant, il faut garder à l'esprit que de telles études ne fournissent pas d'informations sur la toxicocinétique relative.

En général, les études de toxicité pour les organes cibles partagent les caractéristiques communes suivantes : examen histopathologique détaillé de l'organe cible, y compris examen post mortem, poids des tissus et examen des tissus fixés ; études biochimiques des voies critiques dans l'organe cible, telles que les systèmes enzymatiques importants ; des études fonctionnelles de la capacité de l'organe et des constituants cellulaires à remplir les fonctions métaboliques et autres attendues ; et l'analyse des biomarqueurs d'exposition et des effets précoces dans les cellules des organes cibles.

Une connaissance détaillée de la physiologie, de la biochimie et de la biologie moléculaire des organes cibles peut être intégrée aux études sur les organes cibles. Par exemple, étant donné que la synthèse et la sécrétion de protéines de faible poids moléculaire constituent un aspect important de la fonction rénale, les études de néphrotoxicité accordent souvent une attention particulière à ces paramètres (IPCS 1991). Étant donné que la communication de cellule à cellule est un processus fondamental du fonctionnement du système nerveux, les études d'organes cibles sur la neurotoxicité peuvent inclure des mesures neurochimiques et biophysiques détaillées de la synthèse, de l'absorption, du stockage, de la libération et de la liaison aux récepteurs des neurotransmetteurs, ainsi que des mesures électrophysiologiques des modifications de la membrane. potentiel associé à ces événements.

Un degré élevé d'accent est mis sur le développement de méthodes in vitro pour la toxicité des organes cibles, pour remplacer ou réduire l'utilisation d'animaux entiers. Des progrès substantiels dans ces méthodes ont été réalisés pour les substances toxiques pour la reproduction (Heindel et Chapin 1993).

En résumé, les études de toxicité pour les organes cibles sont généralement entreprises comme test d'ordre supérieur pour déterminer la toxicité. La sélection d'organes cibles spécifiques pour une évaluation plus approfondie dépend des résultats des tests de dépistage, tels que les tests aigus ou subchroniques utilisés par l'OCDE et l'Union européenne ; certains organes et systèmes d'organes cibles peuvent être candidats a priori à une enquête spéciale en raison du souci de prévenir certains types d'effets néfastes sur la santé.

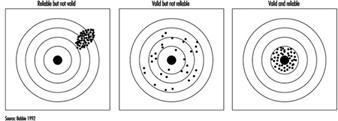

Problèmes de validité dans la conception de l'étude

Le besoin de validité

L'épidémiologie vise à fournir une compréhension de l'expérience de la maladie dans les populations. En particulier, il peut être utilisé pour mieux comprendre les causes professionnelles de la mauvaise santé. Ces connaissances proviennent d'études menées sur des groupes de personnes atteintes d'une maladie en les comparant à des personnes sans cette maladie. Une autre approche consiste à examiner quelles maladies contractent les personnes qui travaillent dans certains emplois avec des expositions particulières et à comparer ces schémas de maladie à ceux de personnes non exposées de la même manière. Ces études fournissent des estimations du risque de maladie pour des expositions spécifiques. Pour que les informations issues de ces études soient utilisées pour établir des programmes de prévention, pour la reconnaissance des maladies professionnelles et pour que les travailleurs affectés par des expositions soient convenablement indemnisés, ces études doivent être valides.

Validité peut être défini comme la capacité d'une étude à refléter l'état réel des choses. Une étude valide est donc celle qui mesure correctement l'association (qu'elle soit positive, négative ou absente) entre une exposition et une maladie. Il décrit la direction et l'ampleur d'un risque réel. Deux types de validité sont distingués : la validité interne et la validité externe. La validité interne est la capacité d'une étude à refléter ce qui s'est réellement passé entre les sujets de l'étude ; la validité externe reflète ce qui pourrait se produire dans la population.

La validité concerne la véracité d'une mesure. La validité doit être distinguée de la précision de la mesure, qui est fonction de la taille de l'étude et de l'efficacité de la conception de l'étude.

Validité interne

Une étude est dite valide en interne lorsqu'elle est exempte de biais et reflète donc fidèlement l'association entre l'exposition et la maladie qui existe parmi les participants à l'étude. Un risque observé de maladie associé à une exposition peut en effet résulter d'une association réelle et donc être valide, mais il peut aussi refléter l'influence de biais. Un biais donnera une image déformée de la réalité.

Trois grands types de biais, également appelés erreurs systématiques, se distinguent généralement :

- biais de séléction

- biais d'information ou d'observation

- déroutant

Ils seront brièvement présentés ci-dessous, à l'aide d'exemples tirés du milieu de la santé au travail.

Biais de séléction

Un biais de sélection se produira lorsque l'entrée dans l'étude est influencée par la connaissance du statut d'exposition du participant potentiel à l'étude. Ce problème n'est donc rencontré que lorsque la maladie a déjà eu lieu au moment (avant) que la personne entre dans l'étude. En règle générale, dans le cadre épidémiologique, cela se produit dans des études cas-témoins ou dans des études de cohorte rétrospectives. Cela signifie qu'une personne sera plus susceptible d'être considérée comme un cas si l'on sait qu'elle a été exposée. Trois séries de circonstances peuvent conduire à un tel événement, qui dépendra également de la gravité de la maladie.

Biais d'autosélection

Cela peut se produire lorsque des personnes qui savent qu'elles ont été exposées à des produits nocifs connus ou présumés dans le passé et qui sont convaincues que leur maladie est le résultat de l'exposition consulteront un médecin pour des symptômes que d'autres personnes, moins exposées, auraient pu ignorer. Cela est particulièrement susceptible de se produire pour les maladies qui présentent peu de symptômes perceptibles. Un exemple peut être une perte de grossesse précoce ou un avortement spontané chez les infirmières manipulant des médicaments utilisés pour le traitement du cancer. Ces femmes sont plus conscientes que la plupart de la physiologie de la reproduction et, en étant préoccupées par leur capacité à avoir des enfants, elles peuvent être plus susceptibles de reconnaître ou de qualifier d'avortement spontané ce que d'autres femmes ne considéreraient que comme un retard dans l'apparition des menstruations. Un autre exemple tiré d'une étude de cohorte rétrospective, cité par Rothman (1986), concerne une étude des Centers for Disease Control sur la leucémie parmi les troupes qui avaient été présentes lors d'un essai atomique américain au Nevada. Parmi les troupes présentes sur le site test, 76% ont été tracées et ont constitué la cohorte. Parmi ceux-ci, 82% ont été trouvés par les enquêteurs, mais 18% supplémentaires ont contacté les enquêteurs eux-mêmes après avoir entendu parler de l'étude. Quatre cas de leucémie étaient présents parmi les 82 % suivis par les CDC et quatre cas étaient présents parmi les 18 % auto-référés. Cela suggère fortement que la capacité des enquêteurs à identifier les personnes exposées était liée au risque de leucémie.

Biais diagnostique

Cela se produira lorsque les médecins sont plus susceptibles de diagnostiquer une maladie donnée une fois qu'ils savent à quoi le patient a été exposé précédemment. Par exemple, lorsque la plupart des peintures étaient à base de plomb, un symptôme de maladie des nerfs périphériques appelé névrite périphérique avec paralysie était également connu sous le nom de « chute de poignet » des peintres. Connaître la profession du patient facilitait le diagnostic de la maladie même à ses débuts, alors que l'identification de l'agent causal serait beaucoup plus difficile chez les participants à la recherche dont on ne savait pas qu'ils étaient professionnellement exposés au plomb.

Biais résultant du refus de participer à une étude

Lorsque des personnes, en bonne santé ou malades, sont invitées à participer à une étude, plusieurs facteurs jouent un rôle pour déterminer si elles seront d'accord ou non. La volonté de répondre à des questionnaires plus ou moins longs, qui portent parfois sur des questions sensibles, et plus encore de donner du sang ou d'autres échantillons biologiques, peut être déterminée par le degré d'intérêt personnel de la personne. Quelqu'un qui est conscient d'une exposition potentielle passée peut être prêt à se conformer à cette enquête dans l'espoir qu'elle aidera à trouver la cause de la maladie, tandis que quelqu'un qui considère qu'il n'a été exposé à rien de dangereux, ou qui n'est pas intéressé en sachant, peut décliner l'invitation à participer à l'étude. Cela peut conduire à une sélection des personnes qui seront finalement les participants à l'étude par rapport à toutes celles qui auraient pu l'être.

Biais informationnel

Ceci est également appelé biais d'observation et concerne l'issue de la maladie dans les études de suivi et l'évaluation de l'exposition dans les études cas-témoins.

Évaluation différentielle des résultats dans les études de suivi prospectives (de cohorte)

Deux groupes sont définis au début de l'étude : un groupe exposé et un groupe non exposé. Des problèmes de biais diagnostiques se poseront si la recherche de cas diffère entre ces deux groupes. Par exemple, considérons une cohorte de personnes exposées à un rejet accidentel de dioxine dans une industrie donnée. Pour le groupe très exposé, un système de suivi actif est mis en place avec des examens médicaux et une surveillance biologique à intervalles réguliers, alors que le reste de la population active ne reçoit que des soins de routine. Il est fort probable que davantage de maladies soient identifiées dans le groupe sous surveillance étroite, ce qui conduirait à une surestimation potentielle du risque.

Pertes différentielles dans les études de cohorte rétrospectives

Le mécanisme inverse de celui décrit au paragraphe précédent peut se produire dans les études de cohorte rétrospectives. Dans ces études, la façon habituelle de procéder est de partir des dossiers de toutes les personnes qui ont été employées dans une industrie donnée dans le passé, et d'évaluer la maladie ou la mortalité consécutive à l'emploi. Malheureusement, dans presque toutes les études, les dossiers sont incomplets, et le fait qu'une personne soit portée disparue peut être lié soit au statut d'exposition, soit au statut de la maladie, soit aux deux. Par exemple, dans une étude récente menée dans l'industrie chimique auprès de travailleurs exposés aux amines aromatiques, huit tumeurs ont été retrouvées dans un groupe de 777 travailleurs ayant subi un dépistage cytologique des tumeurs urinaires. Au total, seuls 34 enregistrements ont été trouvés manquants, correspondant à une perte de 4.4 % du fichier d'évaluation de l'exposition, mais pour les cas de cancer de la vessie, les données d'exposition manquaient pour deux cas sur huit, soit 25 %. Cela montre que les dossiers des personnes qui sont devenues des cas étaient plus susceptibles d'être perdus que les dossiers des autres travailleurs. Cela peut se produire en raison de changements d'emploi plus fréquents au sein de l'entreprise (qui peuvent être liés à des effets d'exposition), de démissions, de licenciements ou d'un simple hasard.

Évaluation différentielle de l'exposition dans les études cas-témoins

Dans les études cas-témoins, la maladie est déjà survenue au début de l'étude et des informations seront recherchées sur les expositions passées. Le biais peut résulter de l'attitude de l'intervieweur ou du participant à l'étude à l'égard de l'enquête. Les informations sont généralement recueillies par des enquêteurs formés qui peuvent ou non être au courant de l'hypothèse sous-jacente à la recherche. Par exemple, dans une étude cas-témoins basée sur la population sur le cancer de la vessie menée dans une région hautement industrialisée, le personnel de l'étude pourrait bien être conscient du fait que certains produits chimiques, tels que les amines aromatiques, sont des facteurs de risque du cancer de la vessie. S'ils savent également qui a développé la maladie et qui ne l'a pas fait, ils peuvent être susceptibles de mener des entretiens plus approfondis avec les participants atteints d'un cancer de la vessie qu'avec les témoins. Ils peuvent exiger des informations plus détaillées sur les occupations passées, en recherchant systématiquement l'exposition aux amines aromatiques, alors que pour les témoins, ils peuvent enregistrer les occupations de manière plus routinière. Le biais qui en résulte est appelé biais de suspicion d'exposition.

Les participants eux-mêmes peuvent également être responsables de ce biais. C'est appelé biais de rappel pour le distinguer du biais de l'intervieweur. Dans les deux cas, la suspicion d'exposition est le mécanisme du biais. Les personnes malades peuvent suspecter une origine professionnelle à leur maladie et vont donc essayer de se souvenir le plus précisément possible de tous les agents dangereux auxquels elles ont pu être exposées. En cas de manipulation de produits non définis, ils peuvent être enclins à rappeler les noms de produits chimiques précis, notamment si une liste de produits suspects est mise à leur disposition. En revanche, les contrôles peuvent être moins susceptibles de passer par le même processus de pensée.

La confusion

Il y a confusion lorsque l'association observée entre exposition et maladie résulte en partie d'un mélange de l'effet de l'exposition étudiée et d'un autre facteur. Disons, par exemple, qu'on constate un risque accru de cancer du poumon chez les soudeurs. On est tenté de conclure immédiatement qu'il existe une association causale entre l'exposition aux fumées de soudage et le cancer du poumon. Cependant, nous savons aussi que le tabagisme est de loin le principal facteur de risque du cancer du poumon. Par conséquent, si des informations sont disponibles, nous commençons à vérifier le statut tabagique des soudeurs et des autres participants à l'étude. Nous pouvons constater que les soudeurs sont plus susceptibles de fumer que les non-soudeurs. Dans cette situation, le tabagisme est connu pour être associé au cancer du poumon et, en même temps, dans notre étude, le tabagisme est également associé au fait d'être soudeur. En termes épidémiologiques, cela signifie que le tabagisme, lié à la fois au cancer du poumon et à la soudure, brouille l'association entre la soudure et le cancer du poumon.

Interaction ou modification d'effet

Contrairement à tous les problèmes énumérés ci-dessus, à savoir la sélection, l'information et la confusion, qui sont des biais, l'interaction n'est pas un biais dû à des problèmes de conception ou d'analyse de l'étude, mais reflète la réalité et sa complexité. Un exemple de ce phénomène est le suivant : l'exposition au radon est un facteur de risque de cancer du poumon, tout comme le tabagisme. De plus, le tabagisme et l'exposition au radon ont des effets différents sur le risque de cancer du poumon selon qu'ils agissent ensemble ou isolément. La plupart des études professionnelles sur ce sujet ont été menées auprès de mineurs de fond et ont parfois fourni des résultats contradictoires. Dans l'ensemble, il semble y avoir des arguments en faveur d'une interaction du tabagisme et de l'exposition au radon dans la production du cancer du poumon. Cela signifie que le risque de cancer du poumon est augmenté par l'exposition au radon, même chez les non-fumeurs, mais que l'ampleur de l'augmentation du risque due au radon est beaucoup plus importante chez les fumeurs que chez les non-fumeurs. En termes épidémiologiques, on dit que l'effet est multiplicatif. Contrairement à la confusion décrite ci-dessus, l'interaction doit être soigneusement analysée et décrite dans l'analyse plutôt que simplement contrôlée, car elle reflète ce qui se passe au niveau biologique et n'est pas simplement une conséquence d'une mauvaise conception de l'étude. Son explication conduit à une interprétation plus valable des résultats d'une étude.

Validité externe

Ce problème ne peut être résolu qu'après s'être assuré que la validité interne est garantie. Si l'on est convaincu que les résultats observés dans l'étude reflètent des associations réelles, on peut se demander si l'on peut ou non extrapoler ces résultats à la population plus large dont sont eux-mêmes issus les participants à l'étude, voire à d'autres populations identiques ou du moins très similaires. La question la plus fréquente est de savoir si les résultats obtenus pour les hommes s'appliquent également aux femmes. Pendant des années, les études et surtout les enquêtes d'épidémiologie professionnelle ont été menées exclusivement auprès des hommes. Des études menées auprès de chimistes dans les années 1960 et 1970 aux États-Unis, au Royaume-Uni et en Suède ont toutes révélé des risques accrus de cancers spécifiques, à savoir la leucémie, le lymphome et le cancer du pancréas. Sur la base de ce que nous savions des effets de l'exposition aux solvants et à certains autres produits chimiques, nous pouvions déjà en déduire à l'époque que le travail en laboratoire comportait également un risque cancérogène pour les femmes. Cela s'est d'ailleurs avéré être le cas lorsque la première étude menée auprès de femmes chimistes a finalement été publiée au milieu des années 1980, qui a trouvé des résultats similaires à ceux des hommes. Il est à noter que d'autres cancers en excès retrouvés étaient des tumeurs du sein et de l'ovaire, traditionnellement considérées comme n'étant liées qu'à des facteurs endogènes ou à la reproduction, mais pour lesquelles des facteurs environnementaux nouvellement suspectés comme les pesticides peuvent jouer un rôle. Il reste encore beaucoup à faire sur les déterminants professionnels des cancers féminins.

Stratégies pour une étude valide

Une étude parfaitement valide ne peut jamais exister, mais il incombe au chercheur d'essayer d'éviter, ou du moins de minimiser, autant de biais que possible. Cela peut souvent être fait au stade de la conception de l'étude, mais peut également être effectué pendant l'analyse.

Conception de l'étude

Les biais de sélection et d'information ne peuvent être évités que par la conception minutieuse d'une étude épidémiologique et la mise en œuvre scrupuleuse de toutes les directives quotidiennes qui en découlent, y compris une attention méticuleuse à l'assurance qualité, pour la conduite de l'étude dans les conditions de terrain. La confusion peut être traitée au stade de la conception ou de l'analyse.

Sélection

Les critères pour considérer un participant comme un cas doivent être explicitement définis. On ne peut pas, ou du moins on ne doit pas, tenter d'étudier des conditions cliniques mal définies. Une façon de minimiser l'impact que la connaissance de l'exposition peut avoir sur l'évaluation de la maladie est de n'inclure que les cas graves qui auraient été diagnostiqués indépendamment de toute information sur l'histoire du patient. Dans le domaine du cancer, les études seront souvent limitées aux cas avec preuve histologique de la maladie pour éviter l'inclusion de lésions borderline. Cela signifie également que les groupes à l'étude sont bien définis. Par exemple, il est bien connu en épidémiologie du cancer que les cancers de différents types histologiques au sein d'un organe donné peuvent avoir des facteurs de risque différents. Si le nombre de cas est suffisant, il est préférable de séparer l'adénocarcinome du poumon du carcinome épidermoïde du poumon. Quels que soient les critères définitifs d'admission à l'étude, ils doivent toujours être clairement définis et décrits. Par exemple, le code exact de la maladie doit être indiqué en utilisant la Classification Internationale des Maladies (CIM) et aussi, pour le cancer, la Classification Internationale des Maladies-Oncologie (CIM-O).

Des efforts devraient être faits une fois les critères précisés pour maximiser la participation à l'étude. La décision de refuser de participer n'est presque jamais prise au hasard et conduit donc à des préjugés. Les études doivent d'abord être présentées aux cliniciens qui voient les patients. Leur approbation est nécessaire pour approcher les patients, et il faudra donc les convaincre de soutenir l'étude. Un argument souvent convaincant est que l'étude est dans l'intérêt de la santé publique. Cependant, à ce stade, il est préférable de ne pas discuter de l'hypothèse exacte à évaluer afin d'éviter d'influencer indûment les cliniciens impliqués. On ne devrait pas demander aux médecins d'assumer des tâches supplémentaires; il est plus facile de convaincre le personnel de santé d'apporter son soutien à une étude si les moyens sont fournis par les investigateurs de l'étude pour effectuer toutes les tâches supplémentaires, en plus des soins de routine, nécessitées par l'étude. Les enquêteurs et les personnes chargées de l'analyse des données ne doivent pas être au courant de l'état pathologique de leurs patients.

Une attention similaire doit être accordée aux informations fournies aux participants. L'objectif de l'étude doit être décrit en termes généraux et neutres, mais doit également être convaincant et persuasif. Il est important que les questions de confidentialité et d'intérêt pour la santé publique soient bien comprises tout en évitant le jargon médical. Dans la plupart des contextes, l'utilisation d'incitations financières ou autres n'est pas considérée comme appropriée, bien qu'une compensation doive être prévue pour toute dépense encourue par un participant. Enfin, et ce n'est pas le moins important, la population générale devrait être suffisamment instruite sur le plan scientifique pour comprendre l'importance de telles recherches. Les avantages et les risques de la participation doivent être expliqués à chaque participant potentiel lorsqu'il doit remplir des questionnaires et/ou fournir des échantillons biologiques pour le stockage et/ou l'analyse. Aucune coercition ne doit être appliquée pour obtenir un consentement préalable et pleinement informé. Lorsque les études sont exclusivement fondées sur des dossiers, l'approbation préalable des organismes chargés d'assurer la confidentialité de ces dossiers doit être obtenue. Dans ces cas, le consentement individuel des participants peut généralement être annulé. Au lieu de cela, l'approbation des dirigeants syndicaux et gouvernementaux suffira. Les enquêtes épidémiologiques ne constituent pas une menace pour la vie privée d'un individu, mais sont une aide potentielle pour améliorer la santé de la population. L'approbation d'un comité d'examen institutionnel (ou comité d'examen éthique) sera nécessaire avant la conduite d'une étude, et une grande partie de ce qui est indiqué ci-dessus sera attendue par eux pour leur examen.

Informations

Dans les études de suivi prospectives, les moyens d'évaluation de l'état de la maladie ou de la mortalité doivent être identiques pour les participants exposés et non exposés. En particulier, différentes sources ne doivent pas être utilisées, telles que la vérification dans un registre central de mortalité uniquement pour les participants non exposés et l'utilisation d'une surveillance active intensive pour les participants exposés. De même, la cause du décès doit être obtenue par des moyens strictement comparables. Cela signifie que si un système est utilisé pour accéder à des documents officiels pour la population non exposée, qui est souvent la population générale, il ne faut jamais envisager d'obtenir des informations encore plus précises par le biais de dossiers médicaux ou d'entretiens sur les participants eux-mêmes ou sur leurs familles pour le sous-groupe exposé.

Dans les études de cohorte rétrospectives, des efforts doivent être faits pour déterminer dans quelle mesure la population étudiée est comparée à la population d'intérêt. Il faut se méfier des pertes différentielles potentielles dans les groupes exposés et non exposés en utilisant diverses sources concernant la composition de la population. Par exemple, il peut être utile de comparer les listes de paie avec les listes de membres des syndicats ou d'autres listes professionnelles. Les divergences doivent être conciliées et le protocole adopté pour l'étude doit être suivi de près.

Dans les études cas-témoins, d'autres options existent pour éviter les biais. Les enquêteurs, le personnel de l'étude et les participants à l'étude n'ont pas besoin d'être au courant de l'hypothèse précise à l'étude. S'ils ne connaissent pas l'association testée, ils sont moins susceptibles d'essayer de fournir la réponse attendue. Garder le personnel de l'étude dans l'ignorance quant à l'hypothèse de recherche est en fait souvent très peu pratique. L'enquêteur connaîtra presque toujours les expositions présentant le plus grand intérêt potentiel ainsi que qui est un cas et qui est un témoin. Il faut donc compter sur leur honnêteté et aussi sur leur formation en méthodologie fondamentale de la recherche, qui devrait faire partie de leur parcours professionnel ; l'objectivité est la marque de fabrique à toutes les étapes de la science.

Il est plus facile de ne pas informer les participants à l'étude de l'objet exact de la recherche. De bonnes explications de base sur la nécessité de collecter des données pour mieux comprendre la santé et la maladie sont généralement suffisantes et satisferont les besoins de l'examen éthique.

La confusion

La confusion est le seul biais qui peut être traité soit au stade de la conception de l'étude, soit, à condition que des informations adéquates soient disponibles, au stade de l'analyse. Si, par exemple, l'âge est considéré comme un facteur de confusion potentiel de l'association d'intérêt parce que l'âge est associé au risque de maladie (c'est-à-dire que le cancer devient plus fréquent chez les personnes âgées) et également à l'exposition (les conditions d'exposition varient avec l'âge ou avec des facteurs liés à l'âge tels que la qualification, le poste et la durée de l'emploi), plusieurs solutions existent. Le plus simple est de limiter l'étude à une tranche d'âge précise - par exemple, ne recruter que des hommes caucasiens âgés de 40 à 50 ans. Cela fournira des éléments d'analyse simple, mais aura aussi l'inconvénient de limiter l'application des résultats à une seule sexe âge/groupe racial. Une autre solution consiste à faire correspondre l'âge. Cela signifie que pour chaque cas, un référent du même âge est nécessaire. C'est une idée intéressante, mais il faut garder à l'esprit la difficulté éventuelle de satisfaire à cette exigence à mesure que le nombre de facteurs d'appariement augmente. De plus, une fois qu'un facteur a été apparié, il devient impossible d'évaluer son rôle dans la survenue de la maladie. La dernière solution consiste à disposer de suffisamment d'informations sur les facteurs de confusion potentiels dans la base de données de l'étude afin de les vérifier dans l'analyse. Cela peut être fait soit par une simple analyse stratifiée, soit avec des outils plus sophistiqués tels que l'analyse multivariée. Cependant, il convient de rappeler que l'analyse ne pourra jamais compenser une étude mal conçue ou mal menée.

Conclusion

La possibilité que des biais se produisent dans la recherche épidémiologique est établie depuis longtemps. Cela n'était pas trop préoccupant lorsque les associations étudiées étaient fortes (comme c'est le cas pour le tabagisme et le cancer du poumon) et, par conséquent, certaines inexactitudes ne causaient pas de problème trop grave. Cependant, maintenant que le moment est venu d'évaluer les facteurs de risque les plus faibles, le besoin de meilleurs outils devient primordial. Cela comprend la nécessité d'excellents modèles d'étude et la possibilité de combiner les avantages de divers modèles traditionnels tels que les études cas-témoins ou de cohorte avec des approches plus innovantes telles que les études cas-témoins imbriquées dans une cohorte. En outre, l'utilisation de biomarqueurs peut fournir les moyens d'obtenir des évaluations plus précises des expositions actuelles et éventuellement passées, ainsi que pour les premiers stades de la maladie.

Fatigue et récupération

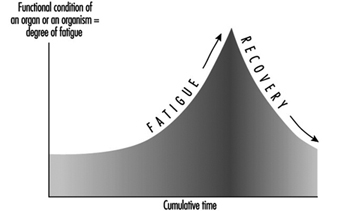

La fatigue et la récupération sont des processus périodiques dans tout organisme vivant. La fatigue peut être décrite comme un état qui se caractérise par une sensation de fatigue associée à une réduction ou une variation non désirée de la performance de l'activité (Rohmert 1973).

Toutes les fonctions de l'organisme humain ne se fatiguent pas à cause de l'utilisation. Même en dormant, par exemple, nous respirons et notre cœur bat sans arrêt. De toute évidence, les fonctions de base de la respiration et de l'activité cardiaque sont possibles tout au long de la vie sans fatigue et sans pauses pour la récupération.

Par contre, on constate après un gros travail assez prolongé qu'il y a une réduction de capacité - ce que l'on appelle sensation de fatigue. Cela ne s'applique pas à la seule activité musculaire. Les organes sensoriels ou les centres nerveux se fatiguent également. C'est pourtant le but de chaque cellule d'équilibrer la capacité perdue par son activité, un processus que nous appelons récupération.

Stress, effort, fatigue et récupération

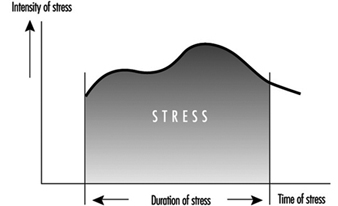

Les concepts de fatigue et de récupération au travail humain sont étroitement liés aux concepts ergonomiques de stress et d'effort (Rohmert 1984) (figure 1).

Figure 1. Stress, déformation et fatigue

Le stress désigne la somme de tous les paramètres de travail dans le système de travail qui influencent les personnes au travail, qui sont perçus ou ressentis principalement par le système récepteur ou qui sollicitent le système effecteur. Les paramètres de stress résultent de la tâche de travail (travail musculaire, travail non musculaire - dimensions et facteurs liés à la tâche) et des conditions physiques, chimiques et sociales dans lesquelles le travail doit être effectué (bruit, climat, éclairement, vibrations , travail posté, etc.—dimensions et facteurs liés à la situation).

L'intensité/difficulté, la durée et la composition (c'est-à-dire la répartition simultanée et successive de ces demandes spécifiques) des facteurs de stress se traduisent par un stress combiné, qu'exercent tous les effets exogènes d'un système de travail sur le travailleur. Ce stress combiné peut être géré activement ou supporté passivement, en fonction notamment du comportement de la personne qui travaille. Le cas actif impliquera des activités orientées vers l'efficacité du système de travail, tandis que le cas passif induira des réactions (volontaires ou involontaires), qui visent principalement à minimiser le stress. La relation entre le stress et l'activité est influencée de manière décisive par les caractéristiques individuelles et les besoins de la personne qui travaille. Les principaux facteurs d'influence sont ceux qui déterminent la performance et sont liés à la motivation et à la concentration et ceux liés à la disposition, que l'on peut appeler capacités et compétences.

Les contraintes liées au comportement, qui se manifestent dans certaines activités, provoquent des contraintes individuellement différentes. Les souches peuvent être indiquées par la réaction d'indicateurs physiologiques ou biochimiques (par exemple, l'augmentation de la fréquence cardiaque) ou elles peuvent être perçues. Ainsi, les souches sont sensibles à la "mise à l'échelle psycho-physique", qui estime la souche telle qu'elle est ressentie par la personne qui travaille. Dans une approche comportementale, l'existence d'une contrainte peut également être déduite d'une analyse d'activité. L'intensité avec laquelle les indicateurs de stress (physiologiques-biochimiques, comportementaux ou psycho-physiques) réagissent dépend de l'intensité, de la durée et de la combinaison des facteurs de stress ainsi que des caractéristiques individuelles, des capacités, des compétences et des besoins de la personne qui travaille.

Malgré des contraintes constantes, les indicateurs issus des domaines d'activité, de performance et de pénibilité peuvent varier dans le temps (effet temporel). De telles variations temporelles doivent être interprétées comme des processus d'adaptation des systèmes organiques. Les effets positifs entraînent une réduction de la tension/amélioration de l'activité ou de la performance (par exemple, grâce à l'entraînement). Dans le cas négatif, cependant, ils entraîneront une augmentation de l'effort/une réduction de l'activité ou des performances (par exemple, fatigue, monotonie).

Les effets positifs peuvent entrer en action si les capacités et les compétences disponibles sont améliorées dans le processus de travail lui-même, par exemple, lorsque le seuil de stimulation de l'entraînement est légèrement dépassé. Les effets négatifs sont susceptibles d'apparaître si les soi-disant limites d'endurance (Rohmert 1984) sont dépassées au cours du processus de travail. Cette fatigue entraîne une diminution des fonctions physiologiques et psychologiques, qui peut être compensée par la récupération.

Pour restaurer les performances d'origine, des indemnités de repos ou au moins des périodes avec moins de stress sont nécessaires (Luczak 1993).

Lorsque le processus d'adaptation est porté au-delà de seuils définis, le système organique employé peut être endommagé au point de provoquer une déficience partielle ou totale de ses fonctions. Une réduction irréversible des fonctions peut apparaître lorsque le stress est beaucoup trop élevé (dommage aigu) ou lorsque la récupération est impossible pendant une durée plus longue (dommage chronique). Un exemple typique de tels dommages est la perte auditive induite par le bruit.

Modèles de fatigue

La fatigue peut être multiforme, selon la forme et la combinaison de la contrainte, et une définition générale de celle-ci n'est pas encore possible. Les suites biologiques de la fatigue ne sont en général pas mesurables de manière directe, de sorte que les définitions sont principalement orientées vers les symptômes de la fatigue. Ces symptômes de fatigue peuvent être divisés, par exemple, dans les trois catégories suivantes.

- Symptômes physiologiques: la fatigue est interprétée comme une diminution des fonctions des organes ou de tout l'organisme. Il en résulte des réactions physiologiques, par exemple une augmentation de la fréquence cardiaque ou de l'activité musculaire électrique (Laurig 1970).

- Symptômes comportementaux: la fatigue est interprétée principalement comme une diminution des paramètres de performance. Les exemples sont des erreurs croissantes lors de la résolution de certaines tâches, ou une variabilité croissante des performances.

- Symptômes psycho-physiques: la fatigue est interprétée comme une augmentation de la sensation d'effort et une détérioration de la sensation, en fonction de l'intensité, de la durée et de la composition des facteurs de stress.

Dans le processus de fatigue, ces trois symptômes peuvent jouer un rôle, mais ils peuvent apparaître à différents moments.

Les réactions physiologiques dans les systèmes organiques, en particulier ceux impliqués dans le travail, peuvent apparaître en premier. Plus tard, les sensations d'effort peuvent être affectées. Les changements de performance se manifestent généralement par une régularité décroissante du travail ou par une quantité croissante d'erreurs, bien que la moyenne des performances ne soit pas encore affectée. Au contraire, avec une motivation appropriée, la personne qui travaille peut même essayer de maintenir ses performances grâce à sa volonté. La prochaine étape peut être une nette réduction des performances se terminant par une dégradation des performances. Les symptômes physiologiques peuvent conduire à une dégradation de l'organisme, y compris des modifications de la structure de la personnalité et à l'épuisement. Le processus de fatigue est expliqué dans la théorie des déstabilisations successives (Luczak 1983).

La tendance principale de la fatigue et de la récupération est illustrée à la figure 2.

Figure 2. Tendance principale de la fatigue et de la récupération

Pronostic de la fatigue et de la récupération

Dans le domaine de l'ergonomie, il existe un intérêt particulier à prédire la fatigue en fonction de l'intensité, de la durée et de la composition des facteurs de stress et à déterminer le temps de récupération nécessaire. Le tableau 1 montre ces différents niveaux d'activité et périodes de réflexion ainsi que les raisons possibles de la fatigue et les différentes possibilités de récupération.

Tableau 1. Fatigue et récupération en fonction des niveaux d'activité

|

Niveau d'activité |

Période |

Fatigue de |

Récupération par |

|

La vie de travail |

Décennies |

Surmenage pour |

Retraite |

|

Phases de la vie professionnelle |

Années |

Surmenage pour |

Vacances |

|

Séquences de |

Mois/semaines |

Changement défavorable |

Week-end, gratuit |

|

Un quart de travail |

Un jour |

Stress au-dessus |

Temps libre, repos |

|

Tâches |

HORAIRES |

Stress au-dessus |

Période de repos |

|

Partie d'une tâche |

Minutes |

Stress au-dessus |

Changement de tension |

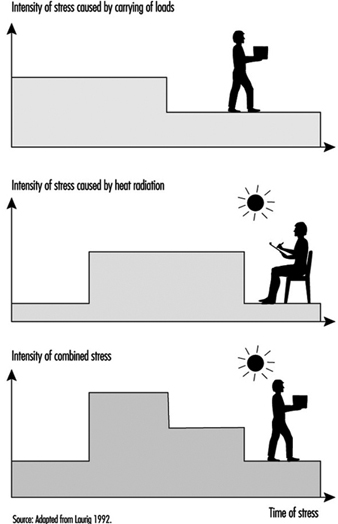

Dans l'analyse ergonomique du stress et de la fatigue pour déterminer le temps de récupération nécessaire, la prise en compte de la durée d'une journée de travail est la plus importante. Les méthodes de telles analyses commencent par la détermination des différents facteurs de stress en fonction du temps (Laurig 1992) (figure 3).

Figure 3. Stress en fonction du temps

Les facteurs de stress sont déterminés à partir du contenu spécifique du travail et des conditions de travail. Le contenu du travail pourrait être la production de force (par exemple, lors de la manipulation de charges), la coordination des fonctions motrices et sensorielles (par exemple, lors de l'assemblage ou de l'utilisation d'une grue), la conversion d'informations en réaction (par exemple, lors du contrôle), les transformations pour produire des informations (par exemple, lors de la programmation, de la traduction) et la production d'informations (par exemple, lors de la conception, de la résolution de problèmes). Les conditions de travail comprennent des aspects physiques (par exemple, bruit, vibrations, chaleur), chimiques (agents chimiques) et sociaux (par exemple, collègues, travail posté).

Dans le cas le plus simple, il y aura un seul facteur de stress important tandis que les autres peuvent être négligés. Dans ces cas, notamment lorsque les facteurs de stress résultent d'un travail musculaire, il est souvent possible de calculer les indemnités de repos nécessaires, car les notions de base sont connues.

Par exemple, l'allocation de repos suffisante dans le travail musculaire statique dépend de la force et de la durée de la contraction musculaire comme dans une fonction exponentielle liée par multiplication selon la formule :

![]()

avec

RA = Allocation de repos en pourcentage de t

t = durée de contraction (période de travail) en minutes

T = durée maximale possible de contraction en minutes

f = la force nécessaire pour la force statique et

F = force maximale.

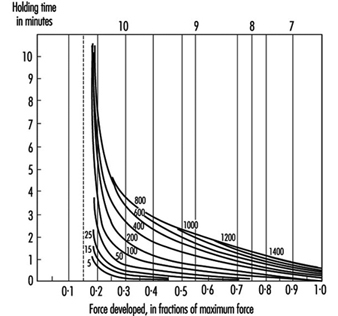

Le lien entre la force, le temps de maintien et les allocations de repos est illustré à la figure 4.

Figure 4. Allocations de repos en pourcentage pour diverses combinaisons de forces de maintien et de temps

Des lois similaires existent pour un travail musculaire dynamique lourd (Rohmert 1962), un travail musculaire léger actif (Laurig 1974) ou différents travaux musculaires industriels (Schmidtke 1971). Plus rarement, vous trouverez des lois comparables pour le travail non physique, par exemple pour l'informatique (Schmidtke 1965). Laurig (1981) et Luczak (1982) donnent un aperçu des méthodes existantes de détermination des indemnités de repos pour les travaux musculaires et non musculaires principalement isolés.

Plus difficile est la situation où il existe une combinaison de différents facteurs de stress, comme le montre la figure 5, qui affectent simultanément la personne active (Laurig 1992).

Figure 5. La combinaison de deux facteurs de stress

La combinaison de deux facteurs de stress, par exemple, peut conduire à des réactions de déformation différentes selon les lois de combinaison. L'effet combiné de différents facteurs de stress peut être indifférent, compensatoire ou cumulatif.

Dans le cas de lois de combinaison indifférentes, les différents facteurs de stress ont un effet sur différents sous-systèmes de l'organisme. Chacun de ces sous-systèmes peut compenser la contrainte sans que la contrainte soit introduite dans un sous-système commun. La déformation globale dépend du facteur de contrainte le plus élevé, et donc les lois de superposition ne sont pas nécessaires.

Un effet compensatoire est donné lorsque la combinaison de différents facteurs de stress conduit à une déformation inférieure à celle de chaque facteur de stress seul. La combinaison du travail musculaire et des basses températures peut réduire l'effort global, car les basses températures permettent au corps de perdre la chaleur produite par le travail musculaire.

Un effet cumulatif se produit si plusieurs facteurs de stress se superposent, c'est-à-dire qu'ils doivent passer par un « goulot d'étranglement » physiologique. Un exemple est la combinaison du travail musculaire et du stress thermique. Les deux facteurs de stress affectent le système circulatoire en tant que goulot d'étranglement commun avec une contrainte cumulative résultante.

Les effets de combinaison possibles entre le travail musculaire et les conditions physiques sont décrits dans Bruder (1993) (voir tableau 2).

Tableau 2. Règles de combinaison des effets de deux facteurs de stress sur la déformation

|

Du froid |

Vibration |

uniforme |

Bruit |

|

|

Travail dynamique lourd |

- |

+ |

0 |

0 |

|

Travail musculaire léger actif |

+ |

+ |

0 |

0 |

|

Travail musculaire statique |

+ |

+ |

0 |

0 |

0 effet indifférent ; + effet cumulatif ; – effet compensateur.

Source : Adapté de Bruder 1993.

Pour le cas de la combinaison de plus de deux facteurs de stress, qui est la situation normale en pratique, seules des connaissances scientifiques limitées sont disponibles. Il en va de même pour la combinaison successive de facteurs de stress (c'est-à-dire l'effet de contrainte de différents facteurs de stress qui affectent successivement le travailleur). Dans de tels cas, en pratique, le temps de récupération nécessaire est déterminé en mesurant des paramètres physiologiques ou psychologiques et en les utilisant comme valeurs d'intégration.

Impact de l'erreur de mesure aléatoire

Les erreurs de mesure de l'exposition peuvent avoir des impacts différents sur la relation exposition-maladie étudiée, selon la manière dont les erreurs sont réparties. Si une étude épidémiologique a été menée à l'aveugle (c'est-à-dire que des mesures ont été prises sans connaître la maladie ou l'état de santé des participants à l'étude), nous nous attendons à ce que l'erreur de mesure soit répartie uniformément entre les strates de la maladie ou de l'état de santé.

Le tableau 1 donne un exemple : supposons que nous recrutions une cohorte de personnes exposées au travail à un toxique, afin d'investiguer une maladie fréquente. Nous déterminons le statut d'exposition uniquement au recrutement (T0), et non à d'autres moments du suivi. Disons cependant qu'un certain nombre d'individus changent effectivement de statut d'exposition l'année suivante : au temps T1, 250 des 1,200 150 personnes exposées à l'origine ont cessé d'être exposées, tandis que 750 des XNUMX personnes non exposées à l'origine ont commencé à être exposées au toxique. Ainsi, à l'instant T1, 1,100 850 personnes sont exposées et XNUMX ne le sont pas. En conséquence, nous avons une « erreur de classification » de l'exposition, basée sur notre mesure initiale de l'état de l'exposition au temps T0. Ces individus sont ensuite retrouvés après 20 ans (au temps T2) et le risque cumulé de maladie est évalué. (L'hypothèse faite dans l'exemple est que seule une exposition de plus d'un an est préoccupante.)

Tableau 1. Cohorte hypothétique de 1950 individus (exposés et non exposés au travail), recrutés au temps T0 et dont le statut pathologique est déterminé au temps T2

|

Temps |

|||

|

T0 |

T1 |

T2 |

|

Travailleurs exposés 1200 250 abandonnent l'exposition 1100 (1200-250+150)

Cas de maladie au temps T2 = 220 parmi les travailleurs exposés

Travailleurs non exposés 750 150 commencent l'exposition 850 (750-150+250)

Cas de maladie au temps T2 = 85 chez les travailleurs non exposés

La vrai risque de la maladie au temps T2 est de 20% chez les travailleurs exposés (220/1100),

et 10 % chez les travailleurs non exposés (85/850) (risque relatif = 2.0).

Risque estimé à T2 de la maladie parmi les personnes classées comme exposées à T0:% 20

(c.-à-d. risque réel chez les personnes exposées) ´ 950 (c.-à-d. 1200-250)+ 10 %

(c'est-à-dire, risque réel chez les non-exposés) ´ 250 = (190+25)/1200 = 17.9 %

Risque estimé à T2 de la maladie parmi ceux classés comme non exposés à

T0: 20 % (c'est-à-dire le risque réel chez les personnes exposées) ´ 150 +10 %

(c'est-à-dire le risque réel chez les personnes non exposées) ´ 600 (c'est-à-dire 750-150) = (30+60)/750 = 12 %

Risque relatif estimé = 17.9 % / 12 % = 1.49

Les erreurs de classification dépendent, dans cet exemple, de la conception de l'étude et des caractéristiques de la population, plutôt que des limites techniques de la mesure de l'exposition. L'effet d'une mauvaise classification est tel que le « vrai » rapport de 2.0 entre le risque cumulé chez les personnes exposées et les personnes non exposées devient un rapport « observé » de 1.49 (tableau 1). Cette sous-estimation du rapport de risque découle d'un « brouillage » de la relation entre l'exposition et la maladie, qui se produit lorsque la classification erronée de l'exposition, comme dans ce cas, est uniformément répartie en fonction de la maladie ou de l'état de santé (c'est-à-dire que la mesure de l'exposition est pas influencé par le fait que la personne souffrait ou non de la maladie que nous étudions).

En revanche, une sous-estimation ou une surestimation de l'association d'intérêt peut se produire lorsque la classification erronée de l'exposition n'est pas uniformément répartie sur le résultat d'intérêt. Dans l'exemple, on peut avoir biais, et pas seulement un brouillage de la relation étiologique, si la classification de l'exposition dépend de la maladie ou de l'état de santé des travailleurs. Cela pourrait se produire, par exemple, si l'on décide de prélever des échantillons biologiques sur un groupe de travailleurs exposés et sur un groupe de travailleurs non exposés, afin d'identifier les changements précoces liés à l'exposition au travail. Les échantillons prélevés sur les travailleurs exposés pourraient alors être analysés de manière plus précise que les échantillons prélevés sur les travailleurs non exposés; la curiosité scientifique pourrait conduire le chercheur à mesurer des biomarqueurs supplémentaires parmi les personnes exposées (y compris, par exemple, des adduits à l'ADN dans les lymphocytes ou des marqueurs urinaires de dommages oxydatifs à l'ADN), en supposant que ces personnes sont scientifiquement "plus intéressantes". Il s'agit d'une attitude assez courante qui, cependant, pourrait conduire à de sérieux préjugés.

Méthodes statistiques

Il y a beaucoup de débats sur le rôle des statistiques dans la recherche épidémiologique sur les relations causales. En épidémiologie, la statistique est avant tout un ensemble de méthodes d'évaluation de données basées sur des populations humaines (et aussi animales). En particulier, la statistique est une technique de quantification et de mesure de phénomènes incertains. Toutes les investigations scientifiques qui traitent d'aspects non déterministes et variables de la réalité pourraient bénéficier d'une méthodologie statistique. En épidémiologie, la variabilité est intrinsèque à l'unité d'observation – une personne n'est pas une entité déterministe. Alors que les conceptions expérimentales seraient améliorées pour mieux répondre aux hypothèses des statistiques en termes de variation aléatoire, pour des raisons éthiques et pratiques, cette approche n'est pas trop courante. Au lieu de cela, l'épidémiologie est engagée dans la recherche observationnelle qui lui est associée à la fois des sources aléatoires et d'autres sources de variabilité.